Internet

Le triangle de Vannevar Bush

Les innovations portent souvent la marque des organisations qui les ont créées. Le cas d’Internet est particulièrement intéressant, car il a été construit par l’association de trois groupes : les militaires, les universités et l’industrie. Ce qui rendit ce processus encore plus fascinant, c’est qu’il ne s’agissait pas seulement d’un consortium assez lâche où chaque groupe poursuivait ses propres objectifs. Au lieu de quoi, pendant la Seconde Guerre mondiale et après, ces trois groupes avaient fusionné en un triangle de fer : le complexe militaro-industriel et universitaire.

La personne responsable au premier chef de cet assemblage était Vannevar Bush, ce professeur du MIT qui avait construit en 1931 l’analyseur différentiel, le calculateur analogique primitif décrit au chapitre 21. Bush était l’homme qu’il fallait, parce qu’il était une star dans les trois domaines : doyen de l’École d’ingénierie du MIT, cofondateur de l’entreprise d’électronique Raytheon et administrateur scientifique suprême de l’armée pendant la Seconde Guerre mondiale. « Aucun Américain n’a exercé une plus grande influence sur la croissance de la science et de la technologie que Vannevar Bush », proclama plus tard Jerome Wiesner, président du MIT, en ajoutant que « son innovation la plus significative a été le plan en vertu duquel, au lieu d’édifier de grands laboratoires gouvernementaux, l’État a passé des contrats avec des universités et des laboratoires industriels2 ».

Vannevar Bush naquit près de Boston en 1890 ; il était le fils d’un pasteur de l’Église universaliste qui avait commencé sa carrière comme cuistot sur un sloop gréé pour la pêche au maquereau. Ses deux grands-pères étaient capitaines de baleinier, ce qui lui inculqua un bon sens marin et une franchise qui contribuèrent à faire de lui un gestionnaire résolu et un administrateur charismatique. Comme bien des gagnants de l’industrie technologique, il excellait à la fois dans l’ingénierie des produits et la prise rapide de décisions. « Tous mes ancêtres récents étaient capitaines de bateau et en mer on sait gérer une situation sans se poser de questions, dit-il un jour. Et j’ai donc hérité d’une certaine tendance à mener la barque une fois que je suis dedans3. »

Et comme beaucoup de bons leaders de l’industrie technologique, il grandit dans l’amour conjoint des humanités et des sciences. Il pouvait citer Kipling et Omar Khayyam « au kilomètre », il jouait de la flûte, adorait les symphonies et lisait de la philosophie pour le plaisir. Sa famille avait elle aussi un atelier au sous-sol, où il construisait des petits bateaux et des jouets mécaniques. Comme Time le signala plus tard dans son style inimitable de l’époque : « Mince, l’œil vif, le pied marin, Van Bush est un Yankee dont l’amour de la science a commencé, comme pour beaucoup de jeunes Américains, par sa passion du bricolage et des gadgets4. »

Il étudia à l’université Tufts, où il construisit à ses moments perdus une machine topographique qui utilisait deux roues de bicyclette et un pendule pour suivre le contour d’une surface et en calculer l’aire, et était donc un dispositif analogique pour faire du calcul intégral. Il déposa un brevet pour cette invention, le premier des quarante-neuf qu’il accumulerait ultérieurement. Pendant son séjour à Tufts, lui-même et les colocataires de sa résidence universitaire conseillèrent une série de petites sociétés puis, après avoir obtenu leurs diplômes, fondèrent Raytheon, qui deviendrait une firme d’électronique et un fournisseur militaire tentaculaire.

Bush obtint un doctorat en ingénierie électronique conjointement du MIT et de Harvard, puis devint professeur au MIT et doyen de l’école d’ingénierie, où il construisit son analyseur différentiel. Sa passion était de promouvoir le rôle de la science et de la technologie dans la société américaine, à une époque, le milieu des années 1930, où apparemment il ne se passait pas grand-chose d’excitant dans un domaine comme dans l’autre. Le téléviseur n’était pas encore un produit de consommation et, parmi les inventions qui furent placées dans la capsule temporelle lors de l’Exposition universelle de New York en 1939, les plus notables étaient une montre Mickey et un rasoir de sûreté Gillette. La Seconde Guerre mondiale allait changer tout cela et déclencher une explosion de technologies nouvelles, avec Vannevar Bush en avant-garde.

Craignant que l’armée américaine accuse un retard technologique, il mobilisa le président de Harvard, James Bryant Conant, et d’autres éminents scientifiques afin de convaincre le président Franklin Roosevelt de constituer la Commission pour la recherche de la défense nationale (NDRC) puis le Bureau de la recherche et du développement scientifique (OSRD), qu’il présida tous les deux. Crayon en main, son éternelle pipe à la bouche, il supervisa le Projet Manhattan pour construire la bombe atomique en même temps que des projets pour développer le radar et des systèmes de défense anti-aérienne. Time le surnomma le « général de la physique » sur sa couverture du 3 avril 1944. « Si nous avions été à la hauteur en technologie militaire dix ans plus tôt, déclarait-il au journaliste en martelant son bureau du poing, nous n’aurions probablement jamais eu cette fichue guerre5. »

Avec son style direct tempéré par un caractère chaleureux, c’était un chef dur, mais attachant. Un jour, un groupe de scientifiques militaires, frustrés par un problème bureaucratique quelconque, entrèrent dans son bureau pour démissionner. Bush n’arrivait pas à cerner la nature de l’embrouille. « Alors, raconte-t-il, je leur ai carrément dit : “On ne démissionne pas en temps de guerre. Foutez-le camp d’ici, les gars, retournez au boulot, et moi je vais m’occuper de l’affaire6.” » Ils obéirent. Comme le fit remarquer plus tard Jerome Wiesner du MIT, « c’était un homme aux opinions fortement ancrées, qu’il exprimait et appliquait vigoureusement, et pourtant il éprouvait un grand respect devant les mystères de la nature, manifestait une chaleureuse tolérance des faiblesses de la nature humaine et était ouvert au changement7. »

En juillet 1945, quand la guerre fut terminée, Vannevar Bush produisit à la demande de Roosevelt un rapport (finalement remis au président Harry Truman) qui préconisait le financement par le gouvernement de la recherche fondamentale en partenariat avec les universités et l’industrie. Il choisit un titre évocateur et typiquement américain : « La science, frontière sans fin ». L’introduction de Bush mérite d’être relue chaque fois que des politiciens menacent de couper les subventions de la recherche nécessaire aux innovations futures : « La recherche fondamentale conduit à des connaissances nouvelles. Elle fournit du capital scientifique. Elle crée la base dont toutes les applications pratiques du savoir doivent être tirées.8 »

Sa description de la manière dont la recherche fondamentale fournit le germe des inventions pratiques a été baptisée le « modèle linéaire de l’innovation ». Bien que des vagues subséquentes d’historiens des sciences aient cherché à discréditer le modèle linéaire, lui reprochant d’ignorer l’interaction complexe entre la recherche théorique et les applications pratiques, il avait un attrait populaire et correspondait aussi à une vérité sous-jacente. La guerre, écrivait Bush, avait « clairement montré qu’il ne faisait pas de doute » que la science fondamentale – la découverte des fondements de la physique nucléaire, du laser, de l’informatique, du radar – « est absolument essentielle à la sécurité nationale ». Elle était aussi, ajoutait-il, cruciale pour la sécurité économique des États-Unis. « De nouveaux produits et de nouveaux procédés ne naissent pas tout armés. Ils sont fondés sur de nouveaux principes et de nouvelles conceptions, qui sont à leur tour minutieusement développés par des recherches dans les domaines les plus purs de la science. Une nation qui dépend des autres pour enrichir de nouveautés ses connaissances scientifiques fondamentales sera lente dans son progrès industriel et faible dans sa compétitivité sur le marché du commerce mondial. » À la fin de son rapport, Bush prenait des accents lyriques pour chanter les louanges des retombées pratiques de la recherche scientifique fondamentale : « Les avancées scientifiques, une fois traduites dans l’usage pratique, signifient plus d’emplois, de meilleurs salaires, des horaires moins chargés, des récoltes plus abondantes, plus de temps libre pour les loisirs, pour l’étude, pour apprendre comment vivre sans le travail abrutissant qui a été par le passé le fardeau du citoyen ordinaire.9 »

Inspiré par ce rapport, le Congrès créa la National Science Foundation. Au début, Truman mit son veto à la loi correspondante parce qu’elle stipulait que le directeur de la NSF serait nommé par un organe indépendant et non par le président. Mais Vannevar Bush fit changer Truman d’avis en lui expliquant que cette solution l’isolerait des gens cherchant à obtenir des faveurs politiques. « Van, vous devriez faire de la politique, lui dit Truman. Vous avez certains des instincts nécessaires. » À quoi Bush répondit : « Monsieur le président, qu’est-ce que vous croyez que je fiche à Washington depuis cinq ou six ans10 ? »

La création d’une relation triangulaire entre le gouvernement, l’industrie et l’université fut à sa manière l’une des innovations significatives qui contribuèrent à produire la révolution technologique de la fin du xxe siècle. Le ministère de la Défense (ex-ministère de la Guerre) et la National Science Fondation devinrent bientôt les principaux bailleurs de fonds pour une grande partie de la recherche fondamentale aux États-Unis et dépensèrent autant que le secteur privé entre 1950 et 1990*1. Le rendement de cet investissement fut considérable et favorisa la naissance non seulement d’Internet, mais aussi de nombreux piliers de l’innovation et du boom économique dans l’Amérique de l’après-guerre11.

Il existait avant la guerre quelques centres de recherche du secteur privé, en particulier les laboratoires Bell. Mais quand l’appel solennel de Vannevar Bush eut produit des encouragements et des contrats du gouvernement fédéral, des centres de recherche hybrides commencèrent à proliférer. Notamment la RAND Corporation, fondée à l’origine pour la recherche et le développement (Research ANd Development) au service de l’armée de l’air, le Stanford Research Institute (SRI) et son prolongement l’Augmentation Research Center, et le Xerox PARC (pour Palo Alto Research Center). Tous joueraient un rôle dans le développement d’Internet.

Deux des plus importants de ces instituts naquirent autour de Cambridge, au Massachusetts, juste après la guerre : l’institut Lincoln, un centre de recherche financé par l’armée et affilié au MIT, et Bolt, Beranek & Newman (BBN), une société de recherche et de développement fondée et peuplée par des ingénieurs du MIT (et quelques-uns de Harvard). Un professeur du MIT doté d’un accent traînant du Missouri et d’une sympathique aptitude à la formation d’équipes était étroitement associé à ces deux établissements.

J. C. R. Licklider

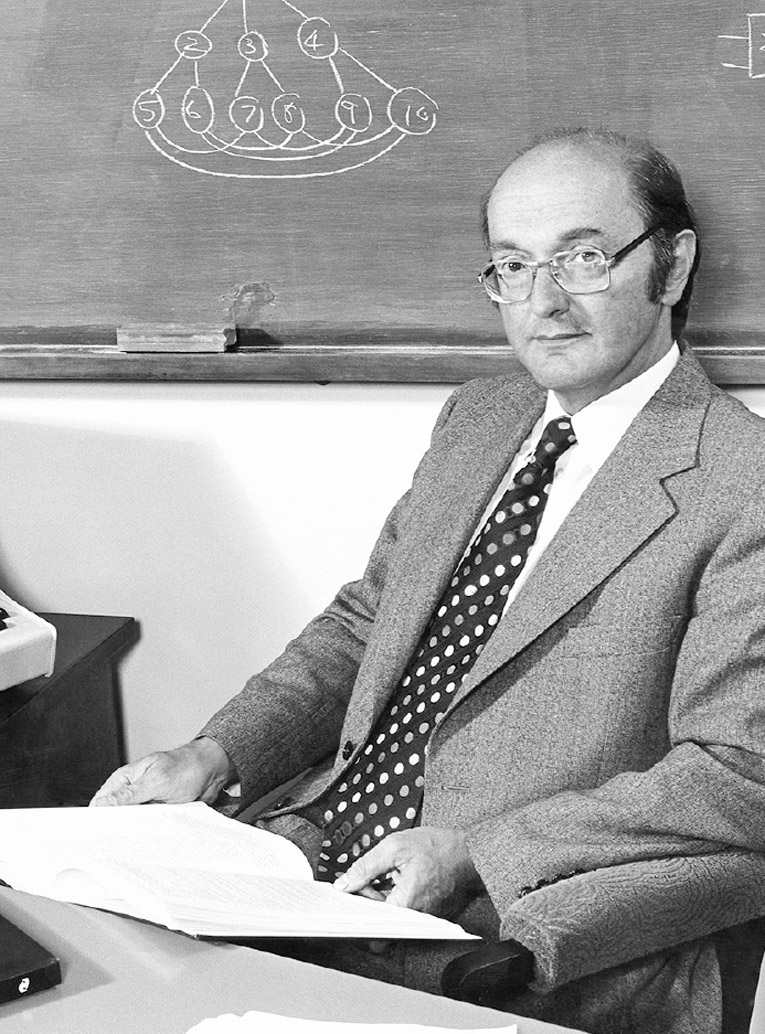

Qui chercherait les pères fondateurs d’Internet serait bien avisé de commencer par un psychologue et technologue, laconique mais bizarrement charmant, avec un sourire franc et un certain scepticisme, Joseph Carl Robnett Licklider, né en 1915, que tout le monde appelait « Lick ». Il a fait œuvre de pionnier en introduisant les deux plus importants concepts sous-jacents à Internet : des réseaux décentralisés qui permettraient la diffusion de l’information en direction et à partir de n’importe quel lieu, et des interfaces qui faciliteraient l’interaction humain-machine en temps réel. En outre, il était le directeur fondateur du bureau militaire qui finança ARPANET, et il y reprit du service une décennie plus tard quand des protocoles furent créés pour tisser à partir d’ARPANET la toile qui deviendrait Internet. Comme l’a dit l’un de ses associés et protégés, Bob Taylor : « Il était vraiment le père de tout ça12. »

Le père de Licklider était un pauvre journalier agricole du Missouri qui réussit comme représentant en assurances à Saint-Louis, puis, laissé pour compte par la Dépression, se reconvertit en pasteur baptiste dans une minuscule bourgade rurale. Fils unique choyé, Lick transforma sa chambre en un atelier de production d’avions modèle réduit et reconstruisit des vieilles voitures dans le jardin avec sa mère à côté de lui pour lui tendre les outils. Il se sentait néanmoins piégé dans cette région rurale isolée pleine de clôtures en fil de fer barbelé.

Il s’échappa d’abord pour étudier à l’université Washington de Saint-Louis ; ensuite, après avoir obtenu un doctorat en psychoacoustique (la science qui étudie notre perception des sons), il entra au laboratoire de psychoacoustique de Harvard. S’intéressant de plus en plus à la relation entre la psychologie et la technologie, à l’interaction entre le cerveau humain et les machines, il quitta Harvard pour le MIT, où il inaugura une section de psychologie basée au département d’ingénierie électrique.

Au MIT, Licklider rejoignit le milieu éclectique des ingénieurs, psychologues et humanistes rassemblés autour du professeur Norbert Wiener, un théoricien qui étudiait comment humains et machines travaillaient ensemble. C’est lui qui créa le terme cybernétique, la science décrivant comment n’importe quel système, depuis le cerveau humain jusqu’au mécanisme de pointage d’une pièce d’artillerie, apprend à partir de communications, de boucles de commande et de rétroaction. « Il y a eu un fantastique ferment intellectuel à Cambridge après la Seconde Guerre mondiale, raconte Licklider. Wiener gérait un cercle hebdomadaire de quarante ou cinquante personnes qui s’étaient regroupées. On se réunissait et on parlait pendant deux heures. J’étais un des fidèles adhérents13. »

Contrairement à certains de ses collègues du MIT, Wiener estimait que la voie la plus prometteuse pour l’informatique était de concevoir des machines qui puissent bien travailler avec l’esprit humain au lieu d’essayer de le remplacer. « Beaucoup de gens supposent que les machines à calculer sont des substituts de l’intelligence et ont réduit le besoin de pensée originale, écrivait Wiener. Ce n’est pas le cas14. » Plus l’ordinateur sera puissant, plus il sera avantageux de le connecter avec une pensée humaine imaginative, créative et de haut niveau. Licklider se rangea à cette conception, qu’il appellerait plus tard la « symbiose homme-machine ».

Licklider avait un humour malicieux mais bon enfant. Il adorait regarder les Trois Stooges et avait un penchant de potache pour les gags visuels. Parfois, quand un collègue était sur le point de présenter un diaporama, Licklider glissait en douce la photo d’une jolie femme dans le panier du projecteur. Au travail, il faisait le plein d’énergie en se gavant continuellement de Coca-Cola et de bonbons tirés des distributeurs automatiques ; il donnait des barres chocolatées Hershey comme récompenses à ses enfants et à ses étudiants. Il était aussi dévoué à ses étudiants de troisième cycle, qu’il invitait à dîner chez lui à Arlington, dans la banlieue de Boston. « Pour lui, tout se ramenait à la collaboration, disait son fils Tracy. Il se promenait un peu partout en créant au passage des îlots de gens qu’il encourageait à être curieux et à résoudre des problèmes. » C’était l’une des raisons qui le poussèrent à s’intéresser aux réseaux. « Il savait que pour avoir de bonnes réponses il fallait compter sur des collaborations lointaines. Il adorait dénicher des gens talentueux et les réunir pour faire des équipes15. »

Sa convivialité ne s’étendait toutefois pas aux personnages prétentieux ou pompeux (à l’exception de Norbert Wiener). Quand il pensait qu’un orateur se répandait en absurdités, il se levait et posait des questions apparemment innocentes, mais qui étaient en fait des pièges diaboliques. Quelques instants plus tard, le conférencier se rendait compte qu’il avait été ridiculisé et Licklider se rasseyait. « Il n’aimait pas les poseurs et les prétentieux, confirme Tracy Licklider. Il n’était jamais méchant, mais il dégonflait adroitement les prétentions des gens. »

L’une des passions de Licklider était l’art. Où qu’il voyage, il passait des heures dans les musées, où il traînait parfois ses deux enfants récalcitrants. « Il en est devenu dingue, raconte Tracy, il n’en avait jamais assez. » Parfois il passait cinq heures ou plus dans un musée à s’émerveiller de chaque coup de pinceau, analyser la composition de chaque tableau et tenter d’appréhender ce qu’il nous enseignait sur la créativité. Il repérait instinctivement le talent dans tous les domaines, mais il avait le sentiment qu’il était le plus facilement visible dans ses formes les plus pures, comme la touche d’un peintre ou le refrain mélodique d’un compositeur. Il disait qu’il cherchait les mêmes touches créatives dans les plans des ingénieurs en informatique ou en réseautique. « Il est devenu un détecteur de créativité vraiment compétent. Il discutait souvent de ce qui rendait les gens créatifs. Il avait l’impression que c’était plus facile à voir chez un peintre, alors il a fait encore plus d’efforts pour le repérer dans l’ingénierie, où l’on ne peut pas voir les coups de pinceau aussi rapidement16. »

Et, par-dessus tout, Licklider était généreux. D’après son biographe Mitchell Waldrop, quand il travaillait au Pentagone plus tard dans sa carrière, il remarqua un soir que la femme de ménage admirait les reproductions de tableaux qui décoraient son mur. Elle lui dit : « Vous savez, docteur Licklider, je fais toujours votre pièce en dernier, parce que j’aime avoir un peu de temps pour moi toute seule, sans rien qui presse, pour regarder les tableaux. » Il lui demanda lequel lui plaisait le plus, et elle indiqua la reproduction d’un Cézanne. Licklider fut transporté de joie, car c’était son tableau favori, et lui en fit promptement cadeau17.

Licklider pensait que son amour de l’art le rendait plus intuitif. Il pouvait traiter une large gamme d’informations et en déduire des schémas. Une autre de ses qualités, qui le servirait bien quand il aiderait à constituer l’équipe qui jetterait les bases d’Internet, était qu’il adorait partager des idées sans en revendiquer à tout prix la paternité. Son ego était si docile qu’on avait l’impression qu’il aimait mieux mettre à disposition d’autrui les idées développées dans une conversation que tenter de se les approprier. « En dépit de sa très considérable influence sur l’informatique, Lick était resté modeste, explique Bob Taylor. Son type préféré de plaisanterie était celle dont il était la cible18. »

Le temps partagé et la symbiose homme-ordinateur

Au MIT, Licklider collabora avec le pionnier de l’intelligence artificielle John McCarthy, dans le laboratoire duquel les bidouilleurs du Tech Model Railway Club avaient inventé Spacewar. Sous la direction de McCarthy, ils aidèrent à développer des systèmes de temps partagé en informatique pendant les années 1950.

Jusqu’alors, quand vous vouliez qu’un ordinateur exécute une tâche, il fallait soumettre un paquet de cartes perforées ou une bande magnétique aux opérateurs de la machine, à la manière d’une offrande présentée aux prêtres qui gardaient jalousement un oracle. C’était le « traitement séquentiel » (batch processing, littéralement « traitement par lots ») et c’était une corvée ennuyeuse. Il pouvait s’écouler des heures voire des jours entiers avant que vous puissiez récupérer les résultats ; la moindre erreur risquait de vous obliger à soumettre les cartes ou la bande à un nouveau traitement ; et il se pouvait que vous n’ayez pas la possibilité de manipuler ni même de voir l’ordinateur lui-même.

Le temps partagé (time-sharing), c’était différent. Il autorisait la connexion d’un grand nombre de terminaux à un même gros ordinateur (mainframe), si bien que de nombreux utilisateurs pouvaient entrer directement des instructions au clavier et obtenir une réponse presque immédiatement. Comme un grand maître qui joue simultanément des dizaines de parties d’échecs, la mémoire centrale du gros ordinateur suivait les actions de tous les utilisateurs, et son système d’exploitation multitâches était capable de faire tourner simultanément de nombreux programmes. Ce qui fournissait aux utilisateurs une expérience enchanteresse : on pouvait avoir une interaction au clavier et en temps réel avec un ordinateur, comme une conversation. « Il s’était créé parmi nous une sorte de petite religion inspirée par la conviction que cela allait être totalement différent du traitement séquentiel », raconte Licklider19.

Ce fut une étape décisive vers un partenariat direct ou une symbiose entre l’humain et l’ordinateur. Si l’on en croit Bob Taylor, « l’invention de l’informatique interactive grâce au temps partagé a été encore plus importante que l’invention de l’informatique elle-même. Le traitement séquentiel, c’était comme si on échangeait des lettres avec quelqu’un, tandis que l’informatique interactive, c’était comme si on lui parlait20. »

L’importance de l’informatique interactive se manifesta au laboratoire Lincoln, le centre de recherche financé par l’armée que Licklider aida à créer au MIT en 1951. C’est là qu’il forgea une équipe composée à moitié de psychologues et à moitié d’ingénieurs pour examiner comment les humains pourraient interagir plus intuitivement avec les ordinateurs et comment les informations pourraient être présentées avec une interface plus conviviale.

L’une des missions du laboratoire Lincoln était de développer des ordinateurs pour un système de défense anti-aérienne qui fournirait une alerte avancée en cas d’attaque ennemie et coordonnerait une riposte. Connu sous l’appellation anodine de SAGE, pour Semi-Automatic Ground Environment – « environnement au sol semi-automatique » –, il coûta plus d’argent et employa plus de personnel que le Projet Manhattan qui avait construit la bombe atomique. Pour fonctionner, le système SAGE avait besoin de permettre à ses utilisateurs d’avoir des interactions instantanées avec ses ordinateurs. Lorsqu’un missile ou un bombardier était en route, il n’y aurait pas le temps de traiter les calculs séquentiellement.

Le système SAGE comprenait vingt-trois centres de détection et de poursuite d’un bout à l’autre des États-Unis, connectés entre eux par des lignes téléphoniques à longue distance. Il était en mesure de diffuser des informations à jusqu’à quatre cents avions de chasse en même temps. Ce qui exigeait de puissants ordinateurs interactifs, des réseaux à même de transmettre de vastes quantités d’informations et des affichages capables de présenter ces informations sous une forme graphique et facile à comprendre. À cause de sa formation de psychologue, c’est à Licklider qu’on eut recours pour aider à élaborer les interfaces humain-machine (ce que les utilisateurs voyaient sur l’écran). Il formula un ensemble de théories sur les diverses manières de cultiver une symbiose, un partenariat intime qui permettrait aux humains et aux machines de coopérer pour résoudre des problèmes. Il attribuait une grande importance à la recherche de méthodes pour transmettre visuellement des situations en évolution constante : « Nous voulions des méthodes pour sauvegarder la situation aérienne pendant plusieurs secondes successives, pour reproduire les trajectoires sous forme de lignes et non de spots ponctuels et pour colorer les tracés de façon à pouvoir dire quelle était l’information récente et dans quelle direction l’objet se déplaçait21. » Le sort de l’Amérique pouvait dépendre de la capacité d’un servant de console à évaluer correctement les données et à réagir immédiatement.

Les ordinateurs interactifs, les interfaces intuitives et les réseaux à grande vitesse de transfert prouvaient qu’humains et machines pouvaient travailler ensemble dans un partenariat collaboratif, et Licklider imagina les moyens d’y parvenir pour autre chose que des systèmes de défense anti-aérienne. Il commença à parler de ce qu’il appelait « un système vraiment SAGE » qui connecterait en réseau non seulement les centres de défense anti-aérienne, mais aussi des « centres pensants » comprenant de vastes bibliothèques de connaissances, avec lesquels les gens pourraient interagir sur des consoles munies d’affichages conviviaux – autrement dit, l’univers numérique que nous avons aujourd’hui.

Ces idées formèrent la base d’un des articles les plus influents de l’histoire de la technologie d’après-guerre, intitulé « La symbiose homme-machine », que Licklider publia en 1960 : « Espérons que dans un avenir pas trop éloigné les cerveaux humains et les ordinateurs seront très étroitement accouplés, et que le partenariat ainsi obtenu pensera comme nul cerveau humain n’a encore jamais pensé et traitera des informations d’une manière dont sont encore très loin les machines informatiques que nous connaissons aujourd’hui. » Cette sentence mérite d’être relue, car elle est devenue l’un des concepts fondateurs de l’ère numérique22.

Licklider se rangea du côté de Norbert Wiener, dont la théorie de la cybernétique était fondée sur le travail en commun des humains et des machines, plutôt que celui de leurs collègues du MIT Marvin Minsky et John McCarthy, dont la quête de l’intelligence artificielle impliquait la création de machines capables d’apprendre toutes seules et d’imiter la cognition humaine. Ainsi que l’expliquait Licklider, l’objectif raisonnable était de créer un environnement dans lequel humains et machines « coopèrent dans la prise de décisions ». Autrement dit, ils s’enrichiraient mutuellement. « Les humains fixeront les objectifs, formuleront les hypothèses, détermineront les critères et feront les évaluations. Les machines informatiques accompliront les tâches répétitives qu’il faut faire afin de préparer le terrain pour les intuitions et les décisions dans la pensée technique et scientifique. »

Le réseau informatique intergalactique

En combinant ses intérêts pour la psychologie et l’ingénierie, Licklider se concentra encore plus sur l’informatique. Ce qui le conduisit en 1957 à rejoindre la jeune société Bolt, Beranek & Newman (BBN), établie à Cambridge, une entreprise de recherche mi-commerciale, mi-universitaire où travaillaient déjà nombre de ses amis. Comme les laboratoires Bell à l’époque de l’invention du transistor, BBN rassembla des talents divers – des théoriciens, des ingénieurs, des techniciens, des informaticiens, des psychologues et, à l’occasion, un colonel de l’armée de terre23.

L’une des missions de Licklider chez BBN consistait à mener une équipe chargée de trouver comment l’informatique pourrait transformer les bibliothèques. Il dicta son rapport final « Bibliothèques du futur » en cinq heures, assis au bord de la piscine pendant un congrès à Las Vegas24. Il y explorait le potentiel « de dispositifs et de techniques permettant l’interaction homme-ordinateur en ligne », concept qui présageait Internet. Licklider envisageait la constitution par accumulation d’une gigantesque base de données qui soit gérée et élaguée de façon à ce qu’elle « ne devienne pas trop diffuse, trop écrasante ou trop peu fiable ».

Dans un passage pittoresque de son rapport, il présentait un scénario de fiction dans lequel il posait des questions à l’ordinateur. Il imagine ainsi l’activité de la machine : « Au cours du week-end, elle a récupéré plus de dix mille documents, les a examinés pour y trouver des sections riches en informations pertinentes, puis a analysé lesdites sections pour en faire des énoncés formalisés en calcul des prédicats de premier ordre et a introduit ces énoncés dans la base de données. » Licklider était conscient que la démarche qu’il décrivait finirait par être dépassée : « Il est certain qu’une démarche plus sophistiquée sera faisable avant 1994 », écrivait-il en portant son regard à trois décennies dans l’avenir25. Il était remarquablement prescient. En 1994, les premiers moteurs de recherche à indexation de texte, WebCrawler et Lycos, furent développés pour Internet, bientôt suivis par Excite, Infoseek, AltaVista et Google.

Licklider prédit aussi quelque chose de contraire à l’intuition mais qui s’est avéré juste : que l’information numérique ne remplacerait pas complètement l’imprimerie. « En tant que moyen d’afficher des informations, la page imprimée est superbe. Elle possède assez de résolution pour satisfaire les exigences de l’œil. Elle présente suffisamment d’informations pour occuper le lecteur pendant un quantum de temps pratique. Elle offre une grande flexibilité en matière de polices de caractères et de format. Elle laisse au lecteur la pleine maîtrise du mode et de la vitesse d’inspection. Elle est d’encombrement réduit, légère, déplaçable ; on peut la découper, l’agrafer, la coller, la copier, la jeter, et elle ne coûte pas cher26. »

En octobre 1962, tandis qu’il travaillait encore sur son projet de « Bibliothèques du futur », Licklider fut recruté par Washington pour diriger un nouveau bureau dédié au traitement de l’information à l’Agence pour les projets de recherche avancée dépendant du ministère de la Défense, appelée alors ARPA*2 (Advanced Research Projects Agency). Intégrée au Pentagone, elle était autorisée à financer la recherche fondamentale dans les universités et dans l’industrie, devenant ainsi l’une des nombreuses manières dont le gouvernement mit en application la vision de Vannevar Bush. Il y avait aussi une raison moins abstraite. Le 4 octobre 1957, les Soviétiques avaient lancé Spoutnik I, le premier satellite artificiel. La connexion que Vannevar Bush avait établie entre la science et la défense nationale scintillait maintenant dans le ciel tous les soirs. Quand les Américains louchaient pour l’apercevoir, ils voyaient aussi que Bush avait raison : la nation qui financerait le mieux la science produirait les meilleures fusées, les meilleurs satellites. Il s’ensuivit une vague salutaire d’affolement public.

Le président Eisenhower aimait bien les scientifiques. Leur culture et leur mode de pensée, leur aptitude à être rationnels sans dépendre d’une idéologie avaient pour lui un certain attrait. « L’amour de la liberté impose de préserver toutes les ressources qui rendent cette liberté possible – depuis le caractère sacré de nos familles et la richesse de notre terre jusqu’au génie de nos savants », avait-il proclamé dans son premier discours d’investiture. Il organisa des dîners de scientifiques à la Maison Blanche, comme le feraient plus tard les Kennedy avec les artistes, et en rassembla un grand nombre autour de lui dans des postes de conseillers.

Spoutnik fournit à Eisenhower l’occasion de formaliser son ouverture envers les scientifiques. Moins de deux semaines après le lancement du satellite russe, il réunit quinze conseillers scientifiques de haut rang qui avaient travaillé pour le Bureau de la mobilisation pour la défense nationale, et leur demanda, raconte son collaborateur Sherman Adams, « de lui dire où devrait se placer la recherche scientifique dans la structure du gouvernement fédéral27 ». Il rencontra ensuite au petit déjeuner James Killian, le président du MIT, et le nomma conseiller scientifique à plein temps28. En collaboration avec le secrétaire à la Défense, Killian élabora un plan, annoncé en janvier 1958, pour intégrer l’ARPA au Pentagone ; comme le note l’historien Fred Turner, « l’ARPA représentait une extension des collaborations militaro-universitaires orientées vers la défense nationale qui avaient débuté pendant la Seconde Guerre mondiale29. »

Le bureau interne à l’ARPA que Licklider était appelé diriger s’appelait Recherche en commande et contrôle. Sa mission était d’étudier comment des ordinateurs interactifs pourraient contribuer à faciliter le flux de l’information. Il y avait une autre offre d’emploi pour la conduite d’un groupe qui étudierait les facteurs psychologiques dans la prise de décision militaire. Licklider soutint que ces deux sujets devraient fusionner. « J’ai commencé à exprimer éloquemment mon sentiment : les problèmes du couple commande/contrôle étaient essentiellement des problèmes d’interaction homme-ordinateur », dirait-il plus tard30. Il accepta de se charger des deux tâches et baptisa son groupe mixte Bureau des techniques de traitement de l’information de l’ARPA – IPTO pour Information Processing Techniques Office.

Licklider avait beaucoup d’idées passionnantes, surtout sur la manière d’encourager le temps partagé, l’interactivité en temps réel et les interfaces qui faciliteraient la symbiose homme-machine. Toutes convergeaient vers un seul concept : le réseau. Avec son humour pince-sans-rire, il commença à désigner sa vision par l’expression « intentionnellement grandiloquente » de « Réseau informatique intergalactique31 ».

Dans une note de service d’avril 1963 adressée aux « membres et affiliés » de ce réseau de rêve, Licklider en décrivit les objectifs : « Considérons la situation dans laquelle plusieurs centres différents sont reliés en réseau […] N’est-il pas désirable voire nécessaire que tous les centres se mettent d’accord sur un langage ou, du moins, sur quelques conventions pour poser des questions telles que “Quelle langue parlez-vous32 ?” »

Bob Taylor et Larry Roberts

Contrairement à de nombreux autres associés qui firent progresser l’ère numérique, Bob Taylor et Larry Roberts ne furent jamais amis, ni avant ni après leur séjour commun à l’IPTO. Et, de fait, des années plus tard, chacun dénigrerait amèrement la contribution de l’autre. « Larry prétend qu’il a installé le réseau lui-même, ce qui est totalement faux », se plaignit Taylor en 2014. Ne lui faites pas confiance. Je suis désolé pour lui33. » Pour sa part, Roberts affirme que Taylor est amer parce que son mérite n’a pas été suffisamment reconnu. « Je ne sais pas quel mérite on peut lui reconnaître à part celui de m’avoir recruté. C’est la seule chose importante que Bob ait jamais faite34. »

Mais pendant les quatre années où ils travaillèrent ensemble à l’ARPA dans les années 1960, Taylor et Roberts se complétèrent à merveille. Taylor n’était pas un brillant scientifique : il n’avait même pas un doctorat. Mais avec sa personnalité affable et persuasive il attirait les talents comme un aimant. Roberts, en revanche, était un ingénieur pur et dur aux façons brusques, à la limite de la sécheresse, qui se chronométrait en essayant différents parcours à pied entre les bureaux du tentaculaire Pentagone. Il ne charmait pas ses collègues, mais il forçait souvent leur respect. Et ses manières directes et brutales faisaient de lui un gestionnaire compétent, même s’il n’était pas aimé. Taylor amadouait les gens, Roberts les impressionnait avec son intellect.

Bob Taylor naquit en 1932 au Texas dans un foyer pour mères célibataires à Dallas, puis fut mis dans le train et expédié dans un orphelinat de San Antonio avant d’être adopté, à l’âge de vingt-huit jours, par un pasteur méthodiste itinérant et son épouse. La famille déménageait tous les deux ou trois ans, au gré des affectations du père, dans des villes comme Uvalde, Ozona, Victoria, San Antonio et Mercedes35. Comme dans le cas de Steve Jobs, autre enfant adopté, les parents de Taylor ne cessaient de souligner qu’il avait été « choisi, trié sur le volet ». Comme il le disait en plaisantant : « Tous les autres parents avaient été obligés de prendre ce qu’ils trouvaient, mais moi j’ai été choisi. C’est probablement ce qui m’a donné une assurance imméritée. » Il lui fallut aussi réapprendre, à chaque déménagement familial, à se créer de nouvelles relations, à apprendre de nouvelles expressions locales et à trouver sa place dans la hiérarchie sociale d’une petite ville. « Vous êtes obligé à chaque fois de vous créer un nouveau cercle d’amis et d’interagir avec un nouvel ensemble de préjugés36. »

Taylor étudia la psychologie expérimentale à la Southern Methodist University de Dallas, servit dans la Marine et décrocha une licence et une maîtrise à l’université du Texas. Pendant qu’il rédigeait une dissertation en psychoacoustique, il fut obligé d’entrer ses données sur des cartes perforées en vue de leur traitement séquentiel par le système informatique de l’université. « J’ai été obligé de trimbaler des piles de cartes qui mettaient des jours à être traitées, et ensuite on me disait que j’avais une virgule en trop sur la carte 653 ou un truc de ce genre et qu’il fallait tout refaire. J’étais furieux. » Il se rendit compte qu’il pouvait y avoir une meilleure façon de procéder en lisant l’article de Licklider sur les machines interactives et la symbiose homme-ordinateur, qui suscita chez lui un moment Euréka. « Oui, c’est comme ça que ça devrait être ! », se rappelle-t-il avoir pensé37.

Après avoir enseigné dans un établissement privé et travaillé pour un fournisseur militaire en Floride, Taylor trouva un emploi au siège de la NASA à Washington – il supervisait des recherches sur les affichages de simulateurs de vol. À l’époque, Licklider dirigeait déjà l’IPTO de l’ARPA, où il inaugura une série régulière de rencontres avec des chercheurs gouvernementaux engagés dans des travaux similaires. Lorsque Taylor se présenta fin 1962, Licklider le surprit en manifestant sa connaissance de la dissertation de psychoacoustique qu’il avait écrite à l’université du Texas. (Le directeur de mémoire de Taylor était un ami de Licklider.) « J’étais terriblement flatté, raconte Taylor, alors je suis devenu du jour au lendemain un admirateur et un très bon ami de Lick. »

Taylor et Licklider voyageaient parfois ensemble pour se rendre à des congrès, ce qui cimenta encore plus leur amitié. Lors d’un voyage en Grèce en 1963, Licklider emmena Taylor dans un des musées d’Athènes et lui montra sa technique personnelle pour étudier les coups de pinceau d’un peintre en regardant le tableau de biais. Dans un café, tard le même soir, Taylor fut invité à se joindre aux musiciens à qui il apprit à jouer des chansons de Hank Williams38.

Contrairement à certains ingénieurs, Licklider comme Taylor comprenaient le facteur humain : ils avaient étudié la psychologie, avaient le sens du contact et appréciaient l’art et la musique. Il arrivait parfois à Taylor de fanfaronner et Licklider avait tendance à être trop coulant, ils n’en adoraient pas moins travailler avec d’autres personnes, avec qui ils sympathisaient et dont ils encourageaient les talents. Cette passion de l’interaction humaine et l’attention qu’ils portaient à son fonctionnement les destinaient à concevoir les interfaces entre humains et machines.

Quand Licklider quitta la direction de l’IPTO, son adjoint, Ivan Sutherland, assura l’intérim et, à l’instigation de Licklider, Taylor quitta la NASA pour devenir l’adjoint de Sutherland. Taylor était l’une des rares personnes qui comprenaient que la technologie de l’information pouvait être plus passionnante que le programme spatial. Quand Sutherland eut démissionné en 1966 pour occuper une chaire de professeur titulaire à Harvard, Taylor n’était pas le candidat idéal à sa succession, puisqu’il n’avait pas de doctorat et n’était pas informaticien, mais il finit par obtenir le poste.

À l’IPTO, Taylor fut frappé par trois choses. D’abord, tous les centres de recherche et universités sans exception qui étaient sous contrat avec l’ARPA voulaient les tout derniers ordinateurs et les plus performants. C’était de la redondance et du gaspillage. Il pouvait par exemple y avoir un ordinateur qui faisait du graphisme à Salt Lake City et un autre de l’extraction de données à Stanford, mais un chercheur qui avait besoin d’exécuter ces deux types de tâches devait soit faire la navette en avion, soit demander à l’IPTO de financer un autre ordinateur. Pourquoi ne pourraient-ils pas être connectés par un réseau qui autoriserait leur utilisation réciproque en temps partagé ? Ensuite, dans ses voyages pour interroger de jeunes chercheurs, Taylor découvrit que ceux basés en un endroit désiraient profondément s’informer de l’état des recherches en cours ailleurs. Il comprit qu’il serait logique de les connecter électroniquement afin qu’ils puissent partager plus facilement leurs informations. Enfin, Taylor fut frappé par le fait qu’il y avait trois terminaux dans son bureau au Pentagone, chacun doté de son propre mot de passe et de ses propres instructions, connectés à trois centres informatiques différents financés par l’ARPA. « C’est stupide, songea-t-il. Je devrais pouvoir accéder à n’importe lequel de ces systèmes à partir d’un terminal unique. » Ce besoin de trois terminaux « a conduit à une révélation39 ». Ces trois problèmes pouvaient être résolus d’un seul coup par l’édification d’un réseau de transmission de données qui connecterait les centres de recherche, à condition toutefois que Taylor arrive à mettre en application le rêve de Licklider d’un réseau informatique intergalactique.

Il traversa le Pentagone pour aller dans l’anneau E voir son patron, Charles Herzfeld, directeur de l’ARPA. Avec son accent nasillard du Texas, Taylor sut comment charmer Herzfeld, un intellectuel réfugié originaire de Vienne. Il n’apporta ni mémorandum ni dossier de présentation, mais se lança dans un boniment exubérant. Un réseau financé et imposé par l’ARPA permettrait à des centres de recherche de partager des ressources informatiques, de collaborer à des projets, et à Taylor de mettre au rancart deux des terminaux de son bureau.

« Super idée, dit Herzfeld. Mettez-la en chantier. Vous avez besoin de combien ? »

Taylor admit qu’il se pourrait qu’il faille un million de dollars rien que pour organiser le projet.

« Vous les avez », déclara Herzfeld.

En repartant vers son bureau, Taylor regarda sa montre. « Mon Dieu, se dit-il tout bas. Ça n’a pris que vingt minutes40. »

C’est une anecdote que Taylor a souvent racontée dans des interviews et des historiques oraux. Ce récit ne déplut pas à Herzfeld, mais il se sentit plus tard obligé d’avouer qu’il était un peu trompeur : « [Taylor] laisse de côté le fait que j’étudiais le problème avec lui et Licklider depuis trois ans. Ce n’était pas difficile d’avoir ce million de dollars parce que j’attendais plus ou moins qu’il me le demande41. » Taylor admit que c’était le cas et ajouta en prime son commentaire personnel : « Ce qui m’a vraiment fait plaisir, c’est que Charlie a pris l’argent sur des fonds censés servir à développer un système de défense par missiles, ce qui était à mon avis l’idée la plus stupide et la plus dangereuse qui soit42. »

Taylor avait maintenant besoin de quelqu’un pour diriger le projet, et c’est ainsi que Roberts entra en scène. Il était manifestement l’homme qu’il fallait.

On pourrait croire que Larry Roberts est né et a été élevé pour contribuer à édifier Internet. Ses deux parents étaient titulaires de doctorats en chimie ; dans son enfance passée près de Yale, il avait construit à partir de rien un téléviseur, une bobine Tesla*3, un poste de radio amateur et un système téléphonique. Il étudia au MIT, où il obtint ses licence, maîtrise et doctorat en ingénierie. Impressionné par les articles de Licklider sur la symbiose homme-ordinateur, il alla travailler avec lui au laboratoire Lincoln et devint son protégé dans les domaines du temps partagé, des réseaux et des interfaces. L’une de ses expériences au laboratoire Lincoln impliquait la connexion de deux ordinateurs éloignés ; le projet avait été financé par Bob Taylor à l’ARPA. « Licklider m’avait inspiré, avec sa vision d’ordinateurs connectés en réseau, raconte Roberts, et j’ai décidé de travailler là-dessus. »

Mais Roberts refusait toujours la proposition de Taylor de le faire venir à Washington pour être son adjoint. Son travail au laboratoire Lincoln lui plaisait et il n’avait guère de respect pour Taylor. Il y avait aussi un détail que Taylor ignorait : un an auparavant, on avait proposé à Roberts le poste de Taylor. « Au moment de partir, Ivan m’a demandé de rejoindre immédiatement l’IPTO pour devenir son prochain directeur, mais c’était un poste de gestionnaire, et je préférais la recherche », précise Roberts. Ayant décliné le poste de directeur, Roberts n’allait pas être l’adjoint de Taylor. « Laissez tomber, lui dit-il. Je suis occupé. Je m’amuse un max avec cette recherche merveilleuse43. »

La résistance de Roberts avait une autre raison, que Taylor sentait confusément : « Larry venait du MIT avec un doctorat, et moi je venais du Texas avec une simple maîtrise. Alors je suppose qu’il ne voulait pas travailler pour moi44. »

Or Taylor était un Texan rusé et tenace. En automne 1966, il demanda à Herzfeld : « Charlie, l’ARPA finance bien le laboratoire Lincoln à cinquante et un pour cent, non ? » Herzfeld le lui confirma. « Tu es au courant de ce projet de réseautage que je veux faire ? Bon, j’ai du mal à avoir le directeur de programme que je veux, et il travaille au laboratoire Lincoln. » Peut-être, suggéra Taylor, qu’Herzfeld pourrait appeler le chef du laboratoire et lui dire qu’il serait dans l’intérêt de l’établissement de convaincre Roberts d’accepter ce poste. C’était une manière très texane de procéder, et cela aurait plu au président de l’époque, Lyndon Johnson. Le chef du laboratoire n’était pas idiot. « Ce serait probablement une bonne chose pour tout le monde ici si tu voulais bien prendre ça en considération », fit-il remarquer à Roberts après avoir reçu le coup de fil d’Herzfeld.

En décembre 1966, Larry Roberts alla donc travailler à l’ARPA. « Avec ce chantage, j’ai assuré la célébrité future de Roberts », dirait plus tard Taylor45.

Lorsque Roberts arriva à Washington aux alentours de Noël, sa femme et lui habitèrent quelques semaines chez Taylor en attendant de trouver à se loger. Même s’ils n’étaient pas destinés à devenir copains, les relations entre les deux hommes étaient cordiales et professionnelles, du moins pendant les années qu’ils passèrent à l’ARPA46.

Roberts n’était pas aussi sympathique que Licklider, ni aussi extraverti que Taylor, ni aussi sociable que Bob Noyce. « Larry est un pisse-froid », dirait plus tard Taylor47. Au lieu de quoi il possédait un trait qui était tout aussi utile pour promouvoir la créativité et gérer une équipe : c’était un décideur. Plus important encore, ses décisions ne se fondaient pas sur ses émotions ou un favoritisme personnel, mais plutôt sur une analyse rationnelle et précise des différentes options. Ses collègues respectaient ses décisions, même s’ils n’étaient pas d’accord avec lui, parce qu’il était clair, concis et juste. C’était l’un des avantages qu’il y a à avoir un authentique ingénieur aux commandes. Mal à l’aise dans le rôle d’adjoint de Taylor, Roberts réussit à s’arranger avec le big boss de l’ARPA, Charlie Herzfeld, pour se faire nommer chef scientifique de l’agence. « Je gérais les contrats pendant la journée et je faisais mes recherches sur les réseaux la nuit », raconte Roberts48.

Taylor, lui, était jovial et sociable, parfois à l’excès. « Je suis un extraverti », disait-il. Chaque année, il organisait un colloque des chercheurs financés par l’ARPA et un autre pour leurs meilleurs étudiants de troisième cycle, d’ordinaire en des lieux pittoresques comme Park City, en Utah, ou à La Nouvelle-Orléans. Chaque chercheur devait faire une présentation, ensuite il était bombardé de questions et de suggestions par son auditoire. C’est ainsi que Taylor repérait les étoiles montantes d’un bout à l’autre des États-Unis, et son magnétisme lui serait plus tard très utile quand il irait travailler au Xerox PARC. Ce talent l’aida aussi à accomplir l’une des tâches les plus importantes dans l’édification d’un réseau : convaincre tout le monde de l’intérêt de ce concept.

Arpanet

Taylor savait qu’il avait besoin de convaincre de l’utilité d’un réseau en temps partagé les gens que ce concept était destiné à aider, c’est-à-dire les chercheurs bénéficiant de subventions de l’ARPA. Aussi les invita-t-il à une réunion à l’université du Michigan en avril 1967, où il leur fit présenter le projet par Roberts. Les centres informatiques seraient connectés par des lignes téléphoniques en location, expliqua Roberts. Il décrivit deux architectures possibles : un système à plaque tournante (hub) avec un ordinateur central dans un site comme Omaha, au Nebraska, qui acheminerait les informations, ou un système en réseau qui ressemblait à une carte routière où s’entrecroisaient des lignes tendues de site en site. Roberts et Taylor avaient commencé à pencher pour l’option décentralisée : elle serait plus sûre. Les informations pourraient être transmises de nœud en nœud jusqu’à ce qu’elles atteignent leur destination.

Beaucoup des participants répugnaient à rejoindre un réseau. « Les universités en général ne voulaient pas partager leurs ordinateurs avec qui que ce soit, dirait Roberts en 1989. Elles voulaient acheter leurs propres ordinateurs et se cacher dans leur coin49. » Elles ne voulaient pas non plus que le précieux temps de calcul de leurs machines soit grignoté par l’obligation de traiter le routage du trafic entraîné par le rattachement au réseau. Les premiers contestataires furent Marvin Minsky du Laboratoire d’intelligence artificielle du MIT et son ex-collègue John McCarthy, qui était passé à Stanford. Leurs ordinateurs, soutenaient-ils, tournaient déjà au maximum de leur capacité. Quel intérêt auraient-ils à permettre à d’autres de se brancher sur eux ? En outre, il leur incomberait la charge d’acheminer du trafic réseau venant d’ordinateurs inconnus et dont ils ne parlaient pas le langage. « Ils se plaignaient tous les deux qu’ils allaient perdre de la puissance de calcul et ils ont dit qu’ils ne participeraient pas, raconte Taylor. Je leur ai dit qu’ils n’avaient pas le choix, parce que ça me permettrait de diviser par trois mon financement de l’informatique50. »

Taylor était convaincant et Roberts tenace, et ils firent remarquer aux participants qu’ils étaient tous financés par l’ARPA. « Nous allons construire un réseau et vous allez y participer, déclara sèchement Roberts. Et vous allez y connecter vos machines51. » Ils n’obtiendraient plus de subventions pour acheter des ordinateurs tant qu’ils ne seraient pas branchés sur le réseau.

Des idées jaillissent souvent d’échanges lors de réunions, et celle qui se matérialisa à la fin de la séance du Michigan contribua à détendre l’atmosphère. Elle venait de Wes Clark, qui avait conçu un ordinateur personnel, surnommé le LINC, au laboratoire Lincoln du MIT. Il s’intéressait plus au développement d’ordinateurs conçus pour l’usager individuel qu’à la promotion du temps partagé de gros ordinateurs, aussi n’avait-il pas tellement prêté attention à la discussion. Mais vers la fin de la réunion, il comprit pourquoi il était difficile de faire accepter l’idée du réseau aux centres de recherche : « Juste avant que nous nous séparions, j’ai le souvenir très clair d’avoir brusquement trouvé où était le méta-problème. J’ai fait passer à Larry une note où je disais que je pensais avoir vu comment résoudre le problème52. » Sur le chemin de l’aéroport, dans une voiture de location conduite par Taylor, Clark expliqua son idée à Roberts et à deux autres collègues. L’ARPA ne devrait pas forcer les ordinateurs de recherche de chaque site à prendre en charge le routage des données. Au lieu de quoi l’ARPA devrait concevoir et donner à chaque site un mini-ordinateur normalisé qui se chargerait du routage. Le gros système informatique en place sur chaque site n’aurait plus que la tâche simple consistant à établir une connexion avec son mini-ordinateur de routage fourni par l’ARPA. Ce qui avait trois avantages : cela déchargerait le gros ordinateur du site hôte de la plus grande partie de la tâche, donnerait à l’ARPA le pouvoir de normaliser le réseau, et permettrait que le routage des données soit complètement délocalisé au lieu d’être contrôlé par un tout petit nombre de grosses plaques tournantes.

Taylor embrassa l’idée sur-le-champ. Roberts posa quelques questions, puis exprima son accord. Le réseau serait géré par les mini-ordinateurs normalisés que Clark avait proposés et qu’on appela « processeurs de messages interfacés » ou IMP (pour Interface Message Processors). Plus tard, on les appellerait simplement « routeurs ».

Quand ils arrivèrent à l’aéroport, Taylor demanda qui devrait construire ces IMP. Pour Clark, c’était évident : la tâche devrait être confiée à Bolt, Beranek & Newman, la firme de Cambridge où Licklider avait travaillé. Mais il y avait aussi dans la voiture Al Blue, qui était chargé des questions de conformité à l’ARPA. Il rappela au groupe que le projet devrait faire l’objet d’un appel d’offres, conformément aux normes fédérales en matière de contrats avec le secteur privé53.

Dans une réunion de suivi qui se tint à Gatlinburg, au Tennessee, en octobre 1967, Roberts présenta une version révisée du projet de réseau. Il lui donna aussi un nom, ARPA Net, simplifié plus tard en ARPANET. Mais il restait un problème à résoudre : la communication entre deux points du réseau nécessiterait-elle une ligne dédiée entre eux, comme pour une communication téléphonique ? Ou alors y avait-il un moyen pratique quelconque de permettre à de multiples flux de données de partager des lignes simultanément, un peu comme le système de temps partagé pour les lignes téléphoniques ? Les caractéristiques potentielles de pareil réseau de transmission de données avaient été proposées au début du mois par une commission du Pentagone.

C’est alors qu’un jeune ingénieur anglais, Roger Scantlebury, se leva pour présenter un article décrivant les travaux de son patron, Donald Davies, du Laboratoire national de physique britannique. L’article donnait une réponse : une méthode pour fractionner les messages en petits éléments que Davies avait qualifiés de « paquets ». Scantlebury ajouta que l’idée avait été indépendamment développée par un chercheur de la RAND, Paul Baran. Après son exposé, Larry Roberts et d’autres se rassemblèrent autour de Scantlebury pour en savoir plus, puis se replièrent sur le bar pour en discuter jusqu’à une heure tardive.

Le transfert par paquets : Paul Baran,

Donald Davies et Leonard Kleinrock

Il existe de nombreuses manières d’envoyer des données via un réseau. La plus simple, dite commutation de circuits (circuit switching), est utilisée dans le système téléphonique : un ensemble de commutateurs crée un circuit dédié permettant aux signaux de circuler dans les deux directions tout le temps que dure la conversation, la connexion restant établie même pendant de longues pauses. Une autre méthode est la commutation de messages (message switching) ou, comme l’appelèrent les compagnies de télégraphe, la commutation de messages en différé (store-and-forward switching). Dans ce système, un message entier reçoit un en-tête d’adresse, est envoyé dans le réseau puis transmis de nœud en nœud jusqu’à sa destination.

Une méthode encore plus efficace est la commutation ou transfert par paquets (packet switching), cas particulier de commutation en différé dans lequel les messages sont fractionnés en minuscules éléments exactement de la même taille, les paquets, chacun muni d’un en-tête d’adresse indiquant où ils doivent aller. Ces paquets sont alors expédiés dans le réseau où ils caracolent jusqu’à leur destination, transmis de nœud en nœud en utilisant n’importe lesquelles des liaisons disponibles à cet instant. Si certaines liaisons commencent à être embouteillées par une surcharge de données, des paquets seront détournés vers des liaisons de substitution. Quand tous les paquets arrivent au nœud de leur destination, ils sont réassemblés conformément aux instructions des en-têtes. « C’est comme si on fractionnait une longue lettre en des dizaines de cartes postales numérotées adressées au même endroit, expliquait Vinton Cerf, l’un des pionniers d’Internet. Elles peuvent toutes prendre des itinéraires différents pour arriver à destination, et ensuite elles sont réassemblées54. »

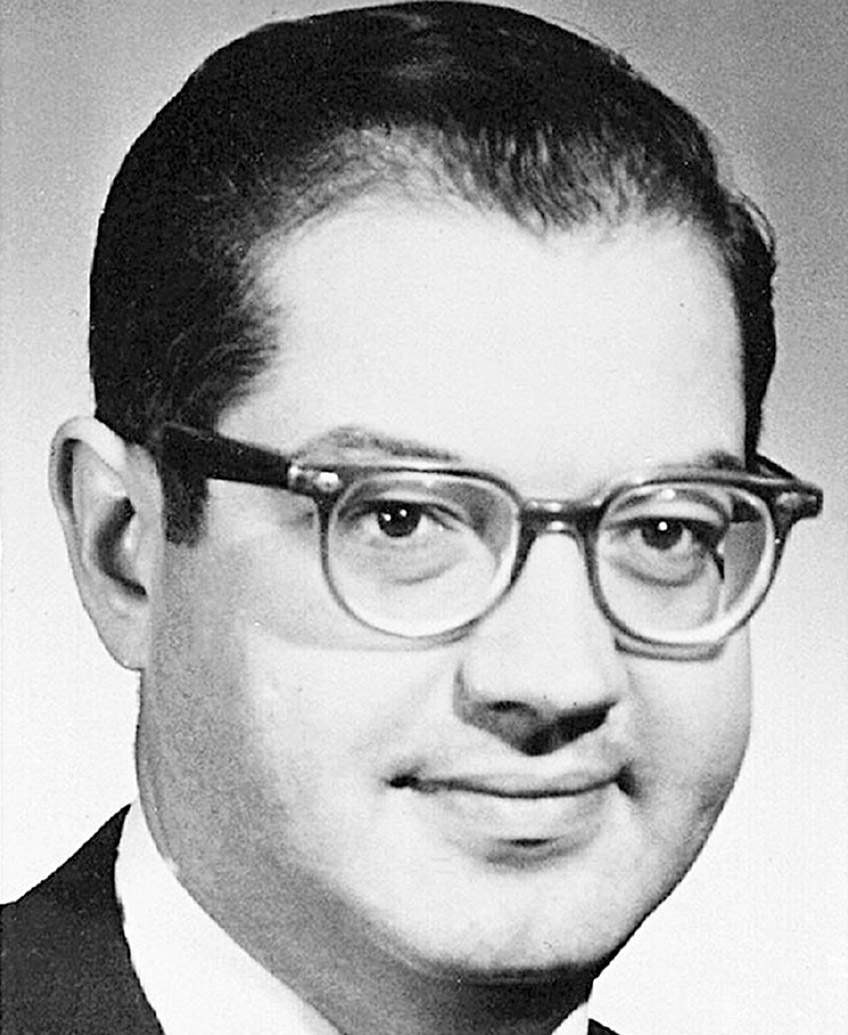

Comme Scantlebury l’avait expliqué à Gatlinburg, le premier concepteur d’un réseau à transfert de paquets était un ingénieur du nom de Paul Baran (prononcé comme bear et non comme bar). Sa famille avait émigré de Pologne quand il avait deux ans et s’était fixée à Philadelphie, où son père ouvrit une petite épicerie. Après avoir terminé ses études à l’université Drexel en 1949, Baran rejoignit la société d’informatique nouvellement créée par Presper Eckert et John Mauchly, où il testait des composants pour l’UNIVAC. Il partit pour Los Angeles, prit des cours du soir à l’UCLA et finit par décrocher un emploi à la RAND Corporation.

Lorsque les Soviétiques testèrent une bombe à hydrogène en 1955, Baran se découvrit une mission : contribuer à empêcher l’holocauste nucléaire. Un jour qu’il examinait chez RAND la liste hebdomadaire des sujets sur lesquels l’armée de l’air voulait commander des recherches, il en isola un relatif à l’élaboration d’un système de communications militaire capable de survivre à une attaque ennemie. Il savait qu’un tel système pourrait contribuer à éviter un échange nucléaire, car si l’un des camps craignait que son système de communications soit anéanti, il serait plus facilement tenté de lancer le premier une attaque préventive en cas de montée des tensions. Avec des systèmes de communications capables de survie, les nations en présence ne ressentiraient pas le besoin d’avoir constamment le doigt sur la détente.

Baran trouva deux idées clés qu’il commença à publier en 1960. La première était que le réseau ne devrait pas être centralisé ; il ne devrait pas y avoir de plaque tournante principale contrôlant l’ensemble des commutations et du routage. Il ne devrait pas être non plus simplement décentralisé, avec le contrôle réparti sur de nombreuses plaques tournantes régionales, comme le réseau téléphonique américain d’AT&T ou la carte des lignes d’une grande compagnie aérienne. Si l’ennemi détruisait quelques-unes de ces plaques tournantes, le système serait neutralisé. Au lieu de quoi, le contrôle devrait être complètement délocalisé. Autrement dit, tous les nœuds sans exception devraient avoir le même pouvoir de commuter et d’acheminer le flux de données. Ce qui deviendrait le trait distinctif d’Internet, l’attribut enraciné dans sa conception qui lui permettrait d’émanciper les individus et de résister au contrôle centralisé.

Paul Baran (1926-2011).

Leonard Kleinrock (né en 1934).

Vinton Cerf (né en 1943) et Bob Kahn (né en 1938).

Il dessina un réseau qui ressemblait à un filet. Tous les nœuds auraient la capacité d’acheminer du trafic, et tous étaient connectés à quelques autres nœuds. Si l’un des nœuds était détruit, alors le trafic serait détourné sur d’autres itinéraires. « Il n’y a pas de contrôle central, expliquait Baran. Une simple procédure locale de routage est exécutée à chaque nœud. » Il estima que même avec trois ou quatre liaisons par nœud, le système aurait une résistance et une capacité de survie quasi illimitées. « Un simple niveau de redondance de trois ou quatre autoriserait un réseau presque aussi robuste que la limite théorique55. »

« Après avoir trouvé comment obtenir la robustesse, j’ai été ensuite obligé de m’attaquer au problème de la transmission des signaux dans ce type de réseau en filet », raconte Baran56. Ce qui lui inspira sa deuxième idée, qui était de fractionner les données en petits blocs d’une taille normalisée. Un message serait fractionné en un grand nombre de ces blocs, dont chacun cheminerait via un itinéraire différent, et qui seraient réassemblés une fois arrivés à destination : « Un bloc message universellement normalisé pourrait être par exemple composé de 1024 bits. La majeure partie du bloc message serait réservée au type de données à transmettre, quel qu’il soit, tandis que le reste contiendrait des informations d’intendance, telles que la détection d’erreur et les données de routage. »

Baran se heurta alors à l’une des réalités de l’innovation, à savoir que les bureaucraties bien enracinées sont résistantes au changement. La RAND recommanda son idée d’un réseau à transfert par paquets à l’armée de l’air qui, après un examen approfondi, décida d’en construire un. Mais le ministère de la Défense décréta alors que toute entreprise de ce type devrait être menée par l’Agence des communications de la défense de façon à être utilisée par toutes les branches de l’appareil militaire. Et Baran se rendit compte que ladite Agence n’aurait jamais ni le désir ni la capacité de le faire.

Il essaya donc de persuader AT&T de compléter son réseau vocal à commutation de circuits par un réseau de transmission de données à transfert de paquets. « Ils se sont défendus bec et ongles, raconte-t-il. Ils ont essayé tout un tas de trucs pour l’empêcher. » Les gens d’AT&T ne voulaient même pas que la RAND se serve des cartes de ses circuits, ce qui obligea Baran à s’en procurer un jeu en cachette. Il fit plusieurs expéditions au siège d’AT&T à Manhattan. Au cours de l’une d’elles, un cadre supérieur – un ingénieur des circuits analogiques à l’ancienne – fut apparemment stupéfait lorsque Baran expliqua qu’avec son système les données pourraient circuler dans les deux directions sans qu’un circuit dédié reste ouvert en permanence. « Il a regardé ses collègues dans la pièce tandis que ses globes oculaires envoyaient un signal d’incrédulité totale », raconte Baran. Après un silence, le cadre dit : « Fiston, voilà comment ça marche, un téléphone », puis se lança dans une description paternaliste et simpliste du procédé.

Lorsque Baran persista à promouvoir son idée apparemment ridicule que les messages pouvaient être hachés menu et foncer dans le réseau sous forme de minuscules paquets, AT&T l’invita, lui et d’autres chercheurs extérieurs, à une série de séminaires pour expliquer comment son système fonctionnerait en réalité. « Il a fallu quatre-vingt-quatorze intervenants distincts pour décrire tout le système », s’émerveilla Baran. Lorsque la présentation fut terminée, les responsables de chez AT&T demandèrent à Baran : « Est-ce que vous voyez maintenant pourquoi le transfert de paquets ne marcherait pas ? » Ils furent très déçus quand Baran répondit simplement « Non. » Encore une fois, AT&T était bloqué par le dilemme de l’innovation. Le monopole téléphonique refusait d’envisager un type entièrement nouveau de réseau de transmission de données tellement il avait investi dans les circuits traditionnels57.

Les travaux de Baran culminèrent finalement dans onze volumes d’analyse d’ingénierie détaillée, Sur les communications délocalisées, achevés en 1964. Il insista pour que cette somme ne soit pas classée secret-défense, parce qu’il avait compris que pareil système aurait un maximum d’efficacité si les Russes en avaient un eux aussi. Bien que Bob Taylor en ait lu des passages, personne d’autre à l’ARPA ne le fit, et l’idée de Baran n’eut donc guère d’impact jusqu’au jour où elle fut portée à l’attention de Larry Roberts lors du colloque de Gatlinburg en 1967. Une fois rentré à Washington, Roberts exhuma les rapports de Baran, les dépoussiéra et se mit à les lire.

Roberts se procura également les articles écrits par le groupe de Donald Davies en Angleterre et que Roger Scantlebury avait résumés à Gatlinburg. Davies était le fils d’un Gallois employé aux écritures dans une mine de charbon, qui décéda quelques années après la naissance de son fils en 1924. Le jeune Davies fut élevé à Portsmouth par sa mère, qui travaillait pour les Postes britanniques, lesquelles géraient le réseau téléphonique national. Il passa son enfance à jouer avec des circuits téléphoniques, puis obtint des licences en maths et en physique à l’Imperial College de Londres. Pendant la guerre, il travailla à l’université de Birmingham, créant des alliages pour les tubes des armes nucléaires comme assistant de Klaus Fuchs, qui s’avéra être un espion soviétique. Il travailla ensuite avec Alan Turing à la construction de l’Automatic Computing Engine, un calculateur à programme enregistré, au Laboratoire national de physique.

Davies s’intéressa ensuite à l’informatique en temps partagé, dont il avait appris l’existence lors d’une visite au MIT en 1965, et à l’usage des lignes téléphoniques pour la transmission de données. En combinant mentalement ces deux idées, il se fixa comme objectif de trouver une méthode similaire au temps partagé qui puisse tirer le maximum des lignes téléphoniques. Ce qui le conduisit aux mêmes concepts que Baran avait développés à propos de l’efficacité du fractionnement des messages en unités de taille réduite. Il trouva aussi un bon vieux mot anglais pour les désigner : packets. Quand il essaya de convaincre les Postes britanniques d’adopter ce système, il se heurta au même problème que Baran quand il avait frappé à la porte de chez AT&T. Mais ils se trouvèrent tous les deux un fan à Washington. Larry Roberts accueillit leurs idées à bras ouverts, et adopta le terme packets en prime58.

Il y eut aussi l’apport d’un troisième homme, quelque peu controversé, qui ne dédaignait pas l’autopromotion, l’affable et réjouissant Leonard Kleinrock, expert en flux des données dans les réseaux, qui devint un grand ami de Larry Roberts quand, jeunes doctorants, ils se partagèrent un bureau au MIT. Kleinrock grandit à New York dans une famille d’immigrants pauvres. Son intérêt pour l’électronique se déclencha quand, à l’âge de six ans, en lisant une BD de Superman, il vit des instructions pour construire un poste à galène qui marchait sans piles. Il réunit un rouleau de papier hygiénique, l’une des lames de rasoir de son père, un peu de fil électrique et le graphite d’une mine de crayon, ensuite il convainquit sa mère de l’emmener en métro jusqu’à la partie sud de Manhattan pour acheter un condensateur à capacité variable dans un magasin d’électronique. Le montage fonctionna, et une fascination pour l’électronique qui durerait toute sa vie commença à s’épanouir. « Je n’en reviens toujours pas, raconte-t-il en parlant du poste à galène. J’ai toujours l’impression que c’est de la magie. » Il se mit à annoter des manuels de lampes de radio trouvés chez des soldeurs et à récupérer des postes de radio abandonnés dans les bennes à ordures ; il les dépeçait comme un vautour pour en retirer les composants afin de pouvoir bricoler ses propres postes59.

N’ayant pas les moyens d’accéder à l’université, même au City College of New York où la scolarité était gratuite, il travaillait le jour dans une firme d’électronique et prenait des cours du soir. Les enseignants du soir avaient plus l’esprit pratique que ceux de la journée ; au lieu de lui apprendre la théorie des transistors, raconte Kleinrock, l’enseignant lui disait à quel point ils étaient sensibles à la chaleur et comment compenser la température attendue en concevant un circuit. « On n’apprenait jamais ce genre d’astuces pratiques dans les cours de la journée. Le prof ne l’aurait pas su60. »

Après avoir obtenu son diplôme, il décrocha une bourse pour faire son doctorat au MIT. C’est là qu’il étudia la théorie des files d’attente, qui examine des problèmes comme la prévision du temps d’attente moyen compte tenu de facteurs variés, et il formula dans sa thèse certaines des théories mathématiques sous-jacentes qui analysaient le flux des messages et la formation d’embouteillages dans les réseaux de données à commutation. En plus de partager un bureau avec Roberts, Kleinrock était un condisciple d’Ivan Sutherland et avait assisté à des conférences de Claude Shannon et de Norbert Wiener. « C’était vraiment un foyer d’excellence intellectuelle61 », dirait-il du MIT des années 1950.

Une nuit où un Kleinrock épuisé faisait tourner une des machines du laboratoire d’informatique du MIT, un énorme ordinateur expérimental appelé le TX-2, il entendit un « pssssss » insolite : « J’ai commencé à être très inquiet. Il y avait un casier vide où un élément de la machine avait été retiré pour être réparé, j’ai levé les yeux en l’air, j’ai regardé dans ce casier et il y avait deux yeux qui me regardaient ! » C’était Larry Roberts qui lui faisait une farce62.

L’effervescent Kleinrock et le glacial Roberts restèrent amis en dépit (ou peut-être à cause) de leurs personnalités différentes. Ils aimaient faire ensemble la tournée des casinos de Las Vegas pour essayer de rouler la banque. Roberts trouva un système de comptage de cartes pour le black-jack, fondé sur le repérage tant des cartes fortes que des cartes faibles, et il l’enseigna à Kleinrock. « Nous nous sommes fait virer un jour, ma femme et moi, quand nous jouions au Hilton : les directeurs du casino nous surveillaient à travers le plafond et ils ont eu des soupçons quand j’ai pris une assurance sur une main à un moment où, normalement, on ne le ferait pas à moins de savoir qu’il ne restait pas beaucoup de cartes fortes dans le sabot », raconte Roberts. Un autre stratagème impliquait d’essayer de calculer la trajectoire de la balle à la roulette à l’aide d’un compteur fait avec des transistors et un oscillateur. Il était censé mesurer la vélocité de la balle et prédire de quel côté du tambour elle finirait, ce qui augmentait les chances en faveur du joueur. Pour recueillir les données nécessaires, Roberts avait un enregistreur caché dans sa main sous des bandes de gaze. Le croupier, se doutant qu’il y avait du louche, regarda Roberts et Kleinrock et demanda : « Vous voulez que je vous casse l’autre bras ? » Ils décidèrent que non et partirent63.

Dans sa proposition de thèse de doctorat, rédigée en 1961, Kleinrock prévoyait d’explorer les fondements mathématiques de la prédiction des embouteillages dans un réseau de type maillé. Dans ce mémoire et d’autres articles, il décrivait un réseau à transfert différé – « réseau de communication où il y a stockage à chacun des nœuds » –, mais pas un réseau employant exclusivement le transfert de paquets, dans lequel les messages seraient fractionnés en minuscules unités toutes exactement de la même taille. Kleinrock traitait la question du « retard moyen subi par un message en traversant le réseau » et analysait comment l’imposition d’une structure prioritaire incluant le fractionnement des messages contribuerait à résoudre ce problème. Toutefois, il n’utilisa pas le terme de « paquet » ni n’introduisit de concept qui s’en rapproche étroitement64.

Kleinrock était un collègue sociable et empressé, mais il ne tenta jamais d’égaler Licklider dans sa réticence à revendiquer ses découvertes. Il s’aliénerait plus tard un grand nombre des autres développeurs d’Internet en affirmant que, dans sa thèse de doctorat et l’article qui la proposait (écrits tous les deux après que Paul Baran eut commencé à formuler le transfert par paquets à la RAND), il avait « développé les principes de base du transfert par paquets » et « la théorie mathématique des réseaux à transfert par paquets, technologie sous-jacente à Internet65 ». À partir du milieu des années 1990, il entama une campagne énergique pour se faire reconnaître comme « le père des réseaux de données modernes66 ». Ou, comme il l’affirmait dans une interview en 1996, « ma thèse de doctorat a établi les principes de base du transfert par paquets67. »

Il s’ensuivit donc un tollé parmi les autres pionniers d’Internet, qui attaquèrent publiquement Kleinrock en disant que sa brève mention d’un fractionnement des messages était très loin d’une proposition visant le transfert par paquets. « Kleinrock est un prévaricateur, dit Bob Taylor. Sa prétention d’avoir joué le moindre rôle dans l’invention du transfert par paquets est l’exemple typique d’une incorrigible autopromotion dont il est coupable depuis toujours68. » (À quoi Kleinrock répliqua : « Taylor est mécontent parce qu’il n’a jamais eu la reconnaissance qu’il estimait mériter69. »)

Donald Davies, le chercheur britannique qui créa le terme « paquet », était un homme aimable et réservé qui ne se vantait jamais de ses exploits. On le disait humble à l’excès. Mais juste avant de mourir il rédigea un article, publié à titre posthume, qui attaquait Kleinrock en des termes d’une surprenante vigueur : « Les travaux de Kleinrock avant et jusqu’à 1964 ne lui donnent aucun droit de revendiquer la création du transfert par paquets, écrivait Davies après une analyse en profondeur. Le passage de son ouvrage sur la discipline des files d’attente en temps partagé, s’il avait été poursuivi jusqu’à une conclusion, aurait peut-être pu le conduire au transfert par paquets, mais ce ne fut pas le cas […] Je ne trouve nulle part la preuve qu’il ait compris les principes du transfert par paquets70. » Alex McKenzie, un ingénieur qui dirigeait le centre de contrôle des réseaux chez BBN, serait plus tard encore plus direct : « Kleinrock prétend avoir introduit l’idée de la paquetisation. C’est totalement absurde ; il n’y a RIEN dans son ouvrage de 1964 qui suggère ou analyse l’idée de la paquetisation, ni qui y fasse allusion. » Il trouvait les prétentions de Kleinrock « ridicules71 ».

La réaction contre Kleinrock fut si acerbe qu’elle devint le sujet d’un article de Katie Hafner dans le New York Times en 2001. Elle y décrivait comment l’attitude collégiale habituelle des pionniers d’Internet avait été pulvérisée par la revendication de priorité de Kleinrock pour le concept du transfert par paquets. Paul Baran, qui, lui, méritait d’être connu comme le père du transfert par paquets, se manifesta pour dire que « Internet est en réalité l’œuvre de mille personnes », et il déclara ostensiblement que la plupart des gens impliqués n’avaient pas de revendications en la matière. « Il y a seulement ce cas particulier insignifiant, qui semble être une aberration », ajouta-t-il dans une allusion méprisante à Kleinrock72.

On notera avec intérêt que jusqu’au milieu des années 1990, Kleinrock avait attribué à d’autres la découverte du transfert par paquets. Dans un article publié en 1978, il citait Baran et Davies comme les pionniers de ce concept : « Au début des années 1960, Paul Baran avait décrit certaines des propriétés des réseaux de transmission de données dans une série d’articles pour la RAND Corporation […] En 1968, Donald Davies, au Laboratoire national de physique britannique, commençait à écrire sur les réseaux à transfert de paquets73. » De même, dans un article de 1979 décrivant le développement des réseaux délocalisés, Kleinrock ne citait ni ne mentionnait ses propres travaux du début des années 1960. En 1990, il déclarait encore que Baran avait été le premier à concevoir le transfert par paquets : « Je lui [Baran] attribuerais la paternité des premières idées74. » En revanche, lorsque son article de 1979 fut réimprimé en 2002, Kleinrock écrivit une nouvelle introduction où il proclamait : « J’ai développé les principes sous-jacents au transfert par paquets, ayant publié le premier article sur la question en 196175. »

Pour être juste envers Kleinrock, qu’il ait ou non prétendu que ses travaux du début des années 1960 avaient élaboré le transfert par paquets, il aurait mérité (et mérite encore) un certain respect en tant que pionnier d’Internet. C’était incontestablement un des premiers théoriciens marquants du flux de données dans les réseaux et aussi un précieux chef de file dans la construction d’ARPANET. Il fut l’un des premiers à calculer les effets du fractionnement des messages quand ils passaient d’un nœud à l’autre. En outre, Larry Roberts appréciait ses travaux théoriques et l’avait enrôlé dans l’équipe chargée de la mise en œuvre d’ARPANET. L’innovation est impulsée par des gens qui trouvent de bonnes théories et ont l’occasion de faire partie d’un groupe capable de les mettre en application.

La controverse autour de Kleinrock est intéressante parce qu’elle montre que la plupart des créateurs d’Internet préféraient – pour employer la métaphore d’Internet lui-même – un système de mérites complètement délocalisé. Ils isolaient et contournaient instinctivement tout nœud qui tentait de revendiquer une signification plus grande que les autres. Internet est né d’une éthique de la collaboration créative et de la prise de décision délocalisée, et il plaisait à ses fondateurs de protéger ce patrimoine. Il s’est enraciné dans leur personnalité et dans l’ADN d’Internet même.

L’origine « nucléaire » d’ARPANET :

réalité ou mythe ?

L’un des aspects historiques les plus communément acceptés d’Internet est qu’il a été édifié pour survivre à une attaque nucléaire. Ce qui fait enrager nombre de ses architectes, notamment Bob Taylor et Larry Roberts, qui ont à maintes reprises et avec insistance démoli ce mythe des origines. Toutefois, comme c’est le cas de bien des innovations de l’ère numérique, il y a multiplicité de causes et d’origines. Différents acteurs ont des perspectives différentes. Certains, plus haut placés dans la hiérarchie que Taylor et Roberts, et qui sont mieux renseignés sur les motifs exacts des décisions de financement, ont commencé à démystifier la démystification. Essayons de nous y retrouver.

Il ne fait pas de doute que, lorsque Paul Baran proposa un réseau à transfert de paquets dans ses rapports pour la RAND, la capacité de survie à une attaque nucléaire était l’une de ses idées directrices : « Il était nécessaire d’avoir un système stratégique qui puisse résister à une première attaque et puisse ensuite rendre à l’attaquant la monnaie de sa pièce. Le problème était que nous n’avions pas de système de communications capable de survivre, si bien que les missiles soviétiques visant les [bases de] missiles américains détruiraient totalement le système de communications téléphoniques76. » Ce qui conduisait à une situation dangereusement instable : une nation serait plus facilement tentée de lancer une frappe préventive si elle craignait que ses communications et sa capacité de riposte ne survivent pas à une attaque. « L’origine du transfert par paquets est tout à fait dans le style de la guerre froide. Je me suis précisément intéressé à la manière de construire un système fiable de commandement et de contrôle77. » En 1960, Baran entreprit donc de concevoir « un réseau de communications permettant à plusieurs centaines de stations de communications vitales de communiquer les unes avec les autres après une attaque ennemie78. »