Kapitel 5

Die richtige Organisationseinheit beauftragen

Die meisten Führungskräfte unterliegen dem Irrtum zu glauben, einzig und allein für die Ausrichtung des eigenen Unternehmens verantwortlich zu sein und die Zügel fest in der Hand zu haben. Sie sind der festen Überzeugung, dass sie es sind, die alle wichtigen Entscheidungen treffen und dass – sobald sie ihre Entscheidungen getroffen haben – sich alle Mitarbeiter sofort dieser Sache annehmen und sie umsetzen. Dieses Kapitel baut auf einen bereits diskutierten Gedanken auf: In Wahrheit sind es die Kunden des Unternehmens, die darüber entscheiden, was tatsächlich umgesetzt wird und was nicht. Wir konnten in der Branche der Computerlaufwerke beobachten, dass Unternehmen dann bereit waren, auf technologisch riskante Projekte zu setzen, wenn sie der Überzeugung waren, dass die Kunden einen Bedarf an den daraus entstehenden Produkten entwickeln würden. Aber es war ihnen unmöglich, Ressourcen für einfachere, disruptive Projekte zu mobilisieren, wenn sich abzeichnete, dass die profitabelsten Kunden kein Interesse daran finden würden.

Diese Beobachtung unterstützt die etwas kontroverse Theorie der Ressourcenabhängigkeit, die nur von einer Minderheit von Managementforschern vertreten wird165. Sie unterstellt, dass die Handlungsspielräume eines Unternehmens begrenzt sind. Sie werden bestimmt von externen Stakeholdern .(hauptsächlich von Kunden und Investoren), deren Bedürfnisse zufrieden gestellt werden müssen, denn sie sind es schließlich, die dem Unternehmen die überlebenswichtigen Ressourcen zur Verfügung stellen. Ausgehend von den Theorien der biologischen Evolution, behaupten Vertreter dieses Ansatzes, dass Organisationen nur dann überleben und florieren, wenn ihre Mitglieder, ihre Strategien und sämtliche Abläufe die Interessen der Kunden und Investoren wahren. Dies geschähe dann, wenn diese Unternehmen die erwarteten Produkte, Dienstleistungen und Gewinne hervorbringen. Organisationen, die das nicht tun, werden die lebensnotwendigen Ressourcen nicht erhalten und schließlich sterben166. Dieser .„Survival-of-the-fittest“-Prozess führt dazu, dass jene Unternehmen am erfolgreichsten sind, denen es am besten gelingt, Prozesse und Systeme so zu gestalten, dass die Kunden zufriedengestellt werden. Diese Theorie führt allerdings zu sehr kontroversen Diskussionen. Denn immerhin unterstellt sie den Führungskräften, den Kunden gegenüber macht- bzw. hilflos zu sein, sobald sie gegen deren Bedürfnisse handeln. Selbst Führungskräfte – die die kühnsten und innovativsten Visionen für eine neue Ausrichtung des Unternehmens haben – sind zum Scheitern verurteilt, wenn nicht ihre Mitarbeiter da[130]hinter stehen oder wenn diese nicht in der Lage sind, die dafür nötigen Prozesse einzuleiten oder zu verändern. Kundenorientierte Mitarbeiter und auf Kundenorientierung ausgerichtete Prozesse sind äußerst mächtig. Sie können alle Anstrengungen der Manager zunichte machen. Da die Kunden dem Unternehmen die überlebensnotwendigen finanziellen Ressourcen zur Verfügung stellen, sind sie es – und nicht die Führungskräfte –, die den Kurs des Unternehmens bestimmen. Vertreter dieser Theorie behaupten deshalb, dass die Rolle der Führungskräfte lediglich eine symbolische ist. In Wahrheit erfolgt die Kursbestimmung eines Unternehmens, dessen Mitarbeiter und Strategie auf die reine Funktion des .„Überlebens“ ausgerichtet ist, durch den Ressourcengeber – also durch den Kunden.

Für all jene von uns, die ein Unternehmen führen oder beraten oder Nachwuchsführungskräfte ausbilden, ist das ein äußerst beunruhigender Gedanke. Wir sind da, um Unternehmen zu führen, Dinge zu verändern, Strategien zu formulieren und umzusetzen, das Wachstum zu beschleunigen und Gewinne zu machen. Die Theorie der Ressourcenabhängigkeit stellt unsere Daseinsberechtigung als Führungskraft, Berater oder Mentor in Frage.

Die Ergebnisse unseres Forschungsprojektes liefern aber bestechende Beweise für die Richtigkeit dieser Theorie. Kunden haben einen beachtlichen Einfluss darauf, wie Entscheidungen getroffen werden und in welche Projekte Investitionen fließen. Sie sind demnach mächtiger als die Führungskräfte.

Wenn die Kunden aber die Ressourcenströme eines Unternehmens bestimmen, wie können und sollen Führungskräfte mit disruptiven Innovationen, die von den Kunden abgelehnt werden, umgehen? Eine Möglichkeit liegt in harter Überzeugungsarbeit. Es sollen alle im Unternehmen darauf eingeschworen werden, trotzdem in diese Richtung zu gehen. Die strategische Bedeutung für das Unternehmen muss hervorgehoben werden. Und das, obwohl zum einen zahlungskräftige Kunden diese Produkte ablehnen und zum anderen diese disruptiven Innovationen niedrigere Gewinnaussichten versprechen als alternative Produkte in den Premium-Märkten. Die zweite Option besteht in der Schaffung einer unabhängigen Organisationseinheit. Diese soll auf die Kunden ausgerichtet sein, die die disruptive Technologie tatsächlich auch brauchen. Welcher Weg wird wohl erfolgversprechender sein?

Manager, die sich für die erste Option entscheiden, kämpfen gegen mächtige Kräfte im Unternehmen. Sie kämpfen gegen die Theorie, dass es die Kunden sind, die die Entscheidungen und Investitionen eines Unternehmens steuern. Führungskräfte, die sich für die zweite Option entscheiden, nutzen diese Kräfte, anstatt sie zu bekämpfen. Die Fälle in diesem Kapitel zeigen, dass diese zweite Alternative wesentlich höhere Erfolgswahrscheinlichkeiten hat als die erste.

Innovation und Ressourcenallokation

Kunden steuern den Ressourcenallokationsprozess – also jenen Prozess, der bestimmt, welche Initiativen Mitarbeiterressourcen und Geld zugeteilt bekommen. Ressourcenallokation und Innovation sind zwei Seiten einer Medaille: Nur jene Produktentwicklungsprojekte, die eine ausreichende Finanzierung erhalten, verfügen in weiterer Folge über ausreichend Aufmerksamkeit, Managementkapazität und Personal und haben somit eine Chance auf Erfolg. Projekte, die zu wenige Ressourcen erhalten, verhungern. Innovationsmuster spiegeln die Muster der Ressourcenallokation wider.

Gute Ressourcenallokationsprozesse zeichnen sich dadurch aus, dass sie Produktideen aussondern, die von den Kunden nicht angenommen werden. Funktionieren diese Prozesse, bekommt ein Produkt, das von den Kunden nicht gewollt wird, keine Ressourcen. In gut geführten Unternehmen ist das ein Muss. Gut geführte Unternehmen müssen in Projekte und Ideen investieren, die die Kunden wirklich wollen. Je besser das gelingt, umso erfolgreicher ist das Unternehmen.

Wie wir in Kapitel vier gesehen haben, ist diese Ressourcenallokation keine Frage einer Top-Down-Entscheidung, der die Umsetzung folgt. Zumeist werden den obersten Führungskräften Projekte erst dann zur Entscheidung vorgelegt, nachdem viele andere im Unternehmen bereits darüber entschieden haben. In den unteren Hierarchieebenen wird darüber befunden, welche Projekte den Vorgesetzten vorgelegt werden sollen und welche es nicht der Mühe wert sind. Das Top-Management sieht nur sorgfältig ausgewählte Projekte und somit nur einen Bruchteil aller Innovationsideen im Unternehmen167.

Selbst wenn das Top-Management sich für die Durchführung eines der vorgelegten Projekte entschieden hat, ist das noch lange keine .„geritzte Sache“. Viele wichtige Ressourcenentscheidungen werden erst nach der Projektfreigabe getroffen – in der Realität oft erst nach der Produkteinführung. Wenn mehrere Projekte gleichzeitig umzusetzen sind, setzt das mittlere Management Prioritäten. Es trifft gezielte Entscheidungen, sobald mehrere Produkte um Zeit, Mitarbeiterressourcen, Anlagen und Vertriebskapazitäten konkurrieren.

Wie treffen nun aber die .„Nicht-Mitglieder der Unternehmensleitung“ ihre Entscheidungen über die Ressourcenallokation?

Sie entscheiden auf der Grundlage ihres Verständnisses darüber, wer die wichtigsten und profitabelsten Kunden sind. Sie entscheiden über die Wichtigkeit der Projekte, welche dem Management vorgelegt werden und steuern somit deren Priorisierung. Eng damit verbunden ist das Bewusstsein darüber, wie solche Entscheidungen die eigene Karriere beeinflussen. Diese Wahrnehmung ist wiederum beeinflusst vom Verständnis und von[132]der Einschätzung dieser Mitarbeiter darüber, was die Kunden wirklich wollen und welche Produkte das Unternehmen braucht, um die Umsätze zu steigern und um mehr Gewinne zu machen. Wenn Mitarbeiter profitable Innovationsprogramme unterstützen, ist das der eigenen Karriere zumeist förderlich. Durch das Streben nach Gewinnen und persönlichen Erfolgen gibt dieser Mechanismus letztendlich den Kunden der meisten Unternehmen die Macht, Ressourcenverteilungen und damit Innovationsmuster zu steuern.

Erfolg in der disruptiven Computerlaufwerkstechnologie

Es gibt eine Möglichkeit, aus dieser .„Fremdkontrolle“ auszubrechen. Drei Fälle in der Geschichte der Computerlaufwerke zeigen, wie Führungskräfte bei disruptiven Innovationen eine starke Marktposition aufbauen konnten. In zwei Fällen gelang es den Managern, die Kräfte der Ressourcenabhängigkeit für sich zu nutzen: Durch Ausgründung .(Spin-off) einer unabhängigen Unternehmenseinheit, die die Aufgabe hatte, die disruptive Technologie zu vermarkten. Im dritten Fall entschieden sich die Führungskräfte dafür, gegen diese Kräfte anzukämpfen. Sie überlebten das Projekt – waren aber vollkommen ausgeblutet.

Quantum und Plus Development

Die Quantum Corporation war in den frühen 1980er Jahren ein führender Hersteller von 8-Zoll-Laufwerken für Minicomputer. Das Unternehmen verschlief vollends den Trend zu den 5¼-Zoll-Laufwerken. Es führte seine ersten Modelle fast vier Jahre nach dem ersten Erscheinen dieser Laufwerke ein. Als die Pioniere der 5¼-Zoll-Laufwerke von unten in den Minicomputer-Markt eindrangen, gingen die Verkäufe von Quantum unaufhaltsam zurück.

Im Jahre 1984 sahen einige Quantum-Mitarbeiter einen potenziellen Markt für ein dünnes 3,5-Zoll-Laufwerk. Dieses sollte den PCs der IBM XT- und AT-Klasse in eine für Erweiterungen vorgesehene Einbaustelle eingebaut werden. Diese Laufwerke sollten nicht an die OEM-Hersteller, sondern an die Benutzer der PCs verkauft werden. Sie entschlossen sich, Quantum zu verlassen und ein eigenes Unternehmen zu gründen, um diese Idee zu Geld zu machen.

Quantum ließ diese Mitarbeiter nicht einfach ziehen. Die Unternehmensleitung von Quantum entschied sich dafür, das Projekt zu finanzieren und hielt 80 Prozent der Plus Development Corporation – dem daraus entstandenen Spin-Off. Es war ein unabhängiges Unternehmen, mit eigener Führungsmannschaft und mit allen Funktionen und Prozessen, die ein unab[133]hängiges Unternehmen brauchte. Plus war äußerst erfolgreich. Es entwickelte und vermarktete seine Laufwerke. Gefertigt wurden sie von Matsushita Kotobuki Electronics (MKE) in Japan.

Als die Umsätze der 8-Zoll-Produktlinie von Quantum in den 1980er Jahren gegen Null gingen, wurden diese Rückgänge durch die steigenden Umsätze der .„Hardcard“ von Plus wettgemacht. Quantum kaufte sodann die restlichen 20 Prozent von Plus und holte deren Führungsmannschaft in die wichtigsten Führungspositionen von Quantum. Das 3,5-Zoll-Laufwerk wurde dann soweit angepasst, dass es für OEM-Hersteller von Desktop-PCs, wie zum Beispiel Apple, attraktiv war. Dies geschah genau zu dem Zeitpunkt, als 3,5-Zoll-Laufwerke den Markt für Desktops überfluteten .(siehe den Entwicklungspfad in Abbildung 1.7). Quantum rehabilitierte sich als Hersteller von 3,5-Zoll-Laufwerken, trieb aggressiv weitere evolutionäre Technologieinnovationen voran, eroberte nächsthöhere Marktsegmente wie Engineering Workstations und bewältigte erfolgreich die evolutionäre Technologieinnovation der 2,5-Zoll-Laufwerke. 1994 war Quantum weltweit der mengenmäßig größte Produzent von Computerlaufwerken168.

Control Data in Oklahoma

Der Control Data Corporation .(CDC) gelang das gleiche Comeback – zumindest einmal. CDC war führender Produzent von 14-Zoll-Laufwerken, die zwischen 1965 und 1982 an OEM-Produzenten verkauft wurden. Sein Marktanteil schwankte zwischen 55 und 62 Prozent. Als aber das 8-Zoll-Laufwerk in den späten 1970er Jahren auf den Markt kam, lag das Unternehmen im Tiefschlaf – drei Jahre lang. CDC konnte nie mehr als einen winzigen Bruchteil des 8-Zoll-Laufwerk-Marktes erreichen. Die wenigen Produkte, die es verkaufte, dienten lediglich der Verteidigung seines Marktes bei den Mainframe-Computern. Der Grund lag in der Prioritätenbildung bei der Ressourcenvergabe und den Managementkapazitäten: Techniker und Marketingmanager vom Hauptsitz in Minneapolis wurden immer wieder vom 8-Zoll-Projekt abgezogen, um Probleme in der Markteinführung der nächsten Generation des 14-Zoll-Laufwerks für die Hauptkunden von CDC zu lösen.

CDC führte sein erstes 5¼-Zoll-Laufwerk zwei Jahre nach Seagate ein, das im Jahre 1980 das erste 5¼-Zoll-Laufwerk auf den Markt brachte. Dieses Mal wurde aber eine Unternehmenseinheit in Oklahoma City mit dem Projekt betraut. Laut einem Manager .„nicht, um vor der Entwicklungskultur von CDC in Minneapolis zu flüchten, sondern um das .(5¼-Zoll-Produkt-) Team von CDCs Hauptkunden zu isolieren.“ Auch wenn CDC spät dran war und die ehemalige, führende Marktposition nie wieder erreichen konnte, war das Projekt profitabel. Zeitweise behauptete das Unternehmen einen Marktanteil von 20 Prozent bei den 5¼-Zoll-Laufwerken mit höherer Kapazität.

Micropolis: Übergang durch einen Kraftakt des Managements

Micropolis Corporation wurde als Hersteller von 8-Zoll-Laufwerken im Jahre 1978 gegründet und war das einzige weitere führende Unternehmen der Branche, das den Übergang zu einer neuen disruptiven Technologie schaffte. Allerdings wählte es nicht die Ausgründung als Strategie, so wie es für Quantum und Control Data funktionierte, sondern bewältigte den Wandel von innen heraus. Aber sogar diese Ausnahme bestätigt die Regel, dass Kunden einen enormen Einfluss auf die Ressourcenströme im Unternehmen haben.

Micropolis begann sich im Jahre 1982 zu verändern. Gründer und CEO Stuart Mabon verstand intuitiv die unterschiedlichen Entwicklungspfade der Marktnachfrage und der Technologie (wie sie in Abbildung 1.7 dargestellt sind). Er beschloss, Micropolis zu einem führenden Hersteller von 5¼-Zoll-Laufwerken zu machen. In der Hoffnung, ausreichend Ressourcen für die Entwicklung der nächsten Generation von 8-Zoll-Laufwerken aufbringen zu können, so dass Micropolis in beiden Märkten bestehen konnte169, wies er die besten seiner Entwickler dem 5¼-Zoll-Projekt zu. Mabon erinnerte sich, .„dass es 100 Prozent meiner Zeit und meiner Energie in Anspruch nahm“, um ausreichend Ressourcen für das 5¼-Zoll-Projekt zur Verfügung zu stellen. Unternehmensinterne Mechanismen steuerten die Ressourcen immer wieder dem 8-Zoll-Laufwerk zu – also dahin, wo die profitablen Kunden waren.

Bis 1984 schaffte es Micropolis nicht, mit den Konkurrenten im Minicomputer-Markt Schritt zu halten. Es zog seine restlichen 8-Zoll-Laufwerke aus dem Markt zurück. Mit einer Herkulesanstrengung gelang jedoch der Erfolg mit dem 5¼-Zoll-Programm. Abbildung 5.1 zeigt, warum dieser Kampf so schwierig war: Während des Übergangs nahm Micropolis seine Position auf einem anderen Entwicklungspfad ein. Das Unternehmen musste all seine bestehenden Kunden aufgeben und die verlorenen Umsätze mit dem Verkauf neuer Produkte an gänzlich andere Hersteller von Desktop-PCs ausgleichen. Mabon behielt diese Erfahrung als das anstrengendste Unterfangen seines Lebens in Erinnerung.

Schließlich führte Micropolis im Jahre 1993 ein 3,5-Zoll-Laufwerk ein. Zu diesem Zeitpunkt hatte die 3,5-Zoll-Architektur eine Speicherkapazität von 1 Gigabyte erreicht. Mit dieser Kapazität konnte Micropolis nun das Laufwerk an seine bestehenden Kunden verkaufen.

Abbildung 5.1:Technologischer Wandel und Marktposition von Micropolis Corporation170

Disruptive Technologien und die Theorie der Ressourcenabhängigkeit

Die Schwierigkeiten von Seagate Technology in der Vermarktung des 3,5-Zoll-Laufwerks und der gescheiterte Versuch von Bucyrus Erie, den Hydrohoe an seine Hauptkunden zu verkaufen, zeigen, wie die Theorie der Ressourcenabhängigkeit auf disruptive Innovationen anzuwenden ist. Sowohl Seagate als auch Bucyrus waren Pioniere in der Entwicklung der disruptiven Technologie. Die Unternehmensleitung fasste den Entschluss zur Markteinführung. Trotzdem flossen die dafür nötigen Anstrengungen auf allen Ebenen des Unternehmens solange nicht zusammen, bis die Kunden diese Produkte auch tatsächlich wollten.

Müssen wir nun einfach hinnehmen, dass Manager im Grunde machtlose Individuen sind, so wie es die Theorie der Ressourcenabhängigkeit besagt? Wohl kaum. Im Einführungskapitel dieses Buches verwendeten wir das Bild des Menschen, der seine ersten Flugversuche machte. Solange er versuchte, gegen die Naturgesetze anzukämpfen, scheiterte er kläglich. Aber[136]sobald er die Schwerkraft, das Gesetz von Bernoulli, das Zusammenwirken von Auftrieb, Vortrieb, Widerstand und Gewicht verstand, konnte er Fluggeräte entwickeln. Sie machten sich diese Kräfte zu Nutze – und zwar mit großem Erfolg. Das ist eine gute Analogie dafür, was Quantum und Control Data in Wirklichkeit taten. Dadurch, dass sie eine eigene Organisationseinheit für ein völlig anderes Wertesystem gründeten, hingen ihre Ressourcen und ihr Überleben nun von den .„richtigen“ Kunden ab. Die Manager nutzten die mächtigen Prinzipien der Theorie der Ressourcenabhängigkeit. Der CEO von Micropolis kämpfte gegen sie an. Aber so ein Sieg ist selten, in jedem Fall aber teuer erkämpft.

Disruptive Technologien zeigten in mehreren Branchen – in der Stahlindustrie, bei Computerlaufwerken und Baggern – ihre verheerenden Auswirkungen171. Die folgenden Seiten fassen die Folgen disruptiver Innovationen in drei anderen Branchen zusammen – Computer, Einzelhandel und Drucker. Damit wird noch einmal deutlich gemacht, dass jene Unternehmen, die die Prinzipien disruptiver Technologien für sich nutzen, statt sie zu bekämpfen, auch jene Unternehmen sind, die in der Lage sind, eine marktführende Position aufzubauen.

DEC, IBM und der Personal Computer

Die Computerbranche und die Branche der Computerlaufwerke haben naturgemäß ganz ähnliche Entwicklungsgeschichten. Das Wertesystem der letzteren ist in das Wertesystem der ersteren eingebettet. Würde man die Bezeichnungen der Achsen und der Geraden der Abbildung 1.7 mit Begriffen der Computerbranche einfach austauschen, würde sie ziemlich treffend den Untergang führender Computerhersteller darstellen. IBM, der erste Branchenführer, verkaufte seine Mainframe-Computer an zentrale Rechnungswesen- und Datenverarbeitungsabteilungen großer Organisationen. Der Minicomputer stellte für IBM und seine Konkurrenten eine disruptive Technologie dar. Die Kunden hatten keinen Gebrauch dafür. Er versprach niedrigere und nicht höhere Margen. Anfangs war der Markt wesentlich kleiner. Folglich ignorierten die Hersteller der Mainframe-Computer für viele Jahre den Minicomputer. Dadurch ermöglichten sie den Eintritt mehrerer neuer Konkurrenten. Diese eroberten schließlich den Markt und dominierten ihn: Digital Equipment, Data General, Prime, Wang und Nixdorf. Schließlich führte IBM doch noch eine Linie von Minicomputern ein. Das tat das Unternehmen aber im Wesentlichen nur, um seine Position zu verteidigen, als IBM feststellte, dass die Hersteller von Minicomputern ihre Geräte bereits so weit entwickelt hatten, dass sie auch für IBMs Hauptkunden attraktiv waren.

Ganz ähnlich war es bei den Minicomputern. Keiner der führenden Hersteller schaffte eine nennenswerte Marktposition bei den Desktop-PCs. Der[137]Desktop-PC war eine disruptive Technologie. Dieser Markt wurde durch neu eingetretene Unternehmen geschaffen. Darunter waren Apple, Commodore, Tandy und IBM. Hersteller von Minicomputern waren außergewöhnlich florierende Unternehmen, von Investoren, der Wirtschaftspresse und Managementforschern hoch geschätzt – bis in die späten 1980er Jahre. Zu dieser Zeit schnitt der Entwicklungspfad der Desktop-PCs die Gerade der Kundenerwartungen von Minicomputer-Käufern. Der raketenartige Angriff der Desktop-Hersteller setzte den Minicomputer-Produzenten schwer zu. Viele von ihnen kamen zu Fall. Keiner konnte sich nachhaltig am Markt behaupten.

Eine ähnliche Kette von Ereignissen zeichnete sich bei der Einführung der Laptops ab. Der Markt wurde von Neueinsteigern wie Toshiba, Sharp und Zenith geschaffen und später dominiert. Apple und IBM, die führenden Hersteller von PCs, ignorierten lange Zeit diesen Markt. So lange, bis der Entwicklungspfad der Laptops die Bedürfnisgerade der PC-Kunden schnitt.

Wahrscheinlich wurde keines dieser Unternehmen so hart getroffen wie Digital Equipment. Innerhalb weniger Jahre fiel DEC ins Bodenlose. Als einzelne Arbeitsplätze und vernetzte Desktop-Computer die Minicomputer überflüssig machten, war DECs Schicksal über Nacht besiegelt.

Natürlich stürzte DEC nicht aufgrund von mangelnden Versuchen. Zwischen 1983 und 1995 versuchte sich das Unternehmen vier Mal mit Desktop-PC-Linien. Diese Produkte waren technologisch viel einfacher als seine Minicomputer. Vier Mal scheiterte DEC in diesem Wertesystem, das man als durchaus profitabel ansah. Warum? DEC lancierte diese Produktlinien vom Mutterhaus aus172. Die Unternehmensleitung traf die Entscheidung, in das PC-Geschäft einzusteigen. Dennoch sahen Mitarbeiter und Führungskräfte, die im Tagesgeschäft entscheiden und handeln mussten, keinen Sinn darin, ihre Zeit, Geld und Energie in Low-Margin-Produkte zu investieren, die ihre Kunden gar nicht haben wollten. Die vielfältigen Gründe für solche Phänomene wurden bereits ausführlich diskutiert. Hochleistungsprojekte, die wesentlich höhere Margen versprachen, wie DECs superschneller Alpha Microprozessor und sein Ausflug in Mainframe-Computer, beanspruchten sämtliche Ressourcen und alle Aufmerksamkeit.

DEC versuchte in das Desktop-PC-Geschäft vom Mutterhaus aus einzutreten. Daher war das Unternehmen gezwungen, einen Spagat zwischen zwei Kostenstrukturen zweier Wertesysteme zu schaffen. Es gelang nicht, ausreichend Fixkosten abzubauen, um im Low-End PC Markt wettbewerbsfähig zu sein. Die Strukturen und die damit verbundenen Fixkosten waren nötig, um im Wettbewerb für die High-End-Produkte erfolgreich zu sein.

Die Erfolgsgeschichte von IBM in den ersten fünf Jahren der PC-Branche ist anders. Das Unternehmen schuf eine unabhängige Organisation in Florida – weit entfernt von der Zentrale in New York. Diese Organisation hatte sämtliche Freiheiten im Einkauf der einzelnen Komponenten, im Vertrieb[138]über die eigenen Kanäle, im Aufbau der nötigen Strukturen. Die Organisation konnte sich frei und unabhängig bewegen. Sie orientierte sich konsequent an den Erfordernissen und Erfolgsfaktoren des PC-Marktes. Vielfach wird die Meinung vertreten, dass erst IBMs spätere Entscheidung, die PC-Division stärker mit IBMs Hauptorganisation zu verbinden, verantwortlich für die großen Schwierigkeiten war, Marktanteile und die Profitabilität der PC-Sparte zu halten. Das reibungslose Zusammenleben zweier unterschiedlicher Kostenstrukturen und zweier unterschiedlicher Geschäftsmodelle scheint äußerst schwierig zu sein.

Die Schlussfolgerung, dass ein einzelnes Unternehmen es kaum schaffen kann, gleichzeitig eine disruptive Technologie einzuführen und das etablierte Geschäft im Hauptmarkt zu halten, gefällt vielen Managern nicht wirklich – vor allem nicht den sogenannten .„Macher-Typen“ unter ihnen. Die meisten Führungskräfte versuchen genau das, was Micropolis probierte: Die Wettbewerbsfähigkeit im Hauptgeschäft zu halten und gleichzeitig eine disruptive Technologie zu verfolgen. Es gibt bestechende Hinweise, dass solche Anstrengungen in den seltensten Fällen Früchte tragen. Ein Geschäftsbereich wird dabei immer zu kurz kommen. Mit einer Ausnahme: Wenn zwei unabhängige Organisationseinheiten geschaffen werden, die in ihrem jeweiligen Wertesystem die jeweiligen Kunden bedienen.

Kresge, Woolworth und die Diskonter im Einzelhandel

In kaum einer Branche waren die Auswirkungen disruptiver Technologien so dramatisch wie im Einzelhandel, wo Diskonter den traditionellen Kaufhäusern und Kleinpreisgeschäften173 .(Variety Stores) den Markt wegnahmen. Die .„Technologie“ des Diskonthandels war für die traditionellen Einzelhändler eine disruptive Innovation. Qualität und die Auswahl der Produkte bei den Diskontern warf all das, was man bis dahin als Qualitätsmaßstab gewohnt war, über den Haufen. Zudem war die Kostenstruktur eines Diskonthändlers mit der eines Kaufhauses nicht vergleichbar.

Der erste Diskonthändler – Korvette’s – öffnete Mitte der 1950er Jahre eine ganze Reihe von Geschäften in New York. Korvette’s und seine Nachahmer positionierten sich am absolut unteren Ende der Einzelhändler. Sie verkauften landesweit bekannte Marken zu Preisen, die zwischen 20 und 40 Prozent unter den Preisen der Kaufhäuser lagen. Sie konzentrierten sich auf Produkte, die .„sich selbst verkauften“, die die Kunden bereits kannten und zu verwenden wussten. Ein gut geschultes Verkaufspersonal war nicht mehr nötig. Die Diskonter konzentrierten sich auch auf eine Zielgruppe, die für die großen Kaufhäuser am wenigsten attraktiv war: .„Junge Frauen von Arbeitern mit kleinen Kindern.“174 Das stand in krassem Gegensatz zu den gehobenen, hochpreisigen Standards, mit denen Kaufhäuser die Qualität im Handel definierten und ihre Gewinne einfuhren.

Diskonter gaben sich nicht mit niedrigeren Gewinnen zufrieden. Vielmehr bedienten sie sich einer anderen ökonomischen Logik. Traditionelle Kaufhäuser hatten eine Handelsspanne von etwa 40 Prozent und schlugen ihr Lager vier Mal im Jahr um. Sie verdienten auf das Geld, das in das Lager investiert worden war, 40 Prozent – und das vier Mal im Jahr. So kamen sie auf eine Lagerrentabilität von 160 Prozent. Variety Stores .(Kleinpreisgeschäfte) kamen durch eine ähnliche Formel auf etwas niedrigere Gewinne. Diskonthändler kamen auf eine ähnliche Lagerrentabilität, hatten aber eine andere Ertragslogik: Niedrigere Handelsspannen bei höherem Lagerumschlag. Tabelle 5.1 fasst dies zusammen.

|

Unternehmenstyp |

Beispiel |

Typische Bruttomarge |

Typischer Lagerumschlag |

Return on Inventory Investment* |

|---|---|---|---|---|

|

Kaufhäuser |

R. H. Macy |

40% |

4X |

160% |

|

Variety Stores |

F. W. Woolworth |

36% |

4X |

144% |

|

Diskonter |

Kmart |

20% |

8 |

160% |

* Berechnet aus: Bruttomarge X Lagerumschlag

Tabelle 5.1:Verschiedene Wege zum Erfolg175

Auch in Deutschland zeichnete sich diese Entwicklung ab. In einem Spiegel-Artikel aus dem Jahre 1963 war zu lesen:

.„Landauf, landab eröffneten nun Diskonter ihre Selbstbedienungsscheunen, die durch simpelste Ausstattung und durch Billigstangebote auffielen. Auf absichtlich grob zurecht gehauenen Regalen stapelte sich wirr und verwirrend eine scheinbar unerschöpfliche Warenfülle, die zur demonstrativen Armut des sonstigen Interieurs krass kontrastierte.

Das Publikum strömte staunend zuhauf. Es genoss in den seltsamen Etablissements das prickelnde Gefühl, auch einmal von den Früchten des Beziehungshandels naschen zu dürfen, die vorher nur den Lieblingskindern des Wohlstands vorbehalten waren: den Beziehungs-Reichen.

… Danach verdiente der Diskonthändler mit einer durchschnittlichen Handelsspanne von 23 Prozent bei gleichem Umsatz mehr als der Fachhändler mit 35 Prozent Verdienstspanne, weil

|

• |

sein Sortiment nur 40 Artikel enthielt gegenüber 300 Artikeln im Fachgeschäft, |

|

• |

sein Lager nur einen Wert von 25000 Mark hatte gegenüber 70000 Mark beim Fachhändler, |

|

• |

sein Lager jährlich achtmal umgeschlagen wurde gegenüber dreimal beim Fachhändler und |

|

• |

der Diskonter bei gleichem Umsatz weniger Personal und eine erheblich kleinere Ladenfläche benötigte“176. |

Die Geschichte des Diskonthandels erzählt auch die Geschichte der Minimills. Genauso wie die Minimills nutzten die Diskonthändler ihre Kostenstruktur, um sich .„marktaufwärts“ zu entwickeln und um von den traditio[140]nellen Händlern in erstaunlichem Tempo Marktanteile an sich zu reißen: Zunächst am unteren Ende des Marktes mit Markenprodukten bei Haushalts- und Eisenwaren, kleinen Geräten und Koffern, später in gehobenen Marktsegmenten wie Möbeln und Bekleidung. Abbildung 5.2 zeigt, wie verblüffend diese Entwicklung war: Bei den Produkten, die sie anboten, stieg ihr Umsatzanteil von zehn Prozent im Jahre 1960 auf fast 40 Prozent nur sechs Jahre später.

Abbildung 5.2:Zunahme der Diskonter von 1960 bis 1966177

So wie bei den Computerlaufwerken und bei den Baggern erkannten ein paar wenige der führenden traditionellen Einzelhändler diese disruptive Entwicklung und investierten frühzeitig – vor allem S. S. Kresge, F. W. Woolworth und Dayton Hudson. Keine der anderen größeren Handelsketten machte einen ernsthaften Versuch, in das Diskont-Geschäft einzutreten. Weder Sears, Montogmery Ward, J.C. Penny, noch R. H. Macy. Kresge (mit seiner Kmart-Kette) und Dayton Hudson (mit Target) hatten Erfolg178. Beide schufen Diskonthandelsorganisationen, die vom angestammten Geschäft unabhängig waren. Woolworth scheiterte mit seinem Versuch .(Woolco), einen Diskonthändler aus dem Mutterhaus heraus aufzubauen. Ein detaillierter Vergleich der Ansätze von Kresge und Woolworth, die beide eine sehr ähnliche Ausgangsposition hatten, verdeutlicht einmal mehr, warum die Gründung einer unabhängigen Organisation eine unabdingbare Voraussetzung für den Erfolg mit einer disruptiven Technologie ist.

S. S. Kresge, zu diesem Zeitpunkt der zweitgrößte Variety Store der Welt, begann sich im Jahre 1957 mit dem Konzept des Diskonthandels auseinanderzusetzen. Zu dieser Zeit war der Diskonthandel noch in den Kinderschuhen. 1961 kündigen sowohl S. S. Kresge als auch sein Konkurrent F. W.[141]Woolworth .(der damals weltgrößte Variety Store) den Eintritt in das Diskonthandelsgeschäft an. Beide Unternehmen öffneten im Jahre 1962 Geschäfte, beide innerhalb von drei Monaten. Allerdings mit höchst unterschiedlichem Erfolg. Zehn Jahre später hatte Kmarts Umsatz 3,5 Millionen Dollar erreicht; Woolco dümpelte mit einem unprofitablen Umsatz von 0,9 Millionen Dollar vor sich hin179.

Kresge konzentrierte sich voll auf den Diskonthandel und zog sich aus dem Variety Store Geschäft zurück. Im Jahre 1959 wurde Harry Cunningham zum CEO bestellt. Sein einziger Auftrag war es, Kresge in einen mächtigen Diskonthändler zu verwandeln. Cunningham brachte ein komplett neues Managementteam mit. Im Jahre 1961 gab es .„nicht einen Vorstand, Gebietsleiter, Gebietsleiterassistenten oder regionalen Merchandise Manager, der nicht neu in seiner Position war“180. In diesem Jahr beschloss Cunningham, keine neuen Variety Stores mehr zu öffnen und startete ein Desinvestitionsprogramm: 10 Prozent aller Variety Stores von Kreske sollten von nun an pro Jahr geschlossen werden. Das bedeutete eine klare strategische Neuorientierung des Unternehmens in Richtung Diskonthandel.

Woolworth hingegen unterstützte zwei strategische Initiativen parallel. Man wollte das Kerngeschäft stärken hinsichtlich Technologie, Kapazitäten, Anlagen und Einrichtungen. Gleichzeitig wollte man in den disruptiven Diskonthandel investieren. Jene Führungskräfte, die mit der Weiterentwicklung und Ergebnisverbesserung von Woolworths Variety Geschäft beauftragt waren, sollten gleichzeitig .„die größte Kette von Diskontgeschäften in den USA“ aufbauen. CEO Robert Kirkwood meinte, dass Woolco .„nicht mit den Wachstums- und Expansionsplänen des Unternehmens im Variety Business Bereich in Konflikt stand“ und dass kein bestehendes Geschäft in einen Diskonthandel umgewandelt werden soll181. Als in den 1960er Jahren der Boom für Diskonthändler voll einsetzte, öffnete Woolworth neue Variety Stores in gleicher Geschwindigkeit wie in den 1950er Jahren.

Bedauerlicherweise .(aber vorhersehbar) hatte Woolworth die größten Schwierigkeiten. Es war unmöglich, ein Unternehmen zu führen, das zwei unterschiedlichen Kulturen, zwei unterschiedliche Geschäftsmodelle und zwei unterschiedliche Ertragslogiken hatte, die jeweils nötig waren, um sowohl im Variety Store Geschäft als auch beim Diskonthandel erfolgreich zu sein.

Bis 1967 hatte Woolco den Begriff .„Diskont“ von allen Werbeanzeigen genommen und verwendete stattdessen den Begriff .„Promotional Department Store“. Woolworth setzte ursprünglich einen eigenen Mitarbeiterstab für Woolco ein. Im Jahre 1971 war Folgendes zu beobachten:

Im Bemühen, den Umsatz pro Quadratmeter sowohl bei Woolco als auch bei Woolworth zu steigern, wurden beide Geschäftsbereiche auf regionaler Basis konsolidiert. Unternehmenssprecher meinten, dass die Konsolidierung – die die Akquisition von Büros, Distributionszentren und die Einstellung von Führungspersonal auf regionaler Ebene umfasste – beiden Geschäftsbereichen helfen würde, bessere Warenange[142]bote und mehr Effizienz zu erreichen. Woolco würde von Woolworths Beschaffungsressourcen profitieren, von seinem Distributionssystem und von seiner Expertise in der Einrichtung von Spezialabteilungen. Woolworth würde Woolcos Know-how in der Standortwahl, im Design, in der Bewerbung und im Betreiben von großen Geschäften von über 100000 Quadratfuß .(etwa 9000 Quadratmeter) übernehmen182.

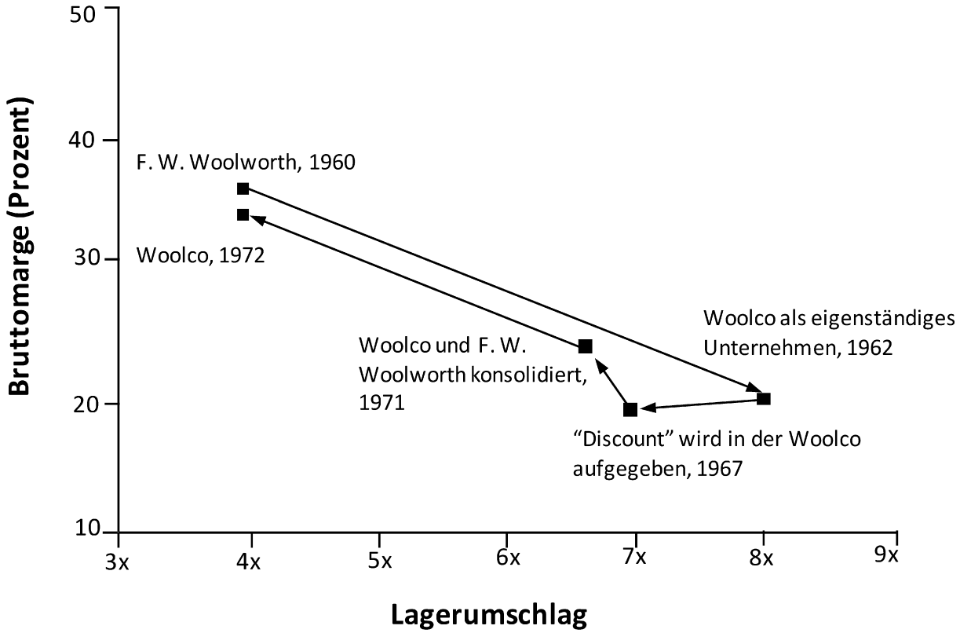

Was waren nun die Auswirkungen dieser Konsolidierungsmaßnahmen zur Kosteneinsparung? Sie lieferten einen weiteren Beweis dafür, dass zwei unterschiedliche Geschäftsmodelle nicht reibungslos nebeneinander existieren können. Innerhalb eines Jahres gelang es Woolco, seine Handelsspanne auf 33 Prozent zu steigern – die höchste unter den Diskonthändlern. Allerdings fiel der Lagerumschlag von Faktor 7 auf Faktor 4. Die Ertragsformel, die Woolworth jahrelang so erfolgreich gemacht hatte .(35 Prozent Handelsspanne und ein Lagerumschlag von vier, was eine Lagerrendite von 140 Prozent ergab), wurde nun auch auf Woolco übertragen und zudem von Woolco gefordert .(siehe Abbildung 5.3). Woolco war kein Diskonthändler mehr – weder dem Namen nach, noch nach dem Geschäftsmodell. Wie zu erwarten war, scheiterte Woolworths Ausflug in das Diskontgeschäft: Das letzte Woolco-Geschäft wurde im Jahre 1982 geschlossen.

Abbildung 5.3:Der Einfluss der Integration von Woolco und F.W. Woolworth auf die Ertragslogik183

Woolworth und Digital Equipment verfolgten die gleiche Strategie. Beide gründeten neue Organisationseinheiten innerhalb des Mutterhauses, die nach den gleichen Regeln und den gleichen Kriterien ihr Geld verdienen mussten wie etablierte Unternehmensbereiche. In beiden Fällen konnten diese Organisationseinheiten weder die Kostenstruktur noch die Ertragslogik aufbauen, die für ein erfolgreiches Bestehen im Wertesystem nötig gewesen wären.

Überleben durch Selbstmord: Die Laser- und Tintenstrahldrucker von Hewlett-Packard

Die Erfahrung von Hewlett-Packard zeigt, wie eine Ausgründung mit dem Ziel der Entwicklung und Vermarktung einer disruptiven Technologie von PC-Druckern letztendlich auch den Todesstoß für einen anderen Geschäftsbereich bedeuten kann.

Hält man sich vor Augen, wie Hewlett-Packard beim Aufkommen der Tintenstrahldrucker reagierte, ist die Erfolgsgeschichte der PC-Drucker von HP umso bemerkenswerter. Anfang der 1980er Jahre baute HP sein riesiges und erfolgreiches Geschäft rund um die Technologie des Tintenstrahldrucks auf. Der Laser-Drucker war eine bedeutende Verbesserung im Vergleich zum Matrix-Drucker, der bis dahin dominierte. HP konnte damit eine führende Marktposition erreichen.

Als die Tintenstrahltechnologie als eine Alternative auftauchte, gab es hitzige Debatten darüber, ob nun Laser oder Tintenstrahl zum dominierenden Standard werden würde. Zahlreiche Experten taten sich hervor und berieten HP. Es gab für beide Technologien zahlreiche Argumente dafür, dass sie die erste Wahl für Desktop PCs werden würden184.

Auch wenn sie zu diesem Zeitpunkt nicht als solche gesehen wurde, war die Tintenstrahltechnologie eine disruptive Innovation. Sie war langsamer als der Laserdruck, die Auflösung war schlechter, die Kosten pro gedruckter Seite waren höher. Aber der Drucker selbst war kleiner und wesentlich günstiger als der Laserdrucker. Zu diesen niedrigen Preisen ließ er natürlich auch niedrigere Margen erwarten als der Laserdrucker. Im Vergleich zum Laserdrucker war der Tintenstrahldrucker daher eine klassische disruptive Innovation.

Anstatt diese zwei Technologien innerhalb des gleichen Hauses gegeneinander antreten zu lassen und anstatt zu versuchen, beide Technologien über die gleiche Geschäftseinheit für Drucker in Boise, Idaho zu vermarkten, entschloss sich HP dazu, eine völlig unabhängige Organisationseinheit in Vancouver, Washington aufzubauen. Diese Organisationseinheit hatte den Auftrag, den Tintenstrahldrucker zum Erfolg zu führen. Erst dann ließ man die zwei Technologien miteinander konkurrieren. Beide verhielten sich auf klassische Weise. Wie in Abbildung 5.4 dargestellt, entwickelte sich die Laserdrucktechnologie steil nach oben – genauso wie die 14-Zoll-Laufwerke, Mainframe-Computer und die integrierten Stahlhersteller. Die Laserdrucker von HP druckten in hoher Geschwindigkeit mit außergewöhnlicher Auflösung. Sie konnten hunderte von Schriftarten und die kompliziertesten Graphiken drucken. Zudem konnten sie auf beiden Seiten des Papiers drucken und mehrere User in einem Netzwerk gleichzeitig bedienen. Auch ihre Größe nahm stetig zu.

Abbildung 5.4:Verbesserung der Geschwindigkeit von Tintenstrahl- und Laserdruckern185

Der Tintenstrahldrucker konnte diese Qualität nicht erreichen. Aber die kritische Frage war, ob der Tintenstrahldrucker jemals so gut sein würde, wie es im Markt für Desktop-PCs erforderlich war. Die Auflösung der Tintenstrahldrucker war offensichtlich gut genug für viele Studenten, professionelle Anwender und für viele nicht-vernetzte Anwender von Desktop-PCs.

Die Tintenstrahldrucker begannen bald den Laserjetdruckern das Wasser zu reichen. Viele Verwender von Laserdruckern stiegen auf Tintenstrahldrucker um. Es war vorhersehbar, dass Kunden, die die höchste Druckerqualität verlangten – da, wo HPs Laserdruck hinwollte – stetig weniger wurden. Es bestand die Gefahr, dass eine Geschäftseinheit die andere ruinierte. Hätte HP aber die Tintenstrahltechnologie nicht einer unabhängigen Geschäftseinheit übertragen, wäre sie wahrscheinlich zwischen den Laserdruckern untergegangen. Man hätte Canon, einem der größten Konkurrenten, den Markt überlassen. Durch diese Strategie gelang es HP gleichzeitig im Laser-Geschäft zu bleiben. Genauso wie es IBM gelang im Mainframe-Geschäft zu bleiben und sich die integrierten Stahlhersteller in die oberste Marktnische zurückzogen – und damit viel Geld zu verdienen186.

Das bestehende System als Barriere für disruptive Innovationen – der Fall Siemens

Versetzen wir uns für einen Moment zurück an den Anfang der 90er Jahre des letzten Jahrhunderts: Siemens ist im deutschen Markt und weit darüber hinaus die unumstrittene Nr.1 im Bereich Öffentliche Vermittlungstechnik und obendrein mit diesem Geschäft hochprofitabel. Die Stimmung ist gut, nicht zuletzt aufgrund der Überzeugung des Top-Managements mit der ISDN-Schmalband-Technologie erst am Anfang eines Zyklus zu stehen, der viel Gutes für Siemens und seine Kunden erwarten lässt. Ein paar Wenige sehen die Welt indes anders: Unter ihnen Cisco. Soeben als Start-up in den USA gegründet, ist für Cisco die Zukunft untrennbar mit der Breitband-Technologie verknüpft.

Machen wir einen Sprung ins Jahr 2000. Cisco agiert mittlerweile weltweit und avanciert mit einer Börsenkapitalisierung von weit über 500Mrd. Dollar kurzfristig zum wertvollsten Unternehmen der Welt. Anders die Situation bei Siemens. Obgleich es verschiedene Rufer gab, hielt man nach wie vor an der Schmalband-Technologie fest. Zu überlegen wähnte man diese Technologie, zu sicher die eigene Technologieführerschaft und – last but not least – zu profitabel war das Geschäft, das über viele Jahrzehnte mit den staatlichen Telekommunikationsunternehmen der ganzen Welt betrieben wurde. Im Jahr 2006 bereitete Klaus Kleinfeld dem .„Schrecken ohne Ende“ durch das Einbringen der Telekomsparte in ein Joint Venture mit Nokia schließlich .„ein Ende mit Schrecken“. Das Ganze war nicht nur ein finanzielles Desaster. Siemens hatte auch eine seiner Wurzeln verloren, die zurück bis zur Unternehmensgründung im Jahre 1848 reichten187.

Was genau war geschehen? Auf viele der zuvor geschilderten Gesetzmäßigkeiten des Scheiterns treffen wir auch hier: Der bereits erwähnte große Erfolg mit einer bewährten Technologie. Die Konditionierung des Top-Managements auf eben diese Technologie. Die offensichtlich noch recht .„holprigen“ disruptiven Lösungen, die in Sachen Übertragungssicherheit und Datenqualität der etablierten Technologie so gar nicht das Wasser reichen konnten. Es gab sie auch hier, die frühen Rufe. Sie waren zunächst schwach, aber dann doch stark genug, um eine Initiative in Richtung Breitband-Technologie zu starten. Aber halbherzig. Gerade einmal 50 Entwickler .(aus einer Population von mehreren Tausend in der Kommunikationssparte) wurden abgestellt, um sich der Breitband-Technologie zuzuwenden. Und sie standen gehörig unter Druck. Wirtschaftlich, um alsbald Ergebnisse vorzuweisen. Technologisch, um schnell marktfähige Leistungen zu präsentieren. Vor allem aber emotional. Tagein, tagaus waren sie den Ratschlägen der Kollegen ausgesetzt, die immer wieder aufs Neue ihre Argumente vorbrachten, warum es mit der Breitband-Technologie niemals funktionieren würde. Solange, bis man schließlich den ursprünglichen .„Drive“ verloren hatte. Der Mut, ein wirkliches Team, gar eine eigene Einheit zu formen, um mit einem[146]entsprechenden Budget die neue Technologie konsequent zu verfolgen, war nicht vorhanden. Erst glaubte man nicht an die Technologie und später wollte man – vor dem Hintergrund der bisherigen Erfolge mit dem Schmalband – nicht daran glauben. Angesichts der systemischen Zwänge musste es so kommen, wie es kam. Randbemerkung: Neben Siemens schafften auch die anderen, in der Schmalband-Technologie führenden Unternehmen .(etwa Alcatel, Lucent, Nortel oder NEC) nicht rechtzeitig den Sprung in die Breitband-Technologie. Einmal mehr waren Newcomer die Gewinner.

Zurück zu Siemens: Systemische Zwänge führten dazu, dass man zeitweise den Anschluss an die Spitze verlor, dass man Trends verschlief oder – wie im Fall der Telekommunikation – ganze Sparten aufgeben musste. Aber daraus hat man gelernt und wirksame Mechanismen geschaffen, die das verhindern sollen. Im Mittelpunkt stehen folgende Überzeugungen: Führungskräfte stellen ein technologisches Weltbild, auf dem ihr Erfolg und teilweise auch ihr persönlicher Werdegang fußt, nicht so ohne Weiteres in Frage. Zumindest dort, wo das Neue die bestehenden Technologien, die heutigen Kunden und angestammten Märkte kannibalisiert, darf es nicht im Rahmen der bestehenden Operationen verfolgt werden. Es bedarf separater Einheiten mit einer eigenen Steuerungslogik – manche sprechen auch von Welpenschutz.

Die .„Lösungen“ der Vergangenheit hatten sich als untauglich erwiesen: Zentrale Budgets für Forschungsvorhaben .(sogenannte Unternehmensprojekte fernab von Märkten und Kunden), die bei den Beteiligten zu einer .„alles-bezahlt-Haltung“ führen, brachten so gut wie nie brauchbare Resultate. Untauglich erweist sich auch die reine Zuständigkeit der im traditionellen Geschäft erfolgreichen Bereiche. Letzteres führte im schlimmsten Fall dazu, dass hochprofitable Bereiche sich außer Stande sahen, im Grunde lächerliche Beträge für Zukunftstechnologien bereit zu stellen – und so die Zukunft ganzer Märkte für einen Silberling verkauften. So geschehen im Unternehmensbereich .„Übertragungstechnik“ in Bezug auf die optische Nachrichtentechnologie. Und dort, wo man am Ende aufgrund von Zurufen eine disruptive Technologie verfolgte, geschah dies .(a) halbherzig, ohne das wirkliche Commitment der Bereichsführung, .(b) ohne die besten Ressourcen und .(c) ohne wirklichen Auftrag, Lösungen zu entwickeln, um das Bestehende zu kannibalisieren sowie .(d) unter enormem emotionalen Druck der Betroffenen unter den bohrenden Fragen .„Forscht ihr noch oder habt ihr etwa schon eine Lösung gefunden?“.

Wie sehr sich zwischenzeitlich die Haltung zu und der Umgang mit der disruptiven Innovation gewandelt hat, lässt sich am Siemens-Bereich .„Industrie“ ablesen. Heute herrscht hier das technologische Weltbild .„proprietäre Plattformen“ vor. Hier ist Siemens führend. Was aber, wenn offene Systeme die Welt revolutionieren? Ohne zu wissen, welche Fraktion am Ende gewinnt, will man für beides gewappnet sein. Dafür wurde weit ab von den bestehenden Operationen eine eigene Einheit geschaffen, mit Budget ausge[147]stattet und der klare Auftrag erteilt, das Bestehende nach Kräften zu kannibalisieren.

Ein systemisch struktureller, kultureller und methodischer Mix soll auf Basis von Lektionen der Vergangenheit und den guten Erfahrungen, die man mit der konsequenten Trennung von Alt und Neu sammeln konnte, sicherstellen, dass Disruptionen nicht systematisch scheitern. Es werden:

|

• |

der Nutzen von Disruption heute greifbar gemacht, |

|

• |

überall dort, wo das Neue erfolgreiche Produkte und bewährte Technologien und angestammte Märkte kannibalisiert, eine Trennung herbei geführt, |

|

• |

Instanzen geschaffen bzw. deren Rolle geschärft, über die direkte Marktanbindung und über die Grenzen einzelner Technologien hinaus, Wechselwirkungen zwischen Technologien zu erfassen und querzudenken, |

|

• |

Methoden entwickelt – namentlich das .„Strategic Visioning“ oder die .„Pictures of the Future“, um ein gemeinsames Verständnis von Trends und Treibern zu erzeugen und Zukunftsbilder zu entwickeln188, |

|

• |

Spielregeln – insbesondere Steuerungslogiken – definiert, um den Eigenarten der Disruption gerecht zu werden. |