Kapitel 4

Das .„Einrastprinzip“

Märkte gleichen Hierarchien. Am unteren Ende zählt der Preis und Margen sind niedrig. Das obere Ende des Marktes verspricht in der Regel höhere Margen. Dafür ist aber eine hohe Qualität erforderlich.

Aus der Geschichte der Computerlaufwerke und der Bagger wird eines deutlich: Die Grenzen dieser Wertesysteme kesseln Unternehmen nicht gänzlich ein. Es gibt eine beachtliche Aufwärtsmobilität. Klare Grenzen setzen sie aber in der Abwärtsmobilität. Dieses Phänomen gleicht einem Einrast-Prinzip: Einmal in einem Markt positioniert, wirkt dieser Mechanismus. Es ist ungleich schwieriger, oft sogar unmöglich, erfolgreich in untere Marktsegmente – in Low-End-Märkte – einzudringen, während eine Aufwärtsmigration in Premium-Segmente viel attraktiver und leichter erscheint. Einmal aber weiter oben in der Marktpyramide positioniert, bleibt der Weg zurück verschlossen.

In diesem Kapitel gehen wir folgenden Fragen nach: Warum können führende Unternehmen sich zwar problemlos in Richtung High-End-Märkte entwickeln, währenddessen es aber sehr schwierig zu sein scheint, sich nach unten – Richtung Low-End-Märkte – zu bewegen? Vernünftige Führungskräfte finden – wie wir später noch sehen werden – kaum ein stichhaltiges Argument für einen Eintritt in kleine, schlecht definierte Low-End-Märkte, die nur niedrigere Gewinnaussichten versprechen. High-End-Märkte hingegen locken mit Wachstums- und Gewinnchancen. Daher neigen gut geführte, ertrags- und wachstumsorientierte Unternehmen dazu, ihr Glück in oberen Marktsegmenten zu versuchen. Oft verlassen sie dabei ihren angestammten Bereich (oder verlieren dort an Wettbewerbsfähigkeit). Sie suchen Kunden in höheren Preisklassen. Daher konzentriert sich ihre Energie darauf, Produkte mit höherer Leistungsfähigkeit zu entwickeln, die den Zugang zu attraktiveren Märkten mit höheren Gewinnmöglichkeiten gewähren.

Die Aussichten in High-End-Segmenten sind tatsächlich meist verlockend. Der obere, rechte Punkt im Entwicklungspfad der Computerlaufwerke und jener der Bagger wirkt wie ein starker Magnet. In diesem Kapitel widmen wir uns der magischen Anziehungskraft, die dieser Punkt ausübt. Dabei betrachten wir noch einmal die Geschichte der Computerlaufwerke. Die Erkenntnisse werden dann abstrahiert und verallgemeinert, indem wir das gleiche Phänomen im Kampf zwischen den Minimills und den integrierten Stahlherstellern untersuchen.

Die Migration der Computerlaufwerke in High-End-Segmente

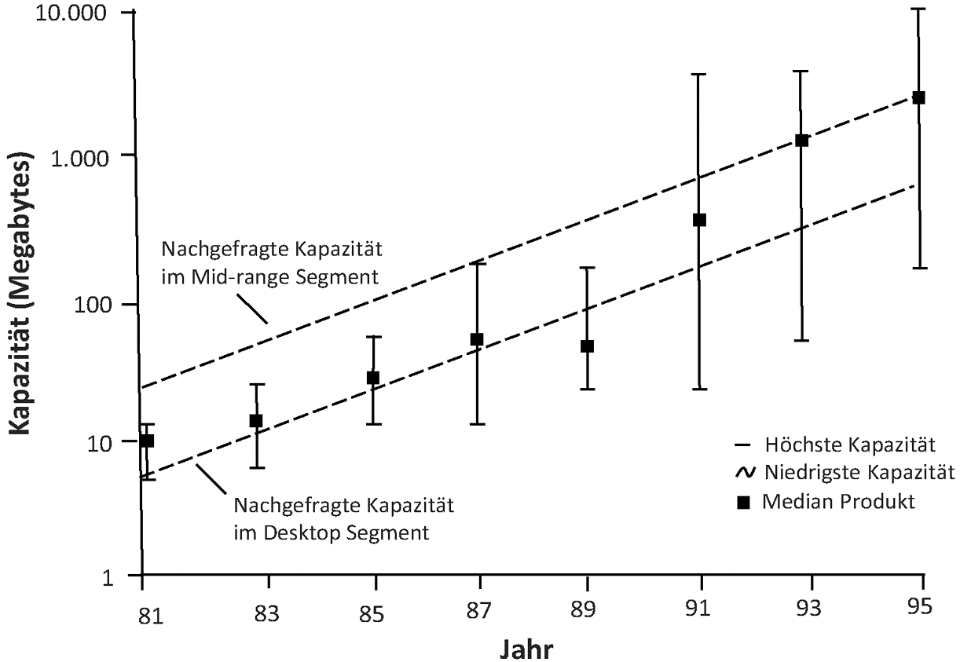

Abbildung 4.1 zeigt die Strategie von Seagate Technology: Die permanente Weiterentwicklung und die Eintritte in immer höher liegende Segmente. Diese Strategie ist typisch für die Branche. Erinnern Sie sich daran, dass es Seagate war, das das Wertesystem der Desktop-PCs hervorgebracht und dann auch dominiert hat. Die vertikalen Linien in der Abbildung stellen die Positionierungen der Produkte im Verhältnis zur am Markt verlangten Speicherkapazität dar. Für jedes dargestellte Jahr reichen diese von der niedrigsten bis zur höchsten angebotenen Kapazität. Der schwarze, rechteckige Punkt auf der Linie stellt den Median dar.

Abbildung 4.1:Die Aufwärtsmigration der Seagate Produkte137

Zwischen 1983 und 1985 waren die Produkte von Seagate genau in der Mitte der durchschnittlich nachgefragten Kapazität des Desktop-PC-Marktes positioniert. Zwischen 1987 und 1989 drang das 3,5-Zoll-Laufwerk von unten in diesen Markt ein. Seagate antwortete auf diesen Angriff nicht, indem es direkt gegen diese disruptive Technologie ankämpfte. Das Unternehmen zog sich in obere Marktsegmente zurück. Seagate bot weiterhin Laufwerke in der Kapazitätsklasse an, die für Desktop-PCs charakteristisch war. Allerdings verlagerte sich der Fokus des Unternehmens bis 1993 deutlich auf Midrange-Computer, z.B. auf Dateiserver oder Engineering Workstations.

Disruptive Technologien entfalten ihre verheerende Wirkung aus folgendem Grund: Unternehmen, die eine disruptive Technologie entwickeln und vermarkten, entschließen sich in der Regel nicht im ursprünglichen Wertesys[103]tem zu bleiben. Vielmehr versuchen sie, mit jeder neuen Produktgeneration weiter nach oben zu drängen – soweit es eben geht. Sie entwickeln ihre Technologie so lange weiter, bis diese für das nächsthöhere Wertesystem attraktiv genug ist. Dort sind die Margen höher und dort ist ein weiteres Wachstum möglich. Genau diese Aufwärtsmobilität ist es, die disruptive Technologien für etablierte Unternehmen so gefährlich macht – und so attraktiv für Neueinsteiger. Am unteren Ende entsteht ein Vakuum für einfachere, günstigere Produkte, ein Vakuum für neue, disruptive Technologien.

Wertesysteme und ihre typischen Kostenstrukturen

Was steckt hinter dieser asymmetrischen Mobilität? Wie wir bereits gesehen haben, wird sie durch Ressourcenentscheidungen beeinflusst: Unternehmen neigen dazu, ihre Ressourcen in Produkte und Projekte zu investieren, die höhere Margen und größere Märkte versprechen. In den allermeisten Fällen findet man diese am rechten, oberen Ende des Entwicklungspfades .(wie in Abbildung 1.7 und 3.3 abgebildet) und kaum in den unteren Märkten. Die Hersteller von Computerlaufwerken bewegten sich Schritt für Schritt zum High-End-Segment des Marktes. Ihre Ressourcenallokationsprozesse trieben sie dorthin.

Wie in Kapitel zwei verdeutlicht, hat jedes Wertesystem eine typische Kostenstruktur. Sie wird von jedem Unternehmen aufgebaut, das für den Kunden attraktive Produkte und Dienstleistungen anbieten will. Sobald die Hersteller von Computerlaufwerken in ihren angestammten Märkten groß und erfolgreich geworden waren, entwickelten sie eine spezielle Charakteristik: Sie gestalteten ihre Aktivitäten .(und damit auch ihre Kosten) in Forschung, Entwicklung, Vertrieb, Marketing und Verwaltung entsprechend den Wünschen der Kunden und den Erfordernissen des Wettbewerbs. Die Bruttogewinnspannen entwickelten sich in jedem Wertesystem so, dass die besseren Hersteller bei den gegebenen .(und für den Wettbewerb erforderlichen) Kostenstrukturen profitabel waren.

Daraus ergab sich eine einfache Logik zur Gewinnsteigerung. Die Kosten zu senken war schwierig, wenn man im gleichen Markt bzw. im gleichen Wertesystem bleiben wollte: Es fielen Kosten für Forschung, Entwicklung, Marketing und die allgemeinen Verwaltungskosten an und diese waren auch nötig, um im Kerngeschäft erfolgreich bleiben zu können. Vielversprechender hingegen war es, sich im Markt nach oben zu bewegen. Leistungsfähigere Produkte versprachen höhere Margen. Sich im Markt nach unten zu bewegen, kam nicht in Frage.

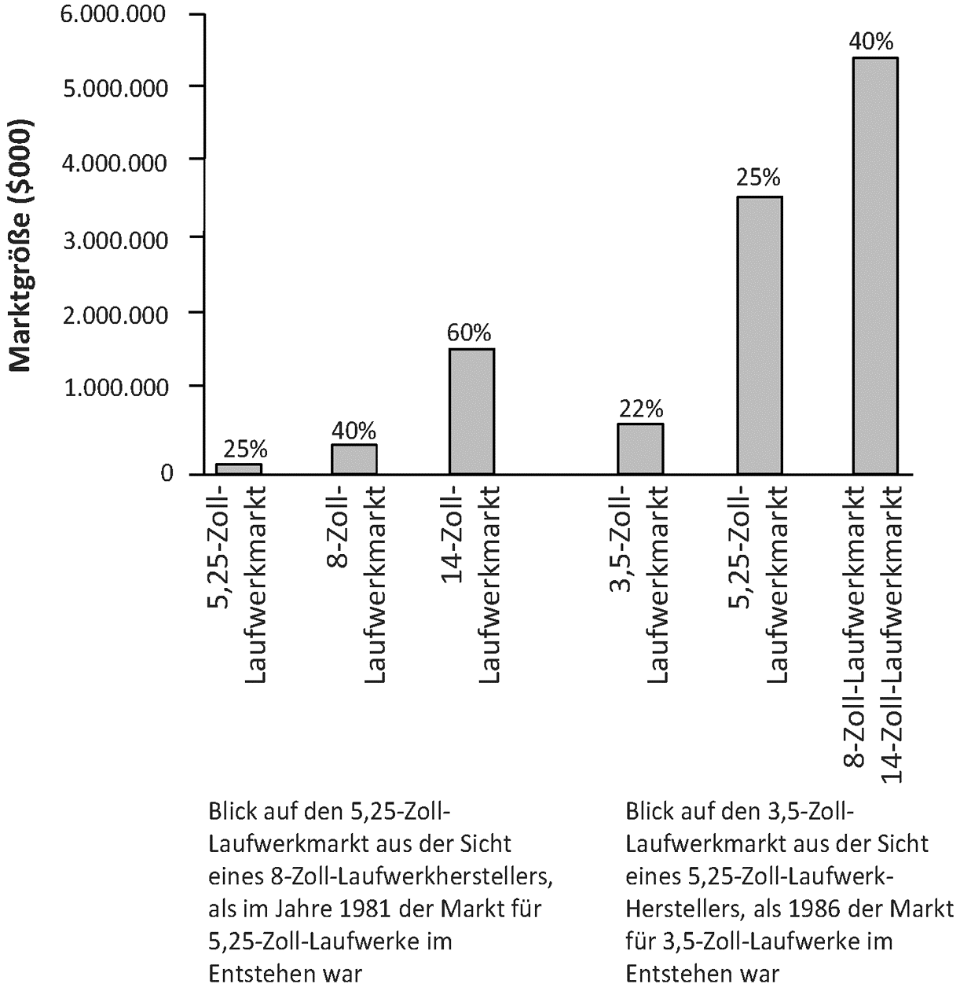

Wie offensichtlich diese Strategie zur Ertragssteigerung beiträgt, zeigt Abbildung 4.2. Die drei Säulen auf der linken Seite der Abbildung stellen die Größe des Desktop-, des Minicomputer- und des Mainframe-Computer-[104]Marktes im Jahre 1981 dar. Die Prozentzahl über den Säulen gibt die typische Bruttogewinnspanne im jeweiligen Wertesystem wider. Die Bruttogewinnspannen sind in den High-End-Märkten deutlich höher. Sie sind nötig, um die höheren Fixkosten der Unternehmen zu decken.

Abbildung 4.2:Der Blick auf den Markt aus der Sicht unterschiedlicher Hersteller .(Die Prozentwerte stellen unterschiedliche Bruttogewinnmargen in den jeweiligen Wertesystemen dar)138

Diese Unterschiede in der Marktgröße und den typischen Kostenstrukturen der Wertesysteme sind verantwortlich für die asymmetrischen Bewegungen der Unternehmen im Markt und ihre Strategien im Wettbewerb. Hersteller von 8-Zoll-Laufwerken für Minicomputer hatten beispielsweise Kostenstrukturen, die eine 40%ige Bruttogewinnspanne verlangten. Der Eintritt in das darunterliegende Wertesystem wäre einem Kampf gegen einen übermächtigen Gegner gleichgekommen. Dieser wies Kostenstrukturen auf, die lediglich eine 25%ige Bruttogewinnspanne erforderten. Der Eintritt in das nächsthöhere Wertesystem hatte andere Konsequenzen. Man begab sich in einen Markt mit einer relativ günstigen Kostenstruktur, der den dortigen[105]Unternehmen eine 60%ige Bruttogewinnspanne gewährte. Welche Entwicklungsrichtung macht nun aber Sinn? Die Antwort liegt auf der Hand.

Eine ähnliche Asymmetrie stellten die Hersteller von 5¼-Zoll-Laufwerken im Jahre 1986 fest, als es um die Entscheidung ging, die Ressourcen auf die Herstellung und Vermarktung von 3,5-Zoll-Laufwerken für Laptops zu konzentrieren oder in den Markt für Minicomputer oder Mainframe-Computer einzusteigen.

Es war vielversprechender, Zeit und Geld in die Entwicklung von leistungsfähigeren Produkten zu stecken. Sie ließen höhere Bruttogewinnspannen und eine höhere Rentabilität erwarten. In verschiedensten Entscheidungen hatten daher Projekte zur Entwicklung leistungsfähigerer Produkte für die oberen attraktiveren Märkte immer wieder Priorität. Mit anderen Worten waren es die Entscheidungsprozesse über den sinnvollen und rentablen Einsatz von Ressourcen, die in den Wertesystemen der Computerlaufwerke die Aufwärtsmobilität förderten und die Abwärtsmobilität verhinderten.

Die hedonische Regressionsanalyse in Kapitel zwei zeigte auch, dass das jeweils nächsthöhere Wertesystem signifikant höhere Preise für ein zusätzliches Megabyte an Speicherkapazität bezahlte. Warum sollte sich jemand dazu entscheiden, ein Megabyte zu einem geringeren Preis zu verkaufen, wenn er es auch zu einem höheren Preis verkaufen kann? Die Migration der Computerlaufwerksproduzenten in das rechte, obere Ende des Marktes war absolut rational.

Einige Autoren fanden in anderen Branchen Hinweise dafür, dass Unternehmen auf der Suche nach höherer Rentabilität in den oberen Märkten ihren Heimatmarkt verlassen. Schritt für Schritt entwickeln sie dann auch die Kostenstrukturen, die in diesen Märkten typisch und nötig sind139. Das verschärft noch einmal mehr die Schwierigkeit der Abwärtsmobilität.

Ressourcenallokation und Aufwärtsmigration

Weitere aufschlussreiche Einsichten in diese asymmetrische Mobilität zwischen den Wertesystemen geben zwei unterschiedliche Modelle über Ressourcenallokation von Unternehmen. Das erste Modell beschreibt Ressourcenallokation als einen rationalen Top-Down-Prozess. Die obersten Führungskräfte bewerten einzelne Alternativen und investieren finanzielle Mittel in jene Projekte, die mit der Strategie des Unternehmens übereinstimmen und die höchste Erträge erwarten lassen. Projekte, die diese Kriterien nicht erfüllen, werden fallen gelassen.

Das zweite Modell der Ressourcenallokation, erstmals von Joseph Bower140 beschrieben, sieht diesen Prozess anders. Bower meint, dass die meisten Innovationsideen tief aus dem Innersten – und nicht von der Spitze – des Unternehmens kommen. Sobald diese Ideen an die Oberfläche gelangen, spielt[106]das mittlere Management eine kritische, aber unsichtbare Rolle. Sie sichten Projekte und wählen aus. Sie können nicht jede Idee unterstützen, die ihnen vorgetragen wird. Sie müssen sich entscheiden, welche Ideen die besten sind, welche die höchsten Erfolgswahrscheinlichkeiten haben und welche am wahrscheinlichsten vom Top-Management genehmigt werden.

In den meisten Unternehmen machen mittlere Manager einen Sprung in ihrer Karriere, wenn sie in einem erfolgreichen Projekt eine Schlüsselrolle spielen. Wenn sie sich für die falschen Projekte entscheiden oder auch nur einfach immer wieder Pech haben, ist das für ihre Karriere nicht gerade förderlich. Das mittlere Management wird natürlich nicht für alle gescheiterten Projekte verantwortlich gemacht. Wenn Projekte schief gehen, weil sie beispielsweise von den Technikern nicht umgesetzt werden konnten, werden sie nicht notwendigerweise als Misserfolg betrachtet. Aus den technologischen Anstrengungen kann schließlich viel gelernt werden und Technologieentwicklung wird ja im Allgemeinen als Unterfangen mit unsicherem, nicht vorhersehbarem Ausgang gesehen. Aber wenn Projekte scheitern, weil der Markt dafür nicht da war, hat das weit größere Auswirkungen auf die Karriere der mittleren Manager. Solche Misserfolge sind gleichzeitig teuer und sie sind öffentlich sichtbar. Bis zum Zeitpunkt der Markteinführung haben Unternehmen bereits in das Produktdesign, in die Produktion und Entwicklung, in das Marketing und in den Vertrieb investiert. Im eigenen Interesse und auch im Interesse des Unternehmens neigt das mittlere Management daher dazu, nur solche Innovationsprojekte zu unterstützen, für die eine Nachfrage am Markt am wahrscheinlichsten ist. Im nächsten Schritt verpacken sie die Projektideen so, dass sie die Unterstützung und Genehmigung der obersten Führungskräfte erhalten. Auch wenn die Top-Manager denken mögen, dass sie es sind, die die Entscheidungen treffen, sind bereits viele der kritischen Entscheidungen über die Ressourcenallokation lange vorher getroffen worden: Das mittlere Management hat entschieden, welche Projekte es unterstützt und welche nicht, welche Projekte dem Top-Management präsentiert und welche fallen gelassen werden.

Betrachten Sie die Folgen dieser Prozesse für den erfolgreichen Eintritt in obere oder untere Segmente anhand eines fiktiven Beispiels: Zwei angesehene Mitarbeiter, einer aus dem Marketing, der andere aus der Entwicklung, haben gleichzeitig zwei unterschiedliche Ideen, die sie – vorbei an ihrem gemeinsamen, direkten Vorgesetzten – dem Manager zwei Ebenen über ihnen präsentieren. Der Marketingmanager präsentiert zuerst seine Idee für ein Modell mit höherer Laufwerkskapazität und höherer Geschwindigkeit. Der Manager beginnt mit seinen Fragen:

.„Wer wird das kaufen?“

.„Da gibt es ein ganzes Segment am Markt für Workstation-Computer. Es handelt sich dabei um einen Markt von 600 Millionen Dollar allein für Laufwerke. Das konnten wir bis jetzt nie erreichen, weil die Kapazitäten unserer[107]Produkte dafür nie ausreichten. Ich glaube, mit diesem Produkt kommen wir dort hin.“

.„Haben Sie diese Idee schon irgendwelchen potentiellen Kunden präsentiert?“

.„Ja, ich war letzte Woche in Kalifornien. Sie sagten alle, sie wollen so bald wie möglich einen Prototypen sehen. In neun Monaten kommt ein neues Produktdesign. Das könnte unsere Chance sein. Die Kunden arbeiten gerade mit ihrem derzeitigen Lieferanten .(Konkurrent X) an einer Lösung. Aber wir haben gerade einen Mitarbeiter von Konkurrent X eingestellt. Er sagt, sie hätten Probleme, die Spezifikationen zu erfüllen. Ich bin mir sicher, dass wir es schaffen können.“

.„Aber glaubt die Entwicklung, dass wir das schaffen können?“

.„Die sagen, es sei eine riesige Herausforderung! Aber Sie kennen die Typen. Das sagen die immer.“

.„Mit welchen Margen können wir in dem Segment da oben rechnen?“

.„Das ist das, was mich wirklich begeistert. Wenn wir das Laufwerk in unseren Werken produzieren können, dann können wir – ausgehend von einem Preis von X pro Megabyte – mit einer Bruttogewinnspanne von 35 Prozent rechnen.“

Vergleichen Sie jetzt das Gespräch des Managers mit dem Entwickler, der eine Idee für ein billigeres, kleineres, langsameres, disruptives Laufwerk mit geringerer Kapazität präsentiert:

.„Wer wird das kaufen?“

.„Da bin ich mir noch nicht ganz sicher. Aber da muss es irgendwo einen Markt dafür geben. Die Leute wollen immer kleinere und billigere Dinge. Ich könnte mir vorstellen, dass das Laufwerk für Faxgeräte oder Drucker vielleicht verwendet werden kann.“

.„Haben Sie diese Idee schon irgendwelchen potentiellen Kunden präsentiert?“

.„Ja. Bei der letzten Messe habe ich die Produktidee einem unserer Kunden erklärt. Er sagte, er wäre interessiert. Aber er konnte noch nicht genau sagen, wie sie das Laufwerk verwenden können. Heutzutage braucht es mindestens 270MB für alles. Aber wir haben keine Chance, so viele MBs in dieses Laufwerk zu packen – zumindest nicht so schnell. Aber seine Antwort überrascht mich nicht wirklich.“

.„Was denken die Hersteller von Faxgeräten?“

.„Naja, die sagen, sie wüssten nicht so genau. Noch einmal – sie finden, es ist eine faszinierende Idee. Aber sie haben ihre Produktpläne schon fertig und keiner von denen verwendet Laufwerke.“

.„Glauben Sie, wir können mit diesem Projekt Geld verdienen?“

.„Naja, ich glaube schon. Aber das hängt natürlich davon ab, welchen Preis wir dafür verlangen können.“

Welches dieser zwei Projekte wird der Manager nun unterstützen? Im Tauziehen um die Ressourcen für Entwicklungsprojekte werden immer solche Projekte gewinnen, die auf explizite Kundenwünsche der bestehenden Kunden zielen oder auf die expliziten Wünsche von Kunden, die ihr bisheriger Lieferant noch nicht erfüllen konnte. Entwicklungsprojekte von Produkten, für die es noch keine Märkte gibt, haben das Nachsehen. Dafür gibt es einen einfachen Grund: Effektive Prozesse für die Ressourcenallokation sind so gestaltet, dass sie jene Produktideen ausmerzen, für die es aller Wahrscheinlichkeit nach keine großen, profitablen und aufnahmefähigen Märkte gibt. Unternehmen, die ihre Entwicklungsressourcen nicht systematisch auf die Kundenbedürfnisse ausrichten, werden letztendlich scheitern141.

Es ist also wesentlich leichter, sich nach oben – in die Premiumsegmente – zu entwickeln, als nach unten, um damit in Low-End-Bereiche des Marktes einzudringen. Gleichzeitig kommen aber bei disruptiven Innovationen die gefährlichsten Angriffe aus dem Low-End-Bereich. Das Irritierendste dabei ist, dass .„gutes“ Management nicht hilft: Härter zu arbeiten, schlauer oder visionärer zu sein, löst das Problem nicht. Ressourcenallokationsprozesse beinhalten tausende Entscheidungen – manche sehr subtil, andere sehr explizit. Täglich entscheiden hunderte von Mitarbeitern, wie sie ihre Zeit einsetzen und wie sie die Ressourcen des Unternehmens verwenden. Selbst, wenn sich ein Vorgesetzter für eine disruptive Technologie entscheidet, neigen Mitarbeiter im Unternehmen dazu, sie zu ignorieren oder bestenfalls nur widerwillig mitzumachen. Vor allem, wenn sie nicht dem entspricht, was nach Meinung der Mitarbeiter dem Unternehmen und ihnen selbst zum Erfolg verhilft. Gut geführte Unternehmen bestehen nicht aus Ja-Sagern, die blind das tun, was das Management von ihnen verlangt. Vielmehr haben sie gelernt, zu erkennen, was gut für das Unternehmen und gut für die eigene Karriere ist. Mitarbeiter der besten Unternehmen ergreifen die Initiative, um Kunden gut zu bedienen und um geplante Umsatz- und Gewinnziele zu erreichen. Selbst für den besten Manager ist es eine Herausforderung, kompetente Mitarbeiter dazu zu bringen, sich mit Energie und Nachdruck mit Dingen zu beschäftigen, von denen sie nicht allzu viel halten. Ein Beispiel aus der Geschichte der Computerlaufwerke verdeutlicht das.

Das 1,8-Zoll-Laufwerk

Zahlreiche Führungskräfte aus der Branche der Computerlaufwerke unterstützten uns bei den Forschungsarbeiten zu diesem Buch. Als sich die ersten Untersuchungsergebnisse herauskristallisierten, wurden alle Publikationen aus diesem Projekt noch einmal gesichtet und die Erkenntnisse[109]zusammengefasst. Es war nun äußerst spannend zu sehen, ob das in Abbildung 1.7 zusammengefasste Modell auch die Entscheidungsmuster bei den 1,8-Zoll-Laufwerken, die zu diesem Zeitpunkt als disruptive Technologie am Markt erschienen waren, erklären konnte. Für Branchenfremde schien das klar zu sein: .„Wie oft muss so etwas denn noch passieren, bis diese Unternehmen endlich daraus lernen?“ Sie haben gelernt. Ende 1993 hatte jeder der führenden Hersteller von Computerlaufwerken ein 1,8-Zoll-Modell entwickelt und war für die Markteinführung bereit.

Im August 1994 besuchte Clayton Christensen den CEO eines der größten Hersteller von Computerlaufwerken. Er fragte ihn, was sein Unternehmen mit den 1,8-Zoll-Laufwerken tun werde. Damit sprach er ein heikles Thema an. Der CEO deutete zum Regal in seinem Büro, in dem ein 1,8-Zoll-Laufwerk lag. .„Sehen Sie das?“ fragte er. .„Das ist die vierte Generation eines 1,8-Zoll-Laufwerks, das wir entwickelt haben – jede Generation mit noch mehr Kapazität als das Vorgängermodell. Aber wir haben kein einziges davon verkauft. Wir möchten startklar sein, sobald der Markt dafür reif ist. Aber es gibt scheinbar noch keinen Markt dafür.“

Christensen zeigte ihm daraufhin einen Bericht des Disk / Trend Report, eine angesehene Marktforschungspublikation, die eine wichtige Quelle für seine Forschungsarbeiten darstellte. In diesem Bericht wurde der Markt für diese Laufwerke auf 40 Millionen Dollar für das Jahr 1993, auf 80 Millionen Dollar für das Jahr 1994 und auf 140 Millionen Dollar für 1995 geschätzt.

.„Ich weiß, dass die das glauben“ antwortete der CEO. .„Aber die täuschen sich. Es gibt keinen Markt. Wir hatten dieses Laufwerk 18 Monate lang in unserem Produktkatalog. Jeder weiß, dass wir es haben, aber niemand will es. Dieser Markt ist einfach nicht vorhanden. Wir sind dem Markt offensichtlich zu weit voraus.“ Christensen hatte keine Argumente mehr, die er diesem Manager – einem der besten, mit dem er es je zu tun hatte – entgegensetzen hätte können. Also verlagerte sich das Gespräch wieder auf andere Themen.

Etwa einen Monat später unterrichtete Christensen in einem Kurs für Technologiemanagement im MBA Programm der Harvard Business School. Dabei diskutierte er mit den Teilnehmern über eine Fallstudie, in der es um die Entwicklung eines neuen Motors bei Honda ging. Einer der Teilnehmer arbeitete früher in der Forschungs- und Entwicklungsabteilung von Honda. Daher bat Christensen ihn, zu erzählen, wie es denn bei Honda so war. Es stellte sich heraus, dass dieser Teilnehmer an Armaturen und Navigationssystemen arbeitete. Christensen konnte nicht widerstehen, ihn zu unterbrechen und folgende Frage zu stellen: .„Wie speichern Sie all diese Daten für die Karten?“

Der Student sagte: .„Wir fanden ein kleines 1,8-Zoll-Laufwerk, das wir verwenden konnten. Das ist wirklich toll – es ist praktisch eine monolithische Einheit mit ganz wenigen beweglichen Teilen. Sehr robust.“

.„Wo kaufen Sie das Gerät?“ fragte Christensen.

.„Das ist irgendwie lustig“ antwortete er. .„Man bekommt es bei keinem der großen Hersteller von Laufwerken zu kaufen. Wir beziehen es von einem kleinen Start-up-Unternehmen in Colorado – den Namen habe ich vergessen.“

Für Christensen war das ein Rätsel. Wie konnte der Vorstandschef des oben erwähnten Unternehmens behaupten, dass es keinen Markt für 1,8-Zoll-Laufwerke gäbe, obwohl einer vorhanden war. Und warum war der Student der Meinung, die großen Hersteller würden die besagten Laufwerke nicht verkaufen, wenn diese das doch taten? Die Antwort liegt zum einen im .„Rechts-oben-links-unten“-Problem und zum anderen in der Rolle, die hunderte Entscheidungsträger in guten Unternehmen bei der Priorisierung und Förderung von Projekten spielen, von denen sie glauben, sie brächten größere Erfolge und Gewinne.

Der CEO im obigen Beispiel hatte sich zwar dazu entschieden, frühzeitig in eine disruptive Technologie zu investieren und hatte das Projekt auch solange verfolgt, bis ein erfolgreiches, ökonomisches Design entwickelt worden war. Aber die Mitarbeiter wollten nichts von einem 80-Millionen-Markt im Low-End-Bereich wissen – einem Markt, der die Wachstumsbedürfnisse und Gewinnerwartungen eines Multimilliarden-Unternehmens befriedigen hätte können. Auch weil Konkurrenten andauernd versuchten, bestehende Kunden aus ihrem Markt abzuwerben und damit dem Unternehmen Millionen an Umsatz abspenstig zu machen. Es war auch nichts von einem Absatzmarkt zu sehen, als die Verkäufer Prototypen eines 1,8-Zoll-Laufwerks an einen Autohersteller schickten, um durch deren Verkauf die angestrebten Umsatzzahlen für 1994 zu erreichen. Der Grund für den Misserfolg lag wohl auch darin, dass diese Verkäufer ihre Erfahrungen und Kontakte nicht in der Automobil-, sondern in der Computerbranche hatten.

Um eine so komplexe Aufgabe, wie die Einführung eines neuen Produktes zu meistern, müssen die gesamte Energie und sämtliche Entscheidungen eines Unternehmens darauf ausgerichtet sein. Folglich sind es nicht nur die Kunden eines etablierten Unternehmens, die dieses in die Irre leiten. Etablierte Unternehmen sind auch Gefangene des Geschäftsmodells und der Organisationskultur, die einem Wertesystem inne wohnen. Diese Gefangenschaft erstickt jedes vernünftige Argument für eine Investition in die nächste Stufe einer disruptiven Technologie im Keim.

Aufwärtsmigration von ganzen Wertesystemen

Die Triebkraft, die Unternehmen in die oberen Marktsegmente drängt, ist besonders stark, wenn sich die Kunden des Unternehmens selbst nach oben entwickeln. In diesem Fall wird diese Entwicklung von einem Unter[111]nehmen, das Komponenten wie Computerlaufwerke herstellt, gar nicht bewusst wahrgenommen. Das gesamte Wertesystem – Kunden wie Lieferanten – bewegt sich nach oben.

Aus diesem Blickwinkel betrachtet, wird schnell deutlich, wie leicht ein führender Hersteller von 8-Zoll-Laufwerken – Priam, Quantum und Shugart – den Trend zu den 5¼-Zoll-Laufwerken verschlafen konnte. Nicht ein einziger seiner Hauptkunden wie Digital Equipment, Prime Computer, Data General, Wang Laboratories und Nixdorf hatten erfolgreich einen Desktop-PC eingeführt. Stattdessen entwickelte sich jeder von ihnen selbst in höhere Gefilde des Marktes, in High-End-Segmente, die eine höhere Produktleistung verlangten und höhere Margen versprachen. Und das alles passierte im Bestreben, Kunden zu gewinnen, die immer schon Mainframe-Computer verwendeten. Ganz ähnlich war es bei den Kunden der Hersteller von 14-Zoll-Laufwerken – Mainframe-Hersteller wie Univac, Burrough, NCR, ICL, Siemens und Amdahl. Keiner von ihnen machte einen ernsthaften Versuch sich in untere Marktsegmente zu bewegen und bei Minicomputern Fuß zu fassen.

Drei fast unüberwindbare Barrieren einer .„Abwärtsentwicklung“ sind dafür verantwortlich: Die Verlockung höherer Margen in den oberen Marktsegmenten, die gleichzeitige .„Aufwärtsentwicklung“ zahlreicher Kunden des Unternehmens und die Schwierigkeit, die Kosten für eine .„Abwärtsentwicklung“ entsprechend zu senken. Bei Entscheidungen über Neuproduktentwicklungen verlieren daher in aller Regel disruptive Innovationsprojekte. Projekte mit dem Ziel, Produkte für die oberen Marktsegmente zu entwickeln oder zu verbessern, gewinnen.

Verantwortlich dafür sind ausgereifte Planungs- und Entscheidungssysteme. Einen systematischen Prozess zu finden und sicherzustellen, dass Projekte mit niedrigerer Erfolgswahrscheinlichkeit ausgesondert werden, ist ja auch schließlich eine wichtige Errungenschaft gut geführter Unternehmen.

Dieses Phänomen der großen Aufwärts- und geringen Abwärtsmobilität und der Tendenz, sich in obere Marktsegmente zu entwickeln, hat zur Folge, dass im Low-End-Bereich eines Marktes ein Vakuum entsteht. Dieses Vakuum zieht neue Konkurrenten an, die dieses mit neuen Technologien und günstigeren Kostenstrukturen bestens füllen können. Ein solch entstandenes Vakuum konnte man sehr gut in der Stahlindustrie beobachten. Nachdem neue Anbieter mit ihrer disruptiven Minimill-Technologie im Low-End-Bereich des Marktes einen Brückenkopf bauten, begannen sie unermüdlich, die darüber liegenden Segmente anzugreifen.

Die Aufwärtsmigration der integrierten Stahlhersteller

Anfang der 1960er Jahre begann die Minimill-Stahltechnologie ihren Siegeszug in der Stahlindustrie. In einem Lichtbogenofen wird Schrott geschmolzen und daraus Stahl gewonnen. Der in Elektrolichtbogenöfen geschmolzene Stahl wird anschließend in metallurgischen Prozessen weiterverarbeitet. Die Bezeichnung Minimills erhielten Werke mit dieser Technologie, da die Mindestgröße eines Werkes, um Stahl mit diesem Verfahren zu konkurrenzfähigen Kosten produzieren zu können, lediglich ein Zehntel jener eines integrierten Stahlwerkes mit Sauerstoffverfahren beträgt .(integrierte Stahlhersteller tragen diesen Namen, weil sie in einem integrierten Prozess Eisenerz, Koks und Kalkstein in Stahl transformieren). Hinsichtlich der Gieß- und Walzprozesse ähneln sich integrierte Stahlwerke und Minimills. Der zentrale Unterschied besteht in der Größe: Um mit Hochöfen Stahl zu wettbewerbsfähigen Kosten herstellen zu können, sind wesentlich größere Mengen erforderlich. Mitte der 1990er Jahre waren die nordamerikanischen Stahlwerke die effizientesten und kostengünstigsten Stahlproduzenten der Welt. Im Jahre 1995 waren in den besten Minimills 0,6 Arbeitsstunden nötig, um eine Tonne Stahl zu produzieren. Das beste integrierte Stahlwerk benötigte 2,3 Arbeitsstunden. In jenen Segmenten, in denen auch Minimills aktiv sind, war deren Produktqualität gleichwertig. Auf Vollkostenbasis waren die Minimills um etwa 15 Prozent günstiger, als ein durchschnittlicher integrierter Stahlhersteller. 1995 waren Investitionen von etwa 400 Millionen Dollar erforderlich, um eine wettbewerbsfähige Minimill zu bauen142. Hinsichtlich der Kapitalkosten pro Tonne Produktionskapazität kostete die Errichtung eines integrierten Stahlwerkes in etwa viermal so viel143. In der Folge stieg der Marktanteil der Minimills an der gesamten Stahlproduktion von Null im Jahre 1965 auf 19 Prozent im Jahre 1975, 32 Prozent im Jahre 1985 und auf 40 Prozent zehn Jahre später. Heute machen Minimills etwa 60 Prozent der Stahlproduktion in den USA aus, in Europa etwa 40 Prozent144.

Bis Mitte der 1990er Jahre – d.h. drei Jahrzehnte nach der Einführung dieser Technologie der Stahlerzeugung – hat keiner der großen Stahlhersteller weltweit ein Werk mit Minimill-Technologie gebaut. Warum entschied sich niemand dazu, obwohl dies wirtschaftlich gesehen doch offensichtlich Sinn machte? In der Wirtschaftspresse, vor allem in den USA, fand man dazu meist folgende Erklärung: Das Management der integrierten Stahlhersteller ist konservativ, rückwärtsgewandt, risikoavers und inkompetent. Lesen Sie dazu beispielsweise folgende Anklage:

Im letzten Jahr schloss U.S. Steel fünfzehn seiner Werke, da es seine Wettbewerbsfähigkeit verloren hatte. Vor drei Jahren schloss Bethlehem Steel große Teile seiner Produktion in Johnstown Pennsylvania und in Lackawann, New York … Das Schließen dieser großen Stahlkomplexe ist das dramatische und endgültige Eingeständnis der heutigen Vorstände, dass das Management seiner Aufgabe nicht nachgekommen ist.[113]Es repräsentiert das jahrzehntelange Streben nach Gewinnmaximierung auf kurze Sicht.145 Wäre die US-Stahlindustrie, gemessen in Tonnen je Arbeitsstunde, ebenso produktiv wie in der Rhetorik je Problem, wäre sie ein Spitzenperformer.146

Diese Anschuldigungen stimmen natürlich zum Teil. Aber die Unfähigkeit des Managements kann nicht einzig und allein dafür verantwortlich sein, dass es zum Scheitern der integrierten Stahlhersteller Nordamerikas im Wettbewerb gegen die Minimills kam. Von den zu diesem Zeitpunkt bestgeführten integrierten Stahlherstellern – darunter Nippon, Kawasaki und NKK in Japan, British Steel und Hoogovens in Europa, Pohant Steel in Korea – hatte keiner in die Minimill-Stahltechnologie investiert, obwohl es nachweislich das kostengünstigste Verfahren weltweit war.

Gleichzeitig taten sie alles, um die Effizienz der integrierten Stahlproduktion zu steigern. USX beispielsweise gelang es, die Produktivität in der Stahlherstellung von neun Arbeitsstunden pro Tonne Stahl im Jahre 1980 auf weniger als drei Arbeitsstunden pro Tonne im Jahre 1991 zu senken. Erreicht wurde das durch einen radikalen Abbau von Arbeitsplätzen, von mehr als 93000 im Jahre 1980 auf weniger als 23000 im Jahre 1991 und weiters durch mehr als zwei Milliarden Dollar, die in die Modernisierung der Anlagen gesteckt wurden. Dennoch – all diese Anstrengungen richteten sich lediglich auf die konventionelle Herstellung von Stahl. Wie ist so etwas zu erklären?

Die Stahlproduktion in den Minimills ist eine disruptive Technologie. In den 1960er Jahren eingeführt, produzierte sie zunächst niedrige Qualität. Schrott wurde als Rohstoff verwendet. Das Ergebnis variierte mit der metallurgischen Zusammensetzung und der Reinheit des Schrotts. Daher gab es für Minimills nur einen Markt: Betonrippenstahl. Das war das untere Ende des Marktes in Bezug auf Qualität, Kosten und Margen. Dieser Markt war für die integrierten Stahlhersteller der unattraktivste. Es waren nicht nur die Margen niedrig. Von allen Märkten war das zudem auch jener mit der niedrigsten Kundenloyalität: Die Kunden wechselten laufend ihre Lieferanten. Entscheidend war, wer gerade den niedrigsten Preis verlangte. Die integrierten Stahlhersteller waren nahezu erleichtert, als sie diesen Markt an die Minimills abgeben konnten.

Die Minimills sahen jedoch diesen Markt mit völlig anderen Augen. Sie hatten ganz andere Kostenstrukturen als die integrierten Stahlhersteller: Kaum Abschreibungen und keine Forschungs- und Entwicklungskosten, niedrige Vertriebskosten .(hauptsächlich Telefonrechnungen) und minimale Verwaltungsfixkosten. Sie konnten praktisch ihren gesamten Stahl per Telefon verkaufen – und das auch noch profitabel.

Sobald sie sich erfolgreich im Markt für Betonrippenstahl etabliert hatten, begannen einige aggressive Minimills – darunter vor allem Nucor und Chaparral – den gesamten Stahlmarkt mit anderen Augen zu betrachten als die integrierten Stahlhersteller. Während der Markt für Betonrippenstahl, auf den die Minimills zunächst abzielten, als unterstes Marktsegment für die in[114]tegrierten Stahlhersteller gänzlich unattraktiv geworden war, erschien der aus der Sicht der Minimills darüber liegende Markt höchst verlockend. Dieser Markt versprach bessere Entwicklungschancen, höhere Umsätze und Gewinne. Das war Ansporn genug, um die metallurgische Qualität und Konsistenz der Produkte zu verbessern und in Anlagen zu investieren, mit denen größere Formen produziert werden konnten.

Wie der Entwicklungspfad in Abbildung 4.3 darstellt, griffen die Minimills zunächst den direkt darüber liegenden Markt für größeren Stabstahl, Stangenstahl und Winkeleisen an. Im Jahre 1980 hatten die Minimills 90 Prozent des Marktes für Betonrippenstahl und etwa 30 Prozent des Marktes für Stabstahl, Stangenstahl und Winkeleisen erobert. Zu dem Zeitpunkt, als die Minimills begannen den Markt für Stabstahl und Winkeleisen anzugreifen, war dieser Markt für die integrierten Stahlhersteller jener mit den niedrigsten Margen. Daher waren sie wiederum nahezu erleichtert, dieses Geschäft los zu werden und bis Mitte der 1980er Jahre gehörte er den Minimills.

Sobald sich die Minimills dieses Marktes sicher waren, setzten sie ihren Angriff nach oben fort: Dieses Mal attackierten sie den Markt für Baustahl. Nucor nutzte sein Werk in Arkansas und Chaparral holte von seinem neuen Werk in Texas zum Angriff aus. Auch von diesem Markt wurden die integrierten Stahlhersteller vertrieben. Im Jahre 1992 schloss USX sein integrier[115]tes Stahlwerk südlich von Chicago und ließ damit Bethlehem als einzigen nordamerikanischen Stahlhersteller allein. Sein letztes Werk für Baustahl schloss dieses Unternehmen im Jahre 1995 und überließ damit den gesamten Markt den Minimills. Bethlehem Steel ging im Jahre 2001 in Konkurs. Die Gesellschaft wurde aufgelöst und die verbliebenen Vermögenswerte an die International Steel Group verkauft. Dahinter stand Mittal Steel.

Das Bemerkenswerte an dieser Geschichte ist, dass die integrierten Stahlhersteller genau zu jenem Zeitpunkt ihre Gewinne dramatisch steigerten, als sie begannen, den Markt für Stabstahl den Minimills zu überlassen. Diese Unternehmen senkten nicht nur ihre Kosten. Sie überließen die Produkte mit den niedrigsten Margen ihren Konkurrenten und konzentrierten sich zusehends auf Stahlblech für die qualitätsbewussten Hersteller von Dosen, Autos und Geräten, die für metallurgisch konsistenten Stahl und für fehlerfreie Oberflächen Premiumpreise bezahlten. Tatsächlich richtete sich der Löwenanteil der Investitionen integrierter Stahlhersteller auf das Ziel, sich soweit zu verbessern, dass sie die anspruchsvollsten Kunden in diesen drei Segmenten mit höchstmöglicher Qualität und gewinnbringend versorgen konnten.

Stahlblech war ein sicherer Hafen für die integrierten Stahlhersteller. Dort waren sie geschützt vor den Angriffen der Minimills. Ein modernes, wettbewerbsfähiges Stahlblechwerk zu bauen, kostete etwa 2 Milliarden Dollar. Für die Minimills war diese Summe viel zu hoch.

Diese Strategie stieß unter den Investoren auf großen Anklang. Der Marktwert von Bethlehem Steel sprang von 175 Millionen Dollar im Jahre 1986 auf 2,4 Milliarden im Jahre 1989. Das war eine beachtliche Rendite angesichts der Investition von 1,3 Milliarden Dollar in das Werk während dieser Zeit. Die Wirtschaftspresse applaudierte zu diesen aggressiven, gut überlegten Investitionen:

.„Walter Williams .(der CEO von Bethlehem) hat ein Wunder bewirkt. Über die letzten drei Jahre hat er seinen persönlichen Feldzug gestartet, um die Qualität und Produktivität von Bethlehems Stahlwerken zu verbessern. Bethlehems Verwandlung deklassiert sogar seine stärksten Konkurrenten – die jetzt allesamt zu niedrigeren Kosten als ihre japanischen Rivalen produzieren und rasch die Qualitätslücken schließen. Die Kunden merken den Unterschied. .„Es ist fast schon ein Wunder“ sagt ein Topeinkäufer für Blechstahl von Campbell Soup.“ .(Hervorhebung durch die Autoren).147

Während fast niemand hinsah, geschah fast ein Wunder. Big Steel schafft ein Comeback. Gary Works .(US Steel) ist zurück … und produziert einen glühenden Fluss von geschmolzenem Eisen in der Geschwindigkeit von drei Millionen Tonnen pro Jahr – ein nordamerikanischer Rekord … Anstatt Stahl in allen Formen und Größen zu produzieren, hat sich Gary Works fast ausschließlich auf den höherwertigen Flachstahl konzentriert.“ .(Hervorhebung durch die Autoren).148

Keiner von uns wird bezweifeln, dass diese bemerkenswerten Turnarounds die Früchte guten Managements sind. Aber wohin wird gutes Management dieser Art diese Unternehmen führen?

Das Stranggussverfahren der Minimills zur Produktion von Stahlblech

Während die integrierten Stahlhersteller damit beschäftigt waren, sich zu erholen, zogen am Horizont schon die nächsten disruptiven Wolken auf. Schloemann-Siemag, ein deutsches Unternehmen der Hütten- und Walzwerktechnik – seit der Übernahme der Mannesmann-Sparte Demag im Jahre 1999 nun SMS Schloemann Siemag AG – verkündete im Jahre 1987, dass es ein Stranggussverfahren entwickelt hatte, mit dem es möglich war, flüssigen Stahl zu einem Endlosstrang zu gießen, der anschließend zu Blech ausgewalzt werden kann. Dieser Prozess war wesentlich einfacher als das bis dahin übliche Verfahren der integrierten Stahlhersteller. Aber noch viel wichtiger war: Ein aus Kostensicht wettbewerbsfähiges Werk mit Stranggussverfahren und Walzwerk konnte für weniger als 250 Millionen Dollar gebaut werden – etwa ein Zehntel des Betrages, der für ein konventionelles Werk für Stahlblech hingelegt werden musste. Ein Betrag, der auch für eine Minimill leistbar war. Bei diesem Volumen konnte auch ein Lichtbogenofen die erforderliche Stahlmenge produzieren. Mehr noch, das Stranggussverfahren versprach eine 20-prozentige Reduktion der gesamten Kosten in der Stahlblechproduktion.

Aufgrund dieser vielversprechenden Aussichten wurde das Stranggussverfahren von allen größeren Unternehmen in der Stahlindustrie genau geprüft. Einige Manager von integrierten Stahlherstellern, darunter zum Beispiel USX, arbeiteten hart daran, die Investition in ein Werk mit Stranggussverfahren zu rechtfertigen149. Am Ende war es allerdings Nucor Steel, eine Minimill, und kein integrierter Stahlhersteller, die den Schritt zum Stranggussverfahren wagte. Warum?

Anfangs konnte das Stranggussverfahren nicht die erforderliche Qualität sicherstellen. Hersteller von Dosen, Autos und Geräten verlangten glatte, fehlerfreie Oberflächen. Die einzigen Märkte, die für diese Technologie in Frage kamen, waren Stahldecken, Wellstahlrohre und Wellblechbaracken; Anwendungen, bei denen Kunden mehr auf den Preis, als auf die Oberflächenqualität achteten. Das Stranggussverfahren war eine disruptive Technologie. Große, kompetente und wachstumshungrige integrierte Stahlhersteller stritten sich um das profitable Geschäft großer Auto-, Geräte- und Dosenhersteller. Für sie machte es keinen Sinn, viel Geld in die Stranggusstechnologie zu investieren, war dieses Verfahren doch nur für das am wenigsten profitable, preissensible Massengeschäft geeignet – dem unteren Ende des Marktes. Nachdem Bethlehem und USX zwischen 1987 und 1988 die Stranggusstechnologie ernsthaft in Erwägung gezogen hatten, beschlossen die beiden Unternehmen, doch in konventionelle Technologie zu investieren. Statt geschätzten 150 Millionen Dollar für eine Stranggussanlage gaben sie 250 Millionen für eine konventionelle Anlage aus, mit dem Ziel, die Profitabilität ihres Kerngeschäfts zu steigern.

Es überrascht wohl kaum, dass Nucor die Situation ganz anders beurteilte. Nucor konnte den Markt unbelastet betrachten. Das Unternehmen war nicht durch die Qualitätsanforderungen profitabler Kunden aus dem Stahlblechgeschäft getrieben und profitierte gleichzeitig von der günstigen Kostenstruktur am unteren Ende des Marktes. Nucor fuhr die weltweit erste Stranggussanlage in Crawfordsville, Indiana im Jahre 1989 hoch. Ein Jahr später baute es die zweite Anlage in Hickmann, Arkansas. Bis 1995 erhöhte Nucor an beiden Standorten die Kapazität um 80 Prozent. Nach Schätzungen von Analysten eroberte Nucor bis 1996 etwa 7 Prozent des nordamerikanischen Marktes für Stahlblech. Der Erfolg des Unternehmens war aber auf das am wenigsten profitable Massengeschäft beschränkt. Daher war es nur logisch, dass Nucor daran arbeitete, die Oberflächenqualität zu verbessern, um in die attraktiveren, höherwertigeren und qualitätsbewussteren Marktsegmente einzudringen.

Die Strategie der integrierten Stahlhersteller, sich auf die attraktivsten, obersten Marktsegmente zu konzentrieren, ist nichts anderes als eine Geschichte offensiven Investierens, rationalen Entscheidens, konsequenter Kundenorientierung und die von Rekordgewinnen. Es ist dasselbe Dilemma, dem auch Innovatoren aus der Branche der Computerlaufwerke und der Bagger gegenüberstanden: Vernünftige und gute Managemententscheidungen sind letztendlich der Grund für den Untergang oder den Verlust der Marktführerschaft.

Die Stahlindustrie in Deutschland

Während in den USA das Elektroverfahren .(Minimills) mit einem Anteil von mittlerweile über 60 Prozent weiter verbreitet ist als das Sauerstoffverfahren .(integrierte Stahlwerke), liegt der Anteil in Europa .(EU 27) bei 40 Prozent150. Hier zeigen sich auch deutliche Unterschiede zwischen den Ländern. So beträgt der Anteil der Minimills in Deutschland etwa 30 Prozent, in Italien über 60 Prozent, in Frankreich knapp 40 Prozent und in Spanien fast 80 Prozent der gesamten Stahlproduktion. Die Entwicklung der europäischen und der deutschen Stahlindustrie wurde in den letzten Jahrzehnten allerdings von einigen externen Faktoren beeinflusst, so dass die Verbreitung der Minimills etwas anders verlief als in den USA. Dennoch zeigen sich einige Parallelen.

Nach dem Ende des Zweiten Weltkrieges kam die deutsche Eisen- und Stahlproduktion fast zum Erliegen151. Kriegszerstörungen und Demontage der Produktionsanlagen, die zerstörte Infrastruktur sowie der Rohstoffmangel verhinderten eine rasche Wiederaufnahme der Produktion. Dazu kamen Produktionsbegrenzungen durch die Besatzungsmächte. Der Wiederaufbau in den 50er Jahren leitete dann aber ein rasantes Wachstum der Branche ein,[118]die Rohstahlproduktion wuchs mit durchschnittlich elf Prozent pro Jahr. Die 1960er Jahre erlebten eine Abkühlung der rasanten Nachkriegskonjunktur .(BIP-Wachstums von jährlich vier bis fünf Prozent) und eine Verschiebung der Investitionsgüterindustrie Richtung Konsumgüterindustrie. Die Folge war ein starker Wachstumseinbruch. In den 1970er Jahren, während und nach der Weltwirtschaftskrise, kam es zu einer dramatischen Stahlkrise mit enormen Einbrüchen in der Rohstahlproduktion. Geleitet von Fehleinschätzungen über die Entwicklung der weltweiten Stahlnachfrage wurde die Kapazität weiter ausgeweitet: Für das Jahr 2000 wurde eine Produktion von 2Mrd. Tonnen Rohstahl prognostiziert, die tatsächliche Produktion betrug 850 Millionen. Im Jahre 1980 betrug in Deutschland der Höchststand der Kapazität 70 Millionen Tonnen, die tatsächliche Produktion lag bei 44 Millionen Tonnen152. Die europäischen Stahlproduzenten hatten vor allem in den Ausbau großer, integrierter Stahlwerke investiert, deren Planung und Aufbau lange Vorlaufzeiten benötigte153. Subventionen, Mindestpreise für Betonstahl, Warmbreitband und Stabstahl, Orientierungspreise für andere Produktgruppen, .„freiwillige“ Selbstbeschränkungsabkommen und Produktionsquoten waren nur ein paar der Maßnahmen, mit denen man die europäische Stahlindustrie in den 1970er und 1980er Jahren zu retten versuchte154. Damit wurden einige integrierte Stahlhersteller am Tropf gehalten und ihr Sterben hinausgezögert. Es wurde sehr deutlich, dass in Zeiten der Überkapazität integrierte Stahlhersteller eine zentrale Schwäche hatten155: Ihre Anlagen waren auf Größenersparnisse ausgerichtet und erforderten hohe Produktionsmengen, um die Stückkosten zu senken. Sie waren auch nicht in der Lage, schnell und flexibel auf die schwankende Nachfrage zu reagieren. Die vergleichsweise kleinen Minimills hatten hier entscheidende Vorteile. Trotz der wirtschaftspolitischen Maßnahmen zur Unterstützung der integrierten Stahlhersteller, begannen sich die Elektrostahlwerke durchzusetzen.

In Deutschland wuchs ihr Anteil von zehn Prozent im Jahre 1970 auf 15 Prozent im Jahre 1980. Zehn Jahre später betrug ihr Anteil 20 Prozent und liegt heute bei etwa 30 Prozent – Tendenz steigend156. Aufgrund ihrer Kostenvorteile eroberten die Elektrostahlwerke praktisch den gesamten Markt für Profilstahl in den 1970er und 1980er Jahren157. Die größten Stahlhersteller in Deutschland – ThyssenKrupp, Salzgitter und ArcelorMittal – sind nach wie vor fast ausschließlich als integrierte Stahlhersteller tätig und fokussieren sich auf hochwertigen Flachstahl. Nur etwa 10 Prozent ihrer Produktion ist Elektrostahl. Die meisten der kleinen Hersteller .(Badische Stahlwerke, Riva, Georgsmarienhütte usw.) sind Minimills .(siehe Abbildung 4.4)158.

Wie die meisten europäischen integrierten Stahlhersteller musste in den 1980er Jahren auch die .(damals noch) Thyssen Stahl AG ihre Produktion dem Markt anpassen und begann, sich auf Geschäftsfelder mit gutem Markt- und Ergebnispotenzial zu konzentrieren159. Die heutige Thyssen

Abbildung 4.4:Die größten Stahlerzeuger in Deutschland nach Produktionstechnologie .(2009)160

Krupp AG, entstanden aus der Fusion der beiden Konzerne Thyssen und Krupp im Jahre 1999, ist hauptsächlich ein integrierter Stahlhersteller von Qualitätsflachstahl. Ebenso fokussiert sich Salzgitter auf qualitativ hochwertige Profil- und Flachstahlprodukte und besetzt hochprofitable Nischen. ArcelorMittal, der heute größte Stahlhersteller der Welt, ging 2007 aus der Übernahme des luxemburgischen Konzerns Arcelor durch die holländische Mittal Steel Company hervor. Der Inder Lakshmi Niwas Mittal, .„den vor zwei Jahrzehnten noch niemand in Europa kannte …“, setzte vor allem auf das Konzept der Minimills, die Schrott als Rohstoff in Elektroöfen schmelzen und von Erzpreisen unabhängig sind“161. Durch Akquisitionen schuf er den ersten globalen und heute weltweit führenden Stahlkonzern. In Deutschland konzentriert sich das Unternehmen auf Flachstahlprodukte162.

Die Elektrostahlhersteller .(z.B. Badische Stahlwerke, die italienische Riva-Gruppe und Georgsmarienhütte) spezialisierten sich auf einfachere und preissensiblere Produkte wie Walzdraht, Betonstahl und Stabstahl. Fast ausnahmslos waren es Neueinsteiger in der Branche, die sich mit der Elektrostahl-Technologie am Markt etablierten. Und mit Ausnahme von Dillingen und Saarstahl sind es kleine Hersteller, die ausschließlich auf Elektrostahl setzen.

Die Badischen Stahlwerke gingen aus der 1955 gegründeten Süddeutschen Drahtverarbeitungs-GmbH hervor. 1966 wurde ein Walzwerk in Betrieb genommen – das Vormaterial musste noch zugekauft werden. Zwei Jahre später nahmen zwei Lichtbogenöfen, zwei Stranggießanlagen und ein weiteres Walzwerk ihren Betrieb auf. Das Unternehmen erhielt seinen heutigen Na[120]men. Mit 2,2 Millionen Tonnen Stahl sind die Badischen Stahlwerke heute Deutschlands größter Elektrostahlhersteller.

Die Riva Gruppe, heute das führende Stahlunternehmen Italiens, das drittgrößte Europas und im Jahre 2009 Platz 18 auf der Weltrangliste, begann als Elektrostahlproduzent. Als Schrotthändler in den 1950er Jahren beschlossen die Brüder Emilio und Adriano Riva im Jahre 1957 mit dem damals größten Elektroofen Italiens in die Stahlproduktion einzusteigen – ein rasantes Wachstum folgte daraufhin. In den 1970er Jahren wurde die Stranggusstechnik eingeführt. Akquisitionen und Internationalisierung führten zu weiterem Aufstieg. Um weder ganz von Schrott noch von Eisenerz abhängig zu sein, ist das Unternehmen heute in zwei Geschäftseinheiten aufgeteilt: Die Riva Acciaio SpA, unter der alle Elektrostahlwerke zusammengefasst sind und die Ilva SpA, unter der alle Werke mit integrierter Stahlproduktion Flachwalzprodukte herstellen.

Die Georgsmarienhütte wurde 1856 gegründet, 1923 ging das Unternehmen an den Klöckner-Konzern. Die Stahlkrise traf das Unternehmen hart. Über den bis dahin integrierten Stahlhersteller Georgsmarienhütte wurde 1993 das Vergleichsverfahren eröffnet und ein Management-Buy-Out rettete den Stahlhersteller. Die Verhüttung von Eisenerz als Rohstoff für die Eisenerzeugung in Hochöfen wurde aufgegeben und in einem neu gebauten Elektrolichtbogenofen Schrott eingeschmolzen.

Erst sehr viel später als in den USA und in weit geringerem Ausmaß begann Elektrostahl in die Märkte der klassischen integrierten Stahlhersteller vorzudringen, die vorwiegend hochqualitative Flachstahlprodukte produzierten163. Damit sehen wir einige Ähnlichkeiten mit der Entwicklung in den USA:

|

• |

Die Minimill-Technologie begann sich in den unteren Marktsegmenten zu etablieren, da die Qualität anfangs noch niedrig und diese Segmente preissensibel waren. |

|

• |

Integrierte Stahlhersteller waren dort nicht mehr wettbewerbsfähig und überließen dieses Terrain den Elektrostahlwerken. Sie begannen, sich zunehmend auf qualitativ hochwertige Produkte zu konzentrieren, da sie dort ihre Gewinn- und Wachstumschancen sahen. |

|

• |

Kaum ein integrierter Stahlhersteller setzte auf die Minimill-Technologie. Es waren meist Neueinsteiger in der Branche, die sich mit dieser Technologie erfolgreich am Markt etablieren konnten und die integrierten Stahlhersteller aus den unteren Segmenten verdrängten. |

Anders als in den USA allerdings entwickelten sich die Minimills nur sehr langsam und zögerlich in die oberen Marktsegmente. Auch heute noch ist der Markt größtenteils aufgeteilt in integrierte Stahlwerke, die sich auf die qualitativ hochwertigen Produkte konzentrieren oder aber attraktive Nischen besetzen und Elektrostahlwerke, die vorwiegend in den unteren Marktsegmenten tätig sind. Zu dieser verzögerten Entwicklung der Mini[121]mills trugen allerdings die wirtschaftspolitischen Maßnahmen zur Stützung der integrierten Stahlhersteller vor allem in den 1970er und 1980er Jahren wesentlich bei.