5 - Demasiado barato para tomarlo en cuenta

La lección de Internet: cuando algo reduce su precio a la mitad cada año, el cero es inevitable

En 1954, en los albores de la energía nuclear, Lewis Strauss[38], jefe de la Comisión de Energía Atómica, se plantó delante de un grupo de escritores científicos en Nueva York y predijo los grandes acontecimientos que se iban a producir. Las enfermedades serían domeñadas y llegaríamos a entender por qué envejece el hombre. La gente viajaría pronto «sin esfuerzo» por mar y aire a grandes velocidades. Las grandes hambrunas periódicas pasarían a ser un asunto del pasado. Y sobre todo, pronosticó que «nuestros hijos disfrutarán en sus hogares de energía eléctrica demasiado barata como para tener que medirla».

Eran tiempos optimistas: era el inicio de la edad espacial, la medicina moderna estaba superando antiguas dolencias, la química estaba aportando «calidad de vida» y alimentando al planeta, y la Era de la Información estaba surgiendo con sus infinitas posibilidades. Todo lo que se podía imaginar podía ser inventado y rápidamente etiquetado, envasado y vendido a una clase emergente de ávidos consumidores.

El optimismo de posguerra fundado en que la ciencia y la tecnología podían iniciar una era de prosperidad de crecimiento sin precedentes abarcaba desde el orgullo nacional a la dicha doméstica. El poder del pensamiento humano y la maquinaria inteligente prometió liberarnos de las pesadas labores del hogar y poner fin a la guerra. La cuestión no era si viviríamos en colonias espaciales y lo que llevaríamos allí. Los Jetsons [los Supersónicos] eran la contrapartida a los Picapiedra, y la idea de que algún día tendríamos taxis voladores y mayordomos robots era tan cierta como el hecho de que antes vivíamos en cuevas.

Y, de hecho, la ciencia de posguerra y el auge tecnológico que la siguió nos encaminó por la senda de la productividad y el crecimiento económico a un ritmo nunca visto con anterioridad. Pero no fue tan camino de rosas como lo había predicho Strauss. La electricidad no llegó a ser tan barata como para no tener que medirla.

Aunque los costes del uranio eran bajos comparados con el carbón, los costes iniciales de construir reactores y centrales eléctricas resultaron ser muy elevados. El vertido de los residuos era y sigue siendo un problema sin resolver. Y una propuesta cara y peligrosa resultó serlo por partida doble después de Three Mile Island y Chernobyl.

Hoy en día, la energía nuclear cuesta aproximadamente lo mismo que el carbón, lo que equivale a decir que no cambió la economía de la electricidad en lo más mínimo.[39]

Pero, ¿que habría pasado si Strauss hubiera tenido razón? ¿Si la electricidad hubiera resultado prácticamente gratis? La respuesta es que todo lo que tocaba la electricidad —que es como decir casi todo— se habría transformado. En lugar de equilibrar la electricidad con otras fuentes de energía, ahora utilizaríamos la electricidad todo lo que podríamos; la derrocharíamos, porque sería tan barata que no merecería la pena preocuparse por la eficiencia.

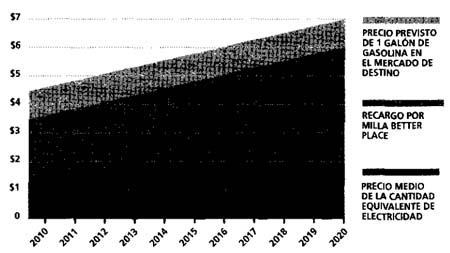

Todos los edificios se calentarían con electricidad, sin tener en cuenta la tasa de conversión térmica. Todos conduciríamos coches eléctricos. (La electricidad gratuita sería un incentivo para desarrollar la tecnología de baterías eficientes para almacenarla). Plantas de desalinización masiva convertirían el agua de mar en toda el agua potable que se podría desear, permitiéndonos regar enormes ringleras de tierras interiores y convertir desiertos en fértiles llanuras.

Dado que dos de los tres principales componentes de la agricultura, el aire y el sol, son gratuitos, y el agua pronto se les uniría, podríamos comenzar a cultivar cosechas con grandes excedentes para satisfacer nuestras necesidades, y muchas de ellas serían la materia prima para los biocombustibles. En comparación, los combustibles fósiles serían considerados absurdamente caros y sucios. De manera que las emisiones de carbono caerían en picado. (Las plantas absorben carbono de la atmósfera antes de devolverlo de nuevo quemándolo, mientras que el petróleo y el carbón añaden más carbono). La frase «calentamiento global» podría no haber entrado a formar parte nunca del lenguaje.

En resumen, lo de «demasiado barato para medirla» podría haber cambiado el mundo.

¿Poco probable? Con la electricidad tal vez (aunque, ¿quién sabe lo que la energía solar puede aportar un día?) Pero hoy existen otras tres tecnologías que afectan a nuestra economía casi como la electricidad: la capacidad de tratamiento informático, el almacenamiento digital y la banda ancha. Los tres se están volviendo demasiado baratas para medirlas.

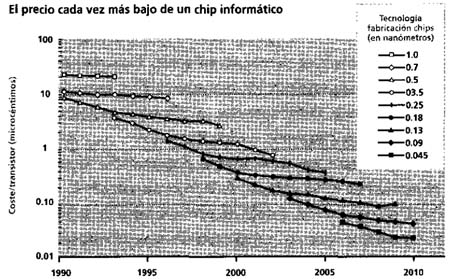

La velocidad a la que está sucediendo esto es alucinante, incluso casi medio siglo después de que Gordon Moore detectara por primera vez la línea de tendencia denominada ahora la Ley de Moore. Y lo que es más asombroso, la capacidad de tratamiento —la que rastreó Moore— está mejorando al ritmo más lento de los tres. Los chips de semiconductores duplican el número de transistores que pueden contener aproximadamente cada 18 meses. (Es la razón por la que cada 2 años aproximadamente usted pueda comprar por el mismo precio un iPod que almacena el doble de música que el anterior). El almacenamiento en disco duro está mejorando incluso más deprisa: el número de bites que se pueden guardar en una zona dada de un disco duro se duplica aproximadamente cada año, y por ello usted puede guardar ahora cientos de horas de vídeo en su TiVo (grabador de vídeo digital). Pero lo que avanza con mayor rapidez de los tres es la banda ancha: la velocidad a la que se pueden transferir datos en un cable de fibra óptica se duplica cada 9 meses. Esa es la razón por la que no necesite ya el TiVo: puede ver toda la TV que desee, cuando lo desee, con los servicios de vídeo online directo (como Hulu).

Cada una de estas tecnologías tienen un poderoso corolario económico: los costes se reducen a la misma velocidad que aumenta la capacidad, la velocidad, etc. De manera que si la potencia informática por un precio dado se duplica cada dos años, una unidad determinada de potencia informática reducirá su precio en un 50 por ciento en el mismo periodo.

Veamos el transistor. En 1961, un único transistor costaba 10 dólares. Dos años más tarde, costaba 5. Otros dos años más tarde, cuando Moore publicó su predicción en la edición de abril de 1965 de Electronics magazine, era de 2,50. En 1968, el precio del transistor había caído a 1 dólar. Siete años más tarde era de 10 céntimos. Otros siete años y era de menos de 1 céntimo, y así sucesivamente. 0,000015 céntimos. O lo que es lo mismo, es demasiado barato para medirlo.

Este «juego triple» de tecnologías más rápidas, mejores y más baratas —tratamiento, almacenamiento y banda ancha— van todas juntas en Internet, y es la razón de que hoy usted pueda tener servicios gratuitos como YouTube (esencialmente cantidades ilimitadas de vídeos que puede contemplar sin demora y cada vez con una mayor resolución), algo que habría sido ruinosamente caro sólo hace unos años.

Nunca en el curso de la historia humana han caído de precio los recursos primarios de una economía industrial de manera tan rápida y durante tanto tiempo. Este es el motor que está detrás del nuevo Gratis, el que va más allá de un truco de marketing o de una subvención cruzada. En un mundo en el que los precios siempre parecen subir, el coste de algo construido sobre estas tres tecnologías siempre irá hacia abajo. Y sigue bajando hasta que llega lo más cerca posible del cero.

Anticipar lo barato

Cuando el coste de lo que estás fabricando cae con esta regularidad y durante tanto tiempo, se puede tratar de aplicar precios que en otras circunstancias parecerían una locura. En lugar de venderlo por lo que cuesta hoy, lo puedes vender por lo que costará mañana. La demanda creciente que este precio bajo estimulará y acelerará la curva, garantizando que el producto costará incluso menos de lo esperado cuando llegue mañana. De modo que usted gana más dinero.

Por ejemplo, a principios de la década de 1960, Fairchild Semiconductor estaba vendiendo un primitivo transistor, llamado el 1211, a las fuerzas armadas. Fabricar cada transistor costaba 100 dólares. Fairchild quería vender el transistor a la RCA para que lo utilizara en su nuevo sintonizador de televisión UHF. Por entonces, RCA estaba usando los tradicionales tubos de vacío, que costaban únicamente 1,05 dólares cada uno.

Los fundadores de Fairchild[40], los legendarios Robert Noyce y su vendedor estrella, Jerry Sanders, sabían que a medida que aumentara su volumen de producción, el coste del transistor bajaría rápidamente. Pero para hacer su primera venta comercial necesitaban que el precio bajara inmediatamente, antes de tener ningún volumen. Así que redondearon a la baja. Redujeron el precio del 1211 a 1,05 dólares, desde el principio, antes de saber siquiera cómo fabricarlo tan barato. «Ibamos a fabricar los chips en una fábrica que no habíamos construido, utilizando un proceso que no habíamos desarrollado todavía, pero sabíamos que lo fundamental era que íbamos a salir al mercado la próxima semana vendiendo a 1,05 dólares (recordaba más tarde Sanders). Estábamos vendiendo en el futuro».

Funcionó. Adelantándose a la curva de descenso del precio, fijaron su objetivo en 1,05 dólares y se hicieron con el 90 por ciento de la cuota del mercado de sintonizadores UHF. Dos años más tarde pudieron reducir el precio del 1211 a 50 céntimos y seguir obteniendo beneficios. Kevin Kelly, que describió este efecto en su libro New Rules for the New Economy[41], lo llama «anticipar lo barato».

Imagine si Henry Ford hubiera aplicado la misma tendencia a su fábrica del Modelo T. Parece casi imposible: ¿cómo podría una cosa física como un coche reducir su precio como lo hace la tecnología digital? Cada año tendríamos que ser el doble de buenos en extraer mineral de las entrañas de la tierra y convertirlo en metales. Todos los componentes que conforman un coche tendrían que irse abaratando como los chips semiconductores obedeciendo a una especie de Ley de Moore de limpiaparabrisas y maquinaria de transmisión. Los obreros tendrían que aceptar recortar sus salarios a la mitad cada año, o la mitad de ellos tendría que ser reemplazada por robots.

Pero si usted hubiera estado vivo en las primeras décadas de la industria del automóvil, no sería imposible de imaginar. Entre 1906 y 1918, los precios de los automóviles «ajustados según calidad» (el rendimiento del coche por dólar) caían aproximadamente un 50 por ciento cada dos años, de manera que para finales de ese periodo, un coche equivalente costaba sólo un quinto de lo que costaba 10 años antes.

Al pasar de la artesanía a una línea de montaje alimentada por motores eléctricos, Ford pudo reducir el coste de la fuerza muscular. A continuación, al pasar de las piezas realizadas a medida a componentes de fabricación estándar, redujo el coste de la mano de obra de nuevo y vendió millones de coches fabricados en serie.

Pero esa extraordinaria curva de descenso de los precios, producto de las revolucionarias técnicas de producción de Henry Ford, no podía durar. Las mejoras de rendimiento/precio de los coches fueron disminuyendo, y hoy en día sólo corresponden a un pequeño porcentaje anual. Somos sin duda mejores extrayendo mineral de la tierra, y la mitad de los obreros del automóvil han sido realmente desplazados por robots, pero no ha sucedido de la noche a la mañana. Los coches son cada vez mejores y más baratos, pero no al ritmo de la tecnología digital. Hoy en día, un coche sigue siendo un artículo caro.

Desde una perspectiva ambiental, no es algo malo. Aunque fuera posible que las cosas físicas cayeran de precio con la misma rapidez que los microchips, los «efectos externos negativos» del exceso de producción resultante serían enseguida demasiado aparentes. Si ha visto WALL-E de Pixar, en la que los humanos son expulsados del planeta por rebosantes montañas de basura, se podrá imaginar el problema.

Pero en la esfera digital, lo se crea en abundancia es en última instancia efímeros bits de información —electrones, fotones y flujo magnético—, no hay nada que impida que esas extraordinarias leyes de la duplicación se desarrollen al máximo. Y la consecuencia es sorprendente, como el propio Moore indica: «la ley de Moore es una infracción de la ley de Murphy. Todo mejora cada vez más».

Por qué funciona la ley de Moore

La mayoría de procesos industriales mejoran con el tiempo y la escala gracias a un efecto conocido como curva de aprendizaje. Lo que pasa es que los procesos basados en semiconductores lo hacen mucho más deprisa y durante más tiempo.

El término «curva de aprendizaje»[42] fue introducido en el siglo XIX por el psicólogo alemán Hermann Ebbinghaus para describir las mejoras que observó cuando las personas memorizaban tareas a lo largo de muchas repeticiones. Pero pronto asumió un significado más amplio. El artículo de la Wikipedia sobre este término lo explica así: «El principio establece que cuantas más veces haya sido realizada una tarea, menos tiempo se necesitará para cada iteración subsiguiente. Un ejemplo temprano de esto fue observado en 1936 en la Base de la Fuerza Aérea Wright-Patterson, en la que los gerentes calcularon que cada vez que se duplicaba la producción total de aviones, el tiempo de fabricación necesario se reducía de un 10 a un 15 por ciento».

A finales de la década de 1960, el Boston Consulting Group (BCG) comenzó a examinar industrias tecnológicas, y vio mejoras que sencillamente se producían con más rapidez de lo que las simples curvas de aprendizaje podían explicar. Cuando la curva de aprendizaje tenía que ver principalmente con el conocimiento humano, esos efectos más amplios parecían tener más que ver con la escala: cuando los productos eran fabricados en grandes cantidades, los costes caían en un porcentaje constante y predecible (10 al 25 por ciento) con cada duplicación del volumen. BCG lo denominó la «curva de la experiencia», para referirse al aprendizaje institucional, desde las mejoras administrativas aplicadas a la optimización de la cadena de suministro al aprendizaje individual de los obreros.

Pero a partir de la década de 1970, las bajadas de precio en el nuevo campo de semiconductores parecían estar sucediendo más deprisa de lo que podía explicar la curva de la experiencia. Los transistores originales cayeron al máximo del índice BCG y siguieron bajando. Durante un decenio, las ventas del transistor 1211 de Fairchild se multiplicaron por 4000. O se duplicaron 12 veces, lo que la teoría de la curva de la experiencia predice que conduciría a un descenso del precio de una treintava parte de la cifra original. De hecho, el precio cayó a una milésima de ese número. Evidentemente estaba pasando algo más.

Lo que hay de diferente en los semiconductores es una característica de muchos productos de alta tecnología; tienen mucha más materia gris que fuerza muscular. Desde un punto de vista económico, sus aportaciones son más intelectuales que materiales. Después de todo, los microchips son simplemente arena (silicio) reunida de manera muy inteligente. Como escribe George Gilder[43], autor de Microcosm:

Cuando la materia desempeña un papel tan pequeño en la producción, hay menos resistencia material al incremento de volumen. Los semiconductores representan el derrocamiento de la materia en la economía.

En otras palabras, las ideas pueden propagarse prácticamente sin límite y sin coste. Esto, desde luego, no es nuevo. De hecho, fue Thomas Jefferson, el padre del sistema de patentes (y de mucho más), quien lo expresó mejor que nadie:

Quien recibe una idea de mí, recibe conocimiento él mismo sin mermar el mío; al igual que quien enciende su vela en la mía, recibe luz sin oscurecerme.

La cuestión es que las ideas son el último producto abundante que se propaga a coste marginal cero. Una vez creadas, las ideas desean propagarse lejos enriqueciendo todo lo que tocan. (En la sociedad, esas ideas que se propagan son llamadas «memes»).

Pero en los negocios, las empresas hacen dinero creando una escasez artificial de ideas a través de la ley de propiedad intelectual. Para eso existen las patentes, los derechos de autor y los secretos comerciales: son esfuerzos por retener el flujo natural de ideas en la población en general durante el tiempo suficiente para hacer beneficios. Fueron creados para dar a los inventores un incentivo económico para crear, una licencia para cobrar un ingreso monopolista durante un tiempo limitado, para que puedan obtener un beneficio por el trabajo que les costó la idea. Pero en última instancia, las patentes expiran y los secretos se hacen públicos; las ideas no pueden ser retenidas para siempre.

Cuantos más productos estén hechos de ideas más que de material, más rápidamente se podrán abaratar. Esta es la raíz de la abundancia que conduce a lo Gratis en el mundo digital, que hoy abreviamos como la Ley de Moore.

Sin embargo, esto no se limita a los productos digitales. Cualquier industria en la que la información se convierte en el principal ingrediente, tenderá a seguir esta curva de aprendizaje compuesta y a acelerar el rendimiento mientras su precio se reduce. Tomemos la medicina, que está derivando del «no sabemos por qué funciona, simplemente lo hace» (hay una razón por la que se llama «descubrimiento» de medicamentos) a un proceso que comienza con los primeros principios de la biología molecular («ahora sabemos por qué funciona»). La ciencia subyacente es información, mientras que la eficacia observada es una anécdota. Una vez que comprendes los fundamentos, puedes crear una abundancia de mejores medicamentos, y más deprisa.

La secuenciación del ADN está cayendo de precio en un 50 por ciento cada 1,9 años, y pronto, nuestra composición genética individual será otra industria de la información. Cada vez serán más los servicios médicos y de diagnóstico suministrados por software (que se hace más barato, hasta el punto de ser gratis), a diferencia de los médicos (que se hacen cada vez más caros).

Lo mismo pasa con la nanotecnología, que promete convertir la fabricación en otra industria de la información, a medida que moléculas diseñadas ad hoc se unen automáticamente. A medida que la energía pasa de quemar combustibles fósiles a utilizar células fotovoltaicas para convertir el sol en electricidad en una escala de servicio público, o diseñar enzimas que puedan convertir la hierba en etanol, también será una industria de la información. En cada caso, industrias que no tienen nada que ver con el tratamiento informático comienzan a mostrar un crecimiento exponencial (y un descenso del precio) a semejanza de la ley de Moore una vez que ellas, también, son más producto de la materia gris que de la fuerza muscular.

La ley de Mead

Como suele suceder, Gordon Moore no acuñó la ley que lleva su nombre. El hombre que lo hizo, el profesor del Caltech [Instituto de Tecnología de California] Carver Mead, fue el primero que se centró en el corolario económico a la regla de duplicación de Moore para la densidad de transistores: si la cantidad de capacidad informática con un coste dado se duplica cada dos años, en ese caso el coste de una unidad dada de capacidad informática debe reducirse por la mitad en el mismo periodo. Y lo que es más importante, fue el primero en considerar realmente lo que ello significaba con relación a nuestra manera de pensar y utilizar la tecnología digital. Y se dio cuenta de que estábamos totalmente equivocados al respecto.

A finales de la década de 1970, Mead enseñaba diseño de semiconductores en el Caltech, estableciendo los principios de los circuitos integrados que llegarían a ser conocidos como Integración a muy gran escala (VLSI), que prácticamente definieron el mundo informático que conocemos hoy. Como Moore antes de él, fue capaz de ver que las duplicaciones cada 18 meses en rendimiento seguirían prolongándose hasta donde nadie podía imaginar. Y ello no estaba motivado únicamente por las curvas de experiencia y aprendizaje estándar sino también por lo que él denominó la «curva de aprendizaje compuesta», que es la combinación de curvas de aprendizaje e invenciones nuevas y frecuentes.

Durante más de medio siglo, los investigadores de semiconductores han hecho una innovación importante cada 10 años más o menos, que vuelve a impulsar a la industria a la parte de brusco declive de la curva. A medida que un proceso de producción se acerca a la cola de su ciclo de mejora de eficiencia, se incrementa el incentivo para aparecer con algo radicalmente nuevo y mejor.

Y dado que, como dijo el físico Richard Feynman, hay «un montón de espacio en el fondo» del mundo de la escala atómica que surgió con la nueva física de finales del siglo XX, los investigadores han sido capaces de encontrar estas nuevas vías con casi una espeluznante regularidad.

Cada vez, ya se trate de un nuevo material, un nuevo proceso de grabado, una nueva arquitectura de chip o una dimensión totalmente nueva como el procesado en paralelo, la curva de aprendizaje se inicia de nuevo en su más vertiginosa pendiente. Cuando se combinan todas estas innovaciones con las curvas de aprendizaje en toda la industria informática, se termina a un ritmo de descenso del coste nunca antes visto. Los transistores, como casi cualquier otra unidad de capacidad informática que elijamos, avanzan inevitablemente hacia el precio cero.

Lo que Mead constató es que este efecto económico llevaba consigo un imperativo moral. Si los transistores se están volviendo demasiado baratos como para medir lo que cuestan, deberíamos dejar de medirlos y de pensar en su coste. Deberíamos pasar de mantenerlos en el supuesto de que son un bien escaso a tratarlos como el producto abundante que es. En otras palabras, deberíamos literalmente comenzar a «despilfarrarlos».

«Despilfarrar» era una palabra desagradable especialmente en el mundo de la tecnología de la información de la década de 1970. Una generación entera de profesionales de la informática había aprendido que su trabajo era distribuir costosos recursos informáticos en pequeñas cantidades. En las acristaladas instalaciones de la época de los ordenadores centrales, estos operadores de sistemas ejercían su poder eligiendo los programas a los que se permitiría funcionar en las costosas máquinas informáticas. Su papel era conservar transistores, y ellos no sólo decidían lo que era válido sino que animaban a los programadores a hacer el uso más económico de su tiempo informático.

Este sacerdocio —el de los administradores de sistemas— gobernó en los albores de la era de la información. Si querías utilizar un ordenador, tenías que vértelas con ellos. Y ello significaba escribir un programa que se conformara a sus estándares de lo que era un uso adecuado de los recursos de la tecnología de la información. El software tenía que estar centrado en objetivos empresariales, ser eficiente en su uso de los ciclos CPU, y modesto en sus ambiciones. Si pasabas esa prueba, podían aceptar tus tarjetas perforadas a través de la ranura de la puerta y, dos días más tarde, devolverte un listado de tus mensajes de error para que pudieras comenzar el proceso de nuevo.

Como resultado, los primeros técnicos dedicaron la mayor parte de sus esfuerzos a que sus algoritmos principales funcionaran lo más eficientemente posible, y pocos esfuerzos al interfaz de usuario. Era la época de la línea de comando, y el papel del software era servir a la unidad de procesamiento central y no a la inversa.

Los ingenieros de la época comprendieron la Ley de Moore a un nivel: sabían que aportaría ordenadores que serían más pequeños y más baratos que los grandes ordenadores de su tiempo. De hecho, no era demasiado difícil imaginar que los ordenadores se volverían tan pequeños y baratos que una familia normal podría tener uno en su hogar. Pero, ¿por qué iba a querer nadie tener algo así? Después de mucho reflexionar, al establisbment informático de finales de los sesenta sólo se le ocurría una razón: para organizar recetas de cocina. El primer ordenador personal del mundo, un elegante electrodoméstico para la cocina ofertado por Honeywell en 1969, hacía precisamente esto (incluso venía con una encimera para trabajar integrada). El Honeywell apareció en el catálogo de ese año de Neiman Marcus al precio de ganga de 10.600 dólares, a pesar de que el único método de hacerlo funcionar era mediante conmutadores de palanca en el panel frontal, y el ama de casa tenía que conocer la numeración hexadecimal. No se sabe de nadie que comprara uno.

Y allí estaba Mead, diciendo a los programadores que se pasaran al derroche. ¿Cómo se derrocha capacidad informática?, pensaban mientras se rascaban la cabeza.

El ratón que rugió

Fue Alan Kay, un ingeniero que trabajaba en el Centro de Investigación de Xerox en Palo Alto, en la década de 1970, quien les enseñó el camino. En lugar de conservar transistores para las funciones de tratamiento principales, desarrolló un concepto informático —el Dynabook— que emplearía frívolamente el silicio para hacer cosas juguetonas en la pantalla: dibujar iconos, dirigir punteros con un ratón, dividir una pantalla en ventanas e incluso añadir animación sin más función que la de hacer bonito.

¿Cuál era el objeto de este derroche visual? Hacer que los ordenadores fueran más fáciles de utilizar por personas normales, incluidos los niños. El trabajo de Kay en la interfaz de usuario gráfica (GUI: graphical user interface) se convirtió en la inspiración del Centro de Palo Alto de Xerox y luego de Apple Macintosh, que cambió el mundo al poner la informática a disposición de todos nosotros.

De lo que se dio cuenta Kay fue de que el trabajo del tecnólogo no era descubrir para qué es buena la tecnología. Su papel es hacer que la tecnología sea tan barata, fácil de utilizar y tan omnipresente que todo el mundo pueda utilizarla, de manera que se propague por todo el mundo y dentro de todos los nichos posibles. Nosotros, los usuarios, ya encontraremos qué hacer con ella, porque cada uno de nosotros es diferente: tenemos diferentes necesidades, diferentes ideas, diferentes conocimientos y diferentes maneras de interactuar con el mundo.

Kay, al mostrar la manera de democratizar la informática, hizo posible extraer el fenómeno de Moore de la caja de cristal y llevarlo a cada hogar, coche y bolsillo. Este ejercicio colectivo de explorar el espacio potencial de la informática nos ha traído de todo, desde la fotografía digital a los videojuegos, desde las TiVos a los iPods. (Hay que decir que organizar recetas no ocupa un lugar muy destacado en las listas de la gente).

Los ingenieros nos aportaron la infraestructura técnica de Internet y de la Web —«TCP/IP» y «http://»—, pero fuimos nosotros los que descubrimos qué hacer con ello. Dado que la tecnología era gratuita y abierta a todos, nosotros, los usuarios, experimentamos con ella y juntos la llenamos con nuestros contenidos, nuestras ideas y con nosotros mismos. Los tecnólogos inventaron el recipiente, pero nosotros lo llenamos.

Evidentemente, la tecnología barata no es tecnología gratuita. Los ordenadores potentes eran caros en los tiempos de Kay, y lo siguen siendo hoy, como el pobre director general de inversiones que acaba de desembolsar seis cifras para comprar una nueva batería de servidores se encargará de decírselo. La tecnología no resulta gratis cuando la tienes que comprar en grandes cantidades. Sin embargo, si la miras desde el otro lado del circuito, la economía cambia. Ese costoso banco de discos duros (elevados costes fijos) puede servir a decenas de miles de usuarios (bajos costes marginales).

En el Internet de nuestros días lo que impera son las economías de escala, encontrar formas de atraer a la mayor cantidad de usuarios hacia recursos centralizados, extendiendo estos costes a públicos cada vez más amplios a medida que la tecnología se vuelve cada vez más capaz. Ya no se trata de lo que cuesta el equipo que ocupa las estanterías en el centro de datos; lo que importa es lo que puede hacer ese equipo. Y cada año, como una especie de reloj mágico, hace cada vez más por menos, acercando a cero los costes marginales de la tecnología en las unidades que nosotros consumimos.

Lo que anticiparon Mead y Kay tuvo un profundo efecto sobre la industria basada en la computación. Significó que los redactores de software, libres ya de tener que preocuparse por los escasos recursos computacionales como la memoria y los ciclos CPU, podían ser cada vez más ambiciosos, centrarse en funciones de un orden más elevado, como las interfaces de usuario, y en nuevos mercados, como el del entretenimiento. El resultado fue un software de mayor atractivo, que atrajo a más usuarios, que a su vez descubrieron más usos para los ordenadores. Gracias a ese derroche de transistores se pudo cambiar el mundo.

Lo que es interesante es que los transistores (o el almacenamiento, o la banda ancha) no tienen que ser completamente gratis para producir este efecto. Hasta cierto punto, son lo suficientemente baratos para poder ser pasados por alto tranquilamente. El filósofo griego Zenón luchó con este concepto en un contexto ligeramente diferente. En la paradoja de la dicotomía de Zenón, tú corres hacia una pared. Mientras corres, la distancia con la pared se reduce a la mitad, luego se vuelve a reducir a la mitad, y así sucesivamente. Pero si continúas subdividiendo el espacio para siempre, ¿cómo podrás llegar nunca a alcanzar la pared? (La respuesta es que no puedes: una vez que estás a unos pocos nanómetros, las fuerzas de repulsión atómica se vuelven demasiado fuertes para que puedas acercarte. En lo que respecta a la aparente paradoja matemática, Newton la resolvió con la invención del cálculo integral).

En economía, el paralelo es este: si el coste unitario de la tecnología («por megabyte» o «por megabyte por segundo» o «por mil operaciones de coma flotante por segundo») se reduce a la mitad cada 18 meses, ¿cuándo se acerca lo suficiente a cero como para decir que has llegado y que lo puedes redondear a cero? La respuesta es que casi siempre antes de lo que piensas.

Lo que comprendió Mead fue que debería activarse un interruptor psicológico cuando las cosas se dirigen hacia el cero. Aunque nunca puedan llegar a ser totalmente gratuitas, a medida que el precio cae, hay una gran ventaja en tratarlas como si fueran gratis. No demasiado baratas para medirlas, como predijo Strauss, sino demasiado baratas como para que importen.

Hierro y vidrio

La historia del semiconductor se ha convertido en gran medida en la fábula de la economía digital, pero como he observado anteriormente, la verdad es que dos tecnologías relacionadas —el almacenamiento y la banda ancha— lo han dejado atrás en la carrera por llegar al fondo.

El primero, el almacenamiento digital, no está basado en grabar en el silicio líneas cada vez más finas, sino en lograr que partículas magnéticas permanezcan de un modo u otro sobre un disco de metal. Es la manera como funciona su ordenador personal o su iPod: una pequeña cabeza (electromagneto) con unos pocos átomos de anchura flota sobre un disco que da vueltas y traza espirales sobre ese disco, lanzando las partículas magnéticas que están debajo para que representen unos (1) o ceros (0) (ponga el número suficiente de ellos y ya tendrá ese PowerPoint en el que ha estado trabajando o el vídeo que acaba de descargar). La manera de meter más bits en un disco es hacer esas pistas más pequeñas, lo que se consigue con una cabeza más delgada pero de mayor potencia, que flote incluso más cerca de un disco hecho de partículas todavía más pequeñas y altamente magnetizadas.

Es una cuestión en gran medida de ensamblajes mecánicos con una precisión que haría enrojecer de vergüenza a un reloj suizo, además de un disco hecho de materiales ferrosos (hierro) que pueden mantener intensos campos magnéticos. Aunque el almacenamiento está basado en una física diferente de la de los semiconductores, las curvas de aprendizaje compuesto de Mead siguen imponiéndose. Realmente, esto tiene poco que ver con los efectos de los semiconductores que Moore estaba observando y, sin embargo, la capacidad de almacenamiento de datos se está incrementando (y los costes reduciéndose) más rápidamente que según la Ley de Moore. Una vez más, la relación de materia gris con un producto físico es elevada, y las innovaciones frecuentes.

El segundo, la banda ancha, deriva de otro campo de la física y de la ciencia de materiales. Enviar datos a larga distancia es fundamentalmente un asunto de fotones, no de electrones. Los interruptores ópticos convierten los bits on/off de código binario en impulsos de luz láser a diferentes frecuencias, y esas «lambdas» (la letra griega utilizada para denotar la longitud de onda) viajan en hilos de vidrio tan puros que la luz rebota contra la paredes internas durante cientos de kilómetros sin pérdida ni distorsión.

Aquí la ciencia es la óptica, no la ciencia de materiales ni la precisión mecánica. Y, sin embargo, la relación de ingredientes intelectuales con los físicos es, una vez más, elevada, de manera que se siguen produciendo innovaciones con frecuencia para reiniciar el ciclo de mejora. Siguiendo también la curva de aprendizaje compuesto de Mead, las redes de fibra óptica y la conexión óptica están mejorando incluso más deprisa que el procesamiento y el almacenamiento, con una duplicación estimada de rendimiento/precio de 1 año.

Lo que puede hacer la abundancia

La banda ancha demasiado barata para medirla nos trajo YouTube, que está revolucionando rápidamente (algunos dicen destruyendo) la industria tradicional de la televisión. El almacenamiento demasiado barato para medirlo nos trajo Gmail [correo electrónico de Google] y su infinita bandeja de entrada, por no hablar de TiVo, MySpace y, al menos a nivel del tamaño de un archivo de MP3, el iPod.

Antes del iPod, nadie pedía llevar una colección entera de música en el bolsillo. Pero los ingenieros de Apple comprendieron la economía de la abundancia de capacidad de almacenamiento. Pudieron ver que las unidades de disco estaban ganando en capacidad por el mismo precio a una velocidad más rápida aún que los procesadores informáticos. Lo que lo estaba impulsando no era la demanda de almacenar enormes catálogos de música sino la física y la ingeniería. Los ingenieros de Apple «escucharon a la tecnología», por usar la frase de Mead.

Prestaron una atención especial a un anuncio de Toshiba hecho en el año 2000 de que pronto podría hacer un disco duro de 1,8 pulgadas que podría almacenar 5 gigabytes. ¿Cuánta capacidad de almacenamiento es esa? Bueno, si hace el cálculo, es suficiente como para almacenar unas 1000 canciones en un drive más pequeño que una baraja de cartas. De modo que Apple hizo simplemente lo que la tecnología permitía y lanzó el producto. La oferta creó su propia demanda; puede que los consumidores no hubieran pensado en llevar todas sus colecciones de música con ellos, pero cuando les ofrecieron la oportunidad de hacerlo, las ventajas resultaron evidentes de manera inmediata. ¿Por qué predecir qué música vas a querer escuchar y bajarte solamente un título, cuando puedes tenerlos todos?

Ahora que este triple juego de tecnologías —procesamiento, almacenamiento y banda ancha— se han combinado para formar Internet, las abundancias se han vuelto compuestas. Uno de los chistes viejos sobre la burbuja de finales de los noventa era que sólo hay dos números en Internet: infinito y cero. El primero, al menos aplicado a las valoraciones del mercado de valores, resultó falso. Pero el segundo está vivo y en buena forma. Internet se ha convertido en la tierra de lo gratis, no por ideología sino por economía. El precio ha caído al coste marginal, y el coste marginal de todo lo que está en Internet se acerca tanto al cero que se puede redondear a esta cifra.

Así como a la industria informática le llevó decenios comprender las implicaciones de la observación de Moore, se tardará varios decenios en comprender las consecuencias compuestas de que Internet conecte el procesamiento con la banda ancha y el almacenamiento, los otros dos jinetes de la ceroesfera.

Cuando Lewis Strauss predijo que la electricidad llegaría a ser demasiado barata como para medirla, su predicción afectó hasta al último reducto de la economía. Era alucinante imaginar lo que podría aportar una abundancia semejante. Ahora la información afecta tanto a la economía como a la electricidad.

La información es la manera de fluir del dinero; aparte del dinero en efectivo en su cartera, es lo que el dinero es: simplemente bits. La información es la manera que tenemos de comunicarnos, ya que cada llamada se convierte en datos en el momento que las palabras salen de nuestros labios. Es la TV y películas que vemos y la música que escuchamos: nacieron en formato digital, y por lo tanto se transforman como todo lo demás en el mundo de los bits, cambian cómo están hechas y cómo las consumimos. Incluso la propia electricidad se está convirtiendo cada vez más en una industria de la información, tanto en el núcleo de distribución de la red como en su borde, a medida que las «redes inteligentes» convierten las redes de una dirección en interactivas, para terminar regulando la demanda y enviando y recibiendo electrones desde paneles solares y coches eléctricos.

Todo lo que tocan los bits queda también tocado por sus propiedades económicas únicas: más barato, mejor y más rápido. Fabrique una alarma digital contra robos, y ahora no será más que otro sensor y nodo de comunicaciones en Internet, con almacenamiento abundante, banda ancha y procesamiento añadidos esencialmente por nada. Es la razón de que haya tantos incentivos de convertir las cosas en digitales: pueden inmediatamente formar parte de algo más grande, algo que no sólo funciona más deprisa, sino que se acelera.

Los bits son los esteroides industriales, de la misma manera que lo era la electricidad; hacen que todo cueste menos y haga más. La diferencia es que siguen aplicando su magia de mejoras año tras año. No se trata de una transformación única como la electricidad, sino de una revolución continua en la que cada nueva generación viene a mitad de precio, con doble rendimiento y cargada de nuevas posibilidades.

Pero, ¿qué pasa con esa primera lección de la economía que dice que el precio es establecido por la oferta y la demanda, no por la ciencia? No tenga miedo, porque se sigue aplicando. La oferta y la demanda determinan el precio de cualquiera de estos artículos en cualquier momento dado. Pero las tendencias de precio a largo plazo están determinadas por la propia tecnología: cuanto más haya de un producto, más barato será. La ley de Say (llamada así por el economista francés del siglo XVIII, Jean-Baptiste Say) indica que la «oferta crea su propia demanda», que es otra forma de decir que si haces un millón de veces más transistores, el mundo encontrará un uso para ellos.

En un momento dado, el mundo puede querer un poco más o un poco menos de lo que se está fabricando en ese momento, y el precio instantáneo lo reflejará, subiendo o bajando con la oferta y la demanda. Pero, a largo plazo, la caída de los costes de producción garantiza que la tendencia general sea a la baja, con desajustes momentáneos de la oferta/demanda que introducen simplemente ondas en una línea que inevitablemente se dirige hacia el cero.

De modo que hoy toda una economía ha sido construida sobre las curvas de aprendizaje compuestas. Es algo sorprendente, ya que es una economía que se ha tardado una generación en comprender y que llevará generaciones explotarla al máximo. Pero el primer reconocimiento de sus implicaciones no vino de los economistas sino del ámbito radical de… los aficionados a los trenes en miniatura.