Capítulo 9

La máquina

Fuego y vapor

Hasta ahora, en este libro, me he preocupado casi por completo de la ciencia pura, es decir, una explicación acerca del Universo que nos rodea. Sin embargo, a través de la Historia los seres humanos han empleado las obras del Universo para aumentar su propia seguridad, comodidad y placer. Emplearon todas esas obras en un principio sin una comprensión adecuada de las mismas pero, gradualmente, llegó a dominarlas con ayuda de cuidadosas observaciones, sentido común e incluso éxitos y fracasos. Una aplicación semejante de las obras para usos humanos es la tecnología, y la misma podemos decir que es anterior a la ciencia.

No obstante, una vez la ciencia comenzó a crecer se hizo posible lograr que la tecnología avanzase a una velocidad cada vez más creciente. En los tiempos modernos, la ciencia y la tecnología han crecido tan entrelazadas (la ciencia haciendo avanzar a la tecnología mientras elucidaba las leyes de la Naturaleza, y la tecnología hace adelantar a la ciencia al producir nuevos instrumentos y mecanismos para que los empleen los científicos), que ya no nos es posible separarlas.

La primitiva tecnología

Si volvemos a los principios, consideremos que, aunque la primera ley de la termodinámica declara que la energía no puede crearse de la nada, no existe ninguna ley en contra de convertir una forma de energía en otra. Toda nuestra civilización ha sido construida para descubrir nuevas fuentes de energía y domeñarlas para usos humanos de una forma cada vez más eficiente y con medios sofisticados. En realidad, el mayor descubrimiento individual en la historia humana tiene que ver con los métodos para convertir la energía química, como por ejemplo combustibles o madera, en calor y en luz.

Fue tal vez hace medio millón de años cuando nuestros antepasados homínidos «descubrieron» el fuego mucho antes de la aparición del Homo sapiens (el hombre moderno). No cabe duda de que encontraron —y tuvieron que huir a escape— arbustos y árboles incendiados por el rayo antes de eso. Pero el descubrimiento de las virtudes del fuego no llegó hasta que la curiosidad venció al miedo.

Debió existir un momento cuando un primitivo dado —tal vez una mujer o (más probablemente aún) un niño— debió verse atraído por los tranquilos restos ardientes de semejante fuego accidental y debió divertirse jugando con él, alimentándole con palitos y observando el bailoteo de las llamas. Indudablemente, los mayores tratarían de detener un juego tan peligroso hasta que uno de ellos, más imaginativo que la mayoría, reconoció las ventajas de dominar la llama y convertir una diversión infantil en algo que empleasen los adultos. Una llama ofrecía luz en la oscuridad y calor contra el frío. También mantenía alejados a los depredadores. Llegado el momento, la gente descubrió que el fuego ablandaba los alimentos y los hacía saber mejor. (Mataba los gérmenes y los parásitos también, pero los seres humanos prehistóricos no podían saberlo.)

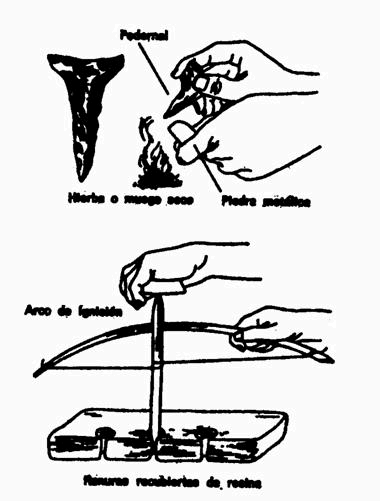

Durante centenares de millares de años, los seres humanos sólo pudieron hacer uso del fuego manteniéndolo encendido de forma constante. Si accidentalmente la llama se apagaba, aquello debía ser el equivalente de un apagón eléctrico en una sociedad moderna. Otra nueva llama debía ser conseguida de otra tribu, o había que aguardar a que un rayo hiciese ese trabajo. Fue sólo en tiempos comparativamente recientes cuando los seres humanos aprendieron a prender una llama antes de que existiese ninguna, momento en que el fuego llegó a ser verdaderamente domado (fig. 9.1). Fue el Homo sapiens quien logró esa tarea en los tiempos prehistóricos, pero no sabemos exactamente cuándo, exactamente dónde, y tal vez no lo sabremos nunca.

Fig. 9.1. Métodos primitivos para hacer fuego.

En los primeros días de la civilización, el fuego se empleó no sólo para iluminación, calor, protección y para cocinar, sino también, llegado el momento, para el aislamiento de los metales a partir de sus menas y para manejar los metales después, para la cochura de la cerámica y de los ladrillos e incluso para fabricar vidrio.

Otros importantes desarrollos fueron los heraldos del nacimiento de la civilización. Hacia el año 9000 a. de J.C., los seres humanos comenzaron a domesticar plantas y animales, comenzando las prácticas de la agricultura y de la ganadería, y de ese modo incrementaron el abastecimiento de alimentos y, respecto de los animales, encontraron una fuente directa de energía. Bueyes, asnos, camellos y hasta caballos (por no decir nada de los renos, los yaks, los búfalos de agua, las llamas y elefantes en diferentes rincones del mundo) aportaron unos músculos más potentes para llevar a cabo tareas necesarias, empleando como combustible unos alimentos demasiado burdos para que los seres humanos pudiesen comerlos.

Hacia el año 3500 a. de J.C. se inventó la rueda (posiblemente en un principio para el torno como medio de moldear la cerámica). Al cabo de algunos siglos (seguramente hacia el año 3000 a. de J.C.), las ruedas fueron situadas sobre trineos, que eran difíciles de arrastrar y que ahora podían rodar fácilmente. Las ruedas no constituyeron una fuente directa de energía, pero hicieron posible el que mucha menos energía se gastase al vencer la fricción.

Asimismo, hacia esta época, las primitivas balsas o piraguas empezaron a emplearse para permitir que la energía del agua corriente transportase cargas. Hacia tal vez el año 2000 a. de J.C., empezaron a emplearse las velas para captar el viento, por lo que los movimientos del aire aceleraron el transporte o incluso forzaban al navío a moverse contra la fuerza de las lentas corrientes. Hacia el año 1000 a. de J.C., los fenicios con sus navíos surcaron ya toda la extensión del mar Mediterráneo.

Más o menos hacia el año 50 a. de J.C., los romanos comenzaron a emplear la noria. Una rápida corriente de agua podía hacer girar una rueda que, a su vez, hacía girar otras ruedas que realizaban un trabajo: moler grano, aplastar menas, bombear agua, etc. Los molinos de viento entraron en uso en ese tiempo, unos mecanismos en que las corrientes de aire, en vez de las de agua, movían la rueda. (Las corrientes rápidas de agua son raras, pero el viento se encuentra en todas partes.) En los tiempos medievales, los molinos de viento constituyeron una fuente importante de energía en Europa occidental. Fue asimismo en los tiempos medievales cuando los seres humanos comenzaron a quemar unas piedras negras llamadas carbón en unos hornos metalúrgicos, a emplear la energía magnética para las brújulas de los navíos (que llegado el momento hicieron posible los largos viajes de exploración) y el uso de la energía química para la guerra.

El primer empleo de la energía química para la destrucción (más allá del simple empleo de flechas incendiadas) tuvo lugar hacia el año 670 d. de J.C., cuando un alquimista sirio llamado Calínico se cree que inventó el fuego griego, una primitiva bomba incendiaria compuesta de azufre y nafta, que se cree que tuvo el mérito de salvar a Constantinopla de su primer asedio por los musulmanes el años 673.

La pólvora llegó a Europa en el siglo XIII. Roger Bacon la describió hacia el año 1280, pero ya se la conocía en Asia desde muchos siglos atrás, y tal vez se introdujera en Europa con las invasiones mongólicas iniciadas el año 1240. Sea como fuere, la artillería cual arma de fuego llegó a Europa en el siglo XIV y se supone que los cañones hicieron su primera aparición en la batalla de Crécy, el año 1346.

El más importante de los inventos medievales es el atribuido al alemán Johann Gutenberg. Hacia 1450, Gutenberg creó el primer tipo movible, y, con él, hizo de la imprenta una poderosa fuerza de comunicación y propaganda. También fabricó la tinta de imprenta, en la que el negro de humo estaba disuelto en aceite de linaza y no, como hasta entonces, en agua. Esto, junto con la sustitución del pergamino por el papel (invento —según la tradición— de un eunuco chino, Ts'ai Lun, el año 50 d. de J.C., que llegó a la Europa moderna por conducto árabe en el siglo XIII), posibilitó la producción a gran escala y distribución de libros y otro material escrito. Ninguna otra invención anterior a los tiempos modernos se adoptó tan rápidamente. Una generación después del descubrimiento se habían impreso ya 40.000 libros.

Los conocimientos documentales del género humano no estuvieron ya ocultos en las colecciones reales de manuscritos, sino que fueron accesibles en las bibliotecas para todos quienes supieran leer. Los folletos crearon y dieron expresión a la opinión pública. (La imprenta tuvo una gran participación en el éxito de la revuelta de Martín Lutero contra el Papado, que, de otra forma, hubiera sido simplemente un litigio privado). Y también ha sido la imprenta, como todos sabemos, uno de los instrumentos que han hecho de la Ciencia lo que hoy es. Esta herramienta indispensable entrañaba una vasta divulgación de ideas. Hasta entonces, la Ciencia había sido un asunto de comunicaciones personales entre unos cuantos aficionados; pero, desde aquellas fechas, un campo principalísimo de actividad que alistó cada vez más trabajadores, suscitó el ensayo crítico e inmediato de las teorías y abrió sin cesar nuevas fronteras.

La máquina de vapor

La subordinación de la energía al hombre alcanzó su momento trascendental hacia fines del siglo XVII, aunque ya se habían manifestado algunos indicios tímidos en los tiempos antiguos. El inventor griego Herón de Alejandría construyó, durante los primeros siglos de la Era cristiana (no se puede siquiera situar su vida en un siglo concreto), cierto número de artificios movidos por la fuerza del vapor. Empleó la expansión del vapor para abrir puertas de templos, hacer girar esferas, etc. Él mundo antiguo, cuya decadencia se acentuaba ya por entonces, no pudo asimilar esos adelantos prematuros.

Quince siglos después, se ofreció la segunda oportunidad a una sociedad nueva en vías de vigorosa expansión. Fue producto de una necesidad cada vez más apremiante: bombear agua de las minas, cuya profundidad crecía sin cesar. La antigua bomba aspirante de mano (véase capítulo 5) empleó el vacío para elevar el agua; y, a medida que progresaba el siglo XVII, los hombres comprendieron mejor el inmenso poder del vacío (o, más bien, la fuerza que ejerce la presión del aire en el vacío).

Por ejemplo, en 1650, el físico alemán (alcalde de Magdeburgo) Otto von Guericke, inventó una bomba de aire accionada por la fuerza muscular. Montó dos hemisferios metálicos unidos por un conducto y empezó a extraer el aire de su interior con una bomba aplicada a la boquilla de un hemisferio. Cuando la presión del aire interior descendía, la presión atmosférica, falta de equilibrio, unía los hemisferios con fuerza siempre creciente. Por último, dos troncos de caballos tirando en direcciones opuestas no pudieron separar los hemisferios, pero cuando se daba otra vez entrada al aire, éstos se separaban por sí solos. Se efectuó ese experimento ante personajes muy importantes, incluyendo en cierta ocasión al propio emperador alemán. Causó gran sensación. Entonces, a varios inventores se les ocurrió una idea. ¿Por qué no usar el vapor en lugar de la fuerza muscular para crear el vacío? Suponiendo que se llenara un cilindro (o algún recipiente similar) con agua, y se la calentara hasta hacerla hervir, el vapor ejercería presión sobre el agua. Si se enfriara el recipiente —por ejemplo, haciendo caer agua fría en la superficie externa—, el vapor dentro del recipiente se condensaría en unas cuantas gotas y formaría un vacío virtual. Entonces se podría elevar el agua cuya extracción se pretendía (por ejemplo, el caso de la mina inundada), haciéndola pasar por una válvula a dicho recipiente vacío.

Un físico francés, Denis Papin, empleó la fuerza del vapor ya tan pronto como en 1679. Desarrolló un digestor de vapor en que el agua se calentaba en una vasija con una tapa fuertemente ajustada. El vapor acumulado creaba una presión que aumentaba el punto de ebullición del agua y, en su temperatura más elevada, cocinaba los alimentos de forma más rápida y mejor. La presión del vapor dentro del digestor debió dar a Papin la noción de cómo el vapor podía producir trabajo. Colocó un poco de agua en el fondo del tubo y, calentándolo, lo convirtió en vapor. Éste se expansionaba y empujaba de esta manera un pistón.

El ingeniero militar inglés Thomas Savery fue quien materializó por primera vez esa idea para aplicarla a un artificio funcional. Su «ingenio de vapor» (la palabra «ingenio» se aplicó originalmente a todo artificio mecánico) sirvió para extraer agua de minas y pozos o mover una rueda hidráulica, llamándolo él, por tal razón, El amigo del minero. Pero resultaba peligroso (porque la alta presión del vapor solía hacer reventar calderas o tuberías) y poco eficaz (porque se perdía el calor del vapor cada vez que se enfriaba el recipiente). Siete años después —en 1698—, Savery patentó su ingenio, y un herrero inglés llamado Thomas Newcomen construyó una máquina más perfecta que funcionaba a bajas presiones; tenía pistón y cilindros, empleándose la presión del aire para mover hacia abajo el pistón.

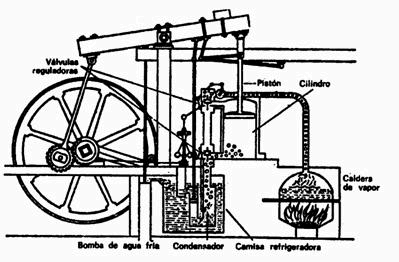

Tampoco fue muy eficiente el ingenio de Newcomen, y la máquina de vapor siguió siendo un artilugio secundario durante más de sesenta años, hasta que un mecánico de precisión escocés, llamado James Watt, ideó el medio de darle efectividad. Lo contrató la Universidad de Glasgow para diseñar un nuevo modelo del ingenio Newcomen, cuyo funcionamiento dejaba mucho que desear. Watt comenzó a cavilar sobre la pérdida inútil de combustible. ¿Por qué se creía necesario enfriar cada vez el recipiente de vapor? ¿Por qué no mantener siempre caliente la cámara de vapor y conducir éste hasta otra cámara condensadora mantenida a baja temperatura? Watt introdujo varias mejoras más: se aprovechó la presión de vapor para mover el pistón, se diseñó una serie de conexiones mecánicas para mantener en línea recta el movimiento del pistón, se enlazó este movimiento alternativo con un cigüeñal que hacía girar a una rueda, y así sucesivamente. En 1782, su máquina de vapor, rindiendo con una tonelada de carbón tres veces más que la de Newcomen, quedó lista para prestar servicio como caballo universal de fuerza (fig. 9.2).

Fig. 9.2. Máquina de vapor de Watt.

En épocas ulteriores se acrecentó sin cesar la eficiencia de la máquina de Watt, principalmente mediante la aplicación de vapor cada vez más caliente a presiones cada vez más altas. El invento de la Termodinámica por Carnot (véase capítulo 7) se debió principalmente a la percepción de que el rendimiento máximo de cualquier máquina térmica era proporcional a la diferencia de temperatura entre el depósito caldeado (vapor en los casos ordinarios) y el frío.

Así los nuevos molinos textiles construidos no habían de localizarse en o cerca de corrientes de movimiento rápido ni requerían de cuidado animal. Podían alzarse en cualquier parte. Gran Bretaña comenzó a llevar a cabo un cambio revolucionario cuando la gente que trabajaba abandonó el campo y las industrias domésticas para establecerse en las fábricas (donde las condiciones laborales resultaron increíblemente crueles y abominables hasta que la sociedad aprendió, a desgana, que la gente no debía ser tratada de un modo peor que los animales).

El mismo cambio tuvo lugar en otros países que adoptaron el nuevo sistema de la fuerza de la máquina de vapor y la Revolución industrial (un término introducido en 1837 por el economista francés Jéróme Adolphe Blanqui).

La máquina de vapor revolucionó también totalmente el transporte.

En 1787, el inventor estadounidense John Fitch construyó el primer vapor funcional, pero su aventura fue un fracaso financiero, y Fitch murió olvidado sin conocer el merecido crédito. Robert Fulton, un promotor más capacitado que él, botó en 1807 su barco de vapor, el Clermont, con tanto alarde y publicidad, que se le consideró el inventor del barco de vapor aunque, realmente, fuera el constructor de esa primera nave tanto como Watt pudiera haberlo sido de la primera máquina de vapor.

Tal vez sería preferible recordar a Fulton por sus tenaces tentativas para construir sumergibles. Sus naves submarinas no fueron prácticas, pero sí precursoras de varios proyectos modernos. Construyó una, llamada Nautilus, que, probablemente, inspiró a Julio Verne para imaginar aquel sumergible fantástico del mismo nombre en la obra Veinte mil leguas de viaje submarino, publicada el año 1870. Éste, a su vez, sirvió de inspiración para bautizar al primer submarino nuclear (véase capítulo 10).

A partir de 1830, los barcos de vapor cruzaron ya el Atlántico propulsados por hélices, una mejora considerable en comparación con las ruedas laterales de palas. Y en 1850 los veloces y bellos Yankee Clippers empezaron a arriar definitivamente sus velas para ser remplazados por vapores en todas las marinas mercantes y de guerra del mundo.

Más tarde, un ingeniero británico, Charles Algernoon Parsons (hijo de Lord Rose que había descubierto la nebulosa del Cangrejo) ideó una mejora importante de la máquina de vapor en conexión con los buques. En vez de que el vapor hiciese funcionar un pistón que, a su vez, movía una rueda, Parsons pensó en la eliminación del «intermediario», y logró una corriente de vapor dirigida directamente contra las paletas de la rueda. De este modo la rueda podría resistir más calor y mayores velocidades. En realidad, en 1884, había creado la primera turbina de vapor práctica.

En 1897, en el Jubileo de Diamantes de la reina Victoria, la armada británica estaba realizando una parada de sus buques de guerra movidos por vapor, cuando el barco de Parsons movido por sus turbinas, el Turbinia, pasó ante ellos, silenciosamente, a una velocidad de 35 nudos. En la armada británica nadie se había percatado de ello, pero fue el mejor truco publicitario que cupiese imaginar. No pasó mucho tiempo antes de que tanto los barcos mercantes como los de guerra fuesen movidos por la presión de las turbinas.

Mientras tanto, la máquina de vapor empezaba a dominar el transporte terrestre. En 1814, el inventor inglés George Stephenson —quien debió mucho a los trabajos precedentes de un ingeniero inglés, Richard Trevithick— construyó la primera locomotora funcional de vapor. El movimiento alternativo de los pistones movidos a vapor pudo hacer girar las ruedas metálicas sobre los rieles tal como había hecho girar antes las ruedas de palas en el agua. Y, allá por 1830, el fabricante americano Peter Cooper construyó la primera locomotora comercial de vapor en el hemisferio occidental.

Por primera vez en la Historia, los viajes terrestres estuvieron al mismo nivel que los marítimos, y el comercio tierra adentro pudo competir con el tráfico marítimo. En 1840, la vía férrea alcanzó el río Mississippi, y en 1869, la superficie entera de Estados Unidos quedó cubierta por una red ferroviaria.

Electricidad

Si consideramos la naturaleza de las cosas, la máquina de vapor es aplicable sólo a la producción de fuerza en gran escala y continua. No puede proporcionar eficazmente pequeños impulsos de energía, ni obedecer, con carácter intermitente, al hecho de presionar un botón: sería absurdo una «minúscula» máquina de vapor cuyo fuego se encendiera y apagara a voluntad. Pero la misma generación que presenciara el desarrollo de esa máquina, asistió también al descubrimiento de un medio para convertir la energía en la forma que acabamos de mencionar: una reserva permanente de energía, dispuesta para su entrega inmediata en cualquier lugar, y en cantidades pequeñas o grandes, oprimiendo un botón. Como es natural, dicha forma es la electricidad.

Electricidad estática

El filósofo griego Tales de Mileto (h. 600 a. de J.C.) observó que una resina fósil descubierta en las playas del Báltico, a la cual nosotros llamamos ámbar y ellos denominaban elektron, tenía la propiedad de atraer plumas, hilos o pelusa cuando se la frotaba con un trozo de piel. El inglés William Gilbert, investigador del magnetismo (véase capítulo 5) fue quien sugirió que se denominara «electricidad» a esa fuerza, nombre que recordaba la palabra griega elektron. Gilbert descubrió que, además del ámbar, otras materias, tales como el cristal, adquirían propiedades eléctricas con el frotamiento.

En 1733, el químico francés Charles-Francis de Cisternay du Fay descubrió que cuando se magnetizaban, mediante el frotamiento, dos varillas de ámbar o cristal, ambas se repelían. Y, sin embargo, una varilla de vidrio atraía a otra de ámbar igualmente electrificada. Y, si se las hacía entrar en contacto, ambas perdían su carga eléctrica. Entonces descubrió que ello evidenciaba la existencia de dos electricidades distintas: «vitrea» y «resinosa».

El erudito americano Benjamín Franklin, a quien le interesaba profundamente la electricidad, adujo que se trataba de un solo fluido. Cuando se frotaba el vidrio, la electricidad fluía hacia su interior «cargándolo positivamente»; por otra parte, cuando se frotaba el ámbar, la electricidad escapaba de él, dejándolo «cargado negativamente». Y cuando una varilla negativa establecía contacto con otra positiva, el fluido eléctrico pasaba de la positiva a la negativa hasta establecer un equilibrio neutral.

Aquello fue una deducción especulativa notablemente aguda. Si sustituimos el «fluido» de Franklin por la palabra electrón e invertimos la dirección del flujo (en realidad, los electrones fluyen del ámbar al vidrio), esa conjetura es correcta en lo esencial.

El inventor francés Jean-Théophile Desaguliers propuso, en 1740, que se llamara «conductores» a las sustancias a cuyo través circulaba libremente el fluido eléctrico (por ejemplo, los metales), y «aislantes», a aquellas a cuyo través no podían moverse libremente (por ejemplo, el vidrio y el ámbar).

Los experimentadores observaron que se podía acumular gradualmente una gran carga eléctrica en un conductor si se le aislaba con vidrio o una capa de aire para evitar la pérdida de electricidad. El artificio más espectacular de esta clase fue la «botella de Leiden». La ideó, en 1745, el profesor alemán E. Georg von Kleist, pero se le dio aplicación por primera vez en la Universidad de Leiden (Holanda), donde la construyó más tarde, independientemente, el profesor neerlandés Peter van Musschenbroek. La botella de Leiden es una muestra de lo que se llama hoy día «condensador», es decir, dos superficies conductoras separadas por una capa aislante de poco grosor, y en cuyo interior se puede almacenar cierta cantidad de carga eléctrica.

En el caso de la botella de Leiden, la carga se forma en el revestimiento de estaño alrededor del frasco, por conducto de una varilla metálica (latón), que penetra en el frasco atravesando un tapón. Cuando se toca esta botella cargada se recibe un electroshock. La botella de Leiden puede producir también una chispa. Naturalmente, cuanto mayor sea la carga de un cuerpo, tanto mayor será su tendencia a escapar. La fuerza que conduce a los electrones desde el área de máxima concentración («polo negativo») hacia el área de máxima deficiencia («polo positivo») se llama «fuerza electromotriz» (f.e.m.) o «potencial eléctrico». Si el potencial eléctrico se eleva lo suficiente, los electrones franquearán incluso el vacío aislador entre los polos negativo y positivo. Entonces cruzan el aire produciendo una chispa brillante acompañada de crepitación. El chisporroteo lo produce la radiación resultante de las colisiones entre innumerables electrones y moléculas del aire; el ruido lo origina la expansión del aire al caldearse rápidamente, seguida por la irrupción de aire más fresco en el momentáneo vacío parcial.

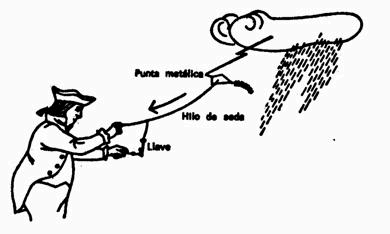

Naturalmente, muchos se preguntaron si el rayo y el trueno no serían un fenómeno similar —aunque de grandes proporciones— al pequeño espectáculo representado por la botella de Leiden. Un erudito británico, William Wall, lo sugirió así en 1708. Esta sugerencia fue un acicate suficiente para suscitar el famoso experimento de Benjamín Franklin en 1752. El cometa que lanzó en medio de una borrasca llevaba un alambre puntiagudo, al cual se unió un hilo de seda para conducir hacia abajo la electricidad de las nubes tormentosas. Cuando Franklin acercó la mano a una llave metálica unida al hilo de seda, esta soltó chispas. Franklin la cargó otra vez en las nubes, y luego la empleó para cargar las botellas de Leiden, consiguiendo así una carga idéntica a la obtenida por otros procedimientos. De esta manera, Franklin demostró que las nubes tormentosas estaban cargadas de electricidad, y que tanto el trueno como el rayo eran los efectos de una botella de Leiden celeste en la cual las nubes actuaban como un polo, y la tierra, como otro (fig. 9.3).

Fig. 9.3. Experimento de Franklin.

Lo más afortunado de este experimento —según la opinión del propio Franklin— fue que él sobrevivió a la prueba. Otros que también lo intentaron, resultaron muertos, pues la carga inducida en el alambre puntiagudo del cometa se acumuló hasta el punto de transmitir una descarga de alto voltaje al cuerpo del individuo que sujetaba la cometa.

Franklin completó en seguida esta investigación teórica con una aplicación práctica. Ideó el «pararrayos», que fue simplemente una barra de hierro situada sobre el punto más alto de una edificación y conectada con alambre a tierra; su puntiagudo extremo canalizaba las cargas eléctricas de las nubes, según demostró experimentalmente Franklin, y cuando golpeaba el rayo, la carga se deslizaba hasta el suelo sin causar daño.

Los estragos ocasionados por el rayo disminuyeron drásticamente tan pronto como esas barras se alzaron sobre los edificios de toda Europa y las colonias americanas… No fue un flaco servicio. Sin embargo, hoy siguen llegando a la tierra dos mil millones de rayos por año, matando a veinte personas y causando ochenta heridos cada día (según rezan las estadísticas).

El experimento de Franklin tuvo dos efectos electrizantes (pido perdón por el retruécano). En primer lugar, el mundo se interesó súbitamente por la electricidad. Por otra parte, las colonias americanas empezaron a contar en el aspecto cultural. Por primera vez, un americano evidenció la suficiente capacidad científica como para impresionar a los cultos europeos del enciclopedismo. Veinticinco años después, cuando, en busca de ayuda, Franklin representó a los incipientes Estados Unidos en Versalles, se ganó el respeto de todos, no sólo como enviado de una nueva República, sino también como el sabio que había domado el rayo, haciéndolo descender humildemente a la tierra. Aquel cometa volador coadyuvó no poco al triunfo de la Independencia americana.

A partir de los experimentos de Franklin, la investigación eléctrica avanzó a grandes zancadas. En 1785, el físico francés Charles-Augustin de Coulomb realizó mediciones cuantitativas de la atracción y repulsión eléctricas. Demostró que esa atracción (o repulsión) entre cargas determinadas varía en proporción inversa al cuadrado de la distancia. En tal aspecto, la atracción eléctrica se asemejaba a la atracción gravitatoria. Para conmemorar permanentemente este hallazgo, se adoptó la palabra «coulomb», o culombio, para designar una unidad práctica de cantidad de electricidad.

Poco después, el estudio de la electricidad tomó un giro nuevo, sorprendente y muy fructífero. Hasta ahora sólo hemos examinado, naturalmente, la «electricidad estática». Ésta se refiere a una carga eléctrica que se almacena en un objeto y permanece allí. El descubrimiento de la carga eléctrica móvil, de las corrientes eléctricas o la «electricidad dinámica» empezó con el anatomista italiano Luigi Galvani. En 1791, éste descubrió por casualidad, cuando hacía la disección de una rana, que las ancas se contraían si se las tocaba simultáneamente con dos metales diferentes (de aquí el verbo «galvanizar»).

Los músculos se contraían como si los hubiera estimulado una chispa eléctrica de la botella de Leiden y, por tanto, Galvani conjeturó que esos músculos contenían algo de lo que él llamaba «electricidad animal». Otros, sin embargo, sospecharon que el origen de esa carga eléctrica podría estribar en el encuentro entre dos metales más bien que en el músculo. Hacia 1800, el físico italiano Alessandro Volta estudió las combinaciones de metales desemejantes, no conectados por tejidos musculares, sino por simples soluciones.

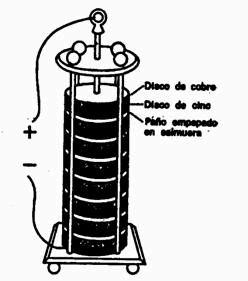

Comenzó usando cadenas de metales desemejantes enlazándolas mediante cuencos llenos a medias de agua salada. Para evitar el excesivo derramamiento de líquido, preparó pequeños discos de cobre y cinc; apilándolos alternativamente; también empleó discos de cartón humedecidos con agua salada, de modo que su «pila voltaica» estuvo integrada por placas consecutivas de plata, cartón y cinc. Así, pues, de ese dispositivo se pudo extraer continuamente corriente eléctrica.

Cabe denominar batería cualquier serie de metales similares repetidos indefinidamente. El instrumento de Volta fue la primera «batería eléctrica». Los científicos requerirían todavía un siglo para comprender por qué entrañan transferencia de electrones las reacciones químicas, y aprender a interpretar las corrientes eléctricas en términos de cambio y flujos electrónicos. Entretanto, siguieron haciendo uso de la corriente sin entender sus peculiaridades (fig. 9.4).

Fig. 9.4. Pila de Volta. Los dos metales diferentes en contacto originan un flujo de electrones que se trasladan de una celda a la siguiente por conducto de un paño empapado en salmuera. La conocida «pila seca» de nuestros días, integrada por carbón y cinc, fue una idea de Bunsen (famoso por el espectroscopio) en 1841.

Humphry Davy utilizó una corriente eléctrica para separar los átomos de moléculas muy compactas y, entre 1807 y 1808, logró por vez primera preparar metales como sodio, potasio, magnesio, calcio, estroncio y bario. Faraday (ayudante y protegido de Davy) procedió a establecer las reglas generales de esa «electrólisis» concebida para la descomposición molecular, y que, medio siglo después, orientaría a Arrhenio en el razonamiento de su hipótesis sobre la disociación iónica (véase capítulo 5).

Los numerosos empleos dados a la electricidad dinámica desde que Volta ideara su batería hace ya siglo y medio, relegaron la electricidad estática a la categoría de mera curiosidad histórica. Sin embargo, el conocimiento y la inventiva no pueden ser nunca estáticos. En 1960, el inventor estadounidense Chester Carlson perfeccionó un aparato que hacía copias utilizando el negro humo en seco, el cual pasa al papel mediante una acción electrostática. Tal sistema de efectuar copias sin soluciones ni sustancias húmedas se llama xerografía (tomado de las voces griegas que significan «escritura seca»), y ha revolucionado los sistemas de copia en las oficinas.

Los nombres de las unidades empleadas para medir los diversos tipos de electricidad han inmortalizado los nombres de los primeros investigadores. Ya he mencionado el coulomb como unidad de cantidad de electricidad. Otra unidad de cantidad es el «faraday» que equivale a 96.500 culombios. El nombre de Faraday se emplea por segunda vez para designar el «farad» (o faradio), una unidad de capacidad eléctrica. Por otra parte, la unidad de intensidad eléctrica (cantidad de corriente eléctrica que pasa a través de un circuito en un momento dado) se llama «ampére» (o amperio), para perpetuar el nombre del físico francés Ampére (véase capítulo 5). Un amperio es igual a 1 culombio/s. La unidad de fuerza electromotriz (f.e.m., la fuerza que impulsa la corriente) es el «volt» (o voltio), en recuerdo de Volta.

La fuerza electromotriz no consiguió siempre impulsar la misma cantidad de electricidad a lo largo de diferentes circuitos. Solía impulsar grandes cantidades de corriente por los buenos conductores, pequeñas cantidades por los malos conductores, y prácticamente ninguna corriente cuando los materiales no eran conductores. En 1827, el matemático alemán Georg Simón Ohm estudió esa resistencia al flujo eléctrico y demostró que se relacionaba directamente con los amperios de la corriente impulsada en un circuito por la conocida fuerza electromotriz. Se podría determinar esa resistencia estableciendo la relación entre voltios y amperios. Ésta es la «ley de Ohm», y la unidad de resistencia eléctrica es el «ohm» (u ohmio), cuyo valor equivale a 1 voltio dividido por un amperio.

Generación de electricidad

La conversión de energía química en electricidad, como ocurrió con la pila de Volta y las numerosas variedades de sus descendientes, ha resultado siempre relativamente costosa porque los productos químicos requeridos no son corrientes ni baratos. Por tal razón, y aunque la electricidad se pudo emplear provechosamente en el laboratorio durante los primeros años del siglo XVI, no tuvo aplicación industrial a gran escala.

Se hicieron tentativas esporádicas para transformar en fuente de electricidad las reacciones químicas producidas por la combustión de elementos corrientes. Ciertos combustibles como el hidrógeno (o, mejor aún, el carbón) resultaban mucho más baratos que metales cual el cobre y el cinc. Hace ya mucho tiempo, en 1839, el científico inglés William Grove concibió una célula eléctrica basada en la combinación de oxígeno e hidrógeno. Fue un ensayo interesante, pero poco práctico. En años más recientes, los físicos se han esforzado en preparar variedades funcionales de tales «células combustibles». La teoría está bien definida; sólo falta abordar los «intríngulis» de la ingeniería práctica.

Cuando, en la segunda mitad del siglo XIX, se impuso el empleo a gran escala de la electricidad, no fue por medio de la célula eléctrica. En tiempos tan distantes como la década de los 1830, Faraday había producido electricidad mediante el movimiento mecánico de un conductor entre las líneas de fuerza de un imán (fig. 9.5; véase también capítulo 5). En semejante «generador eléctrico» o «dínamo» (del griego dynamis, «fuerza») se podía transformar la energía cinética del movimiento en electricidad. Para mover la maquinaria, en 1844 se empleaban grandes versiones rudimentarias de ese generador.

Fig. 9.5. La «dinamo» de Faraday. El disco giratorio de cobre corta las líneas de fuerza de la magneto induciendo la corriente en el voltímetro.

Lo que se necesitaba era un imán más potente todavía para que el movimiento por las intensificadas líneas de fuerza produjera mayor flujo eléctrico. Y se obtuvo ese potente imán mediante el uso de corrientes eléctricas. En 1823, el experimentador electrotécnico inglés William Sturgeon arrolló dieciocho veces un alambre de cobre puro alrededor de una barra férrea en forma de U y produjo la primera «electromagneto». Cuando circulaba la corriente, el campo magnético resultante se concentraba en la barra de hierro, y entonces ésta podía levantar un peso veinte veces superior al suyo. Si se interrumpía la corriente, dejaba de ser un imán y no levantaba nada.

En 1829, el físico americano Joseph Henry perfecciono considerablemente ese artefacto usando alambre aislante. Con este material aislador resultaba posible arrollarlo en apretadas espiras sin temor de cortocircuitos. Cada espira acrecentaba la intensidad del campo magnético y el poder de electroimán. Hacia 1831, Henry construyó una electromagneto, no demasiado grande, pero capaz de levantar una tonelada de hierro.

Evidentemente, aquella electromagneto fue la respuesta justa a la búsqueda de mejores generadores eléctricos. En 1845, el físico inglés Charles Wheatstone empleó una electromagneto con el mismo propósito. La teoría respaldada por las líneas de fuerza resultó más comprensible durante la década de 1860-1870, gracias a la interpretación matemática del trabajo de Faraday por Maxwell (véase capítulo 5) y, en 1872, el ingeniero electrotécnico alemán Friedrich von Hefner-Alteneck diseñó el primer generador realmente eficaz. Por fin se pudo producir electricidad barata a raudales, y no sólo quemando combustibles, sino también con los saltos de agua.

Primeras aplicaciones de la electricidad a la tecnología

Los trabajos conducentes al empleo inicial de la electricidad en el campo tecnológico implicaron grandes merecimientos, cuya mayor parte debería corresponder a Joseph Henry. El invento del telégrafo fue la primera aplicación práctica de la electricidad, y su creador fue Henry. Éste ideó un sistema de relés que permitió transmitir la corriente eléctrica por muchos kilómetros de alambre. La potencia de una corriente decrece a ritmo bastante rápido cuando esa corriente recorre largos trechos de alambre resistente; lo que hizo Henry con sus relés fue aprovechar la señal de extinción para activar una pequeña electromagneto, cuya acción se comunicaba a un conmutador que desencadenaba nuevos impulsos en centrales eléctricas separadas entre sí con intervalos apropiados. Así, pues, se podía enviar a puntos muy distantes un mensaje consistente en impulsos eléctricos codificados. Verdaderamente, Henry concibió un telégrafo funcional.

Pero como Henry era un hombre idealista y creía que se debía compartir los conocimientos con todo el mundo, no quiso patentar su descubrimiento y, por tanto, no se llevó el crédito del invento. Ese crédito correspondió al artista (y excéntrico fanático religioso) Samuel Finley Bréese Morse. Con ayuda de Henry, ofrecida sin reservas (pero reconocida a regañadientes por el beneficiario), construyó el primer telégrafo práctico en 1844. Su principal aportación al telégrafo fue el sistema de puntos y rayas conocido en la actualidad como «código Morse».

La creación más importante de Henry en el campo de la electricidad fue el motor eléctrico. Demostró que se podía utilizar la corriente eléctrica para hacer girar una rueda, del mismo modo que el giro de una rueda podía generar corriente. Y una rueda (o motor) movida por la electricidad podía servir para activar la maquinaria. El motor era fácilmente transportable; resultaba posible hacerlo funcionar en un momento dado (sin necesidad de esperar a que se almacenase el vapor), y su tamaño podía ser tan reducido como se deseara (fig. 9.6).

Fig. 9.6. Motor de Henry. La magneto vertical D atrae a la magneto B, rodeada de alambre, empujando las largas sondas metálicas Q y R hacia los dedales de latón S y T que actúan como terminales para la celda húmeda F. La corriente fluye por el interior de la magneto horizontal, produciendo un campo electromagnético que une a A y C. Entonces se repite todo el proceso en el lado opuesto. Así, pues, la barra horizontal oscila arriba y abajo.

El único problema consistía en transportar la electricidad desde la central generadora hasta el lugar donde estaba emplazado el motor. Fue preciso idear algún medio para evitar la pérdida de energía eléctrica (en forma de calor disipado) durante el recorrido por los alambres.

Una respuesta aceptable fue el «transformador». Quienes experimentaban con corrientes descubrieron que la electricidad sufría muchas menos pérdidas cuando fluía a un ritmo lento. Así, pues, se elevó el rendimiento del generador a un alto voltaje mediante un transformador que, al multiplicar el voltaje, digamos por tres, redujo la corriente (el ritmo del flujo) a una tercera parte. En la estación receptora se podría elevar otra vez la corriente para su aplicación a los motores.

El transformador trabaja aprovechando la corriente «primaria» para inducir una corriente de alto voltaje en una bobina secundaria. Esta inducción requiere que se produzcan variaciones en el campo magnético a través de la bobina secundaria. Puesto que una corriente continua no puede hacerlo, la corriente que se emplea es de tipo variable, alcanza una tensión máxima, para descender luego hasta cero y cobrar nueva intensidad en dirección contraria, o, dicho de otra forma, «una corriente alterna».

La corriente alterna (c.a.) no se sobrepuso a la corriente continua (c.c.) sin una dura pugna. Thomas Alva Edison, el nombre más glorioso de la electricidad en las últimas décadas del siglo XIX, abogó por la c.c. y estableció la primera central generadora de c.c. en Nueva York, el año 1882, para producir la luz eléctrica que había inventado. Se opuso a la c.a. alegando que era más peligrosa (recurrió, entre otros ejemplos, a su empleo en la silla eléctrica). Le presentó batalla Nikola Tesla, un ingeniero croata que había salido malparado cuando colaboraba con Edison. Tesla ideó un sistema fructífero de c.a. en 1888. Y allá por 1893, George Westinghouse, asimismo un convencido de la c.a., ganó una victoria crucial sobre Edison obteniendo para su compañía eléctrica el contrato para construir la central eléctrica del Niágara, utilizando c.a. En décadas subsiguientes, Steinmetz asentó la teoría de las corrientes alternas sobre firmes fundamentos matemáticos. Hoy día, la c.a. es poco menos que universal en los sistemas de distribución de energía eléctrica (En 1966, ingenieros de la «General Electric» crearon un transformador de c.c. —antes considerado como imposible—, pero que supone temperaturas de helio líquido y una escasa eficiencia. Teóricamente es fascinante, pero su uso comercial es aún improbable.)

Tecnología eléctrica

La máquina de vapor es un «mecanismo motriz primario». Toma energía ya existente en la Naturaleza (la energía química de la madera, el petróleo o el carbón), para transformarla en trabajo. El motor eléctrico no lo es; convierte la electricidad en trabajo, pero la electricidad debe formarse por sí misma aprovechando la energía del combustible o el salto de agua. No obstante, se la puede emplear con idéntico fin. En la Exposición de Berlín celebrada el año 1879, una locomotora eléctrica (que utilizaba un tercer raíl como alimentador de corriente) movió fácilmente un tren de vagones. Los ferrocarriles electrificados son corrientes hoy día, en especial para el transporte rápido dentro de zonas urbanas, pues la limpieza y suavidad del sistema compensa sobradamente el gasto adicional.

El teléfono

Sin embargo, la electricidad se revela en toda su magnitud al desempeñar tareas imposibles de realizar por el vapor. Consideremos, por ejemplo, el teléfono, patentado en 1876 por el inventor de origen escocés Alexander Graham Bell. En el micrófono del teléfono, las ondas sonoras emitidas por el locutor chocan contra un sutil diafragma de acero y lo hacen vibrar con arreglo al esquema de las ondas. Las vibraciones del diafragma establecen, a su vez, un esquema análogo en la corriente eléctrica por medio de gránulos de carbón. Cuando el diafragma presiona sobre dichos gránulos, conduce más corriente; y menos, cuando se aparta el diafragma. Así, pues, la corriente eléctrica aumenta o disminuye de acuerdo con las ondas sonoras. En el teléfono receptor, las fluctuaciones de la corriente actúan sobre un electroimán, que hace vibrar el diafragma, con la consiguiente reproducción de las ondas sonoras.

Al principio, el teléfono era una cosa burda y apenas funcionaba, pero incluso así constituyó la estrella de la «Exposición del Centenario», que tuvo lugar en Filadelfia, en 1876, para celebrar el centésimo aniversario de la Declaración de Independencia de Estados Unidos. Un visitante, el emperador brasileño Pedro II, lo probó y soltó asombrado el instrumento. Su comentario fue: «¡Pero si habla!», que dio lugar a grandes titulares en los periódicos. Otro visitante, Kelvin, quedó igualmente impresionado, mientras que el gran Maxwell permaneció atónito ante que algo tan sencillo pudiese llegar a reproducir la voz humana. En 1877, la reina Victoria adquirió un teléfono y el éxito quedó ya asegurado.

También en 1877, Edison ideó una mejora esencial. Construyó un micrófono que contenía carbón en polvo no muy compacto. Cuando el diafragma se oprimía contra el carbón en polvo, el polvo conducía más corriente; cuando se separaba, el polvo conducía menos. De esta forma, las ondas sonoras de la voz eran traducidas por el micrófono en impulsos eléctricos variables con gran fidelidad, y la voz que se oía en el auricular quedaba reproducida con mejorada calidad.

Los mensajes telefónicos no podían llevarse muy lejos sin una inversión ruinosa en fuertes (y por lo tanto de baja resistencia) cables de cobre. En el cambio de siglo, el físico yugoslavonorteamericano Michael Idvorsky Pupin desarrolló un método de cargar un delgado hilo de cobre con bobinas de inductancia a ciertos intervalos. De esta forma se reforzaban las señales y era posible trasladarlas a grandes distancias. La «Bell Telephone Company» compró el mecanismo en 1901 y, hacia 1915, la telefonía a larga distancia comenzó de hecho cuando entró en funcionamiento la línea entre la ciudad de Nueva York y San Francisco.

La telefonista se convirtió en una inevitable y creciente parte de la vida durante medio siglo (invariablemente quienes manejaban los teléfonos fueron mujeres), hasta que empezó a disminuir con los principios del teléfono de dial en 1921. La automatización continuó su avance hasta 1983, cuando centenares de millares de empleados telefónicos se declararon en huelga durante un par de semanas, mientras el servicio telefónico continuaba sin interrupción. Los actuales rayos de radio y los satélites de comunicación han añadido más cosas a la versatilidad del teléfono.

Grabación de los sonidos

Allá por 1877, un año después de inventarse el teléfono, Edison patentó su «fonógrafo». En las primeras grabaciones se marcó el surco sobre papel de estaño, que servía como envoltura de un cilindro rotatorio. En 1885, el inventor americano Charles Sumner Tainter lo sustituyó por cilindros de cera; más tarde, en 1887, Emile Berliner impuso los discos revestidos de cera. En 1925 se empezó a hacer grabaciones por medio de electricidad, empleando un «micrófono» que transformaba el sonido en corriente eléctrica mimética por medio de un cristal piezoeléctrico que sustituyó el diafragma metálico; este cristal favoreció la reproducción del sonido y mejoró su calidad. En la década de 1930, el físico hungaroamericano Peter Goldmark desarrolló el disco de larga duración, que giraba a 33,5 vueltas por minuto en vez de a las 78 r.p.m. de hasta entonces. Un disco LP (larga duración) sencillo podía contener seis veces más música que uno de la antigua clase, y eso hizo posible escuchar sinfonías sin la necesidad repetida de darles la vuelta a los discos y cambiarlos.

La electrónica hizo posible la alta fidelidad (hi-fi) y el sonido estereofónico, que tuvo el efecto, en cuanto se refería al mismo sonido, de eliminar prácticamente todas las barreras mecánicas entre la orquesta o cantante y el oyente.

La «grabación magnetofónica» del sonido fue un invento llevado a cabo en 1898 por el ingeniero electrotécnico danés Valdemar Poulsen, pero hubo que introducir en el invento varias mejoras técnicas para que éste tuviera aplicación práctica. Una electromagneto, que responde a una corriente eléctrica portadora del esquema sonoro, magnetiza una fina capa de polvo metálico sobre una cinta o alambre que circula a través de ella; luego se invierte el sentido de la marcha mediante un electroimán, que recoge la huella magnética para traducirla de nuevo en la corriente que reproducirá el sonido.

La luz artificial antes de la electricidad

Entre todos los milagros de la electricidad, el más popular es, sin duda, la transformación de la noche en día. El género humano se ha defendido con hogueras, antorchas y velas contra el diario e inquietante oscurecimiento del Sol; durante milenios, la luz artificial fue mediocre y oscilante.

El siglo XIX introdujo algunos avances en esos métodos de iluminación de las viejas épocas. El aceite de ballena y luego el queroseno comenzaron a emplearse en las lámparas de aceite, con mayor brillo y eficiencia. El químico austríaco Karl Auer, barón de Welsbach, descubrió que si un cilindro de tejido, impregnado con compuestos de torio y cerio, se colocaba alrededor de la llama de una lámpara, brillaría con mayor blancura. Esto fue el manguito Welsbach, patentado en 1885 y que aumentó notablemente el brillo de las lámparas de petróleo.

A principios de siglo, la iluminación por gas fue introducida por el inventor escocés William Murdock. Hizo salir gas de carbón en chorro, para que se encendiese al salir. En 1802, celebró una paz temporal con Napoleón instalando un espectacular despliegue de luces de gas y, en 1803, de forma rutinaria instaló en las principales fábricas dicha iluminación. En 1807, algunas calles de Londres comenzaron a tener luz de gas, y la costumbre se extendió. A medida que avanzaba el siglo, las grandes ciudades fueron cada vez más luminosas por la noche, reduciendo los índices de delincuencia y ampliando la seguridad de los ciudadanos.

El químico norteamericano Robert Haré descubrió que una cálida luz de gas que se hacía pasar por un bloque de óxido de calcio (cal) producía una brillante luz blanca. Semejante luz de calcio empezó a utilizarse para iluminar grandes escenarios teatrales hasta un nivel mucho más luminoso de lo que fuera posible hasta entonces. Aunque esta técnica ya hace mucho tiempo que quedó anticuada, la gente que se encuentra en un momento de gran publicidad aún se dice que se halla «a la luz de las candilejas», en recuerdo de esa primera aplicación teatral.

Todas esas formas de iluminación, desde las hogueras hasta el chorro de gas, implican llamas al aire libre. Debía de haber algún mecanismo para encender el combustible — ya fuera madera, carbón, petróleo o gas— cuando no existía una llama en las proximidades. Antes del siglo XIX, el método menos laborioso era el empleo del pedernal y el eslabón. Al hacer chocar uno contra otro, se lograba una chispa que permitía, con suerte, encender un poco de yesca (un material finamente dividido e inflamable) con el que, a su vez, encender una candela, etc.

A principios del siglo XIX, los químicos comenzaron a idear métodos para revestir el extremo de un trozo de madera con productos químicos, que pudiesen encenderse en forma de llama cuando se elevaba la temperatura. La fricción podía hacer las veces de esto, y «frotando una cerilla» sobre una superficie rugosa se producía una llama.

Las primeras cerillas humeaban horriblemente, producían malos olores y empleaban productos químicos que eran peligrosamente venenosos. Las cerillas comenzaron a ser realmente seguras para su empleo en 1845, cuando el químico austríaco Antón Ritter von Schrotter empleó el fósforo rojo para estos propósitos. Llegado el momento se desarrollaron los fósforos de seguridad, en los que se colocaba fósforo rojo en una tira rugosa en algún lugar de la caja que contenía las cerillas, mientras que el fósforo en sí tenía en su cabeza los otros productos químicos necesarios. Ni la tira ni la cerilla podían arder espontáneamente, excepto cuando, al frotarse contra aquella tirilla, la cerilla se encendía.

Hubo también un regreso al eslabón y al pedernal, con cruciales mejoras. En lugar del eslabón se emplea mischmetal, una mezcla de metales (principalmente cerio) que, al ser frotado contra una ruedecita, emite unas chispas particularmente calientes. En lugar de la yesca se empleó un fácilmente inflamable combustible para fluido. El resultado es el encendedor para cigarrillos.

Luz eléctrica

Las llamas al aire libre son otra clase de cosa parpadeante y existe un continuo peligro de incendio. Se necesitaba algo nuevo por completo, y hacía ya mucho tiempo que se observaba que la electricidad podía originar luz. Las botellas de Leyden originaban chispas cuando se descargaban; la corriente eléctrica hacía a veces relucir los cables al pasar por los mismos. Ambos sistemas fueron utilizados para la iluminación.

En 1805, Humphry Davy forzó una descarga eléctrica a través del espacio aéreo entre conductores. Al mantener la corriente, la descarga era continua y se conseguía un arco eléctrico. A medida que la electricidad se hizo más barata, fue también posible emplear arcos eléctricos con fines de iluminación. En los años 1870, las calles de París y de otras grandes ciudades poseían semejantes lámparas. La luz era dura, parpadeante y también seguía al aire libre, lo cual constituía una vez más un peligro de incendio.

Sería mejor conseguir que una corriente eléctrica calentase un cable delgado, o filamento, hasta que empezase a brillar. Naturalmente, el filamento debería brillar en un espacio libre de oxígeno, pues si no era así, la oxidación lo destruiría al instante. Los primeros intentos para eliminar el oxígeno se redujeron al procedimiento directo de extraer el aire. En 1875, Crookes ideó cierto método (relacionado con sus experimentos sobre rayos catódicos; véase capítulo 7) para producir un vacío suficiente a tal fin, con las necesarias rapidez y economía. No obstante, los filamentos utilizados resultaron poco satisfactorios. Se rompieron con excesiva facilidad. En 1878, Thomas Edison, animado por su reciente y triunfal invento del fonógrafo, se manifestó dispuesto a abordar el problema. Tenía sólo treinta y un años por entonces, pero era tanta su reputación como inventor, que su anuncio causó verdadero revuelo en las Bolsas de Nueva York y Londres, haciendo tambalearse las acciones de las compañías de gas.

Tras centenares de experimentos y muchos fracasos, Edison encontró, al fin, un material útil como filamento: una hebra de algodón chamuscada. El 21 de octubre de 1879 encendió su lámpara. Ésta ardió sin interrupción durante cuarenta horas. En vísperas de Año Nuevo, Edison presentó sus lámparas en triunfal exhibición pública, iluminando la calle principal de Menlo Park (Nueva Jersey), donde había instalado su laboratorio. Sin pérdida de tiempo, patentó su lámpara y empezó a producirla en cantidad.

Sin embargo, Edison no fue el único inventor de la lámpara incandescente. Otro inventor, por lo menos, pudo reclamar el mismo derecho: fue el inglés Joseph Swan, quien mostró una lámpara con filamento de carbón, ante una junta de la «Newcastle-on-Tyne Chemical Society», el 18 de diciembre de 1878, si bien no logró comercializar su invento hasta 1881.

Entonces Edison abordó un problema fundamental: abastecer los hogares con cantidades constantes y suficientes de electricidad para sus lámparas, tarea que requirió mucho más ingenio que la propia invención de la lámpara. Más tarde, esta lámpara se benefició de dos mejoras. En 1910, William David Coolidge, de la «General Electric Company» eligió el tungsteno, de escasa capacidad calorífica, para fabricar los filamentos y, en 1913, Irving Laungmuir introdujo el nitrógeno de atmósfera inerte en la lámpara para evitar toda evaporación, así como la rotura del filamento, tan frecuente en el vacío (fig. 9.7).

Fig. 9.7. Lámpara incandescente.

Fig. 9.8. Lámpara Fluorescente. Una descarga de electrones desde el filamento excita el vapor mercurial den el tubo, produciendo una radiación ultravioleta. Los rayos ultravioleta hacen destellar el fósforo.

El argón (cuyo uso se generalizó en 1920) sirve a ese propósito mejor que el nitrógeno, pues su atmósfera es completamente inerte. El criptón, otro gas inerte, es más eficiente todavía porque permite que el filamento de la lámpara resista muy elevadas temperaturas y dé más densidad de luz al arder, sin que se acorte por ello su duración.

Durante medio siglo, el cristal transparente de la bombilla eléctrica tuvo como resultado que el filamento reluciese con fuerza y que resultase tan difícil de mirar como el propio Sol. Un ingeniero químico, Marvin Pipikin, ideó un método práctico de revestir el cristal de la bombilla por dentro (por el exterior tal revestimiento sólo servía para recoger polvo y para oscurecer la luz). Al fin, el empleo de bombillas esmeriladas producía una luz suave, agradable y sin parpadeos.

La llegada de la luz eléctrica podía potencialmente eliminar toda clase de llamas al aire libre para la iluminación, lo cual acarrearía que los incendios comenzasen a ser cosa del pasado. Por desgracia, siguen existiendo llamas al exterior y, probablemente, siempre las habrá: chimeneas, estufas de gas y hornos de petróleo. Algo particularmente desgraciado es el hecho de que centenares de millones de adictos aún sigan transportando llamas al aire libre en forma de cigarrillos, empleando con frecuencia, además, encendedores. La pérdida de propiedades y de vidas como resultado de los incendios provocados por cigarrillos (incendios forestales y también de maleza) resulta muy difícil de evaluar.

El filamento brillante de la bombilla eléctrica (una luz incandescente, puesto que es inducida por el calor albergado en el filamento mientras se resiste al flujo de la corriente eléctrica) no es la única forma de convertir la electricidad en luz. Por ejemplo, las llamadas luces de neón (introducidas por el químico francés Georges Claude en 1910) son tubos en los que una descarga eléctrica excita átomos de gases de neón hasta que emiten un brillante y rojo resplandor. La lámpara solar contiene vapor de mercurio, el cual, cuando se excita por medio de una descarga, consigue una radiación muy rica en luz ultravioleta, que puede emplearse no sólo para lograr un bronceado sino también para matar las bacterias o generar fluorescencia. Y esta última, a su vez, conduce a la iluminación fluorescente, introducida en su forma actual en la Feria Mundial de Nueva York del año 1939. Aquí la luz ultravioleta del vapor de mercurio excita la fluorescencia en un revestimiento fosforado en el interior del tubo (fig. 9.8). Dado que esta luz fría gasta poca energía en calor, consume menos corriente eléctrica.

Un tubo fluorescente de 40 W suministra tanta luz —aunque no tanto calor ni mucho menos— como una lámpara incandescente de 150 W. Por tanto, se ha manifestado una tendencia general hacia la luz fluorescente desde la Segunda Guerra Mundial. Cuando apareció el primer tubo fluorescente, se prefirieron las sales de berilio como materia fluorescente. Ello originó varios casos serios de envenenamiento («beriliosis»), por la aspiración de aire contaminado con esas sales o la introducción de esa sustancia en el organismo humano por los cortes de la piel producidos ocasionalmente cuando se rompían los tubos. Desde 1949 se emplearon otros fósforos menos peligrosos.

La última y más prometedora innovación es un método que convierte la electricidad directamente en luz sin la formación previa de luz ultravioleta. En 1936, el físico francés Georges Destriau descubrió que una intensa corriente alterna podía comunicar incandescencia a una sustancia fosforescente tal como el sulfato de cinc. Actualmente, los ingenieros electrotécnicos están aplicando el fósforo al plástico o cristal y utilizan el fenómeno llamado «electroluminiscencia» para formar placas incandescentes. De este modo, una pared o un techo luminiscente podría alumbrar toda una habitación con su resplandor suave y coloreado según el gusto de cada cual.

Sin embargo, la eficiencia de la electroluminiscencia sigue siendo baja para permitirla competir con otras formas de iluminación eléctrica.

Fotografía

Probablemente, ninguna invención relacionada con la luz ha proporcionado al género humano tanto placer como la fotografía. Ésta se inició con la observación de que al pasar la luz a través de un pequeño orificio a una cámara oscura, formaba una imagen difusa e invertida del escenario exterior. Un alquimista italiano, Giambattista della Porta, construyó en 1550 un artefacto similar, denominado, como se ha dicho, «cámara oscura».

En una cámara oscura penetra una cantidad mínima de luz. No obstante, si se remplaza el orificio por una lente, se concentrará una cantidad considerable de luz y, por tanto, la imagen será mucho más brillante. Una vez hecho esto, es necesario buscar alguna reacción química que responda a la luz. Varios hombres se lanzaron a esa búsqueda, destacando, entre ellos, los franceses Joseph-Nicéphore Niepce y Louis-Jacques Mande Daguerre, así como el inglés William Henry Fox Talbot.

Niepce trató de conseguir que la luz solar oscureciera el cloruro de plata en una forma apropiada y produjo la primera fotografía primitiva en 1822, que requería 8 horas de exposición.

Daguerre formó sociedad con Niepce antes de que este último muriese y continuó mejorando el proceso. Tras haber oscurecido sales de plata con luz solar, disolvió las sales sin cambiar en tiosulfato de sodio, un proceso sugerido por el científico John Herschel (el hijo de William Herschel). En 1839, Daguerre empezó a realizar daguerrotipos, las primeras fotografías prácticas, con exposiciones que no requerían más de 20 minutos.

Talbot mejoró el proceso aún más, consiguiendo negativos en los que los lugares en los que incidía la luz se oscurecían, mientras que los oscuros permanecían brillantes en los lugares en que la luz se oscurecía. A partir de tales negativos se podían conseguir numerosos positivos, en los que la luz llevaba a cabo otra inversión, por lo que los lugares luminosos seguían siendo brillantes y lo mismo pasaba con las partes oscuras, como debía ser. En 1844, Talbot publicó el primer libro ilustrado con fotografías.

La fotografía probó su valor en la documentación humana cuando, en los años 1850, los británicos fotografiaron escenas de la guerra de Crimea y cuando, en la década siguiente, el fotógrafo estadounidense Mattew, con lo que ahora consideraríamos un imposible equipo primitivo, tomó unas fotografías que se han hecho clásicas de la guerra civil americana en plena acción.

Durante casi medio siglo, la placa húmeda tuvo que seguir empleándose en fotografía. Ésta consistía en una placa de cristal, que había sido rociada con una emulsión de productos químicos que tenía que hacerse sobre la marcha. La fotografía había de realizarse antes de que la emulsión se secase. Mientras no existiese solución para esta limitación, las fotografías sólo podían hacerse por medio de profesionales habilidosos.

Sin embargo, en 1878, un inventor norteamericano, George Eastman, descubrió cómo mezclar la emulsión con gelatina, en vez de tener que rociar la placa, dejándolo secar en forma de gel que se mantuviese durante largos períodos de tiempo. En 1884 patentó la película fotográfica en la que se rociaba el gel primero sobre papel y luego, en 1889, sobre celuloide. En 1888 inventó la «Kodak», una cámara que tomaría fotografías con sólo apretar un botón. La película expuesta podía sacarse para revelarla. A partir de ese momento, la fotografía se convirtió en una afición popular. A medida que comenzaron a emplearse unas emulsiones más sensibles, las fotos empezaron a tomarse con ayuda de un destello de luz (flash) y ya no hubo necesidad de que el modelo posase durante largos períodos de tiempo con una expresión vidriosa y poco natural.

No cabía suponer que las cosas se hiciesen aún más sencillas pero, en 1947, el inventor estadounidense Edwin Herbert Land ideó una cámara con un doble rollo de película, una ordinaria película negativa y un papel positivo, con unos productos químicos sellados entre ambos. Esos productos químicos se liberaban en el momento apropiado y revelaban la impresión positiva de una forma automática. Unos minutos después de haber disparado la máquina, ya se tenía en la mano una fotografía del todo completa.

Durante el siglo XIX, las fotografías fueron en blanco y negro, no pudiendo hacerlas en color. Sin embargo, a principios del siglo XX, se desarrolló un proceso de fotografiar en color por el físico francés nacido en Luxemburgo Gabriel Lippmann, que consiguió el premio Nobel de Física en 1908. No obstante, esto se demostró que era un falso comienzo, y la fotografía en color de un modo práctico no se desarrolló hasta 1936. Este segundo, y afortunado, intento se basaba en la observación, efectuada en 1855 por Maxwell y Helmholtz, de que cualquier color en el espectro puede conseguirse con una combinación de luz roja, verde y azul. Basado en este principio, la película en color se compone de una emulsión en tres capas: una sensible al rojo, otra al verde y otra más a los componentes azules de la imagen. Se forman así tres fotos separadas pero sobreimpresas, cada una de las cuales reproducen la intensidad de la luz y su parte del espectro como una pauta de oscurecimiento en blanco y negro. La película se revelaba en tres etapas sucesivas, empleando pigmentos rojos, azules y verdes para depositar los colores apropiados sobre el negativo. Cada lugar de la foto es una combinación específica de rojo, verde y azul, y el cerebro interpreta esa combinación para reconstruir todo el abanico del color.

En 1959, Land expuso una nueva teoría sobre la visión del color. Según él, el cerebro no requiere una combinación de tres colores para dar la impresión de colorido total. Todo cuanto necesita es dos longitudes de onda diferentes (o grupos de longitudes de onda), una algo más larga que la otra. Por ejemplo, un grupo de longitudes de onda puede ser un espectro entero o luz blanca. Como su longitud de onda (promedio) está en la zona amarillo-verde, puede servir de «onda corta». Ahora bien, una imagen reproducida mediante la combinación de luces blanca y roja (esta última actuaría como onda larga), aparece a todo color. Land ha hecho también fotografías a todo color con luces verde y roja filtrada, así como otras combinaciones binarias apropiadas.

El invento del cinematógrafo se debió a una primera observación del físico inglés Peter Mark Roget, en 1824. Este científico observó que el ojo humano retiene una imagen persistente durante una fracción apreciable de segundo. Tras la introducción de la fotografía, muchos experimentadores, particularmente en Francia, aprovecharon esa propiedad para crear la ilusión de movimiento exhibiendo en rápida sucesión una serie de estampas. Todo el mundo está familiarizado con el entretenimiento consistente en un mazo de cromos que, cuando se le trashoja con rapidez, da la impresión de que una figura se mueve y realiza acrobacias. Si se proyecta sobre una pantalla, con intervalos de algunos dieciseisavos de segundo, una serie de fotografías, siendo cada una de ellas algo distinta de la anterior, la persistencia de esas imágenes sucesivas en el ojo dará lugar a enlaces sucesivos, hasta causar la impresión de movimiento continuo.

Edison fue quien produjo la primera «película cinematográfica». Fotografió una serie de escenas en una cinta y luego pasó la película por un proyector que mostró, sucesivamente, cada una con la correspondiente explosión luminosa. En 1894 se exhibió, para entretenimiento público, la primera película cinematográfica, y, en 1914, los teatros proyectaron la cinta de largometraje The Birth of a Nation (El nacimiento de una nación).

A las películas mudas se incorporó, en 1927, la banda sonora, en la cual, el sistema ondulatorio de la música y la voz del actor se transforman en una corriente eléctrica variable mediante un micrófono, y entonces esta corriente enciende una lámpara, cuya luz se fotografía también junto con la acción cinematográfica. Cuando la película acompañada de esa banda luminosa añadida en un borde se proyecta en la pantalla, las variaciones luminosas de la lámpara en el esquema de ondas sonoras se transforman de nuevo en corriente eléctrica por medio de un «tubo fotoeléctrico», y la corriente se convierte, a su vez, en sonido.

Dos años después de la primera «película sonora», El cantor de jazz, los filmes mudos pasaron a la historia, tal como le ocurriera casi al vaudeville. Hacia fines de los años 1930, se agregó el color a las «cintas habladas». Por añadidura, la década de 1950 asistió al desarrollo del sistema de visión periférica, e incluso el de efectos tridimensionales (3D), muy poco afortunado y duradero, consistente en la proyección de dos imágenes sobre la pantalla. En este último caso, el espectador debe usar gafas polarizadas para ver una imagen distinta con cada ojo, lo cual produce un efecto estereoscópico.

Máquinas de combustión interna

Aunque el petróleo dio paso a la electricidad en el campo de la iluminación artificial, resultó indispensable para otro adelanto técnico que revolucionó la vida moderna tan profundamente como cuando aparecieron los aparatos electrodomésticos. Esta innovación fue la máquina de combustión interna, llamada así porque en su interior hay un cilindro en el que se quema el combustible de tal forma que los gases mueven directamente el pistón. Por lo general, las máquinas de vapor son de «combustión externa», pues el combustible arde en sus partes exteriores y el vapor así formado pasa entonces al cilindro por diversos conductos.

El automóvil

Este artificio compacto, movido por las pequeñas explosiones provocadas dentro del cilindro, permitió aplicar la fuerza motriz a vehículos menores, para los cuales no resultaba funcional la voluminosa máquina de vapor. No obstante, ya en 1786 aparecieron «carruajes sin caballos», movidos por vapor, cuando William Murdock, un socio de James Watt, decidió construir uno de semejantes artefactos. Un siglo después, el inventor americano Francis Edgar Stanley diseñó la famosa Stanley Steamer, que hizo la competencia a los primeros carruajes provistos con motores de combustión interna. Sin embargo, el futuro pertenecía a estos últimos.

Realmente, se construyeron algunas máquinas de combustión interna a principios del siglo XIX, antes de que se generalizara el uso del petróleo. Éstas quemaron vapores de trementina o hidrógeno como combustible. Pero ese artefacto no dejó de ser una curiosidad hasta que empezó a utilizarse la gasolina, el líquido productor de vapor y, a la vez, combustible cuya explotación resulta rentable y abundante.

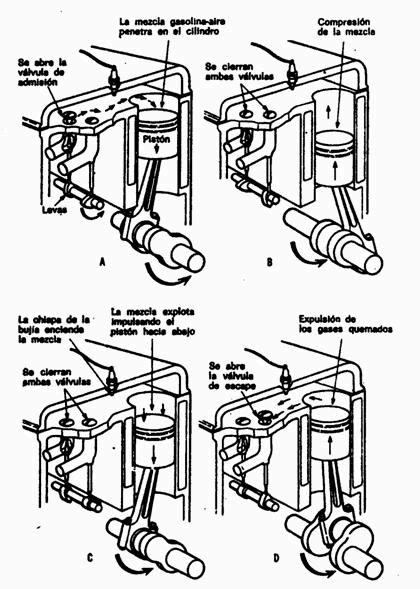

En 1860, el inventor francés Étienne Lenoir construyó el primer motor práctico de combustión interna y, en 1876, el técnico alemán Nikolaus August Otto diseñó un motor de «cuatro tiempos». Primero, un pistón ajustado perfectamente al cilindro recibe un impulso ascendente, de modo que el cilindro vacío absorbe una mezcla de gasolina y aire. Luego, ese pistón recibe un nuevo impulso y comprime el vapor. En el punto de máxima compresión, dicho vapor se enciende y explota. La explosión dispara el pistón, y este movimiento acelerado es lo que hace funcionar el motor. Mueve un árbol que empuja otra vez al pistón para hacerle expulsar los residuos quemados, o «escape»; éste es el cuarto y último movimiento del ciclo. Entonces el árbol mueve el pistón para repetir el ciclo (fig. 9.9).

Fig. 9.9. Motor de «cuatro tiempos» construido por Nikolaus Otto en 1876.

Un ingeniero escocés llamado Dugald Clerk agregó casi inmediatamente una mejora. Incorporó un segundo cilindro de forma que trabajara un pistón mientras el otro estaba en estado de recuperación: ello dio más equilibrio a la producción de fuerza. Al añadir después otros cilindros (ocho es el número más generalizado hoy día), aumentó la armonía y potencia de ese «mecanismo compensador». Un motor así resultaba esencial si los automóviles debían convertirse en una cosa práctica, pero también resultaban necesarios otros inventos auxiliares.

La ignición del compuesto gasolina-aire en el momento preciso planteó un problema. Se emplearon toda clase de ingeniosos artificios, pero en 1923 se le dio una solución general con la electricidad. El suministro proviene de una «batería acumuladora». Ésta es una batería que, como cualquier otra, provee la electricidad producida por una reacción química. Pero se la puede mantener cargada enviándole una corriente eléctrica en dirección opuesta a la de descarga; esta corriente invierte la reacción química, de modo que los productos químicos originen más electricidad. Un pequeño generador movido por el motor suministra esa corriente inversa.

El tipo más común de batería tiene placas alternas de plomo y óxido de plomo, con capas de ácido sulfúrico concentrado. Lo inventó el físico francés Gastón Planté en 1859, y fue modernizado en 1881 por el ingeniero electrotécnico americano Charles Francis Brush. Desde entonces se han inventado otras baterías más resistentes y compactas, como, por ejemplo, una batería de níquel y hierro, ideada por Edison hacia 1905, pero ninguna puede competir en economía con la batería de plomo.

Para elevar el voltaje de la corriente eléctrica facilitada por la batería se emplean transformadores denominados «carretes de inducción», y ese voltaje acrecentado proporciona la chispa de ignición que salta en los electrodos de las populares bujías.

Una vez empieza a funcionar el motor de combustión interna, la inercia lo mantiene en movimiento entre las fases de potencia. Mas, para hacerle arrancar es preciso recurrir a la energía externa. Primeramente se hizo con fuerza muscular (por ejemplo, la manivela del automóvil), y hoy día aún se ponen en marcha los motores fueraborda y las máquinas segadoras tirando de un cable. El «arranque automático» en los automóviles modernos se hace gracias a la batería, que provee la energía necesaria para los primeros movimientos del motor.

En 1885, los ingenieros alemanes Gottlieb Daimler y Karl Benz construyeron, independientemente, el primer automóvil funcional. Pero lo que en realidad vulgarizó el automóvil como medio de transporte fue la «producción en serie».

El primer promotor de esa técnica fue Eli Whitney, quien merece más crédito por ello que por su famoso invento de la máquina desmotadora de algodón. En 1789, el Gobierno Federal contrató a Whitney para la fabricación de cañones destinados al Ejército. Hasta entonces se habían fabricado esas piezas individualmente, es decir, proveyendo a cada una con sus propios y particulares elementos. Whitney ideó un medio para universalizar esos elementos, de modo que cada uno fuera aplicable a cualquier cañón. Esta innovación tan simple —fabricación en serie de piezas intercambiables para cualquier tipo de artículo— fue quizá tan influyente como otros factores importantes en la producción industrial masiva de nuestros días. Cuando apareció la maquinaria moderna, fue posible lanzar al mercado piezas de repuesto en cantidades prácticamente ilimitadas.

El ingeniero estadounidense Henry Ford fue quien por primera vez explotó a fondo este concepto. En 1892 había construido su primer automóvil (un modelo de dos cilindros) y luego, desde 1899, había trabajado como ingeniero jefe de la «Detroit Automobile Company». Esta empresa quería producir vehículos a gusto de cada cliente, pero Ford tenía otras ideas. Así, pues, dimitió en el año 1902, para emprender por su propia cuenta la producción masiva de automóviles. Siete años después lanzó el modelo Ford-T y, en 1913, empezó a fabricar tomando como pauta el plan Whitney… despachando así coche tras coche, cada uno exactamente igual al anterior y todos ellos construidos con las mismas piezas.

Ford descubrió que podría acelerar la producción empleando obreros que hicieran siempre el mismo trabajo especializado con ininterrumpida regularidad, como si fueran máquinas. Entretanto, el americano Samuel Colt (quien había inventado ya el revólver de «seis tiros»), en 1847, daba los primeros pasos en esa dirección y el fabricante de automóviles Ransom E. Olds había aplicado el mismo sistema a la fabricación del vehículo automóvil en 1900. Sin embargo, Olds perdió el apoyo financiero, y entonces las finanzas favorecieron a Ford, quien llevó adelante su movimiento hasta una feliz fructificación. Ford implantó la «cadena de montaje», en la que los operarios agregaban las piezas de su especialización a cada modelo, conforme pasaba ante ellos sobre una correa sin fin, hasta que el automóvil terminado salía rodando por el extremo final de la línea. Este nuevo sistema ofreció dos ventajas económicas: salarios elevados para el obrero, y automóviles asequibles a precios sorprendentemente bajos.

En 1913, Ford fabricaba ya mil modelos T cada día. Antes de que se «rompiera» la cadena en 1927, se habían lanzado quince millones de unidades y el precio había descendido a 290 dólares. Entonces nació la pasión por el cambio anual de coche, y Ford se adhirió al inevitable desfile de variedades e innovaciones superficiales, que decuplicaron el precio de los automóviles y privaron a los norteamericanos de las ventajas de la producción masiva.

En 1892, el ingeniero mecánico alemán Rudolf Diesel introdujo una modificación en el motor de combustión interna, que entrañó simplificaciones mecánicas y economía de combustible. Sometió a muy alta presión la mezcla de combustible-aire, de modo que el calor generado por la compresión fue suficiente para inflamarla. El «motor Diesel» permitió emplear productos destilados del petróleo difícilmente volatilizables. Como la compresión era aquí muy elevada, fue preciso construir un motor mucho más sólido y pesado que el de gasolina. Cuando, en 1920, se desarrolló un sistema adecuado de inyección de fuel-oil, éste fue adoptado sin discusión para los camiones, tractores, autobuses, barcos y locomotoras, convirtiéndose en el rey del transporte pesado.

El progresivo refinamiento de la gasolina ha incrementado la eficiencia del motor de combustión interna. La gasolina es una mezcla compleja de moléculas integrada por átomos de carbono e hidrógeno («hidrocarburos»), algunos de los cuales arden más aprisa que otros. Ahora bien, la combustión demasiado rápida no es deseable, pues entonces la mezcla gasolina-aire explota con excesiva premura, determinando el «picado del motor». La combustión más lenta induce una expansión uniforme del vapor, que propulsa el pistón con suavidad y eficacia.

Para medir el poder antidetonante de una determinada gasolina se emplea la «escala octano», es decir, se la compara con la detonación producida por un hidrocarburo llamado «isooctano», que es extremadamente antidetonante. La refinación de gasolina requiere, entre sus funciones primarias, la producción de un hidrocarburo mixto con un elevado índice de octanos.

Conforme pasa el tiempo, los motores de automóviles se construyen cada vez con mayor «compresión», es decir, que la mezcla gasolina-aire se comprime a densidades progresivamente superiores antes de la ignición. Ello permite obtener más potencia de la gasolina, pero también se estimula la detonación prematura, por lo cual hay que preparar continuamente gasolinas de más octanos. Se ha facilitado una tarea con el empleo de ciertos productos químicos que, agregados en pequeñas cantidades a la gasolina, reducen la detonación. El más eficiente de esos «compuestos antidetonantes» es el «plomo tetraetilo», un compuesto de plomo lanzado al mercado con tal finalidad en 1925. El combustible que lo contiene se llama «etilgasolina». Si el plomo tetraetilo estuviera solo, el óxido de plomo formado durante la combustión destrozaría el motor. De aquí que se agregue también bromuro etílico. El átomo de plomo en el plomo tetraetilo se combina con el átomo de bromuro en el bromuro etílico para formar bromuro de plomo, que se evapora a la temperatura de la gasolina y escapa con los gases residuales.

Los combustibles Diesel son comprobados respecto del retraso de ignición después de la compresión (un retraso demasiado grande resulta indeseable) respecto de un hidrocarburo llamado cetano, que contiene 16 átomos de carbono en su molécula en relación de las 8 que tiene el isooctano. Por lo tanto, para los combustibles Diesel se habla de número de cetano.