Capítulo 6

Los elementos

La tabla periódica

Hasta ahora me he dedicado a los cuerpos del Universo de cierta entidad: las estrellas y galaxias, el Sistema Solar y la Tierra y su atmósfera. Ahora permítaseme considerar la naturaleza de las sustancias que componen todo esto.

Primeras teorías

Los primeros filósofos griegos, cuyo método de planteamiento de la mayor parte de los problemas era teórico y especulativo, llegaron a la conclusión de que la Tierra estaba formada por unos cuantos «elementos» o sustancias básicas. Empédocles de Agrigento, alrededor del 430 a. del J.C., estableció que tales elementos eran cuatro: tierra, aire, agua y fuego. Un siglo más tarde, Aristóteles supuso que el cielo constituía un quinto elemento: el «éter». Los sucesores de los griegos en el estudio de la materia, los alquimistas medievales, aunque sumergidos en la magia y la charlatanería, llegaron a conclusiones más razonables y verosímiles que las de aquéllos, ya que por lo menos manejaron los materiales sobre los que especulaban.

Tratando de explicar las diversas propiedades de las sustancias, los alquimistas atribuyeron dichas propiedades a determinados elementos, que añadieron a la lista. Identificaron el mercurio como el elemento que confería propiedades metálicas a las sustancias, y el azufre, como el que impartía la propiedad de la combustibilidad. Uno de los últimos y mejores alquimistas, el físico suizo del siglo XVI Theophrastus Bombasí von Hohenheim —más conocido por Paracelso—, añadió la sal como el elemento que confería a los cuerpos su resistencia al calor.

Según aquellos alquimistas, una sustancia puede transformarse en otra simplemente añadiendo y sustrayendo elementos en las proporciones adecuadas. Un metal como el plomo, por ejemplo, podía transformarse en oro añadiéndole una cantidad exacta de mercurio. Durante siglos prosiguió la búsqueda de la técnica adecuada para convertir en oro un «metal base». En este proceso, los alquimistas descubrieron sustancias mucho más importantes que el oro, tales como los ácidos minerales y el fósforo.

Los ácidos minerales —nítrico, clorhídrico y, especialmente, sulfúrico— introdujeron una verdadera revolución en los experimentos de la alquimia. Estas sustancias eran ácidos mucho más fuertes que el más fuerte conocido hasta entonces (el ácido acético, o sea, el del vinagre), y con ellos podían descomponerse las sustancias, sin necesidad de emplear altas temperaturas ni recurrir a largos períodos de espera. Aún en la actualidad, los ácidos minerales, especialmente el sulfúrico, son muy importantes en la industria. Se dice incluso que el grado de industrialización de un país puede ser juzgado por su consumo anual de ácido sulfúrico.

De todas formas, pocos alquimistas se dejaron tentar por estos importantes éxitos secundarios, para desviarse de lo que ellos consideraban su búsqueda principal. Sin embargo, miembros poco escrupulosos de la profesión llegaron abiertamente a la estafa, simulando, mediante juegos de prestidigitación, producir oro, al objeto de conseguir lo que hoy llamaríamos «becas para la investigación» por parte de ricos mecenas. Este arte consiguió así tan mala reputación, que hasta la palabra «alquimista» tuvo que ser abandonada. En el siglo XVII, «alquimista» se había convertido en «químico», y «alquimia» había pasado a ser la ciencia llamada «Química».

En el brillante nacimiento de esta ciencia, uno de los primeros genios fue Robert Boyle, quien formuló la ley de los gases que hoy lleva su nombre (véase capítulo 5). En su obra El químico escéptico (The Sceptical Chymist), publicada en 1661, Boyle fue el primero en establecer el criterio moderno por el que se define un elemento: una sustancia básica que puede combinarse con otros elementos para formar «compuestos» y que, por el contrario, no puede descomponerse en una sustancia más simple, una vez aislada de un compuesto.

Sin embargo, Boyle conservaba aún cierta perspectiva medieval acerca de la naturaleza de los elementos. Por ejemplo, creía que el oro no era un elemento y que podía formarse de algún modo a partir de otros metales. Las mismas ideas compartía su contemporáneo Isaac Newton, quien dedicó gran parte de su vida a la alquimia. (En realidad, el emperador Francisco José de Austria-Hungría financió experimentos para la fabricación de oro hasta fecha tan reciente como 1867.)

Un siglo después de Boyle, los trabajos prácticos realizados por los químicos empezaron a poner de manifiesto qué sustancias podrían descomponerse en otras más simples y cuáles no podían ser descompuestas. Henry Cavendish demostró que el hidrógeno se combinaba con el oxígeno para formar agua, de modo que ésta no podía ser un elemento. Más tarde, Lavoisier descompuso el aire —que se suponía entonces un elemento— en oxígeno y nitrógeno. Se hizo evidente que ninguno de los «elementos» de los griegos eran tales según el criterio de Boyle.

En cuanto a los elementos de los alquimistas, el mercurio y el azufre resultaron serlo en el sentido de Boyle. Y también lo eran el hierro, el estaño, el plomo, el cobre, la plata, el oro y otros no metálicos, como el fósforo, el carbono y el arsénico. El «elemento» de Paracelso (la sal) fue descompuesto en dos sustancias más simples.

Desde luego, el que un elemento fuera definido como tal dependía del desarrollo alcanzado por la Química en la época. Mientras una sustancia no pudiera descomponerse con ayuda de las técnicas químicas disponibles, debía seguir siendo considerada como un elemento. Por ejemplo, la lista de 33 elementos formulada por Lavoisier incluía, entre otros, los óxidos de cal y magnesio. Pero catorce años después de la muerte de Lavoisier en la guillotina, durante la Revolución francesa, el químico inglés Humphry Davy, empleando una corriente eléctrica para escindir las sustancias, descompuso la cal en oxígeno y en un nuevo elemento, que denominó «calcio»; luego escindió el óxido de magnesio en oxígeno y otro nuevo elemento, al que dio el nombre de «magnesio».

Por otra parte, Davy demostró que el gas verde obtenido por el químico sueco Cari Wilhelm Scheele a partir del ácido clorhídrico no era un compuesto de ácido clorhídrico y oxígeno, como se había supuesto, sino un verdadero elemento, al que denominó «cloro» (del griego cloros, verde amarillento).

Teoría atómica

A principios del siglo XIX, el químico inglés John Dalton contempló los elementos desde un punto de vista totalmente nuevo. Por extraño que parezca, esta perspectiva se remonta, en cierto modo, a la época de los griegos, quienes, después de todo, contribuyeron con lo que tal vez sea el concepto simple más importante para la comprensión de la materia.

Los griegos se planteaban la cuestión de si la materia era continua o discontinua, es decir, si podía ser dividida y subdividida indefinidamente en un polvo cada vez más fino, o si, al término de este proceso se llegaría a un punto en el que las partículas fuesen indivisibles. Leucipo de Mileto y su discípulo Demócrito de Abdera insistían —en el año 450 a. de J.C.— en que la segunda hipótesis era la verdadera. Demócrito dio a estas partículas un nombre: las llamó «átomos» (o sea, «no divisibles»). Llegó incluso a sugerir que algunas sustancias estaban compuestas por diversos átomos o combinaciones de átomos, y que una sustancia podría convertirse en otra al ordenar dichos átomos de forma distinta. Si tenemos en cuenta que esto es sólo una sutil hipótesis, no podemos por menos que sorprendernos ante la exactitud de su intuición. Pese a que la idea pueda parecer hoy evidente, estaba muy lejos de serlo en la época en que Platón y Aristóteles la rechazaron.

Sin embargo, sobrevivió en las enseñanzas de Epicuro de Samos —quien escribió sus obras hacia el año 300 a. de J.C.— y en la escuela filosófica creada por él: el epicureísmo. Un importante epicúreo fue el filósofo romano Lucrecio, quien, sobre el año 60 a. de J.C., plasmó sus ideas acerca del átomo en un largo poema titulado Sobre la naturaleza de las cosas. Este poema sobrevivió a través de la Edad Media y fue uno de los primeros trabajos que se imprimieron cuando lo hizo posible el arte de Gutenberg.

La noción de los átomos nunca fue descartada por completo de las escuelas occidentales. Entre los atomistas más destacados en los inicios de la Ciencia moderna figuran el filósofo italiano Giordano Bruno y el filósofo francés Pierre Gassendi. Muchos puntos de vista científicos de Bruno no eran ortodoxos, tales como la creencia en un Universo infinito sembrado de estrellas, que serían soles lejanos, alrededor de los cuales evolucionarían planetas, y expresó temerariamente sus teorías. Fue quemado, por hereje, en 1600, lo cual hizo de él un mártir de la Ciencia en la época de la revolución científica. Los rusos han dado su nombre a un cráter de la cara oculta de la Luna.

Las teorías de Gassendi impresionaron a Boyle, cuyos experimentos, reveladores de que los gases podían ser fácilmente comprimidos y expandidos, parecían demostrar que estos gases debían de estar compuestos por partículas muy espaciadas entre sí. Por otra parte, tanto Boyle como Newton figuraron entre los atomistas más convencidos del siglo XVII.

En 1799, el químico francés Joseph Louis Proust mostró que el carbonato de cobre contenía unas proporciones definidas de peso de cobre, carbono y oxígeno y que podía prepararse. Las proporciones seguían el índice de unos pequeños números enteros: 5 a 4 y a 1. Demostró que existía una situación similar para cierto número de otros compuestos.

Esta situación podía explicarse dando por supuesto que los compuestos estaban formados por la unión de pequeños números de fragmentos de cada elemento y que sólo podían combinarse como objetos intactos. El químico inglés John Dalton señaló todo esto en 1803, y, en 1808, publicó un libro en el que se reunía la nueva información química conseguida durante el siglo y medio anterior, y que sólo tenía sentido si se suponía que la materia estaba compuesta de átomos indivisibles. (Dalton mantuvo la antigua voz griega como tributo a los pensadores de la Antigüedad.) No pasó mucho tiempo antes de que esta teoría atómica persuadiera a la mayoría de los químicos. Según Dalton, cada elemento posee una clase particular de átomo, y cualquier cantidad de elemento está compuesta de átomos idénticos de esa clase. Lo que distingue a un elemento de otro es la naturaleza de sus átomos. Y la diferencia física básica entre los átomos radica en su peso. Así, los átomos de azufre son más pesados que los de oxígeno, que, a su vez, son más pesados que los átomos de nitrógeno; éstos, a su vez también, son más pesados que los de carbono, y los mismos, más pesados que los de hidrógeno.

El químico italiano Amadeo Avogadro aplicó a los gases la teoría atómica y demostró que volúmenes iguales de un gas, fuese cual fuese su naturaleza, estaban formados por el mismo número de partículas. Es la llamada «hipótesis de Avogadro». Al principio se creyó que estas partículas eran átomos; pero luego se demostró que estaban compuestas, en la mayor parte de los casos, por pequeños grupos de átomos, llamados «moléculas». Si una molécula contiene átomos de distintas clases (como la molécula de agua, que tiene un átomo de oxígeno y dos de hidrógeno), es una molécula de un «compuesto químico». Naturalmente, era importante medir los pesos relativos de los distintos átomos, para hallar los «pesos atómicos» de los elementos. Pero los pequeños átomos se hallaban muy lejos de las posibilidades ponderables del siglo XIX. Mas, pesando la cantidad de cada elemento separado de un compuesto y haciendo deducciones a partir del comportamiento químico de los elementos, se pudieron establecer los pesos relativos de los átomos. El primero en realizar este trabajo de forma sistemática fue el químico sueco Jóns Jacob Berzelius. En 1828 publicó una lista de pesos atómicos basados en dos patrones de referencia: uno, el obtenido al dar el peso atómico del oxígeno el valor 100, y el otro, cuando el peso atómico del hidrógeno se hacía igual a 1.

El sistema de Berzelius no alcanzó inmediata aceptación; pero en 1860, en el I Congreso Internacional de Química, celebrado en Karlsruhe (Alemania), el químico italiano Stanislao Cannizzaro presentó nuevos métodos para determinar los pesos atómicos, con ayuda de la hipótesis de Avogadro, menospreciada hasta entonces. Describió sus teorías de forma tan convincente, que el mundo de la Química quedó conquistado inmediatamente. Se adoptó como unidad de medida el peso del oxígeno en vez del del hidrógeno, puesto que el oxígeno podía ser combinado más fácilmente con los diversos elementos —y tal combinación era el punto clave del método usual para determinar los pesos atómicos—. El peso atómico del oxígeno fue medido convencionalmente, en 1850, por el químico belga Jean Serváis Stas, quien lo fijó en 16, de modo que el peso atómico del hidrógeno, el elemento más ligero conocido hasta ahora, sería, aproximadamente, de 1; para ser más exactos: 1,0080.

Desde la época de Cannizzaro, los químicos han intentado determinar los pesos atómicos cada vez con mayor exactitud. Por lo que se refiere a los métodos puramente químicos, se llegó al punto culminante con los trabajos del químico norteamericano Theodore William Richards, quien, desde 1904, se dedicó a determinar los pesos atómicos con una exactitud jamás alcanzada. Por ello se le concedió el premio Nobel de Química en 1914. En virtud de los últimos descubrimientos sobre la constitución física de los átomos, las cifras de Richards han sido corregidas desde entonces y se les han dado valores aún más exactos. A lo largo del siglo XIX y pese a realizar múltiples investigaciones que implicaban la aceptación de las nociones de átomos y moléculas y a que, por lo general, los científicos estaban convencidos de su existencia, no se pudo aportar ninguna prueba directa de que fuesen algo más que simples abstracciones convenientes. Algunos destacados científicos, como el químico alemán Wilhelm Ostwald, se negaron a aceptarlos. Para él eran conceptos útiles, pero no «reales».

La existencia real de las moléculas la puso de manifiesto el «movimiento browniano», que observó por vez primera, en 1827, el botánico escocés Robert Brown, quien comprobó que los granos de polen suspendidos en el agua aparecían animados de movimientos erráticos. Al principio se creyó que ello se debía a que los granos de polen tenían vida; pero, de forma similar, se observó que también mostraban movimiento pequeñas partículas de sustancias colorantes totalmente inanimadas.

En 1863 se sugirió por vez primera que tal movimiento sería debido a un bombardeo desigual de las partículas por las moléculas de agua circundantes. En los objetos macroscópicos no tendría importancia una pequeña desigualdad en el número de moléculas que incidieran de un lado u otro. Pero en los objetos microscópicos, bombardeados quizá por sólo unos pocos centenares de moléculas por segundo, un pequeño exceso —por uno u otro lado— podría determinar una agitación perceptible. El movimiento al azar de las pequeñas partículas constituye una prueba casi visible de que el agua, y la materia en general, tiene «partículas».

Einstein elaboró un análisis teórico del movimiento browniano y demostró cómo se podía averiguar el tamaño de las moléculas de agua considerando la magnitud de los pequeños movimientos en zigzag de las partículas de colorantes. En 1908, el científico francés Jean Perrin estudió la forma en que las partículas se posaban, como sedimento, en el agua, debido a la influencia de la gravedad. A esta sedimentación se oponían las colisiones determinadas por las moléculas procedentes de niveles inferiores, de modo que el movimiento browniano se oponía a la fuerza gravitatoria. Perrin utilizó este descubrimiento para calcular el tamaño de las moléculas de agua mediante la ecuación formulada por Einstein, e incluso Oswald tuvo que ceder en su postura. Estas investigaciones le valieron a Perrin, en 1926, el premio Nobel de Física.

Así, pues, los átomos se convirtieron, de abstracciones semimísticas, en objetos casi tangibles. En realidad, hoy podemos decir que, al fin, el hombre ha logrado «ver» el átomo. Ello se consigue con el llamado «microscopio de campo iónico», inventado, en 1955, por Erwin W. Mueller, de la Universidad de Pensilvania. El aparato arranca iones de carga positiva a partir de la punta de una aguja finísima, iones que inciden contra una pantalla fluorescente, la cual da una imagen, ampliada 5 millones de veces, de la punta de la aguja. Esta imagen permite que se vea como un pequeño puntito brillante cada uno de los átomos que componen la punta. La técnica alcanzaría su máxima perfección cuando pudieran obtenerse imágenes de cada uno de los átomos por separado. En 1970, el físico americano Albert Víctor Crewe informó que había detectado átomos sueltos de uranio y torio con ayuda del microscopio electrónico.

La tabla periódica de Mendeléiev

A medida que, durante el siglo XIX, fue aumentando la lista de los elementos, los químicos empezaron a verse envueltos en una intrincada maleza. Cada elemento tenía propiedades distintas, y no daban con ninguna fórmula que permitiera ordenar aquella serie de elementos. Puesto que la Ciencia tiene como finalidad el tratar de hallar un orden en un aparente desorden, los científicos buscaron la posible existencia de caracteres semejantes en las propiedades de los elementos.

En 1862, después de haber establecido Cannizzaro el peso atómico como una de las más importantes herramientas de trabajo de la Química, un geólogo francés (Alexandre-Émile Beguyer de Chancourtois) comprobó que los elementos se podían disponer en forma de tabla por orden creciente, según su peso atómico, de forma que los de propiedades similares se hallaran en la misma columna vertical. Dos años más tarde, un químico británico (John Alexander Reina Newlands) llegó a disponerlos del mismo modo, independientemente de Beguyer. Pero ambos científicos fueron ignorados o ridiculizados. Ninguno de los dos logró ver impresas sus hipótesis. Muchos años más tarde, una vez reconocida universalmente la importancia de la tabla periódica, sus investigaciones fueron publicadas al fin. A Newlands se le concedió incluso una medalla.

El químico ruso Dmitri Ivánovich Mendeléiev fue reconocido, finalmente, como el investigador que puso orden en la selva de los elementos. En 1869, él y el químico alemán Julius Lothar Meyer propusieron tablas de los elementos que, esencialmente, se regían por las ideas de Chancourtois y Newlands. Pero Mendeléiev fue reconocido por la Ciencia, porque tuvo el valor y la confianza de llevar sus ideas más allá que los otros.

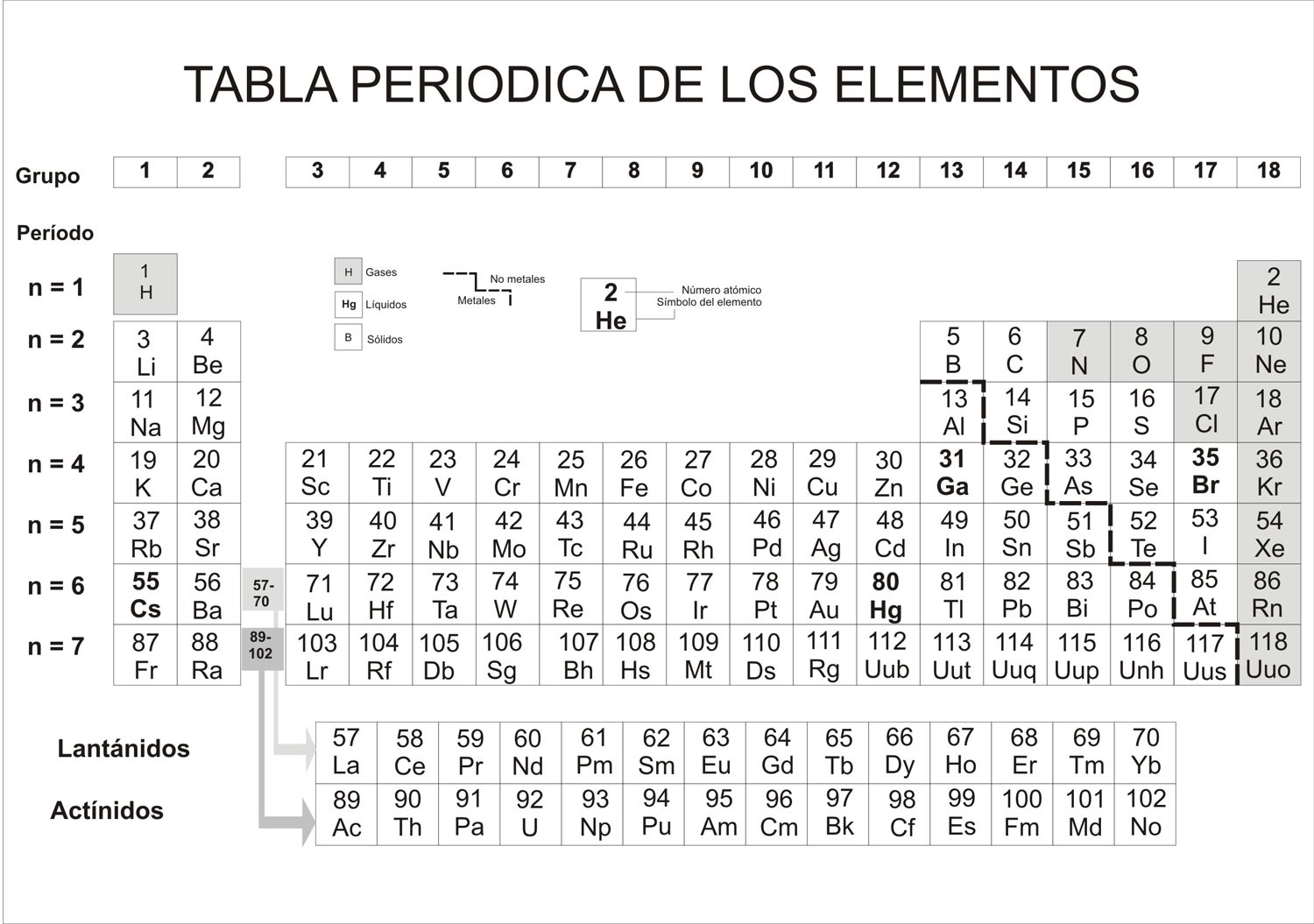

En primer lugar, la tabla periódica «de Mendeléiev» —llamada «periódica» porque demostraba la repetición periódica de propiedades químicas similares— era más complicada que la de Newlands y más parecida a la que hoy estimamos como correcta (fig. 6.1). En segundo lugar, cuando las propiedades de un elemento eran causa de que no conservara el orden establecido en función de su peso atómico, cambiaba resueltamente el orden, basándose en que las propiedades eran más importantes que el peso atómico. Se demostró que ello era correcto. Por ejemplo, el telurio, con un peso atómico de 127,60, debería estar situado, en función de los pesos, después del yodo, cuyo peso atómico es de 126,90; pero en la tabla dispuesta en columnas, cuando se coloca el telurio delante del yodo, se halla bajo el selenio, que se asemeja mucho a él, y, del mismo modo, el yodo aparece debajo de su afín, el bromo.

Fig. 6.1. Tabla periódica de los elementos.

Finalmente —y esto es lo más importante—, cuando Mendeléiev no conseguía que los elementos encajaran bien en el sistema, no vacilaba en dejar espacios vacíos en la tabla y anunciar —con lo que parecía un gran descaro— que faltaban por descubrir elementos, los cuales rellenarían los vacíos. Pero fue aún más lejos. Describió el elemento que correspondía a cada uno de tres vacíos, utilizando como guía las propiedades de los elementos situados por encima y por debajo del vacío en la tabla. Aquí, Mendeléiev mostróse genialmente intuitivo. Los tres elementos predichos fueron encontrados, ya en vida de Mendeléiev, por lo cual pudo asistir al triunfo de su sistema. En 1875, el químico francés Lecoq de Boisbaudran descubrió el primero de dichos elementos, al que denominó «galio» (del latín gallium, Francia). En 1879, el químico sueco Lars Fredrik Nilson encontró el segundo, y lo llamó «escandio» (por Escandinavia). Y en 1886, el químico alemán Clemens Alexander Winkler aisló el tercero y lo denominó «germanio» (naturalmente, por Germania). Los tres elementos mostraban casi las mismas propiedades que predijera Mendeléiev.

Números atómicos

Con el descubrimiento de los rayos X[2] se abrió una nueva Era en la historia de la tabla periódica. En 1911, el físico británico Charles Glover Barkla descubrió que cuando los rayos X se dispersaban al atravesar un metal, dichos rayos, refractados, tenían un sensible poder de penetración, que dependía de la naturaleza del metal. En otras palabras, que cada elemento producía sus «rayos X característicos». Por este descubrimiento, Barkla fue galardonado con el premio Nobel de Física en 1917.

Existían algunas dudas sobre si los rayos X eran corrientes de pequeñas partículas o consistían en radiaciones de carácter ondulatorio similares, en este sentido, a la luz. Una manera de averiguarlo era el comprobar si los rayos X podían ser difractados (es decir, forzados a cambiar de dirección) mediante un dispositivo difractante, constituido por una serie de finas líneas paralelas. Sin embargo, para una difracción adecuada, la distancia entre las líneas debe ser igual al tamaño de las ondas de la radiación. El conjunto de líneas más tupido que podía prepararse era suficiente para la luz ordinaria; pero el poder de penetración de los rayos X permitía suponer como probable —admitiendo que dichos rayos fuesen de naturaleza ondulatoria— que las ondas eran mucho más pequeñas que las de la luz. Por tanto, ningún dispositivo de difracción usual bastaba para difractar los rayos X.

Sin embargo, el físico alemán Max Theodore Félix von Laue observó que los cristales constituían una retícula de difracción natural mucho más fina que cualquiera de los fabricados por el hombre. Un cristal es un cuerpo sólido de forma claramente geométrica, cuyas caras planas se cortan en ángulos determinados, de simetría característica. Esta visible regularidad es el resultado de una ordenada disposición de los átomos que forman su estructura. Había razones para creer que el espacio entre una capa de átomos y la siguiente tenía, aproximadamente, las dimensiones de una longitud de onda de los rayos X. De ser así, los cristales difractarían los rayos X.

En sus experimentos, Laue comprobó que los rayos X que pasaban a través de un cristal eran realmente difractados y formaban una imagen sobre una placa fotográfica, que ponía de manifiesto su carácter ondulatorio. En el mismo año, el físico inglés William Lawrence Bragg y su padre, William Henry Bragg, desarrollaron un método exacto para calcular la longitud de onda de un determinado tipo de rayos X, a partir de su imagen de difracción. A la inversa, se emplearon imágenes de difracción de rayos X para determinar la orientación exacta de las capas de átomos que causaban su difracción. De este modo, los rayos X abrieron la puerta a una nueva comprensión de la estructura atómica de los cristales. Por su trabajo sobre los rayos X, Laue recibió el premio Nobel de Física en 1914, mientras que los Bragg lo compartieron en 1915.

En 1914, el joven físico inglés Henry Gwyn-Jeffreys Moseley determinó las longitudes de onda de los característicos rayos X producidos por diversos metales, e hizo el importante descubrimiento de que la longitud de onda disminuía de forma regular al avanzar en la tabla periódica.

Ello permitió situar de manera definitiva los elementos en la tabla. Si dos elementos, supuestamente adyacentes en la tabla, emitían rayos X cuyas longitudes de onda diferían en una magnitud doble de la esperada, debía de existir un vacío entre ellos, perteneciente a un elemento desconocido. Si diferían en una magnitud tres veces superior a la esperada, debían de existir entre ellos dos elementos desconocidos. Si, por otra parte, las longitudes de onda de los rayos X característicos de los dos elementos diferían sólo en el valor esperado, podía tenerse la seguridad de que no existía ningún elemento por descubrir entre los otros dos.

Por tanto, se podía dar números definitivos a los elementos. Hasta entonces había cabido siempre la posibilidad de que un nuevo descubrimiento rompiera la secuencia y trastornara cualquier sistema de numeración adoptado. Ahora ya no podían existir vacíos inesperados.

Los químicos procedieron a numerar los elementos desde el 1 (hidrógeno) hasta el 92 (uranio). Estos «números atómicos» resultaron significativos en relación con la estructura interna de los átomos (véase capítulo 7), y de una importancia más fundamental que el peso atómico. Por ejemplo, los datos proporcionados por los rayos X demostraron que Mendeléiev había tenido razón al colocar el telurio (de número atómico 52) antes del yodo (53), pese a ser mayor el peso atómico del telurio.

El nuevo sistema de Moseley demostró su valor casi inmediatamente. El químico francés Georges Urbain, tras descubrir el «lutecio» (por el nombre latino de París, Lutecia), anunció que acababa de descubrir otro elemento, al que llamó «celtio». De acuerdo con el sistema de Moseley, el lutecio era el elemento 71, y el celtio debía ser el 72. Pero cuando Moseley analizó los rayos X característicos del celtio, resultó que se trataba del mismo lutecio. El elemento 72 no fue descubierto realmente hasta 1923, cuando el físico danés Dirk Coster y el químico húngaro Georg von Hevesy lo detectaron en un laboratorio de Copenhague. Lo denominaron «hafnio», por el nombre latinizado de Copenhague.

Pero Moseley no pudo comprobar la exactitud de su método, pues había muerto en Gallípoli, en 1915, a los veintiocho años de edad. Fue uno de los cerebros más valiosos perdidos en la Primera Guerra Mundial. Ello le privó también, sin duda, del premio Nobel. El físico sueco Karl Manne George Siegbahn amplió el trabajo de Moseley, al descubrir nuevas series de rayos X y determinar con exactitud el espectro de rayos X de los distintos elementos. En 1924 fue recompensado con el premio Nobel de Física.

En 1925, Walter Noddack, Ida Tacke y Otto Berg, de Alemania, llenaron otro vacío en la tabla periódica. Después de treinta años de investigar los minerales que contenían elementos relacionados con el que estaban buscando, descubrieron el elemento 75, al que dieron el nombre de «renio», en honor al río Rin. De este modo se reducían a cuatro los espacios vacíos: correspondían a los elementos 43, 61, 85 y 87.

Fueron necesarias dos décadas para encontrarlos. A pesar de que los químicos de entonces no se percataron de ello, habían hallado el último de los elementos estables. Los que faltaban eran especies inestables tan raras hoy en la Tierra, que todas menos una tuvieron que ser creadas en el laboratorio para identificarlas. Y este descubrimiento va asociado a una historia.

Elementos radiactivos

Identificación de los elementos

Tras el descubrimiento de los rayos X, muchos científicos se sintieron impulsados a investigar estas nuevas radiaciones, tan espectacularmente penetrantes. Uno de ellos fue el físico francés Antoine-Henry Becquerel. El padre de Henry, Alexandre Edmond (el físico que fotografío por vez primera el espectro solar), se había mostrado especialmente interesado en la «fluorescencia», o sea, la radiación visible emitida por sustancias después de ser expuestas a los rayos ultravioletas de la luz solar.

Becquerel padre había estudiado, en particular, una sustancia fluorescente llamada sulfato de uranilo potásico (compuesto formado por moléculas, cada una de las cuales contiene un átomo de uranio). Henry se preguntó si las radiaciones fluorescentes del sulfato de uranilo potásico contenían rayos X. La forma de averiguarlo consistía en exponer el sulfato al Sol (cuya luz ultravioleta estimularía la fluorescencia), mientras el compuesto permanecía sobre una placa fotográfica envuelta en papel negro. Puesto que la luz solar no podía penetrar a través del papel negro, no afectaría a la placa; pero si la fluorescencia producida por el estímulo de la luz solar contenía rayos X, estos penetrarían a través del papel e impresionarían la placa. Becquerel realizó con éxito su experimento en 1896. Aparentemente, había rayos X en la fluorescencia. Becquerel logró incluso que los supuestos rayos X pasasen a través de delgadas láminas de aluminio y cobre, y los resultados parecieron confirmar definitivamente su hipótesis, puesto que no se conocía radiación alguna, excepto la de los rayos X, que pudiese hacerlo.

Pero entonces —lo cual fue una suerte— el Sol quedó oculto por densos nubarrones. Mientras esperaba que se disiparan las nubes, Becquerel retiró las placas fotográficas, con los trocitos de sulfato sobre ellas, y las puso en un secador. Al cabo de unos días, impaciente, decidió a toda costa revelar las placas, en la creencia de que, incluso sin la luz solar directa, se podía haber producido alguna pequeña cantidad de rayos X. Cuando vio las placas impresionadas, Becquerel vivió uno de esos momentos de profunda sorpresa y felicidad que son los sueños de todos los científicos. La placa fotográfica estaba muy oscurecida por una intensa radiación. La causa no podía ser la fluorescencia ni la luz solar. Bequerel llegó a la conclusión —y los experimentos lo confirmarían muy pronto— de que esta causa era el propio uranio contenido en el sulfato de uranilo potásico.

Este descubrimiento impresionó profundamente a los científicos, excitados aún por el reciente hallazgo de los rayos X. Uno de los científicos que se puso inmediatamente a investigar la extraña radiación del uranio fue una joven química, nacida en Polonia y llamada Marie Sklodowska, que el año anterior había contraído matrimonio con Pierre Curie, el descubridor de la temperatura que lleva su nombre (véase capítulo 5).

Pierre Curie, en colaboración con su hermano Jacques, había descubierto que ciertos cristales, sometidos a presión, desarrollaban una carga eléctrica positiva en un lado y negativa en el otro. Este fenómeno se denomina «piezoelectricidad» (de la voz griega que significa «comprimir»). Marie Curie decidió medir, con ayuda de la piezoelectricidad, la radiación emitida por el uranio. Instaló un dispositivo, al que fluiría una corriente cuando la radiación ionizase el aire entre dos electrodos; y la potencia de esta pequeña corriente podría medirse por la cantidad de presión que debía ejercerse sobre un cristal para producir una corriente contraria que la anulase. Este método se mostró tan efectivo, que Pierre Curie abandonó en seguida su trabajo, y durante el resto de su vida, junto con Marie, se dedicó a investigar ávidamente en este campo.

Marie Curie fue la que propuso el término de «radiactividad» para describir la capacidad que tiene el uranio de emitir radiaciones, y la que consiguió demostrar el fenómeno en una segunda sustancia radiactiva: el torio. En rápida sucesión, otros científicos hicieron descubrimientos de trascendental importancia. Las radiaciones de las sustancias radiactivas se mostraron más penetrantes y de mayor energía que los rayos X; hoy se llaman «rayos gamma». Se descubrió que los elementos radiactivos emitían también otros tipos de radiación, lo cual condujo a descubrimientos sobre la estructura interna del átomo. Pero esto lo veremos en el capítulo 7. Lo que nos interesa destacar aquí es el descubrimiento de que los elementos radiactivos, al emitir la radiación, se transformaban en otros elementos (o sea, era una versión moderna de la transmutación).

Marie Curie descubrió, aunque de forma accidental, las implicaciones de este fenómeno. Cuando ensayaba la pechblenda en busca de su contenido de uranio, al objeto de comprobar si las muestras de la mena tenían el uranio suficiente para hacer rentable la labor del refinado, ella y su marido descubrieron, con sorpresa, que algunos de los fragmentos tenían más radiactividad de la esperada, aunque estuviesen hechos de uranio puro. Ello significaba que en la pechblenda habían de hallarse otros elementos radiactivos, aunque sólo en pequeñas cantidades (oligoelementos), puesto que el análisis químico usual no los detectaba; pero, al mismo tiempo, debían ser muy radiactivos.

Entusiasmados, los Curie adquirieron toneladas de pechblenda, construyeron un pequeño laboratorio en un cobertizo y, en condiciones realmente primitivas, procedieron a desmenuzar la pesada y negra mena, en busca de los nuevos elementos. En julio de 1898 habían conseguido aislar un polvo negro 400 veces más radiactivo que la cantidad equivalente de uranio.

Este polvo contenía un nuevo elemento, de propiedades químicas parecidas a las del telurio, por lo cual debía colocarse bajo este en la tabla periódica. (Más tarde se le dio el número atómico 84.) Los Curie lo denominaron «polonio», en honor al país natal de Marie.

Pero el polonio justificaba sólo una parte de la radiactividad. Siguieron nuevos trabajos, y en diciembre de 1898, los Curie habían obtenido un preparado que era incluso más radiactivo que el polonio. Contenía otro elemento, de propiedades parecidas a las del bario (y, eventualmente, se puso debajo de éste, con el número atómico 88). Los Curie lo llamaron «radio», debido a su intensa radiactividad.

Siguieron trabajando durante cuatro años más, para obtener una cantidad de radio puro que pudiese apreciarse a simple vista. En 1903, Marie Curie presentó un resumen de su trabajo como tesis doctoral. Tal vez sea la mejor tesis de la historia de la Ciencia. Ello le supuso no sólo uno, sino dos premios Nobel. Marie y su marido, junto con Becquerel, recibieron, en 1903, el de Física, por sus estudios sobre la radiactividad, y, en 1911, Marie —su marido había muerto en 1906, en accidente de circulación— fue galardonada con el de Química por el descubrimiento del polonio y el radio.

El polonio y el radio son mucho más inestables que el uranio y el torio, lo cual es otra forma de decir que son mucho más radiactivos. En cada segundo se desintegra mayor número de sus átomos. Sus vidas son tan cortas, que prácticamente todo el polonio y el radio del Universo deberían haber desaparecido en un millón de años. Por tanto, ¿cómo seguimos encontrándolo en un planeta que tiene miles de millones de años de edad? La respuesta es que el radio y el polonio se van formando continuamente en el curso de la desintegración del uranio y el torio, para acabar por transformarse en plomo. Dondequiera que se hallen el uranio y el torio, se encuentran siempre indicios de polonio y radio. Son productos intermedios en el camino que conduce al plomo como producto final.

El detenido análisis de la pechblenda y las investigaciones de las sustancias radiactivas permitieron descubrir otros tres elementos inestables en el camino que va del uranio y el torio hasta el plomo. En 1899, André-Louis Debierne, siguiendo el consejo de los Curie, buscó otros elementos en la pechblenda y descubrió uno, al que denominó «actinio» (de la voz griega que significa «rayo»); se le dio el número atómico 89. Al año siguiente, el físico alemán Friedrich Ernst Dorn demostró que el radio, al desintegrarse, formaba un elemento gaseoso. ¡Un gas radiactivo era algo realmente nuevo! El elemento fue denominado «radón» (de radio y argón, su afín químico), y se le dio el número atómico 86. Finalmente, en 1917, dos grupos distintos —Otto Hahn y Lise Meitner, en Alemania, y Frederick Soddy y John A. Cranston, en Inglaterra— aislaron, a partir de la pechblenda, el elemento 91, denominado protactinio.

El hallazgo de los elementos perdidos

Por tanto, en 1925 había 88 elementos identificados: 81 estables, y 7, inestables. Se hizo más acuciante la búsqueda de los cuatro que aún faltaban: los números 43, 61, 85 y 87.

Puesto que entre los elementos conocidos había una serie radiactiva —los números 84 al 92—, podía esperarse que también lo fueran el 85 y el 87. Por otra parte, el 43 y el 61 estaban rodeados por elementos estables, y no parecía haber razón alguna para sospechar que no fueran, a su vez, estables. Por tanto, deberían de encontrarse en la Naturaleza.

Respecto al elemento 43, situado inmediatamente encima del reino en la tabla periódica, se esperaba que tuviese propiedades similares y que se encontrase en las mismas menas. De hecho, el equipo de Noddack, Tacke y Berg, que había descubierto el renio, estaba seguro de haber dado también con rayos X de una longitud de onda que debían de corresponder al elemento 43. Así, pues, anunciaron su descubrimiento, y lo denominaron «masurio» (por el nombre de una región de la Prusia Oriental). Sin embargo, su identificación no fue confirmada, y, en Ciencia, un descubrimiento no se considera como tal hasta que haya sido confirmado, como mínimo, por un investigador independiente.

En 1926, dos químicos de la Universidad de Illinois anunciaron que habían encontrado el elemento 61 en menas que contenían los elementos vecinos (60 y 62), y lo llamaron «illinio». El mismo año, dos químicos italianos de la Universidad de Florencia creyeron haber aislado el mismo elemento, que bautizaron con el nombre de «florencio». Pero el trabajo de ambos grupos no pudo ser confirmado por ningún otro.

Años más tarde, un físico del Instituto Politécnico de Alabama, utilizando un nuevo método analítico de su invención, informó haber encontrado indicios de los elementos 87 y 85, a los que llamó «virginio» y «alabaminio», en honor, respectivamente, de sus Estados natal y de adopción. Pero tampoco pudieron ser confirmados estos descubrimientos.

Los acontecimientos demostrarían que, en realidad, no se habían descubierto los elementos 43, 61, 85 y 87.

El primero en ser identificado con toda seguridad fue el elemento 43. El físico estadounidense Ernest Orlando Lawrence —quien más tarde recibiría el premio Nobel de Física como inventor del ciclotrón (véase capítulo 7)— obtuvo el elemento en su acelerador mediante el bombardeo de molibdeno (elemento 42) con partículas a alta velocidad. El material bombardeado mostraba radiactividad, y Lawrence lo remitió al químico italiano Emilio Gino Segré —quien estaba interesado en el elemento 43— para que lo analizase. Segré y su colega C. Perrier, tras separar la parte radiactiva del molibdeno, descubrieron que se parecía al renio en sus propiedades. Y decidieron que sólo podía ser el elemento 43, elemento que contrariamente a sus vecinos de la tabla periódica, era radiactivo. Al no ser producidos por desintegración de un elemento de mayor número atómico, apenas quedan indicios del mismo en la corteza terrestre, por lo cual, Noddack y su equipo estaban equivocados al creer que lo habían hallado. Segré y Perrier tuvieron el honor de bautizar el elemento 43; lo llamaron «tecnecio», tomado de la voz griega que significa «artificial», porque éste era el primer elemento fabricado por el hombre. Hacia 1960 se había acumulado ya el tecnecio suficiente para determinar su punto de fusión: cercano a los 2.200 °C. (Segré recibió posteriormente el premio Nobel por otro descubrimiento, relacionado también con materia creada por el hombre [véase capítulo 7].)

Finalmente, en 1939, se descubrió en la Naturaleza el elemento 87. La química francesa Marguerite Perey lo aisló entre los productos de desintegración del uranio. Se encontraba en cantidades muy pequeñas, y sólo los avances técnicos permitieron encontrarlo donde antes había pasado inadvertido. Dio al nuevo elemento el nombre de «francio», en honor de su país natal.

El elemento 85, al igual que el tecnecio, fue producido en el ciclotrón bombardeando bismuto (elemento 83). En 1940, Segré, Dale Raymond Corson y K. R. MacKenzie aislaron el elemento 85 en la Universidad de California, ya que Segré había emigrado de Italia a Estados Unidos. La Segunda Guerra Mundial interrumpió su trabajo sobre este elemento; pero, una vez acabada la contienda, el equipo reanudó su labor, y, en 1947, propuso para el elemento el nombre de «astato» (de la palabra griega que significa «inestable»). (Para entonces se habían encontrado en la Naturaleza pequeños restos de astato, como en el caso del francio, entre los productos de desintegración del uranio.)

Mientras tanto, el cuarto y último elemento de los que faltaban por descubrir (el 61) se había hallado entre los productos de fisión del uranio, proceso que explicamos en el capítulo 10. (También el tecnecio se encontró entre estos productos.) En 1945, tres químicos del Oak Ridge National Laboratory —J. A. Marinsky, L. E. Glendenin y Charles Dubois Coryell— aislaron el elemento 61. Lo denominaron «promecio» (promethium, voz inspirada en el nombre del dios Prometeo, que había robado su fuego al Sol para entregarlo a la Humanidad). Después de todo, el elemento 61 había sido «robado» a partir de los fuegos casi solares del horno atómico.

De este modo se completó la lista de los elementos, del 1 al 92. Sin embargo, en cierto sentido, la parte más extraña de la aventura acababa sólo de empezar. Porque los científicos habían rebasado los límites de la tabla periódica; el uranio no era el fin.

Elementos transuránidos

Ya en 1934 había empezado la búsqueda de los elementos situados más allá del uranio, o sea, los elementos «transuránidos». En Italia, Enrico Fermi comprobó que cuando bombardeaba un elemento con una partícula subatómica, recientemente descubierta, llamada «neutrón» (véase capítulo 7), ésta transformaba a menudo el elemento en el de número atómico superior más próximo. ¿Era posible que el uranio se transformase en el elemento 93, completamente sintético, que no existía en la Naturaleza? El equipo de Fermi procedió a bombardear el uranio con neutrones y obtuvo un producto que, al parecer, era realmente el elemento 93. Se le dio el nombre de «uranio X».

En 1938, Fermi recibió el premio Nobel de Física por sus estudios sobre el bombardeo con neutrones. Por aquella fecha, ni siquiera podía sospecharse la naturaleza real de su descubrimiento, ni sus consecuencias para la Humanidad. Al igual que Cristóbal Colón, había encontrado, no lo que estaba buscando, sino algo mucho más valioso, pero de cuya importancia no podía percatarse.

Basta decir, por ahora, que, tras seguir una serie de pistas que no condujeron a ninguna parte, descubrióse, al fin, que lo que Fermi había conseguido no era la creación de un nuevo elemento, sino la escisión del átomo de uranio en dos partes casi iguales. Cuando, en 1940, los físicos abordaron de nuevo el estudio de este proceso, el elemento 93 surgió como un resultado casi fortuito de sus experimentos. En la mezcla de elementos que determinaba el bombardeo del uranio por medio de neutrones, aparecía uno que, de principio, resistió todo intento de identificación. Entonces, Edwin Mc-Millan, de la Universidad de California, sugirió que quizá los neutrones liberados por fisión hubiesen convertido algunos de los átomos de uranio en un elemento de número atómico más alto, como Fermi había esperado que ocurriese. McMillan y Philip Abelson, un fisicoquímico, probaron que el elemento no identificado era, en realidad, el número 93. La prueba de su existencia la daba la naturaleza de su radiactividad, lo mismo que ocurriría en todos los descubrimientos subsiguientes.

McMillan sospechaba que pudiera estar mezclado con el número 93 otro elemento transuránido. El químico Glenn Theodore Seaborg y sus colaboradores Arthur Charles Wahl y J. W. Kennedy no tardaron en demostrar que McMillan tenía razón y que dicho elemento era el número 94.

De la misma forma que el uranio —elemento que se suponía el último de la tabla periódica— tomó su nombre de Urano, el planeta recientemente descubierto a la razón, los elementos 93 y 94 fueron bautizados, respectivamente, como «neptuno» y «plutonio», por Neptuno y Plutón, planetas descubiertos después de Urano. Y resultó que existía en la Naturaleza, pues más tarde se encontraron indicios de los mismos en menas de uranio. Así, pues, el uranio no era el elemento natural de mayor peso atómico.

Seaborg y un grupo de investigadores de la Universidad de California —entre los cuales destacaba Albert Ghiorso— siguieron obteniendo, uno tras otro, nuevos elementos transuránidos. Bombardeando plutonio con partículas subatómicas, crearon, en 1944, los elementos 95 y 96, que recibieron, respectivamente, los nombres de «americio» (por América) y «curio» (en honor de los Curie). Una vez obtenida una cantidad suficiente de americio y curio, bombardearon estos elementos y lograron obtener, en 1949, el número 97, y, en 1950, el 98. Estos nuevos elementos fueron llamados «berkelio» y «californio» (por Berkeley y California). En 1951, Seaborg y McMillan compartieron el premio Nobel de Química por esta serie de descubrimientos.

El descubrimiento de los siguientes elementos fue el resultado de unas investigaciones y pruebas menos pacíficas. Los elementos 99 y 100 surgieron en la primera explosión de una bomba de hidrógeno, la cual se llevó a cabo en el Pacífico, en noviembre de 1952. Aunque la existencia de ambos fue detectada en los restos de la explosión, no se confirmó ni se les dio nombres hasta después de que el grupo de investigadores de la Universidad de California obtuvo en su laboratorio, en 1955, pequeñas cantidades de ambos. Fueron denominados, respectivamente, «einstenio» y «fermio», en honor de Albert Einstein y Enrico Fermi, ambos, muertos unos meses antes. Después, los investigadores bombardearon una pequeña cantidad de «einstenio» y obtuvieron el elemento 101, al que denominaron «mendelevio», por Mendeléiev.

El paso siguiente llegó a través de la colaboración entre California y el Instituto Nobel de Suecia. Dicho instituto llevó a cabo un tipo muy complicado de bombardeo que produjo, aparentemente, una pequeña cantidad del elemento 102. Fue llamado «nobelio», en honor del Instituto; pero el experimento no ha sido confirmado. Se había obtenido con métodos distintos de los descritos por el primer grupo de investigadores. Mas, pese a que el «nobelio» no ha sido oficialmente aceptado como el nombre del elemento, no se ha propuesto ninguna otra denominación.

En 1961 se detectaron algunos átomos del elemento 103 en la Universidad de California, a los cuales se les dio el nombre de «laurencio» (por E. O. Lawrence, que había fallecido recientemente). En 1964, un grupo de científicos soviéticos, bajo la dirección de Georguéi Nikoláievich Flerov, informó sobre la obtención del elemento 104, y en 1965, sobre la del 105. En ambos casos, los métodos usados para formar los elementos no pudieron ser confirmados. El equipo americano dirigido por Albert Ghioso obtuvo también dichos elementos, independientemente de los soviéticos. Entonces se planteó la discusión acerca de la prioridad; ambos grupos reclamaban el derecho a dar nombre a los nuevos elementos. El grupo soviético llamó al elemento 104 «kurchatovio», en honor de Igor Vasilievich Kurchatov, el cual había dirigido al equipo soviético que desarrolló la bomba atómica rusa, y que murió en 1960. Por su parte, el grupo americano dio al elemento 104 el nombre de «rutherfordio», y al 105 el de «hahnio», en honor, respectivamente, de Ernest Rutherford y Otto Hahn, los cuales dieron las claves para los descubrimientos de la estructura subatómica.

Elementos superpesados

Cada paso en esta ascensión de la escala transuránida fue más difícil que el anterior. En cada estadio sucesivo, el elemento se hizo más difícil de acumular y más inestable. Cuando se llegó al mendelevio, la identificación tuvo que hacerse sobre la base de diecisiete átomos, y no más. Afortunadamente, las técnicas de detección de la radiación se mejoraron maravillosamente en 1955. Los científicos de Berkeley conectaban sus instrumentos a un avisador, con lo que, cada vez que se formaba un átomo de mendelevio, la radiación característica emitida quedaba anunciada por un grave y triunfante avisador de incendios. (De todos modos, el Departamento de extinción de incendios lo prohibió pronto…)

Los elementos superiores fueron detectados incluso en las condiciones más rarificadas. Un solo átomo de un elemento deseado puede detectarse al observar en detalle los productos de su desintegración.

¿Existe necesidad de tratar de llegar más lejos, más allá del 105, aparte del escalofrío propio de batir un récord y de dar el nombre de uno en el libro correspondiente como descubridor de un elemento? (Lavoisier, el mayor de todos los químicos, nunca consiguió ningún descubrimiento, y su fracaso le preocupó en extremo.)

Aún queda por hacer un importante y posible descubrimiento. El incremento en inestabilidad a medida que se asciende en la escala de los números atómicos es uniforme. El más complejo de los átomos estables es el bismuto (83). Detrás del mismo, los seis elementos del 84 al 89 inclusive son tan inestables que cualquier cantidad presente en el momento de la formación de la Tierra ya habría desaparecido en la actualidad. Y luego, y más bien sorprendentemente, sigue el torio (90) y el uranio (92), que son casi estables. Del torio y el uranio existentes en la Tierra en el momento de su formación, el 80 % del primero y el 50 % del último existen aún hoy. Los físicos han elaborado teorías de la estructura atómica para tener esto en cuenta (como explicaré en el capítulo siguiente); y si esas teorías son correctas, en ese caso los elementos 110 y 114 deberían ser más estables de lo que se esperaría de ellos dados sus elevados números atómicos. Por lo tanto, existe considerable interés en conseguir esos elementos, como una forma de comprobar las teorías.

En 1976, se produjo un informe de ciertos halos (marcas circulares negras en la mica) que indicarían la presencia de esos elementos superpesados. Los halos surgen de la radiación emitida por pequeñas cantidades de torio y uranio, pero existen unos halos un poco más allá de lo normal que deben surgir de unos átomos más energéticamente radiactivos que, sin embargo, son lo suficientemente estables como para haber persistido hasta los tiempos modernos. Y debía de tratarse de los superpesados. Por desgracia, las deducciones no se vieron apoyadas en general por los científicos, y dicha sugerencia fue olvidada. Los científicos siguen buscando.

Electrones

Cuando Mendeléiev y sus contemporáneos descubrieron que podían distribuir los elementos en una tabla periódica compuesta por familias de sustancias de propiedades similares, no tenían noción alguna acerca del porqué los elementos pertenecían a tales grupos o del motivo por el que estaban relacionadas las propiedades. De pronto surgió una respuesta simple y clara, aunque tras una larga serie de descubrimientos, que al principio no parecían tener relación con la Química.

Todo empezó con unos estudios sobre la electricidad. Faraday realizó con la electricidad todos los experimentos imaginables; incluso trató de enviar una descarga eléctrica a través del vacío. Mas no pudo conseguir un vacío lo suficientemente perfecto para su propósito. Pero en 1854, un soplador de vidrio alemán, Heinrich Geissler, inventó una bomba de vacío adecuada y fabricó un tubo de vidrio en cuyo interior iban electrodos de metal en un vacío de calidad sin precedentes hasta entonces. Cuando se logró producir descargas eléctricas en el «tubo de Geissler», comprobóse que en la pared opuesta al electrodo negativo aparecía un resplandor verde. El físico alemán Eugen Goldstein sugirió, en 1876, que tal resplandor verde se debía al impacto causado en el vidrio por algún tipo de radiación originada en el electrodo negativo, que Faraday había denominado «cátodo». Goldstein dio a la radiación el nombre de «rayos catódicos».

¿Eran los rayos catódicos una forma de radiación electromagnética? Goldstein lo creyó así; en cambio, lo negaron el físico inglés William Crookes y algunos otros, según los cuales, dichos rayos eran una corriente de partículas de algún tipo. Crookes diseñó versiones mejoradas del tubo de Geissler (llamadas «tubos Crookes»), con las cuales pudo demostrar que los rayos eran desviados por un imán. Esto quizá significaba que dichos rayos estaban formados por partículas cargadas eléctricamente.

En 1897, el físico Joseph John Thomson zanjó definitivamente la cuestión al demostrar que los rayos catódicos podían ser también desviados por cargas eléctricas. ¿Qué eran, pues, las «partículas» catódicas? En aquel tiempo, las únicas partículas cargadas negativamente que se conocían eran los iones negativos de los átomos. Los experimentos demostraron que las partículas de los rayos catódicos no podían identificarse con tales iones, pues al ser desviadas de aquella forma por un campo electromagnético, debían de poseer una carga eléctrica inimaginablemente elevada, o bien tratarse de partículas muy ligeras, con una masa mil veces más pequeña que la de un átomo de hidrógeno. Esta última interpretación era la que encajaba mejor en el marco de las pruebas realizadas. Los físicos habían ya intuido que la corriente eléctrica era transportada por partículas. En consecuencia, estas partículas de rayos catódicos fueron aceptadas como las partículas elementales de la electricidad. Se les dio el nombre de «electrones», denominación sugerida, en 1891, por el físico irlandés George Johnstone Stoney. Finalmente, se determinó que la masa del electrón era 1.837 veces menor que la de un átomo de hidrógeno. (En 1906, Thomson fue galardonado con el premio Nobel de Física por haber establecido la existencia del electrón.)

El descubrimiento del electrón sugirió inmediatamente que debía de tratarse de una subpartícula del átomo. En otras palabras, que los átomos no eran las unidades últimas indivisibles de la materia que habían descrito Demócrito y John Dalton.

Aunque costaba trabajo creerlo, las pruebas convergían de manera inexorable. Uno de los datos más convincentes fue la demostración, hecha por Thomson, de que las partículas con carga negativa emitidas por una placa metálica al ser incidida por radiaciones ultravioleta (el llamado «efecto fotoeléctrico»), eran idénticas a los electrones de los rayos catódicos. Los electrones fotoeléctricos debían de haber sido arrancados de los átomos del metal.

La periodicidad de la tabla periódica

Puesto que los electrones podían separarse fácilmente de los átomos, tanto por el efecto fotoeléctrico como por otros medios, era natural llegar a la conclusión de que se hallaban localizados en la parte exterior del átomo. De ser así, debía de existir una zona cargada positivamente en el interior del átomo, que contrarrestaría las cargas negativas de los electrones, puesto que el átomo, globalmente considerado, era neutro. En este momento, los investigadores empezaron a acercarse a la solución del misterio de la tabla periódica.

Separar un electrón de un átomo requiere una pequeña cantidad de energía. De acuerdo con el mismo principio, cuando un electrón ocupa un lugar vacío en el átomo, debe ceder una cantidad igual de energía. (La Naturaleza es generalmente simétrica, en especial cuando se trata de energía.) Esta energía es liberada en forma de radiación electromagnética. Ahora bien, puesto que la energía de la radiación se mide en términos de longitud de onda, la longitud de onda de la radiación emitida por un electrón que se une a un determinado átomo indicarán la fuerza con que el electrón es sujetado por este átomo. La energía de la radiación aumentaba al acortarse la longitud de onda: cuanto mayor es la energía, más corta es la longitud de onda.

Y con esto llegamos al descubrimiento, hecho por Moseley, de que los metales —es decir, los elementos más pesados— producen rayos X, cada uno de ellos con su longitud de onda característica, que disminuye de forma regular, a medida que se va ascendiendo en la tabla periódica. Al parecer, cada elemento sucesivo retenía sus electrones con más fuerza que el anterior, lo cual no es más que otra forma de decir que cada uno de ellos tiene una carga positiva más fuerte, en su región interna, que el anterior.

Suponiendo que, en un electrón, a cada unidad de carga positiva le corresponde una de carga negativa, se deduce que el átomo de cada elemento sucesivo de la tabla periódica debe tener un electrón más. Entonces, la forma más simple de formar la tabla periódica consiste en suponer que el primer elemento, el hidrógeno, tiene una unidad de carga positiva y un electrón; el segundo elemento, el helio, 2 cargas positivas y 2 electrones; el tercero, el litio, 3 cargas positivas y 3 electrones, y así, hasta llegar al uranio, con 92 electrones. De este modo, los números atómicos de los elementos han resultado ser el número de electrones de sus átomos.

Una prueba más, y los científicos atómicos tendrían la respuesta a la periodicidad de la tabla periódica. Se puso de manifiesto que la radiación de electrones de un determinado elemento no estaba necesariamente restringida a una longitud de onda única; podía emitir radiaciones de dos, tres, cuatro e incluso más longitudes de onda distintas. Estas series de radiaciones fueron denominadas K, L, M, etc. Los investigadores interpretaron esto como una prueba de que los electrones estaban dispuestos en «capas» alrededor del núcleo del átomo de carga positiva. Los electrones de la capa más interna eran sujetados con mayor fuerza, y para conseguir su separación se necesitaba la máxima energía, es decir, de longitudes de onda más corta, o de la serie K. Los electrones de la capa siguiente emitían la serie L de radiaciones; la siguiente capa producía la serie M, etc. En consecuencia, estas capas fueron denominadas K, L, M, etc.

Hacia 1925, el físico austríaco Wolfgang Pauli enunció su «principio de exclusión», el cual explicaba la forma en que los electrones estaban distribuidos en el interior de cada capa, puesto que, según este principio, dos electrones no podían poseer exactamente la misma energía ni el mismo spin. Por este descubrimiento, Pauli recibió el premio Nobel de Física en 1945.

Los gases nobles o inertes

En 1916, el químico americano Gilbert-Newton Lewis determinó las similitudes de las propiedades y el comportamiento químico de algunos de los elementos más simples sobre la base de su estructura en capas. Para empezar, había pruebas suficientes de que la capa más interna estaba limitada a dos electrones. El hidrógeno sólo tiene un electrón; por tanto, la capa está incompleta. El átomo tiende a completar esta capa K, y puede hacerlo de distintas formas. Por ejemplo, dos átomos de hidrógeno pueden compartir sus respectivos electrones y completar así mutuamente sus capas K. Ésta es la razón de que el hidrógeno se presente casi siempre en forma de un par de átomos: la molécula de hidrógeno. Se necesita una gran cantidad de energía para separar los dos átomos y liberarlos en forma de «hidrógeno atómico». Irving Langmuir, de la «General Electric Company» —quien, independientemente, llegó a un esquema similar, que implicaba los electrones y el comportamiento químico— llevó a cabo una demostración práctica de la intensa tendencia del átomo de hidrógeno a mantener completa su capa de electrones. Obtuvo una «antorcha de hidrógeno atómico» soplando gas de hidrógeno a través de un arco eléctrico, que separaba los átomos de las moléculas; cuando los átomos se recombinaban, tras pasar el arco, liberaban las energías que habían absorbido al separarse, lo cual bastaba para alcanzar temperaturas superiores a los 3.400 °C.

En el helio (elemento 2), la capa K está formada por dos electrones. Por tanto, los átomos de helio son estables y no se combinan con otros átomos. Al llegar al litio (elemento 3), vemos que dos de sus electrones completan la capa K y que el tercero empieza la capa L. Los elementos siguientes añaden electrones a esta capa, uno a uno: el berilio tiene 2 electrones en la capa L; el boro, 3; el carbono, 4; el nitrógeno, 5; el oxígeno, 6; el flúor, 7, y el neón 8. Ocho es el límite para la capa L, por lo cual el neón, lo mismo que el helio, tiene su capa exterior de electrones completa. Y, desde luego, es también un gas inerte, con propiedades similares a las del helio.

Cada átomo cuya capa exterior no está completa, tiende a combinarse con otros átomos, de forma que pueda completarla. Por ejemplo, el átomo de litio cede fácilmente su único electrón en la capa L, de modo que su capa exterior sea la K, completa, mientras que el flúor tiende a captar un electrón, que añade a los siete que ya tiene, para completar su capa L. Por tanto, el litio y el flúor tienen afinidad el uno por el otro; y cuando se combinan, el litio cede su electrón L al flúor, para completar la capa L exterior de este último. Dado que no cambia las cargas positivas del interior del átomo, el litio, con un electrón de menos, es ahora portador de una carga positiva, mientras que el flúor, con un electrón de más, lleva una carga negativa. La mutua atracción de las cargas opuestas mantiene unidos a los dos iones. El compuesto se llama fluoruro de litio.

Los electrones de la capa L pueden ser compartidos o cedidos. Por ejemplo, uno de cada dos átomos de flúor puede compartir uno de sus electrones con el otro, de modo que cada átomo tenga un total de ocho en su capa L, contando los dos electrones compartidos. De forma similar, dos átomos de oxígeno compartirán un total de cuatro electrones para completar sus capas L; y dos átomos de nitrógeno compartirán un total de 6. De este modo, el flúor, el oxígeno y el nitrógeno forman moléculas de dos átomos.

El átomo de carbono, con sólo cuatro electrones en su capa L, compartirá cada uno de ellos con un átomo distinto de hidrógeno, para completar así las capas K de los cuatro átomos de hidrógeno. A su vez, completa su propia capa L al compartir sus electrones. Esta disposición estable es la molécula de metano CH4.

Del mismo modo, un átomo de nitrógeno compartirá los electrones con tres átomos de hidrógeno para formar el amoníaco; un átomo de oxígeno compartirá sus electrones con dos átomos de hidrógeno para formar el agua; un átomo de carbono compartirá sus electrones con dos átomos de oxígeno para formar anhídrido carbónico; etc. Casi todos los compuestos formados por elementos de la primera parte de la tabla periódica pueden ser clasificados de acuerdo con esta tendencia a completar su capa exterior cediendo electrones, aceptando o compartiendo electrones.

El elemento situado después del neón, el sodio, tiene 11 electrones, y el undécimo debe empezar una tercera capa. Luego sigue el magnesio, con 2 electrones en la capa M; el aluminio, con 3; el silicio, con 4; el fósforo, con 5; el azufre, con 6; el cloro, con 7, y el argón, con 8.

Ahora bien, cada elemento de este grupo corresponde a otro de la serie anterior. El argón, con 8 electrones en la capa M, se asemeja al neón (con 8 electrones en la capa L) y es un gas inerte. El cloro, con 7 electrones en su capa exterior, se parece mucho al flúor en sus propiedades químicas. Del mismo modo, el silicio se parece al carbono; el sodio, al litio, etc. (fig. 6.2).

Fig. 6.2. Cesión y compartimento de electrones. El litio cede el electrón de su capa exterior al flúor, en la combinación fluoruro de litio; cada átono tiene entonces una capa eterna completa. En la molécula de flúor (F2), se comparten dos electrones, que completan las capas exteriores de ambos átomos.

Así ocurre a lo largo de toda la tabla periódica. Puesto que el comportamiento químico de cada elemento depende de la configuración de los electrones de su capa exterior, todos los que, por ejemplo, tengan un electrón en la capa exterior, reaccionarán químicamente de un modo muy parecido. Así, todos los elementos de la primera columna de la tabla periódica —litio, sodio, potasio, rubidio, cesio e incluso el francio, el elemento radiactivo hecho por el hombre— son extraordinariamente parecidos en sus propiedades químicas. El litio tiene 1 electrón en la capa L; el sodio, 1 en la M; el potasio, 1 en la N; el rubidio, 1 en la O; el cesio, 1 en la P, y el francio, 1 en la Q. Una vez más, se parecen entre sí todos los elementos con siete electrones en sus respectivas capas exteriores (flúor, cloro, bromo, yodo y astato). Lo mismo ocurre con la última columna de la tabla, el grupo, de capa completa, que incluye el helio, neón, argón, criptón, xenón y radón.

El principio de Lewis-Langmuir se cumple de forma tan perfecta, que sirve aún, en su forma original, para explicar las variedades de comportamiento más simples y directas entre los elementos. Sin embargo, no todos los comportamientos son tan simples ni tan directos como pueda creerse.

Por ejemplo, cada uno de los gases inertes —helio, neón, argón, criptón, xenón y radón— tiene ocho electrones en la capa exterior (a excepción del helio, que tiene dos en su única capa), situación que es la más estable posible. Los átomos de estos elementos tienen una tendencia mínima a perder o ganar electrones, y, por tanto, a tomar parte en reacciones químicas. Estos gases, tal como indica su nombre, serían «inertes».

Sin embargo, una «tendencia mínima» no es lo mismo que «sin tendencia alguna»; pero la mayor parte de los químicos lo olvidó, y actuó como si fuese realmente imposible para los gases inertes formar compuestos. Por supuesto que ello no ocurría así con todos. Ya en 1932, el químico americano Linus Pauling estudió la facilidad con que los electrones podían separarse de los distintos elementos, y observó que todos los elementos sin excepción, incluso los gases inertes, podían ser desprovistos de electrones. La única diferencia estribaba en que, para que ocurriese esto, se necesitaba más energía en el caso de los gases inertes que en el de los demás elementos situados junto a ellos en la tabla periódica.

La cantidad de energía requerida para separar los electrones en los elementos de una determinada familia, disminuye al aumentar el peso atómico, y los gases inertes más pesados, el xenón y el radón, no necesitan cantidades excesivamente elevadas. Por ejemplo, no es más difícil extraer un electrón a partir de un átomo de xenón que de un átomo de oxígeno.

Por tanto, Pauling predijo que los gases inertes más pesados podían formar compuestos químicos con elementos que fueran particularmente propensos a aceptar electrones. El elemento que más tiende a aceptar electrones es el flúor, y éste parecía ser el que naturalmente debía elegirse.

Ahora bien, el radón, el gas inerte más pesado, es radiactivo y sólo puede obtenerse en pequeñísimas cantidades. Sin embargo, el xenón, el siguiente gas más pesado, es estable y se encuentra en pequeñas cantidades en la atmósfera. Por tanto, lo mejor sería intentar formar un compuesto entre el xenón y el flúor. Sin embargo, durante 30 años no se pudo hacer nada a este respecto, principalmente porque el xenón era caro, y el flúor, muy difícil de manejar, y los químicos creyeron que era mejor dedicarse a cosas menos complicadas.

No obstante, en 1962, el químico anglocanadiense Neil Bartlett, trabajando con un nuevo compuesto, el hexafluoruro de platino (F6Pt), manifestó que se mostraba notablemente ávido de electrones, casi tanto como el propio flúor. Este compuesto tomaba electrones a partir del oxígeno, elemento que tiende más a ganar electrones que a perderlos. Si el F6Pt podía captar electrones a partir del oxígeno, debía de ser capaz también de captarlos a partir del xenón. Se intentó el experimento, y se obtuvo el fluoroplatinato de xenón (F6PtXe), primer compuesto de un gas inerte.

Otros químicos se lanzaron en seguida a este campo de investigación, y se obtuvo cierto número de compuestos de xenón con flúor, con oxígeno o con ambos, el más estable de los cuales fue el difluoruro de xenón (F2Xe). Formóse asimismo un compuesto de criptón y flúor: el tetrafluoruro de criptón (F4Kr), así como otros de radón y flúor. También se formaron compuestos con oxígeno. Había, por ejemplo, oxitetrafluoruro de xenón (OF4Xe), ácido xénico (H2O4Xe) y perxenato de sodio (XeO6Na4), que explota fácilmente y es peligroso. Los gases inertes más livianos — argón, neón y helio— ofrecen mayor resistencia a compartir sus electrones que los más pesados, por lo cual permanecen inertes (según las posibilidades actuales de los químicos).

Los químicos no tardaron en recuperarse del shock inicial que supuso descubrir que los gases inertes podían formar compuestos. Después de todo, tales compuestos encajaban en el cuadro general. En consecuencia, hoy existe una aversión general a denominar «gases inertes» a estos elementos. Se prefiere el nombre de «gases nobles», y se habla de «compuestos de gases nobles» y «Química de los gases nobles». (Creo que se trata de un cambio para empeorar. Al fin y al cabo, los gases siguen siendo inertes, aunque no del todo. En este contexto, el concepto «noble» implica «reservado» o «poco inclinado a mezclarse con la manada», lo cual resulta tan inapropiado como «inerte» y, sobre todo, no anda muy de acuerdo con una «sociedad democrática».)

Los elementos tierras raras

El esquema de Lewis-Langmuir que se aplicó demasiado rígidamente a los gases inertes, apenas puede emplearse para muchos de los elementos cuyo número atómico sea superior a 20. En particular se necesitaron ciertos perfeccionamientos para abordar un aspecto muy sorprendente de la tabla periódica, relacionado con las llamadas «tierras raras» (los elementos 57 al 71, ambos inclusive).

Retrocediendo un poco en el tiempo, vemos que los primeros químicos consideraban como «tierra» —herencia de la visión griega de la «tierra» como elemento— toda sustancia insoluble en agua y que no pudiera ser transformada por el calor. Estas sustancias incluían lo que hoy llamaríamos óxido de calcio, óxido de magnesio, bióxido silícico, óxido férrico, óxido de aluminio, etc., compuestos que actualmente constituyen alrededor de un 90 % de la corteza terrestre. Los óxidos de calcio y magnesio son ligeramente solubles, y en solución muestran propiedades «alcalinas» (es decir, opuestas a las de los ácidos), por lo cual fueron denominados «tierras alcalinas»; cuando Humphry Davy aisló los metales calcio y magnesio partiendo de estas tierras, se les dio el nombre de metales alcalinotérreos. De la misma forma se designaron eventualmente todos los elementos que caben en la columna de la tabla periódica en la que figuran el magnesio y el calcio; es decir, el berilio, estroncio, bario y radio.

El rompecabezas empezó en 1794, cuando un químico finlandés, Johan Gadolin, examinó una extraña roca que había encontrado cerca de la aldea sueca de Ytterby, y llegó a la conclusión de que se trataba de una nueva «tierra». Gadolin dio a esta «tierra rara» el nombre de «itrio» (por Ytterby). Más tarde, el químico alemán Martin Heinrich Klaproth descubrió que el itrio podía dividirse en dos «tierras», para una de las cuales siguió conservando el nombre de itrio, mientras que llamó a la otra «cerio» (por el planetoide Ceres, recientemente descubierto). Pero, a su vez, el químico sueco Cari Gustav Mosander separó éstos en una serie de tierras distintas. Todas resultaron ser óxidos de nuevos elementos, denominados «metales de las tierras raras». En 1907 se habían identificado ya 14 de estos elementos. Por orden creciente de peso atómico son:

lantano (voz tomada de la palabra griega que significa «escondido»)

cerio (de Ceres)

praseodimio (del griego «gemelo verde», por la línea verde que da su espectro)

neodimio («nuevos gemelos»)

samarío (de «samarsquita», el mineral en que se encontró)

europio (de Europa)

gadolinio (en honor de Johan Gadolin)

terbio (de Ytterby)

disprosio (del griego «difícil de llegar a»)

holmio (de Estocolmo)

erbio (de Ytterby)

tulio (de Thule, antiguo nombre de Escandinavia) iterbio (de Ytterby)

lutecio (de Lutecia, nombre latino de París).

Basándose en sus propiedades de rayos X, estos elementos recibieron los números atómicos 57 (lantano) a 71 (lutecio). Como ya hemos dicho, existía un vacío en el espacio 61 hasta que el elemento incógnito, el promecio, emergió a partir de la fisión del uranio. Era el número 15 de la lista.

Ahora bien, el problema planteado por los elemento de las tierras raras es el de que, aparentemente, no encajan en la tabla periódica. Por suerte, sólo se conocían cuatro cuando Mendeléiev propuso la tabla; si se hubiesen conocido todos, la tabla podría haber resultado demasiado confusa para ser aceptada. Hay veces, incluso en la Ciencia, en que la ignorancia es una suerte.

El primero de los metales de las tierras raras, el lantano, encaja perfectamente con el itrio, número 39, el elemento situado por encima de él en la tabla. (El itrio, aunque fue encontrado en las mismas menas que las tierras raras y es similar a ellas en sus propiedades, no es un metal de tierra rara. Sin embargo, toma también su nombre de la aldea sueca de Ytterby. Así, cuatro elementos se denominan partiendo del mismo origen, lo cual parece excesivo.) La confusión empieza con las tierras raras colocadas después del lantano, principalmente el cerio, que debería parecerse al elemento que sigue al itrio, o sea, al circonio. Pero no es así, pues se parece al itrio. Lo mismo ocurre con los otros quince elementos de las tierras raras; se parecen mucho al itrio y entre sí (de hecho, son tan químicamente parecidos, que al principio pudieron separarse sólo por medio de procedimientos muy laboriosos), pero no están relacionados con ninguno de los elementos que les preceden en la tabla. Prescindamos del grupo de tierras raras y pasemos al hafnio, el elemento 72, en el cual encontraremos el elemento relacionado con el circonio, colocado después del itrio.

Fig. 6.3. Las capas de electrones del lantano. Nótese que la cuarta subcapa de la capa N ha sido omitida y está vacía.

Desconcertados por este estado de cosas, lo único que pudieron hacer los químicos fue agrupar todos los elementos de tierras raras en un espacio situado debajo del itrio, y alineados uno por uno, en una especie de nota al pie de la tabla.

Los elementos transicionales

Finalmente, la respuesta a este rompecabezas llegó como resultado de detalles añadidos al esquema de Lewis-Langmuir sobre la estructura de las capas de electrones en los elementos.

En 1921, C. R. Bury sugirió que el número de electrones de cada capa no estaba limitado necesariamente a ocho. El ocho era el número que bastaba siempre para satisfacer la capacidad de la capa exterior. Pero una capa podía tener un mayor número de electrones si no estaba en el exterior. Como quiera que las capas se iban formando sucesivamente, las más internas podían absorber más electrones, y cada una de las siguientes podía retener más que la anterior. Así, la capacidad total de la capa K sería de 2 electrones; la de la L, de 8; la de la M, de 18; la de la N, de 32, y así sucesivamente. Este escalonamiento se ajusta al de una serie de sucesivos cuadrados multiplicados por 2 (por ejemplo, 2·1, 2·4, 2·9, 2·16, etc.).

Este punto de vista fue confirmado por un detenido estudio del espectro de los elementos. El físico danés Niels Henrik David Bohr demostró que cada capa de electrones estaba constituida por subcapas de niveles de energía ligeramente distintos. En cada capa sucesiva, las subcapas se hallan más separadas entre sí, de tal modo que pronto se imbrican las capas. En consecuencia, la subcapa más externa de una capa interior (por ejemplo, la M), puede estar realmente más lejos del centro que la subcapa más interna de la capa situada después de ella (por ejemplo, la N). Por tanto, la subcapa interna de la capa N puede estar llena de electrones, mientras que la subcapa exterior de la capa M puede hallarse aún vacía.

Un ejemplo aclarará esto. Según esta teoría, la capa M está dividida en tres subcapas, cuyas capacidades son de 2, 6 y 10 electrones, respectivamente, lo cual da un total de 18. El argón, con 8 electrones en su capa M, ha completado sólo 2 subcapas internas. Y, de hecho, la tercera subcapa, o más externa, de la capa M, no conseguirá el próximo electrón en el proceso de formación de elementos, al hallarse por debajo de la subcapa más interna de la capa N. Así, en el potasio —elemento que sigue al argón—, el electrón decimonoveno no se sitúa en la subcapa más exterior de M, sino en la subcapa más interna de N. El potasio, con un electrón en su capa N, se parece al sodio, que tiene un electrón en su capa M. El calcio —el siguiente elemento (20)— tiene dos electrones en la capa N y se parece al magnesio, que posee dos en la capa M. Pero la subcapa más interna de la capa N, que tiene capacidad sólo para 2 electrones, está completa. Los siguientes electrones que se han de añadir pueden empezar llenando la subcapa más exterior de la capa M, que hasta entonces ha permanecido inalterada. El escandio (21) inicia el proceso, y el cinc (30) lo termina. En el cinc, la subcapa más exterior de la capa M adquiere, por fin, los electrones que completan el número de 10. Los 30 electrones del cinc están distribuidos del siguiente modo: 2 en la capa K,8 en la L,18 en la M y 2 en la N. Al llegar a este punto, los electrones pueden seguir llenando la capa N. El siguiente electrón constituye el tercero de la capa N y forma el galio (31), que se parece al aluminio, con 3 electrones en la capa M.

Lo más importante de este proceso es que los elementos 21 al 30 —los cuales adquieren una configuración parecida para completar una subcapa que había sido omitida temporalmente— son «de transición». Nótese que el calcio se parece al magnesio, y el galio, al aluminio. El magnesio y el aluminio están situados uno junto a otro en la tabla periódica (números 12 y 13). En cambio, no lo están el calcio (20) ni el galio (31). Entre ellos se encuentran los elementos de transición, lo cual hace aún más compleja la tabla periódica.

La capa N es mayor que la M y está dividida en cuatro subcapas, en vez de tres: puede tener 2, 6, 10 y 14 electrones, respectivamente. El criptón (elemento 36) completa las dos subcapas más internas de la capa N; pero aquí interviene la subcapa más interna de la capa O, que está superpuesta, y antes de que los electrones se sitúen en las dos subcapas más externas de la N, deben llenar dicha subcapa. El elemento que sigue al criptón, el rubidio (37), tiene su electrón número 37 en la capa O. El estroncio (38) completa la subcapa O con dos electrones. De aquí en adelante, nuevas series de elementos de transición rellenan la antes omitida tercera subcapa de la capa N. Este proceso se completa en el cadmio (48); se omite la subcapa cuarta y más exterior de N, mientras los electrones pasan a ocupar la segunda subcapa interna de O, proceso que finaliza en el xenón (54).