Chapitre 8

Depuis la révolution industrielle, le monde s’est

considérablement rétréci. Alors que les pères pèlerins, fondateurs

des premières colonies américaines avaient mis 66 jours pour

traverser l’Atlantique en 1620, cette traversée prenait un peu plus

d’un mois vers 1830, quinze jours en 1838 lors de la mise en

service du Great Western, puis cinq

jours avec le Normandie dans les années 1930 et environ 8 heures

actuellement. Face à cette évolution, la mondialisation apparaît

comme un phénomène inéluctable.

La population mondiale

Parmi tous les êtres humains qui ont jamais

vécu, depuis l’origine de l’homo sapiens, combien sont vivants

aujourd'hui ? C'est une question que les démographes aiment à

se poser. La réponse est de l’ordre de 6 à 7 % : sur 80 à 100

milliards de personnes nées dans toute l’histoire de l’humanité, on

en compte actuellement 6 milliards. La proportion est plus élevée

encore si on considère les années vécues sur Terre, car la durée de

vie était évidemment bien plus faible auparavant (20 ans à la

période néolithique, 30 ans au XVIIIe

siècle, 65 ans actuellement) : les vivants d’aujourd’hui

représentent un sixième du temps total que les humains ont

collectivement passé sur la Terre.

Le seuil de remplacement des générations

correspond à un taux de fécondité de 2,1 enfants par femme. La

moitié des pays du monde étaient passés en dessous en l’an 2000 et

le mouvement continue. L'ensemble des pays en développement devrait

avoir un taux de fécondité moyen inférieur à ce seuil aux alentours

de 2045. L'allongement de la durée de vie et la baisse générale de

la natalité entraîneront une progression considérable de la part

des personnes âgées dans la population mondiale: les gens de plus

de 60 ans passeraient ainsi de 10 % du total à la fin du

XIXe siècle, à environ un tiers à la fin

du XXIe. L'Europe voit sa natalité

reculer plus vite: en 1975, la France comptait 1,7 million de

jeunes (< 20 ans) de plus qu’en l’an 2000, et en 2025

l’Union européenne comptera autant d’habitants qu’en 1999, soit 380

millions.

Ce basculement commencera à entraîner vers

2010-2020 deux types de problèmes: l’augmentation des dépenses

médicales et le financement des retraites. Sur le premier, on peut

penser que l’allongement de la durée de la vie fait que la

multiplication des problèmes de santé, propre à la vieillesse,

commence beaucoup plus tard (une personne de 80 ans en 2050 aurait

la santé et l’apparence d’une personne de 60 ans aujourd’hui). Sur

le financement des pensions, lorsque la génération d’après-guerre

entrera dans la retraite (les baby-boomers, nés autour de 1950,

auront alors entre soixante et soixante-dix ans, une modification

du système des versements deviendra indispensable. Là aussi,

l’allongement de la durée de vie, permettant d’étendre la période

de vie active au-delà de 60 ans, facilitera la résolution du

problème.

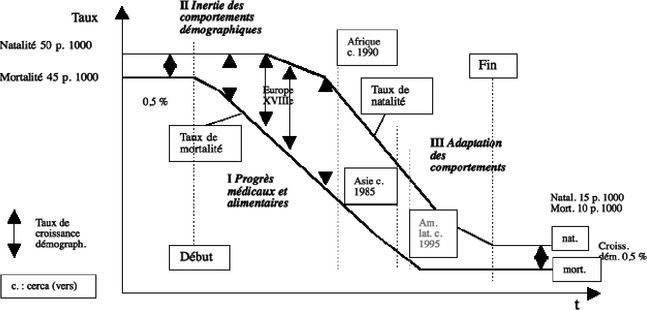

Du fait du décalage de la transition

démographique (voir schéma), la croissance de la population sera

encore beaucoup plus forte dans les pays du Sud que dans les pays

développés, alors qu’il y avait un meilleur équilibre au

XXe siècle. Les inégalités mondiales

entre un monde riche de plus en plus restreint relativement, et un

monde pauvre dominant en nombre, risquent d’apparaître encore plus

fortement. Seul un développement économique plus rapide dans les

pays du Sud, comme on peut d’ailleurs l’observer en Asie et en

Amérique latine, peut empêcher ces déséquilibres mondiaux de

s’accentuer.

fait de l’inertie des comportements (mouvement II) et donc l’écart

entre natalité et mortalité s’accroît, provoquant la hausse de la

population (le taux de croissance démographique est la différence

entre le taux de natalité et de mortalité). La transition démographique est donc à l’origine de

l’explosion démographique. Puis les

comportements changent, les gens ont moins d’enfants, du fait d’un

mode de vie industriel et urbain complètement différent, et le taux

de natalité baisse à son tour (mouvement III). On retrouve, une

fois la transition terminée, un rythme d’accroissement comparable à

celui du départ, mais avec des taux de natalité et mortalité bien

inférieurs. L'Amérique latine, l’Asie et l’Afrique suivent la même

évolution au XXe siècle, avec comme

différence que les progrès alimentaires ne sont pas le facteur

principal à l’origine de la baisse de la mortalité, mais plutôt les

progrès médicaux apportés de l’extérieur. La transition

démographique en Europe est endogène, en ce sens où ce sont les

progrès locaux de l’agriculture qui en sont l’origine, elle est

exogène au Sud, pour la raison indiquée.

fait de l’inertie des comportements (mouvement II) et donc l’écart

entre natalité et mortalité s’accroît, provoquant la hausse de la

population (le taux de croissance démographique est la différence

entre le taux de natalité et de mortalité). La transition démographique est donc à l’origine de

l’explosion démographique. Puis les

comportements changent, les gens ont moins d’enfants, du fait d’un

mode de vie industriel et urbain complètement différent, et le taux

de natalité baisse à son tour (mouvement III). On retrouve, une

fois la transition terminée, un rythme d’accroissement comparable à

celui du départ, mais avec des taux de natalité et mortalité bien

inférieurs. L'Amérique latine, l’Asie et l’Afrique suivent la même

évolution au XXe siècle, avec comme

différence que les progrès alimentaires ne sont pas le facteur

principal à l’origine de la baisse de la mortalité, mais plutôt les

progrès médicaux apportés de l’extérieur. La transition

démographique en Europe est endogène, en ce sens où ce sont les

progrès locaux de l’agriculture qui en sont l’origine, elle est

exogène au Sud, pour la raison indiquée.

Représentation stylisée de

la transition démographique Elle commence par la baisse de

la mortalité (grâce à une meilleure alimentation surtout) en Europe

au XVIIIe siècle, mouvement I du

graphique. Au début, la mortalité reste élevée, du

L'évolution démographique a été essentiellement

marquée, dans les pays développés, après la guerre, par

l’introduction et la légalisation de la contraception scientifique,

ainsi que de l’interruption volontaire de grossesse. En France,

celle-ci fait l’objet d’un vote à l’Assemblée nationale (284 voix

contre 189) le 26 novembre 1974, lorsque le ministre de la Santé de

Valéry Giscard d’Estaing, Simone Veil, fait passer le texte qui

changera les comportements et qui met fin à une loi de 1920

réprimant l’avortement. Il y en a environ 300 000 pour 900 000

naissances au début des années 1970.

Le XXe siècle est

celui de la lutte des femmes pour l’égalité. Le droit de vote a été

obtenu aux États-Unis en 1919-1920 (Equal

suffrage amendment), en Angleterre en 19281, en France en 1944, au Québec en 1940, et en

Suisse seulement en 1971. Le droit à l’éducation a été obtenu dès

les premières décennies du siècle. Le droit au travail a également

été progressivement acquis, même si l’égalité est loin d’être

atteinte dans ce domaine: 60 à 80 % des femmes ont des emplois dans

les pays riches, mais le taux de chômage reste plus faible pour les

hommes et les salaires plus élevés. Les deux guerres mondiales ont

fait progresser tous ces droits. Les innovations en matière de

contrôle des naissances ont également joué leur rôle. L'évolution

des mentalités, à la fois conséquence de ces changements et cause

de leur accélération, a joué aussi un rôle essentiel.

L'urbanisation massive caractérise le

XXe siècle. La moitié de la population

mondiale, soit 3 milliards d’habitants, est urbanisée en l’an 2000,

contre un tiers en 1960. On en prévoit 5 milliards (sur 8) en 2030.

Le mouvement continue avec 60 millions de nouveaux citadins chaque

année. Il correspond à la poursuite de l’exode rural commencé avec

les enclosures de la fin du Moyen Âge et surtout

l'industrialisation du XVIIIe siècle.

Les pays du Sud participent à cette évolution avec une population

urbaine qui est passée de 20 à 40 % du total entre 1960 et 2000 (75

% en Amérique latine, comme dans les pays développés, 38 % en Asie

et en Afrique). Vingt villes ont plus de dix millions d’habitants

dans le monde en 2003, dont quinze dans les pays en développement,

contre seulement deux en 1960 (New York et Tokyo). En 2015, on

comptera 26 villes de plus de dix millions d’habitants dans le

monde, dont 22 dans les pays du Sud.

Athènes au IVe siècle

avant notre ère – à l’époque d’Aristote qui disait déjà que l’homme

était avant tout « un animal urbain » – devait compter dans les 150

000 habitants avec son hinterland, aujourd’hui les plus grandes

métropoles sont cent fois plus peuplées.

Les épidémies tueuses ont changé de nature au

XXe siècle. Les deux principales sont la

grippe espagnole en 1918-1919 qui a provoqué entre 25 et 40

millions de morts dans le monde (plus que la Première Guerre

mondiale) et le SIDA qui depuis 1980 a déjà tué 12 millions de

personnes. À titre de comparaison, la peste avait fait quelque 25

millions de morts en Europe au XIVe

siècle, dans une population beaucoup plus faible d’environ 75

millions et la variole en Amérique au XVIe, apportée par les Européens, avait causé

peut-être 20 millions de morts parmi les populations

indigènes.

Inégalités

Les inégalités se sont creusées aux États-Unis

depuis les années 1980 . À partir de 1993, elles ont atteint des

niveaux jamais vus en un siècle. Le boom boursier a entraîné un

enrichissement des classes moyennes, dont les revenus ont augmenté

en termes réels de 2 % par an dans les années 1990, mais les plus

pauvres ont été laissés de côté dans cette évolution. Un mécanisme

de sablier se serait mis en place où la classe moyenne est aspirée

vers le bas, même si une partie d’entre elle réussit à se maintenir

en haut. Aux États-Unis, le revenu moyen d’un chef d’entreprise est

passé de 42 fois le salaire moyen de ses ouvriers en 1980, à 419

fois en 1998, soit un écart multiplié par dix.

La caractéristique de toute révolution

industrielle ou technologique, comme celle de la fin du

XXe siècle, est dans un premier temps

d’accroître les inégalités, puisqu’au départ certains réalisent des

fortunes rapides dans les secteurs nouveaux, puis de les résorber

massivement grâce justement aux nouvelles technologies. L'extension

de la classe moyenne dans les pays occidentaux, une réduction des

inégalités, est la conséquence des deux premières révolutions

industrielles. Les inégalités extrêmes et permanentes sont au

contraire le propre des pays féodaux et préindustriels.

« Le monde serait entré, à la fin du

XXe siècle, dans une nouvelle révolution

économique, de la même nature et de la même ampleur que celles

qu’il avait connues à la fin du XVIIIe

siècle avec la machine à vapeur et à la fin du XIXe, avec l’électricité. À chaque fois, une nouvelle

technologie à usage général, c’est-à-dire ayant des implications

dans tous les domaines de la vie économique, est venue tout

bouleverser. Chacune de ces révolutions a provoqué naturellement

une augmentation brutale de la production et de la productivité.

Mais, dans le même temps, elle a, à chaque fois, modifié l’ensemble

des rapports sociaux. Elle a, en particulier, d’abord contribué à

accroître les inégalités. Dans une seconde phase, on a toujours pu

observer une inversion de ce mouvement, et le début d’un mouvement

de résorption des inégalités. Au début, l’innovation est réservée à

quelques-uns: ceux-ci améliorent leur situation aux dépens de tous

les autres. Les inégalités se creusent. Mais progressivement, après

un processus complexe de diffusion et d’apprentissage, cette

innovation se généralise, les inégalités qu’elle a créées se

réduisent. Simon Kuznets en a fait la démonstration en étudiant les

précédentes révolutions économiques. Aux États-Unis, par exemple,

la part de la richesse détenue par les 10 % les plus riches de la

population serait passée de 50 % en 1770 à 75 % en 1870, avant de

retomber à 50 % en 1970. L'actuel mouvement de fragmentation de la

société mondiale ne serait donc pas inéluctable : il serait la

conséquence d’une révolution qui n’en est qu’à sa première étape.

Demain, dans une seconde phase, lorsque, comme l’électricité, la

puce se sera généralisée, les inégalités se réduiront: les

nouvelles technologies seront une opportunité formidable pour des

populations pour l’instant à l’écart du mouvement. » E. Izraelewicz

■

Keynésianisme et libéralisme

On peut découper l’après-guerre selon les

décennies successives, même si une part d’arbitraire est forcément

introduite dans ce classement:

• Années

1950 : Reconstruction, progrès du libre-échange et débuts de

l’intégration européenne.

• Années

1960 : Croissance forte et contestation.

• Années

1970 : Chocs pétroliers, tentations protectionnistes et

récession.

• Années

1980 : Crise de la dette au Sud, décennie perdue du

développement.

• Années

1990 : Reprise forte des échanges internationaux,

libéralisation et mondialisation.

• Années

2000 : Mondialisation et crise.

Au lendemain de la Deuxième Guerre mondiale,

sous l’influence des idées keynésiennes et devant la nécessité de

reconstruire les économies, l’État apparaît comme le grand

ordonnateur du capitalisme qui devient mixte. Autant la production

des secteurs de base et la mise en place des infrastructures que

les mécanismes de la redistribution et de la protection sociale

apparaissent comme ses prérogatives incontestées. En outre,

l’orientation des investissements (la planification indicative en

France ou en Hollande), le contrôle des changes, l’organisation et

le contrôle du crédit (nationalisation des banques françaises en

1945-1946), les négociations collectives, l’observation économique

(INSEE, Comptabilité nationale) sont également de son

ressort.

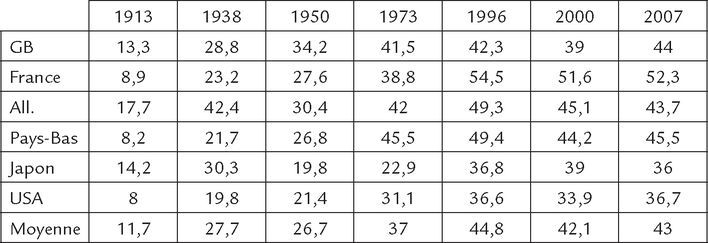

La montée de l’État au XXe siècle peut être illustrée par les chiffres

suivants. En 1870 aux États-Unis, on compte 51 071 agents qui

travaillent pour le gouvernement fédéral (dont 36 696 dans la

Poste !), soit un fonctionnaire (en dehors des postiers) pour

2 858 personnes. En 1901, ce chiffre passe à un fonctionnaire pour

751, et un pour 91 en 1970 ; il est remonté à un pour 102 en

1980 et continue à le faire, illustrant le recul de l’État à la

suite des réactions néolibérales (cf. encadré).

Un retournement a en effet eu lieu à la fin des

années 1970 en Angleterre et aux États-Unis, devant les échecs du

contrôle étatique: inflation à deux chiffres, faible croissance,

déficits et endettement publics, hausse des impôts, lourdeurs

administratives, monopoles publics mal gérés, etc. La thérapeutique

keynésienne, appliquée après la guerre, présentait un défaut que

Keynes lui-même avait sous-estimé. Pour réguler la croissance

économique par le biais des dépenses et recettes publiques, il

faudrait avoir en permanence une connaissance précise de l’état de

l’économie, sinon on risque d’agir à contretemps. Or cette

connaissance est impossible à atteindre, déjà dépassée quand on

l’obtient, l’information économique est largement approximative. On

ignore combien de temps il faudra pour que les dépenses et les

taxes agissent sur l’économie globale. Il en va de même pour la

politique monétaire. De plus, pour des raisons électorales, les

politiques expansionnistes ont été plus fréquentes que les

politiques restrictives, et au lieu d’avoir l’alternance préconisée

par Keynes entre déficits et excédents, on a assisté à une

accumulation de déficits publics conduisant à l’endettement de

l’État et à des pressions inflationnistes croissantes, alimentées

ensuite par les chocs pétroliers et la guerre de Corée, puis celle

du Vietnam. Les différences d’inflation entre les principaux pays,

dans un système de changes fixes, conduisirent à des crises

monétaires (spéculation contre les monnaies faibles) et finalement

la chute du système de changes fixes et d’étalon or-dollar de

Bretton-Woods en 1971-1973.

Le néolibéralisme

Dans les années 1940, Friedrich Hayek, dans son

ouvrage classique La route de la

servitude, avait prévenu les démocraties capitalistes

qu’elles faisaient fausse route en essayant de contrer le

communisme par une plus grande intervention publique, un État en

expansion et une planification, fut-elle indicative. Il préconisait

une Europe fédérale pour remédier à la bureaucratie étatique

envahissante. Les pays anglo-saxons, notamment les États-Unis, ont

davantage évolué vers un welfare

capitalism que vers un wefare

state, un capitalisme social plutôt qu’un régime mixte

social-démocrate caractérisé par l’État-providence. Ce welfare capitalism peut être défini à travers

l’élargissement de la relation d’emploi dans l’entreprise, au-delà

de l’échange de travail contre salaire, en incluant de nombreux

avantages au contrat de travail, avantages fournis par la firme:

programmes d’assurance-santé, de retraite, de formation,

d’éducation, de logement, de garde des enfants, de participation au

capital et aux bénéfices, etc. Ce type de capitalisme s’apparente à

certaines formes de paternalisme apparues dès le XIXe siècle en Europe, et il se répand aux États-Unis

à partir de 1900. Le New Deal marquera

une évolution inverse avec l’apparition de l’État-providence, mais

le mouvement reprendra en force dans les années 1950 et 1960 avec

le recul des syndicats.

Les fonds de pension de sociétés ont été lancés

en 1950 par Charles Wilson, patron de la General Motors, avec un

succès foudroyant: la même année 8 000 plans de ce type étaient mis

en place aux États-Unis. D’autres pays suivront comme la

Grande-Bretagne, la Hollande et le Japon. Le principe consiste à

financer les retraites des employés par des investissements massifs

et diversifiés dans des titres de toute sorte: actions, bons,

obligations, etc. Il s’agissait d’intéresser les travailleurs aux

bénéfices des firmes et à la croissance économique en général, tout

en assurant leur sécurité à long terme. La propriété des

entreprises, aux États-Unis et en Grande-Bretagne est ainsi de plus

en plus détenue par les employés eux-mêmes, à travers les fonds de

pension et les compagnies d’assurance qui les gèrent. Une propriété

collective, une sorte de capitalisme populaire, tendrait ainsi à se

mettre en place.

Les conservateurs arrivent au pouvoir en 1979 en

Angleterre avec Margaret Thatcher dont le programme est de

démanteler le Welfare State, pour

rendre son dynamisme à l’économie britannique, peu performante

depuis la guerre. La victoire dans la guerre des Malouines en 1982

lui confère une popularité telle que le programme de libéralisation

pourra être appliqué. Le premier acte sera la restructuration du

secteur minier nationalisé en 1945 et fortement déficitaire. La

fermeture de puits provoque une grève des mineurs qui dure un an et

se termine par la défaite du syndicat. Un programme de

privatisation est ensuite lancé permettant de réduire les impôts et

de relancer les activités boursières. British Aerospace, Cable

& Wireless, British Rail, British Telecom, British Airways, le

gaz, le pétrole, les logements publics et des industries diverses

allaient retourner au secteur privé. La période conservatrice

s’étendra jusqu’en 1997 et le retour des travaillistes au pouvoir.

Ceux-ci maintiennent cependant les orientations libérales du pays

avec Tony Blair et le New Labour, puis

Gordon Brown en 2007. ■

Après 20 ans de libéralisation, depuis 1980, le

crédit et les prix sont devenus libres, les banques et le secteur

productif public ont été privatisés, les investissements

internationaux, les marchés des capitaux et des changes ne sont

plus contrôlés. Les déficits publics ont reculé (avant 2008), même

si la part de l’État dans le PIB continue à augmenter (cf. tableau 25). En

1970, il était en moyenne de 32 % dans les 22 pays de l' OCDE,

alors qu’il a augmenté de 10 points pour ces mêmes pays, et pour

certains dépassé 50 %, à la fin des années 1990. Les dépenses de

transfert (prestations sociales, subventions, RMI, etc.) sont

celles qui ont le plus augmenté: de 10-15 % du PIB dans les pays

développés en 1960, elles s’élèvent à la fin des années 1990 à

25-35 %. L'État-providence a vu son importance s’accroître dans la

période de libéralisation où pourtant beaucoup craignaient « le

démantèlement de la protection sociale ».

Un nouveau retour du balancier en faveur de

l’État caractérise les années 2000 : les risques de la

dérégulation financière (crise asiatique de 1997-1998, crise

argentine de 2001), les périls de la mondialisation sont dénoncés

de façon croissante (notamment à la conférence de l'OMC à Seattle

en décembre 1999), tandis qu’on accuse la libéralisation d’être à

l’origine de multiples maux, allant des accidents ferroviaires en

Grande-Bretagne à la maladie du bœuf dans ce même pays (encéphalite

spongiforme bovine, ESB ou « vache folle »). Enfin la grande crise

de 2007-2008 semble mettre le clou final dans le cercueil de la

libéralisation, avec le retour en force de l'interventionnisme

étatique et la quasi-nationalisation des banques en

difficulté.

La troisième révolution technologique

« L'augmentation inouïe de la productivité va

augmenter le niveau de vie de l’ensemble des habitants de la

planète alors que la révolution industrielle n’avait concerné que

20 % d’entre eux. La mise en réseau de toutes les informations

disponibles permettra d’élever le niveau d’éducation et de soins.

Enfin, la libre circulation de l’information favorisera et

consolidera la démocratie. Aucun gouvernement ne pourra désormais

asseoir son pouvoir sur l’ignorance. Le siècle Internet va tout

changer. » John Chambers, Cisco Systems

Dans le domaine technique, deux révolutions sont

en cours, celle des communications conduite par les ordinateurs, et

celle de la vie elle-même conduite par les biotechnologies. Ces

deux domaines forment ce qu’on appelle la nouvelle économie, en

expansion rapide même si l’ancienne continue à dominer.

La nouvelle économie…

Il est difficile de bien délimiter les activités

qui caractérisent les trois révolutions industrielles et

technologiques depuis deux siècles et demi, des chevauchements sont

inévitables. Par exemple le chemin de fer (1830) et l’acier (1860)

sont à cheval entre les deux premières révolutions; lors de la

deuxième révolution industrielle, autour de 1900, l’électronique

apparaît déjà avec Bell ou Marconi; l’après 1945 est surtout marqué

par l’essor des biens de consommation durable (électroménager,

télévision, automobile), mais bien sûr l’espace, l’informatique et

les biotechnologies apparaissent déjà.

Révolutions industrielles et phases

intermédiaires, 1760 à 2010

– Première révolution

technologique et industrielle : textiles, machine à

vapeur, sidérurgie du fer et de la fonte, 1760-1820

- Premier intermède: chemins de fer,

1820-1860 ; sidérurgie de l’acier, 1860-1880

– Deuxième révolution

industrielle et technologique: électricité, chimie,

hydrocarbures, moteurs à explosion, 1880-1920

- Deuxième intermède: biens de consommation

durables (radio, automobile, aéronautique, électroménager,

télévision), 1920-1980

– Troisième révolution

industrielle et technologique: biotechnologies, génétique,

technologies de l’information, technologies de l’espace,

1980-... ■

Leur véritable décollage ne se réalise que

depuis les deux dernières décennies du XXe siècle. La troisième révolution technologique

commence dans cette période, elle est centrée sur les technologies

de l’information et la biochimie, davantage orientées vers les

services du traitement et de la circulation de l’information que

vers l’industrie pure. Une nouvelle

économie, l’économie informationnelle, apparaîtrait,

annoncée par le sociologue américain Daniel Bell dès 1973, selon

les tendances suivantes:

• Le

temps, et non les matières premières, devient la ressource

rare.

• Les

connaissances ont plus d’importance que les équipements ou les

dirigeants de la firme.

• La

monnaie matérielle tend à disparaître, suivant une évolution

entamée depuis John Law.

• Les

pouvoirs étatiques et la bureaucratie reculent, au bénéfice d’un

ensemble de communautés reliées, en constante interaction, une

sorte de démocratie directe établissant la transparence et

surveillant les libertés grâce au réseau.

• La

polyvalence dans le travail prend la place de la spécialisation:

nombre de travaux auparavant spécialisés sont faits par la même

personne, ce qui permet de réduire les gaspillages, de mieux

utiliser le temps des individus (Cohen).

• La

tendance historique à la progression du salariat s’inverse au

profit du développement du travail individuel, indépendant et

décentralisé (Castells).

• Les

classes sociales changent avec l’apparition d’une hyperclasse nomade (Attali) détentrice du savoir,

composée des citoyens connectés et de l’autre côté un grand nombre

d’exclus, cette dichotomie faisant éclater le milieu, la classe

moyenne.

• Les

technologies de l’information deviennent le secteur moteur :

on estime qu’elles ont contribué pour un tiers de la croissance

américaine des dernières décennies et pour plus de 80 % de

l’accroissement de l’investissement, même si elles représentent

encore moins de 10 % du PIB.

• L'essor

de la nouvelle économie enfin est lié à la mondialisation puisque

les nouvelles technologies rendent plus difficile pour les États de

contrôler l’échange des capitaux ou des idées, devenu plus libre

sur toute la planète.

Le bouillonnement technologique actuel a été

comparé à la période des chemins de fer vers le milieu du

XIXe siècle : « C'était la folie, et en même temps quelque chose de réel

se produisait; des financiers ont perdu leur argent, cela a été une

période tumultueuse, mais les chemins de fer ont été

construits » (Ferguson). De la même façon, malgré la

multiplication des bulles et des crises accompagnant l’ère

Internet, la technologie est là, elle reste et change les modes de

vie. L'économie de l’information ou nouvelle

économie concerne tout ce qui peut être numérisé

(c’est-à-dire transcrit en suite de 0 et de 1), depuis les données

statistiques ou littéraires, jusqu’aux films, spectacles, musique,

images, etc. La production de ces biens se caractérise par la

présence d’économies d’échelle

infinies : les coûts de production sont élevés mais les

coûts de reproduction et de diffusion sont quasiment nuls, d’où la

possibilité de répartir des coûts fixes sur des ventes extensibles

sans limite, ou plutôt celle de la population mondiale. Une autre

caractéristique est la présence d’économies de réseau ou

externalités de réseau, c’est-à-dire le

fait que la compatibilité des machines et la connexion des

utilisateurs permettent une baisse des coûts, un phénomène qui date

des chemins de fer, mais qui s’étend ici à toute la planète.

Le premier ordinateur a été mis au point en

1946. Le transistor, premier semi-conducteur, a été inventé en 1948

aux laboratoires Bell. Le premier circuit intégré date de 1959,

l’ordinateur personnel apparaît en 1975 et les premières liaisons

Internet entre 1969 et 1972 (cf.

encadré). L'existence d’un réseau mondial est en train de changer

considérablement les relations économiques. La mondialisation et

l’explosion technologique, l’une appuyant l’autre, sont les deux

moteurs de cette nouvelle économie, ou Network

Economy : « Internet permet à toute activité de devenir

transnationale: peu importe où l’entreprise se trouve, la distance

n’est pas un coût pour l’envoi d’informations » (Drucker).

L'explosion du commerce électronique en est la première

caractéristique, avec des taux de croissance de 20 à 30 % par an,

même s’il représente encore un pourcentage assez faible : 0,7

% des ventes totales sur le marché américain en 1999, 3 % en 2007.

En Europe, il représentait 4,7 % des ventes de détail en

2009.

Au plan macroéconomique, qui devient non plus

seulement national mais mondial, cette nouvelle économie se

manifesterait par une inflation faible, du fait de la concurrence

généralisée, et donc de taux d’intérêt faibles. Les firmes

recherchent dans les gains de productivité la hausse des profits

puisque l’augmentation des prix est impossible. Pour les

optimistes, les règles de l’économie seraient en train de changer:

une productivité en hausse continue, une croissance à long terme

plus régulière, l’inflation zéro et le plein-emploi réalisés! Une

vision impliquant la disparition des cycles, idée cependant

contestée par la plupart des économistes et contredite par la

grande crise de 2007-2010.

Une autre interprétation, presque aussi

optimiste, consiste à penser que l’économie mondiale serait dans

les premiers temps d’un nouveau cycle long, dans sa phase

ascendante. Pendant longtemps, en fait pendant les années de

ralentissement (1973-1993) du cycle précédent (1940-1993), la mise

en place des nouveaux outils des technologies de l’information

s’est faite progressivement, trop lentement pour pouvoir affecter

la productivité ou la croissance, et puis, vers le milieu des

années 1990, le seuil d’équipement a été atteint à partir duquel

les effets positifs deviennent sensibles et le cycle s’inverse. Un

peu comme les innovations de la deuxième révolution industrielle,

dans les années 1870-1880 (électricité, chimie, automobile), qui ne

commencent à produire leurs effets sur la croissance globale

qu’après 1896. La crise de la fin de la décennie ne serait ainsi

qu’une fluctuation dans la phase A d’un nouveau Kondratiev (cf. p.

164).

Internet

Alors que personne n’en rêvait, que le Minitel

n’était même pas né, la première transmission d’informations entre

deux ordinateurs a lieu en octobre 1969. C'est le début d’Arpanet,

embryon de ce qui deviendrait un réseau mondial en trois décennies.

La liaison historique a lieu entre San Francisco et Los Angeles, de

l’université Stanford à l'UCLA à 600 km de là. Santa Barbara puis

l’Utah suivront à la fin 1969, formant un réseau à quatre pôles et

quelques dizaines d’intervenants. En 1972 a lieu la première

démonstration publique avec quarante ordinateurs raccordés à

travers les États-Unis. En 2008, on comptait 1,45 milliard

d’internautes sur la planète, la Chine vient en tête (180

millions), suivie par les États-Unis (163), 35 millions en France

en 2009.

Les noms des inventeurs, s’ils ne nous sont pas

encore familiers, resteront sans doute dans l’histoire, aux côtés

des Ampère, Faraday, Volta, Marconi, Edison, Hertz ou Bell. Il

s’agit non pas d’un inventeur mais d’équipes entières, et il faut

citer les noms de Vinton Cerf, Steve Crocker, Jon Postel, Doug

Engelbart, Robert Kahn, Joseph Licklider, Leonard Kleinrock, Ted

Nelson et Tim Berners-Lee. Le financement du Pentagone, qui voit

dans le système un moyen de contrer l’avance russe en matière

spatiale, permettra le développement des recherches. L'utilisation

d’une infrastructure existante, le réseau téléphonique, ouvre la

voie à un développement rapide et peu coûteux. L'absence d’un

centre de décision, l’apparition spontanée et anarchique de

nombreux serveurs et internautes isolés, a contribué au succès

phénoménal de ce nouveau moyen de communication. Pour relier les

réseaux informatiques locaux, il faut créer un système entre les

réseaux, ou internetting, origine du

mot internet. L'idée vient ensuite de relier toutes les

informations entre elles par un système d’hypertexte (documents

dotés de liens), il permet de créer un cyberespace ou toile

d’araignée à l’échelle mondiale, le world wide

web. On assiste ainsi, enthousiastes pour la plupart, un peu

inquiets pour certains, à l’abolition des distances, c’est-à-dire à

« l’implosion du monde réel » (Alberganti). Au début des années

1980, IBM avait encore des allures de firme dominante et lorsqu’un

petit groupe d’ingénieurs la quitta avec Bill Gates à leur tête

pour fonder Microsoft, ceux-ci étaient considérés comme des

casseurs de monopole. Retournement total en 20 ans, ce sont eux qui

sont accusés et font l’objet de procès dans le cadre de la

législation antitrust. Cependant l’immensité, la complexité, la

liberté et l’aspect décentralisé du réseau mondial garantissent

qu’il ne pourra être dominé par une firme. En outre Internet a

encore des progrès à réaliser avant de devenir aussi fiable que les

autres moyens de communication de masse comme le téléphone, la

radio ou la télévision. Le web est encore lié à l’usage de PC, donc

aux logiciels Microsoft, et ces machines peuvent tomber en panne à

tout moment; ensuite, l’utilisation du réseau est elle-même

problématique et le temps gaspillé y est énorme; enfin, la sécurité

n’y est pas toujours garantie, notamment en matière de paiements.

Des changements techniques sont donc encore nécessaires pour en

faire un moyen de masse fiable, rapide et facile d’accès. De

nombreuses connexions autres que les PC se développent et se

branchent sur le réseau, comme les téléphones portables, les

agendas électroniques, les imprimantes, les ustensiles domestiques

(télévision, réfrigérateur, automobile), dont la plupart n’auront

aucun lien avec la firme Microsoft, qui perdra nécessairement ainsi

une part importante de ce marché. ■

L'autre domaine de la nouvelle économie est

celui des biotechnologies, on y trouve des firmes comme

Amgen, Monsanto ou Genentech, et les grands groupes chimiques qui ont

opéré une reconversion: américain comme DuPont, suisse comme Novartis, allemand comme AgrEvo, anglais comme AstraZeneca et français comme Sanofi-Aventis. Leur activité dans le génie

génétique aboutit à l’élaboration de plantes transgéniques ou

organismes génétiquement modifiés, un domaine encore mal connu et

très contesté. Il s’agit par exemple du coton, du colza, du soja,

rendus résistants aux insectes et herbicides, du maïs aussi riche

en protéine que le lait, du riz contentant du fer, de la

modification du lait de vache pour le rapprocher du lait pour

nourrissons, de pommes de terre pouvant fournir de l’amidon pour

l’industrie du papier, etc. La culture d'OGM a été autorisée en

Europe en 2000 avec diverses précautions (étiquetage, localisation,

autorisations décennales renouvelables). Pour leurs défenseurs, ils

permettraient d’accroître la production tout en diminuant l’usage

des pesticides polluants, ils seraient favorables au développement

agricole dans le tiers-monde grâce à des plantes résistant à la

sécheresse, la salinité, et pouvant pousser dans des endroits

jusque-là inadaptés. Ils entraîneraient une amélioration du goût,

de la qualité nutritionnelle des aliments, la mise au point de

nourriture capable de prévenir des maladies comme l’ostéoporose.

Pour leurs détracteurs, ils dissémineraient des gènes dans

l’environnement favorisant une réduction de la biodiversité et ils

feraient dépendre les agriculteurs des firmes multinationales

agro-industrielles. Ils diffuseraient une résistance aux

antibiotiques chez les bactéries.

Mais la génétique a bien d’autres aspects, elle

est liée aux progrès énormes de la médecine au XXe siècle. Les organes sont maintenant couramment

transplantés, les vaccins et les antibiotiques peuvent vaincre la

plupart des bactéries, certaines maladies ont été éliminées,

l’examen du corps va de plus en plus loin grâce aux ordinateurs.

Enfin la génétique s’ajoute aux médicaments et à la chirurgie pour

soigner encore plus efficacement. Le principe est celui d’une

analyse de la programmation du corps et de l’esprit de chaque

individu et d’une reprogrammation ou une réorientation du programme

génétique pour éviter la maladie.

…et l’ancienne

Gestion et concentration

Le mode de gestion des firmes a changé depuis

les années 1980, on est passé du capitalisme

managérial, décrit par Galbraith, dans lequel les

dirigeants, la fameuse technostructure, avaient le pouvoir, même

sans posséder l’entreprise, à un capitalisme

patrimonial dans lequel les actionnaires font la loi. Dans

le premier, seule la taille, les économies d’échelle, le chiffre

d’affaires ont de l’importance, pour le second, c’est la

rentabilité, les dividendes, c’est donc le retour au profit. La

montée des gros investisseurs collectifs (fonds de pension, fonds

communs de placement) conforte cette évolution, car ils ont les

moyens de surveiller la gestion des firmes. Cette évolution a été

accompagnée d’une vague de concentrations à la fin du XXe siècle.

La première avait eu lieu à partir de 1885,

essentiellement aux États-Unis, elle se termine sur le regroupement

qui donne naissance à la General Motors, en 1914. Les firmes qui en

sont issues dominent le capitalisme mondial jusqu’aux années 1970.

Mais la troisième révolution technologique se caractérise par

l’apparition d’une multitude de nouvelles firmes qui figurent

aujourd’hui parmi les premières mondiales (Microsoft, Google,

Cisco, Intel, etc.). La deuxième vague de concentration commence en

1980, un siècle après la première. Cependant, ces concentrations

masquent le fait que peu d’industries sont contrôlées par de

véritables monopoles et que le contrôle du marché par un petit

nombre de firmes a dans l’ensemble reculé pendant cette phase de

concentration (tableau 26). L'explication de ce paradoxe est

simple : les firmes géantes voient leur taille augmenter, mais

les économies nationales croissent encore plus vite et de nouvelles

firmes apparaissent. En outre l’ouverture des frontières augmente

la concurrence internationale et réduit le contrôle des firmes sur

leur marché national. Contrairement à une idée répandue, il n’y a

donc pas de processus historique de concentration croissante des

entreprises. Les fusions des grandes firmes ne compensent pas

l’apport constant des nouveaux arrivants.

| 1988 | 1998 | |

|---|---|---|

| Informatique (matériels) | 77 % | 59 % |

| Informatique (logiciels) | 83 % | 59 % |

| Aéronautique/espace/défense | 55 % | 58 % |

| Automobile | 59 % | 56 % |

| Téléphone | 64 % | 42 % |

| Pétrole | 44 % | 42 % |

| Compagnies aériennes | 40 % | 38 % |

| Spectacle | 61 % | 70 % |

Le cas de l’automobile

L'explosion de la productivité dans l’industrie

a entraîné une baisse relative de la population ouvrière: elle

représentait encore 26 % de la main-d’œuvre aux États-Unis en 1970,

elle n’en représentait plus que 15 % à la fin du XXe siècle. À cette allure, elle rejoindra la

population paysanne en 2035 avec 2,6 % de la population active. Un

exemple illustre bien cette évolution; en 1955, l’ouvrier

sidérurgiste américain produisait 100 tonnes de métal par an, en

1997 1000 tonnes.

Malgré l’explosion finale de la nouvelle

économie, le XXe siècle peut être

qualifié de « siècle de l’automobile ». Il s’agit en effet de la

grande industrie qui naît dans les années 1890, devient ensuite

dominante et atteint son apogée vers le troisième quart du siècle.

Le produit lui-même, la voiture, est le plus populaire, celui qui

connaît le plus grand succès et exerce la plus grande fascination.

Elle introduit une merveilleuse souplesse dans les transports,

alors que les trains entre les villes et les tramways dans les

villes demandaient des infrastructures lourdes et ne pouvaient

aller partout. La voiture a permis le développement de villes

nouvelles, l’extension des habitations, une densité plus faible, à

la différence des constructions traditionnelles, à l’européenne, où

les immeubles sont concentrés autour des rues. La différence

majeure entre l’habitat de l’Ancien et du Nouveau Monde tient d’une

part à l’espace dont le second bénéficie, mais aussi au fait que

l’automobile permet la distance entre les constructions et arrive

juste à l’époque de l’accroissement massif de la population

américaine et de la création de milliers de cités sur le

territoire.

Les zones rurales en bénéficient également, les

transports vers les magasins, vers les écoles, l’acheminement du

courrier, etc. Les pays neufs s’organisent en fonction de

l’automobile: en 1927, les États-Unis détenaient 80 % des voitures

roulant à travers le monde avec une automobile pour 5 habitants (1

pour 2 dans les années 1970), contre 1 pour 44 en France ou en

Angleterre, 1 pour 196 en Allemagne, et moins encore dans le reste

de l’Europe. L'Australie (1/16), le Canada (1/11), la

Nouvelle-Zélande (1/10) ou l’Argentine (1/43) étaient au contraire

aux premiers rangs.

Dans les pays du Sud aujourd’hui l’automobile

reste aussi le bien le plus convoité. Les firmes multinationales

estiment que le seuil de 6 000 $ par tête, qui correspond aux pays

émergents, représente le basculement dans la civilisation

automobile, le niveau à partir duquel les ventes explosent. Au

début du XXIe siècle, les perspectives

sont encore très favorables pour l’industrie automobile: si on

atteint maintenant une voiture pour 1,7 habitant en Amérique, 1

pour cinq en Europe, on n’en compte encore qu’une pour 350 en Inde

et tous les pays du tiers-monde sont largement sous-équipés par

rapport aux pays développés. Les nouveaux constructeurs, en Chine

et en Inde, vont rapidement modifier la domination traditionnelle

des anciens pays industriels.

Dès les années 1930, les problèmes posés par

l’automobile, symbole de liberté et de société de consommation,

commencent à apparaître: la pollution, les encombrements, les

accidents de la route, et ceux-ci n’ont fait que s’amplifier depuis

lors. On a oublié cependant qu’au début du XXe siècle, l’automobile apparaissait comme un moyen

d’accroître la propreté: les déjections, urines, carcasses que le

transport à cheval laissait derrière lui dans les villes étaient

des nuisances considérables, coûteuses à évacuer et facilitant

aussi la propagation des maladies. En 1900 à New York les chevaux

laissaient dans les rues plus d’un million de tonnes de crottin,

plus de 250 000 litres d’urine par jour, et chaque année la ville

devait déblayer les cadavres de 15 000 chevaux !

Le pétrole

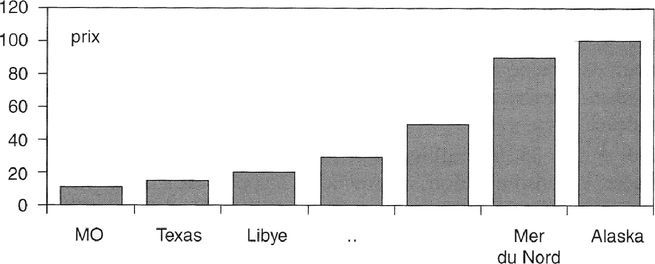

La théorie de la rente différentielle élaborée

par Ricardo au XIXe siècle à propos des

terres s’adapte parfaitement au marché pétrolier, le marché de

matières premières le plus important au XXe siècle pour des raisons économiques et

stratégiques évidentes. Les coûts d’exploitation diffèrent d’un

champ pétrolier à l’autre: les gisements du Moyen-Orient ou du

Texas, plus faciles à exploiter, présentent des coûts plus faibles

que ceux de la mer du Nord ou de l’Alaska. Le prix du brut doit se

fixer de façon à permettre l’exploitation du gisement le plus

coûteux. La demande mondiale détermine quel est ce gisement,

puisque tant qu’elle reste faible, il suffira d’exploiter les

champs pétrolifères les plus faciles d’accès, mais si elle augmente

il faudra mettre en œuvre des gisements plus difficiles à

exploiter. La rente différentielle est

la différence, pour chaque gisement, entre le prix du brut (fixé

d’après le coût du gisement le plus difficile) et son propre coût

d’exploitation. Elle sera d’autant plus élevée que ce dernier est

faible. On voit sur le graphique que si le gisement le plus

difficile correspond à un coût de 100 (Alaska) et le moins coûteux

à 10 (Moyen-Orient), la rente sera de 90 dans ce dernier, et par

exemple 85 au Texas, 80 en Libye, etc., et qu’elle sera de 10 en

mer du Nord et nulle pour le gisement le plus coûteux à exploiter,

celui de l’Alaska dans cet exemple imaginaire.

Coûts d’exploitation des

champs de pétrolifères et rente différentielle (données

imaginaires)

Après une courte période de concurrence

parfaite, entre 1859 et 1880, le marché américain est contrôlé par

une firme, la Standard Oil (SO) fondée par Rockefeller en 1870. La

seule concurrence est en Europe, elle vient de la firme issue de la

fusion en 1907 entre la Royal Dutch, fondée par les frères Nobel

pour exploiter le pétrole de Sumatra, et celle des Rothschild et de

Marcus Samuel, pour le pétrole du Caucase, la Shell. Le pétrole du

Moyen-Orient commencera à être exploité en 1908. En Amérique la SO

est éclatée en 34 sociétés en 1911 en application des lois

antitrust (cf. encadré p. 281), des entreprises qui seront parmi

les plus grandes compagnies du secteur au XXe siècle.

L'histoire du pétrole au XXe siècle est l’histoire du conflit pour le partage

de la rente. Dans un premier temps, les grandes compagnies, les

Sept sœurs, en obtiennent l’essentiel. Les pays producteurs, sous

la domination coloniale ou impérialiste, ne sont pas en mesure d’en

prélever une part importante. L'accord secret d’Achnacarry fixe en

1928 le partage des marchés et le niveau des prix au bénéfice des

compagnies (les septs majors et des sociétés moins importantes:

Shell, Anglo Persian Oil ou BP, Standard Oil of New Jersey ou Esso

puis Exxon, Standard Oil of New York ou Mobil, Standard Oil of

California ou Chevron, Gulf Oil, Amoco, Total, Elf, Fina, ENI.

Après la Deuxième Guerre mondiale, les indépendances et la

formation de l'OPEP en 1960, les pays producteurs obtiennent une

part croissante de la rente, surtout à la suite des deux chocs

pétroliers (quadruplement du prix du brut en 1973, doublement en

1979). Après 1983 le prix baisse en termes réels, la rente, estimée

à environ 1500 milliards, est partagée entre les compagnies qui se

regroupent (fusion Chevron-Gulf, Exxon-Mobil, Total-Fina-Elf ), les

pays producteurs qui tentent de contrôler l’offre afin de maintenir

les prix, et les États des pays consommateurs qui en accaparent

également une partie importante à travers une taxation élevée.

Comme le prix du pétrole est resté en fait stable dans la deuxième

moitié du XXe siècle, en termes réels,

malgré les hausses brutales des années 1970, le conflit pour le

partage de la rente reste la caractéristique essentielle du marché

pétrolier.

Pendant la Première Guerre mondiale, la France

n’avait pas de compagnie nationale et dépendait du pétrole

américain. Les taxis de la Marne notamment avaient été alimentés

par des carburants venus des États-Unis. Grâce à la victoire de

1918, la Compagnie française des pétroles (CFP, future Total),

créée en 1924, récupère les parts de la Deutsche Bank dans la

Turkish Petroleum Cy, et à travers elle le contrôle de gisements au

Moyen-Orient. Dans les années 1960, le général De Gaulle favorise

la création d’un concurrent, qui deviendra plus tard Elf Erap, puis

Elf Aquitaine, et qui exploite des gisements au Gabon, alors

colonie française, et les ressources du gaz de Lacq dans le Béarn.

En 1956, les ressources de Hassi Messaoud en Algérie sont

exploitées par les deux groupes. Albert Frère, un industriel belge,

devient président du conseil d’administration de PetroFina en 1990,

le premier groupe du pays. L'État tient à le garder sous contrôle

belge et une première tentative de vente à Elf-Aquitaine échoue.

C'est finalement la compagnie française rivale d’Elf, Total, qui en

prendra le contrôle en 1998, mettant fin à 79 années

d’indépendance. Un an après, le groupe prendra le contrôle

d’Elf-Aquitaine, formant ainsi le cinquième ensemble pétrolier

mondial, après Shell, Exxon/Mobil, BP et Chevron/Texaco.

Les lois antitrust aux États-Unis

En 1914, une Commission fédérale pour le

commerce (Federal Trade Commission) est

créée pour faire respecter la concurrence et définir les pratiques

loyales dans les affaires. Les États ont d’abord tenté de contrôler

les trusts, mais il est vite apparu que seules les autorités

fédérales avaient le poids nécessaire. Une loi est votée, le

Sherman Act, en 1890, qui permet de

mettre en prison, d’infliger de lourdes amendes à tout membre d’une

entente en vue de restreindre le commerce. Le Hepburn Act la renforce sous la présidence et

l’impulsion de Th. Roosevelt en 1906. En 1911, à la suite de

poursuites lancées dès 1903 par Roosevelt, la Standard Oil est dissoute et éclatée en 34

compagnies indépendantes par la Cour suprême. Une autre loi est

passée en 1914 sous Woodrow Wilson, le Clayton

Anti-Trust Act, pour freiner les fusions et les ententes de

prix. La taille des firmes continue cependant à s’élever, en

l’absence même de concentration, du fait d’une croissance propre,

liée au succès de leur gestion et au dynamisme de leur marché.

Contre ce type de domination, les lois antitrust ne pouvaient rien,

elles n’étaient pas dirigées contre la taille mais plutôt contre la

position de monopole. Elles n’ont guère empêché la concentration de

l’industrie américaine : en 1985, 70 % des ventes étaient

réalisées par des firmes représentant seulement un millième de

l'effectif total des entreprises industrielles. Mais elles ont

permis malgré tout de contrôler les collusions à l’avantage des

consommateurs et de défendre les entreprises indépendantes. Leur

imitation à l’étranger, notamment en Europe, montre que leur effet

a été globalement favorable. De toute façon, aucun groupe dominant

n’a pu conserver longtemps une situation de monopole aux

États-Unis. Le capitalisme américain a suscité des concurrents aux

groupes les plus concentrés : « SO, US Steel, American Can,

International Harvester, qui contrôlaient au moment de leur

formation bien plus de la moitié de la production de leur branche,

ont vu leur part de marché diminuer sensiblement les années

suivantes » (Asselain). Plus proche de nous, le cas d'IBM, dominant

dans les années 1960, pourrait être ajouté à la liste. Les ressorts

spontanés de la concurrence et de l’innovation semblent donc plus

efficaces que les lois contre les monopoles.

Le système global

L'économie mondialisée

La mondialisation économique peut être illustrée

par le fait que le commerce international représente en 2008 un

tiers de la production mondiale, contre 24 % en 1998 et 9 % en

1980. Les firmes multinationales sont au cœur de cette évolution

que des organismes internationaux comme le FMI et l'OMC tentent

tant bien que mal de réguler (cf. encadré). Elles sont les moteurs

du système de production mondial intégré. Les mille plus grandes

firmes dans le monde représentent les quatre-cinquièmes de la

production industrielle mondiale; dans certains pays, comme en

Irlande, elles représentent l’essentiel de l’activité (les 2/3 de

la production et la moitié de l’emploi dans ce cas). Sur les cent

entités les plus importantes à l’échelle mondiale, quarante-cinq

sont des entreprises et non des pays, en comparant les chiffres

d’affaires et les PIB.

Mais les multinationales entretiennent encore

l’essentiel de leur activité dans le pays d’origine (les 2/3 de

leur production et de leurs effectifs). Ce pays d’origine est pour

85 % d’entre elles un pays développé, les autres venant de pays

émergents. Dans ces derniers, comme dans les pays pauvres, les

firmes multinationales payent des salaires plus élevés en moyenne

que les autres firmes et créent des emplois plus rapidement. Elles

représentent le principal vecteur du transfert de technologie vers

les pays du tiers-monde (70 % des royalties payées dans le monde

pour des brevets vient de filiales de multinationales). Elles

créent des richesses, du travail et diffusent des technologies qui

permettent d’augmenter les niveaux de vie. Leur pouvoir enfin n’est

pas aussi assuré qu’il ne semble : des 500 plus grandes firmes

de la revue Fortune en 1980, 40 % avaient disparu à la fin du

siècle, à la suite de fusions ou d’absorption.

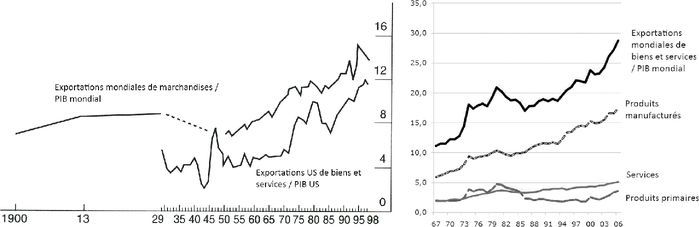

Montée des échanges

internationaux dans la production (%) Sources : 1)

The Economist, 11 sept. 1999 (d’après

Maddison, Irwin) ; 2) M. Fouquin, C. Herzog, CEPII, juin

2008

Les crises financières

Les crises financières se sont succédé depuis la

crise de la dette en Amérique latine démarrée au Mexique en 1982,

la deuxième crise du Mexique en 1994, la crise asiatique partie de

Thaïlande en 1997 et étendue ensuite en Russie et au Brésil en

1998, la crise argentine en 2001 et enfin la grande crise des

subprimes en 2008. Ces crises ont un

caractère nouveau: elles sont plus contagieuses du fait de la

mondialisation et elles sont plus brutales, la crise asiatique a

par exemple entraîné des chutes de 20 % dans les PIB des pays

concernés, la crise de 2008 une récession mondiale. À ce problème

universel de la fragilité du système financier international, il

n’y a pas de réponse commune du fait de l’insuffisance de la

gouvernance mondiale. Face aux progrès de la mondialisation

économique, il n’y a pas eu de progrès équivalents de la gestion du

monde. Les crises sont mondiales, les pouvoirs sont essentiellement

limités aux États-Nations.

En cas de crise des paiements extérieurs, les

gouvernements ont eu le choix entre se couper durablement de la

communauté internationale, ou bien recevoir les fonds du FMI, ou de

l’Europe dans le cas de la Grèce en 2010, mais à condition de se

soumettre à ses plans d’ajustements visant à rétablir leurs

équilibres internes. C'est toujours la deuxième option qui est

choisie car la première présenterait un coût économique, social et

politique considérable. Pourtant, le recours à l’aide extérieure

est difficile et il s’accompagne de critiques très dures contre des

institutions transformées en boucs émissaires des problèmes

intérieurs: « Incarnation d’un pouvoir supranational, imposant sa

loi économique et financière aux gouvernements de la planète, le

FMI est taillé pour le rôle » (B. Stern). Ces critiques viennent de

toute part, des pays concernés, des partis de gauche et de

l’opinion dans les pays riches, qui ont vu surtout dans le FMI une

émanation de l’impérialisme américain dont les potions ont pour

effet « d’achever les malades pluôt que les guérir » (ibid.). Par exemple, le ministre japonais des

Finances dénonce son « intégrisme de marché », la « domination

américaine » qu’il subirait et son penchant à « l’application

aveugle d’un modèle universel ». Les critiques viennent d’ailleurs

des États-Unis eux-mêmes: « Inefficace, dépassé, inutile », selon

l’ex-secrétaire au Trésor George Schultz, qui ajoutait: « Le

FMI ? Un machin multilatéral qui gaspille l’argent du

contribuable américain sur l’ordre du socialiste français

Camdessus, au mépris des intérêts des États-Unis ». Le Congrès

l’accuse de permettre le maintien de gouvernements incompétents

dans le tiers-monde, etc.

Le FMI défend ses positions en avançant par

exemple qu’il a engagé des programmes de réduction de la dette pour

les 35 à 40 pays les plus pauvres dans le monde, en échange de la

mise en place d’un nouveau modèle de développement basé sur

l’ouverture extérieure, la réduction de la pauvreté, les dépenses

en investissements humains (santé, éducation, développement rural),

des actions pour l’environnement et le renforcement des

institutions (notamment la mise en place d’un pouvoir judiciaire

stable et équitable). La réduction de la dette est un moyen de

faciliter le développement économique, mais elle ne va pas sans

problème. Le développement est lié au crédit, et il est essentiel

de ne pas porter atteinte au crédit dont un pays pourra bénéficier

dans l’avenir. Si le secteur privé ne lui prête plus, parce qu’il

est considéré comme mauvais payeur, son développement sera

condamné. Certains pays ne veulent d’ailleurs pas bénéficier des

allègements de dette, de peur de ne pouvoir continuer à accéder aux

flux des crédits bancaires. Les stratégies du Fonds visent à

combiner allègement et maintien des flux de prêts, en liant la

réduction de la dette à l’amélioration des politiques économiques,

de façon à établir une confiance favorable à la poursuite des

prêts. ■

Le GATT et l'OMC

Personne ne pouvait s’attendre à la fin des

années 1940, après le protectionnisme envahissant de la première

moitié du siècle, à l’incroyable succès du GATT dans la formation

d’un commerce libre, qui irait jusqu'au XXIe siècle. Abandonnant leur isolationnisme

séculaire, responsable de l'approfondissement de la crise de 29,

les États-Unis optent pour le libre-échange, ils s’engagent dans

des négociations sur le commerce multilatéral et proposent d’entrée

des réductions considérables des droits et autres barrières aux

échanges. La domination écrasante de l’économie américaine au

sortir de la guerre, face à l’Europe dévastée et au Japon anéanti,

expliquerait ce retournement dans les traditions commerciales

américaines, mais aussi la vision d’idéalistes du libre-échange

comme Cordell Hull, Secrétaire d’État (Aff. étrangères) de

Roosevelt de 1933 à 1944 (la plus longue durée dans l’histoire de

son pays) et prix Nobel de la paix en 1945.

En réalité, la mise en place d’un système

multilatéral s’est faite difficilement. Les négociations ont été

dures : les Anglais n’entendaient pas abandonner le système de

protection et de préférence dans le Commonwealth, les Américains

étaient réticents à réduire tous leurs droits de douane en raison

des puissants lobbies protectionnistes à Washington et de

l'opposition du parti républicain, traditionnellement

protectionniste depuis le XIXe siècle.

L'administration Truman, acquise au libéralisme, devait se battre à

la fois à l’intérieur contre les républicains qui multipliaient les

obstacles au Congrès, et à l’extérieur contre les pays étrangers

résistant à l’idée de réduire leur protection. Les négociations ont

failli être rompues quand les producteurs américains de laine

furent bien près d’obtenir une majorité au Congrès pour une

protection spéciale. Cela aurait entraîné des initiatives du même

genre des autres industries américaines et d’autre part un retrait

des pays intéressés comme l’Australie ou la Nouvelle-Zélande. Le

début de la guerre froide et la crainte du communisme ont fait

basculer la balance en faveur d’un accord, les républicains

ralliant finalement la position de l’administration parce que la

reconstruction de l’Europe occidentale devenait une nécessité

absolue. Le projet de création d’une OIC (Organisation

internationale du Commerce, ITO en anglais) par la charte de la

Havane ne sera cependant pas réalisé à cause de l’opposition du

Congrès, et ce n’est qu’un simple accord – agreement – qui fut signé en 1947 avec 23

pays-membres, l’Accord général sur les tarifs et le commerce, connu

sous le sigle anglais de GATT (General

agreement on tariffs and trade).

L'Organisation mondiale du commerce (OMC) a

remplacé le 1er janvier 1995 le GATT, elle compte 153 membres en

2010 et siège à Genève comme son prédécesseur. Sa création avait

été obtenue lors de la dernière rencontre du cycle de l’Uruguay, en

avril 1994. Une trentaine de pays restent à l’extérieur, certains

sont candidats comme la Russie, l’Iran ou l’Algérie. La Chine est

devenue le 136e membre en 2001. Le GATT était un accord au départ,

puis une véritable organisation internationale qui organisait les

rencontres commerciales internationales : les NCM

(Négociations commerciales multilatérales) ou rounds, huit depuis

l’origine. À Genève (1947), Annecy (1949), Torquay (1950-1951), et

à nouveau Genève (1955-1956), on a élargi l’accord à de nouveaux

pays et entamé la réduction des droits de douane. Le Dillon round

(1961-1962), le Kennedy round (1964-1967) et le Tokyo round

(1973-1979) ont permis une évolution vers des échanges plus libres

avec la réduction en moyenne des tarifs de 40 à 5 % entre les pays

développés. Au fur et à mesure que la guerre s’éloignait et que le

nombre de membres augmentait, les négociations devenaient de plus

en plus difficiles du fait de la résurgence des manifestations

protectionnistes. En témoigne l’allongement de la durée des

négociations : un à deux ans au départ, puis trois, cinq et

huit ans pour l’Uruguay round (1986-1994), ce qui laisse prévoir

une négociation permanente. Le cycle du millénaire, commencé en

1999, s’est poursuivi en l’an 2000 à Seattle par un échec dû à

l’opposition et aux manifestations des groupes hostiles à la

mondialisation, tant américains qu’extérieurs. Les négociations ont

été ensuite bloquées du fait de l’incompatibilité des positions, en

particulier à propos de l’agriculture. Le groupe de Cairns (18 pays

du tiers-monde et d’Océanie) réclame la fin des subventions

agricoles de l’Union européenne et la levée des barrières à

l’entrée pour leurs produits, l’Europe entend conserver sa

politique agricole. Le nouveau cycle (Doha) porte sur les services,

l’agriculture, les investissements, la concurrence, le commerce

électronique et les normes écologiques et sociales. L'OMC

représente un progrès car elle inclut un système de règlement des

contentieux entre États, l'ORD (Organe de règlement des différends)

créé à la demande de l’Union européenne et avalisé avec réticence

par le Congrès américain, traditionnellement influencé par les

lobbies protectionnistes. C'est une avancée vers plus de justice

économique internationale, en lieu et place de la loi de la jungle

qui caractérisait la planète avant la Deuxième Guerre mondiale.

C'est aussi un moyen d’éviter la multiplication des accords

bilatéraux, au bénéfice d’un droit multilatéral. ■

L'environnement et les ressources

naturelles

Les problèmes écologiques ne manquent pas,

depuis les villes polluées et encombrées, les changements

climatiques globaux, la déforestation, l’extension du béton sur les

littoraux et les campagnes, les ports et les rivières empoisonnés,

l’extinction de certaines espèces, etc. Les grandes catastrophes

environnementales de l’après-guerre sont les suivantes: Minamata

(Japon, 1956), Torrey Canyon (Manche, 1967), Seveso (Italie, 1976),

Love Canal (États-Unis, 1978), Three Mile Island (États-Unis,

1979), Bophal (Inde, 1984), Schweitserhalle (Suisse, 1986),

Tchernobyl (Ukraine, 1986), Exxon Valdez (Alaska, 1989), Erika

(France, 2000), AZF à Toulouse (2001), Prestige (Galice, 2002),

Jilin (Chine, 2005), golfe du Mexique (Louisiane, 2010)…

Minamata a été le point de départ d’une prise de

conscience écologique mondiale : la maladie de Minamata vient

de la consommation de poisson dans la baie du même nom, polluée par

des rejets d’environ 30 tonnes de mercure entre 1932 et 1968 par la

fabrique Chisso, une entreprise chimique de fertilisants, de

parfums et de plastique. Elle fait 3000 victimes qui n’ont été

indemnisées que trente ans plus tard. La firme avait procédé à des

versements aux pêcheurs de la baie, dès avant-guerre, pour

compenser les effets destructeurs sur les bancs de poisson, parce

que cela coûtait moins cher que d’adopter un système de traitement,

et elle ne cessa de déverser les produits toxiques qu’en 1968 parce

que la technique de production au mercure était devenue

obsolète.

Mais des changements positifs en matière

écologique ont également eu lieu qui sont moins connus. En effet,

si les hommes avaient conservé les mêmes modes de vie, de

production et de consommation qu’au début du XXe siècle, du fait du triplement de la population

mondiale et de la hausse massive de la production industrielle et

agricole, la planète serait aujourd’hui invivable, un endroit

toxique, malsain et dangereux. Une adaptation favorable,

progressive, a donc eu lieu. Des réglementations et des taxes ont

été mises en place, les prix relatifs ont changé entraînant des

investissements dans l’environnement, des innovations se sont

multipliées pour réduire les gaspillages et la consommation

excessive de matières premières, trouver des substituts, développer

des procédés plus propres, etc. Loin de s’épuiser, les produits

primaires ont vu leurs prix baisser à long terme, aussi bien dans

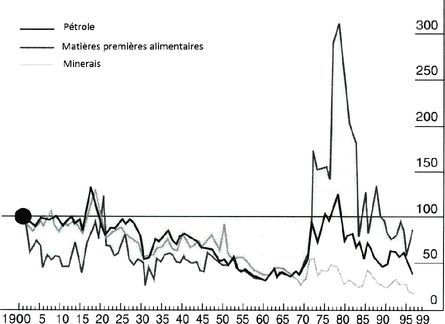

le domaine agricole que minier ou énergétique (cf.

graphique).

Prix réels des produits

primaires au xxe siècle Source:

The Economist

Les mécanismes du marché ont joué efficacement

dans les domaines où les droits de propriété sont bien établis, par

contre dans nombre de cas le marché a été défaillant. Ainsi les

réserves de pêche ont baissé dangereusement faute d’appropriation,

la pollution de l’air, de la terre et des eaux également n’est pas

reflétée dans les prix et aucun mécanisme n’a permis de la freiner.

D’autres problèmes se sont greffés à cela comme la difficulté

scientifique d’évaluation. Les moyens de l’homme sont encore

imparfaits, la terre et la nature sont immenses et impossibles à

dominer, ni même à expertiser. Les spécialistes ne sont par exemple

pas d’accord sur les conséquences des changements climatiques (un

accord relatif sur un lent réchauffement semble cependant se

dégager parmi les scientifiques, mais non sur ses causes humaines,

comme les débats autour du GIEC l’ont montré), sur l’évolution de

la couche d’ozone, sur les conséquences de la déforestation, sur la

disparition ou non de certaines espèces. Les prévisions établies

par les études sont rarement constatées dans la réalité, quelques

décennies plus tard.

L'exemple le plus frappant est le célèbre

rapport Meadows du Club de Rome en 1972 (The

Limits to Growth) dont aucune des prévisions n’a été

réalisée. On pourrait multiplier les exemples: ainsi les pluies

acides étaient censées faire disparaître à terme la forêt

européenne et notamment en Allemagne. On s’aperçoit cependant que

sa surface a progressé. L'homme doit admettre qu’il est encore loin

de maîtriser et même de comprendre la nature. Un autre problème est

l’éclatement des centres de décision: malgré les conférences

mondiales qui se succèdent – comme celle de Copenhague en 2009 –

aucun accord global, aucune stratégie cohérente de l’humanité,

contrôlée par une instance rationnelle supranationale n’a pu se

mettre en place. L'Amérique et l’Europe ont des points de vue

différents sur les priorités, le Nord et le Sud des stratégies

opposées. Les pays développés, les premiers touchés par la

pollution industrielle, les plus sensibilisés aux problèmes de

l’environnement, ont le plus progressé. Ainsi les nuisances

urbaines y ont reculé partout grâce au contrôle progressif des

véhicules et des usines. Des usines de traitement ont permis

d’assainir rivières et océans depuis les années 1960. Les pays en

développement et les pays de l’Est ont enregistré au contraire une

aggravation considérable de la pollution. Un autre clivage est

celui de la démocratie: les pays démocratiques ont mieux contrôlé

les nuisances que les dictatures, simplement parce que les victimes

pouvaient faire entendre leur voix. Ainsi la catastrophe de

Minamata, celles de Seveso et de Bhopal, Erika ou le Prestige en

Europe, ont reçu une plus grande attention des pouvoirs publics que

la pollution de la mer d’Aral et son recul massif ainsi que celle

du nord de la Russie par le stockage de matières radioactives

pendant la période socialiste. De la même façon, les effets de

l'industrialisation accélérée en Chine sont minimisés.

Les blocs régionaux

La mondialisation économique va de pair au

XXe siècle avec un émiettement de la

planète qui compte 203 États en 2010 (dont 10 contestés2, même s’ils ont aussi tendance à se regrouper

en unions économiques. Pour les spécialistes, l’éparpillement est

complémentaire de ces regroupements, en favorisant la région face à

la nation. En Europe on avait cinq cents entités politiques au

XVIe siècle, il n’en restait plus que

trente au XIXe, mais au XXe siècle c’est l’évolution inverse qu’on constate

avec la disparition des empires: austro-hongrois, allemand, russe,

ottoman, soviétique. Même phénomène à l’échelle mondiale avec la

fin des empires coloniaux: l’Afrique noire passe de sept entités

politiques à cinquante dans les années 1960, l’Asie connaît la même

évolution, l’Amérique latine, indépendante depuis 1822, est au

contraire stabilisée politiquement. Cette prolifération est

considérée comme un danger par les politologues car des petits

États ont des institutions faibles qui laissent apparaître des

zones de non droit, des zones grises, en proie à des guerres et des

pouvoirs mafieux. La faiblesse de l’État empêche le bon

fonctionnement de l’économie de marché, les coûts de transaction

augmentent et le développement économique est bloqué. Le mouvement

continue et continuera au XXIe siècle,

pour des raisons diverses: une minorité opprimée aspire à

l’indépendance (Kosovo, Timor) et l’obtient, ou bien au contraire

une partie plus riche veut se détacher du reste du pays qu’elle

considère comme un boulet (Singapour, pays Baltes, Slovénie,

Tchéquie). On pourrait aller ainsi vers des milliers de nations à

travers la planète et non plus des centaines, si on considère qu’il

y cohabite cinq mille ethnies différentes…

La mondialisation s’accompagne d’un resserrement

des liens entre les pays voisins dans chaque aire géographique et

géopolitique. L'Union européenne en représente le modèle le plus

achevé, mais elle n’est pas la seule: une centaine d’États, contre

25 en 1990, font partie d’une aire régionale, comme l'ALENA en

Amérique du Nord, le Mercosur au sud, la CEDEAO en Afrique de

l’Ouest ou l'ASEAN en Asie du Sud-Est. Le risque est la

constitution de forteresses protectionnistes qui freineraient le

commerce international et créeraient des effets de détournement des

échanges néfastes à une allocation efficace des ressources à

l’échelle mondiale, et donc à la croissance. Cependant, si le

modèle est celui de l’Union européenne, caractérisée par une

protection extérieure faible et en baisse constante depuis 1957,

les effets favorables de création de commerce peuvent l’emporter

largement et favoriser la croissance mondiale. L'analyse économique

a montré dans la théorie des unions douanières que l’intégration

régionale ne représentait au mieux qu’un optimum de second rang par

rapport à une situation de libre-échange généralisé. Mais la

théorie présente l’inconvénient d’être statique, de ne pas prendre

en compte les effets dynamiques favorables de tels regroupements

(création d’industries, économies d’échelle) et de se limiter aux

effets économiques alors que des effets politiques sont aussi

recherchés par ces unions et en particulier la création de

nouvelles entités, comme par exemple une fédération européenne

envisagée un moment. En outre, si le libre-échange global est

préférable aux blocs régionaux, il reste un objectif utopique,

alors que la réalisation de zones régionales de libre-échange ou

d’unions douanières est un fait. On peut donc considérer que

régionalisme et multilatéralisme ne s’opposent pas nécessairement,

à la condition de faire en sorte que les blocs régionaux soient

ouverts et non fermés comme c’était le cas dans les années

1930.

Pour les uns, la mondialisation est un phénomène

positif puisqu’une économie mondiale intégrée conduit à

une meilleure division internationale du

travail et une hausse de la productivité et des niveaux de

vie dans le monde. Les pays à bas salaires se spécialisent dans les

activités de main-d’œuvre, ce qui permet aux pays riches d’utiliser

la leur de façon plus productive dans les secteurs à haute

technologie. Les firmes multinationales exploitent davantage les

économies d’échelle potentielles, elles facilitent les transferts

de technologie et les effets d’apprentissage pour les pays en

développement, tandis qu’elles apportent des produits à bon marché

pour les consommateurs. La concurrence est renforcée par le

processus ce qui permet d’abaisser les prix, d’accroître la qualité

et stimuler l’innovation. Le capital va dans les emplois les plus

productifs au lieu de devoir rester dans des emplois intérieurs à

faible rentabilité. La libre circulation des capitaux permet

d’accélérer le développement des pays pauvres tout en assurant une

diversification des risques pour les investisseurs des pays

riches.

Pour les autres, la mondialisation entraîne,

dans les pays développés, à cause de la concurrence des pays du

tiers-monde, des destructions d’emplois, la baisse des salaires des

travailleurs peu qualifiés et l’aggravation des inégalités

sociales. Dans les pays pauvres, elle favorise l’exploitation de la

main-d’œuvre et le maintien de conditions sociales désastreuses.

Les firmes multinationales, non contrôlées de façon démocratique,

organisent les délocalisations vers les pays à bas salaire, pillent

les ressources naturelles du monde et interviennent dans la

politique locale pour maintenir des régimes réactionnaires et

corrompus. On assiste à une course vers le

niveau le plus bas au fur et à mesure que tous les pays

réduisent leur protection sociale, les salaires, les normes de

santé et de sécurité, la protection de l’environnement, etc., pour

rester compétitifs. En plus, les gouvernements perdent le contrôle

des politiques économiques nationales et voient leur souveraineté

reculer, tandis que des marchés financiers non dirigés,

irresponsables, provoquent des crises financières chaotiques comme

au Mexique en 1994, en Asie en 1997 et dans le monde entier en

2008.

Le second point de vue est favorable

à la nation, au maintien de sa

souveraineté et de son identité, de ses caractéristiques

culturelles propres. Il craint que l’extension du marché ne

produise la fusion de l’humanité dans un même moule et la

disparition des cultures locales. Le point de vue libéral au

contraire est internationaliste, il est

favorable à un recul des États nationaux et à la généralisation des

échanges. Il n’y a pas plus de raison de vouloir conserver les

barrières à la circulation des hommes, des biens et des capitaux